Stack Exchange啟動了一項Answer Assistant實驗,測試由人工智慧生成的回答是否能通過社群審核機制,成為公開的內容。然而,此舉在社群內部引發廣泛討論與爭議,部分用戶擔憂人工智慧內容可能影響平臺的知識品質,甚至改變Stack Exchange作為人類策畫知識庫的核心價值。對於Stack Exchange來說,這項實驗目的在於探索人工智慧技術,如何在維持人類維護的前提下,輔助使用者獲得解答,但目前的實施方式已讓不少資深貢獻者感到不安,擔憂這是否會削弱專家參與的動機。

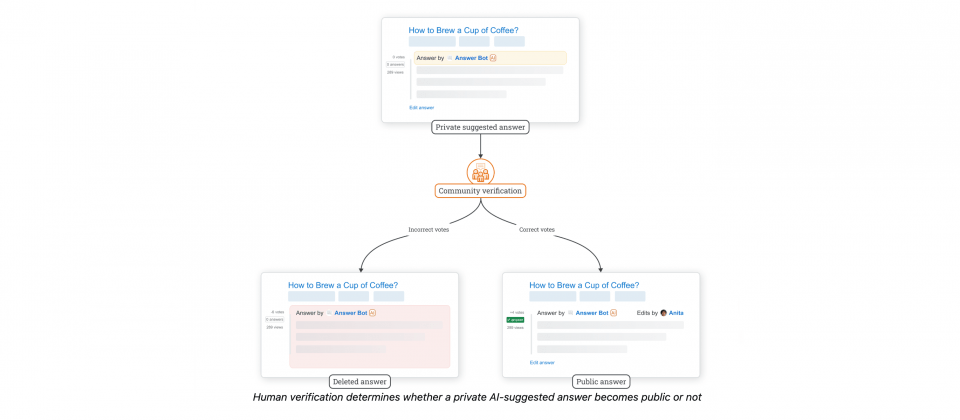

此次Answer Assistant實驗會在部分站點先行測試,包括Arts & Crafts、Raspberry Pi和User Experience。當符合特定條件的問題在72小時內未獲得讚賞或接受的回答時,系統將產生人工智慧建議的答案,但這些內容只有具有一定聲望分數的使用者可以看見,並標註為人工智慧生成,待社群成員評估正確性。若多位使用者認定答案有效,該回答將公開顯示,並由名為Answer Bot的帳號發表,若是人工智慧內容被判定為錯誤則會被刪除,避免影響整體知識庫品質。

這項機制的目標是減少未獲解答的問題,並提供社群成員一個參考答案以進行編輯與補充。不過,部分社群成員對此持質疑態度,認為這與Stack Exchange長期以來強調的人類策畫知識原則相違背。批評者認為,Stack Exchange一直以來的價值在於匯聚專家知識,讓回答不只是正確,更是具有深度、完整性和可信度。而人工智慧生成的內容,即便經過人類審核,仍可能無法達到社群期望的水準,甚至增加專家審核的負擔,讓原本願意貢獻知識的使用者感到沮喪。

此外,另一個爭議點在於審查機制是否足夠嚴謹。目前官方設定的最低審查門檻為50聲望分數,這遠低於其他審查機制的標準,像是部分內容審核隊列通常需要350、500甚至3,000以上的聲望才能參與。一些社群成員質疑,低門檻可能導致機械式審查,讓不具備足夠專業知識的使用者輕易將人工智慧內容標記為正確,進而影響最終公開內容的品質。

還有一個引發社群不滿的問題,是人工智慧內容的可追溯性與透明度。Stack Exchange官方表示人工智慧內容的來源目前無法提供明確的引用與出處,這與Stack Exchange一直以來強調的可驗證資訊原則衝突。官方雖表示正在研究如何解決這個問題,但在沒有明確解決方案的情況下,仍選擇推動實驗,讓部分用戶認為Stack Exchange在來源不可妥協的原則上存在雙重標準。

熱門新聞

2026-03-06

2026-03-02

2026-03-02

2026-03-04

2026-03-05

2026-03-02

2026-03-02