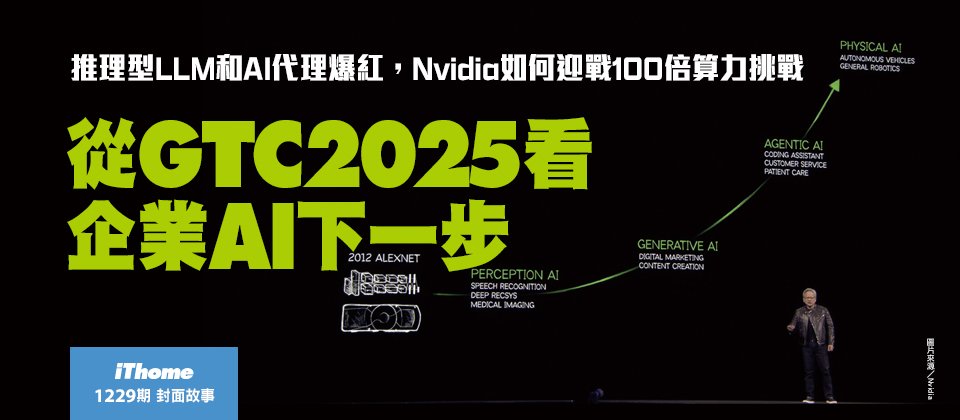

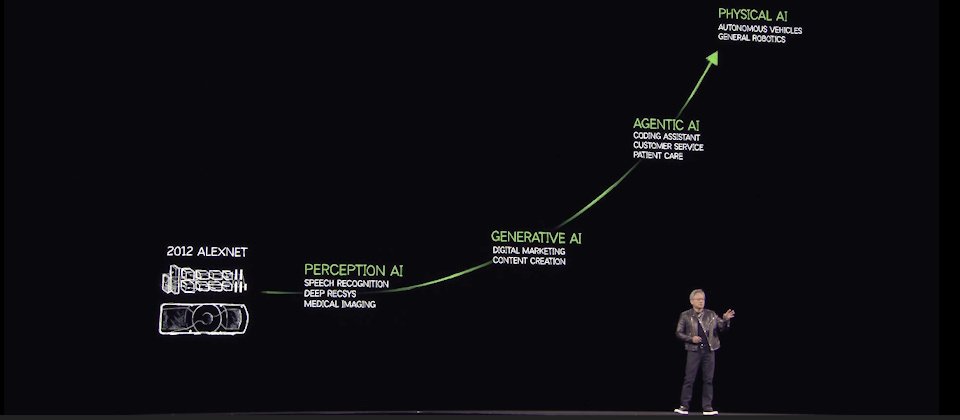

十年前是感知AI,5年前開始出現生成式AI, 最近2年,代理型AI(Agentic AI)崛起,下一波是機器人學,這是物理AI(Physical AI)驅動的新浪潮。(圖片來源/Nvidia)

「去年,幾乎全世界都錯了,AI擴展定律更加飆速地成長,代理型AI和LLM推理能力的影響下,我們目前需要的算力,是去年預估需求的100倍之多!」Nvidia執行長黃仁勳在一年一度的GTC大會開場演講中如此強調,在這場號稱是AI界超級盃的活動中,黃仁勳盤點了從AI到GAI的發展,歸納出他所看到的下一個AI挑戰。

從感知AI、代理AI到物理AI

AI技術十年前從感知類AI開始發展,像是電腦視覺、電腦語音,然後再進展到生成式AI的領域,過去5年的生成式AI焦點是,訓練AI能將一種模態的資料,轉換(生成)為另外一種模態的內容,像是文字生成圖片,文字生成影音,氨基酸結構生成蛋白質結構,或從化學特性生成化學物質結構。甚至最近2年,代理型AI(Agentic AI)崛起,這是一個可以代理行動的AI,能了解上下文,來進行推理、計畫再展開行動,甚至懂得使用工具蒐集新資訊,來完成任務。

「生成式AI,從根本改變了電腦運算的方式,從檢索式運算,變成了生成式運算模式。」他解釋,過去先產生內容,分散成多個版本,在需要的時候,找出最適合的內容版本來用。但是,現在的AI,可以從上下文了解我們想問什麼,了解人類請求的意義後,產生它所知道的內容,甚至有必要,AI還能檢索資訊,為人們生成答案。「生成答案取代了資料檢索,這徹底改變了電腦運算的模式,全球更掀起了一場平臺變革浪潮,過去是在通用處理器上執行手工開發的軟體,現在轉變了在GPU和加速處理器上執行機器學習應用。」

-600-1.jpg)

圖片來源/Nvidia

黃仁勳強調:「AI下一波浪潮將是機器人學(Robotics),這是物理AI(Physical AI)驅動的新浪潮。」,物理AI指那些可以了解物理世界特性的AI,如摩擦力,慣性,物體恆定性,因果關係等,一輛車開到轉角後看不見,AI可以理解這輛車仍然存在,沒有消失,只是看不見。「 這些理解物理世界的AI,會帶來新的物理AI時代,可以用來實現機器人技術。」

在這場AI界超級盃中,今年主軸是代理AI和物理AI。但最直接影響到企業AI未來2、3年發展的是,因推理LLM而進入爆發轉折點的代理AI。

GAI發展三階段,美銀預測2027年開始爆發企業需求

GTC大會前夕,美國銀行全球研究部(BofA Global Research)剛好在臺舉辦論壇,美銀超級研究部門主管Tap Liani指出,科技的應用才能創造效率,當前的AI發展,正處於基礎設施建設的初期,還沒看到應用程式。現在看到大型雲端公司正在打造AI需要的基礎設施,他們有自己的軟體,可以結合ODM設備商來降低基礎設施的成本,這是第一階段。第二階段是雲端SaaS公司,他們會找到獨特的方式運用AI。

不過,這位長年觀察資料科技和網路安全的資深分析師強調:「第三階段才是影響最大的階段,可能從2027年開始,大量企業要找出適合AI的應用。」像是利用AI來創造新的收入,降低成本,尋找新顧客,尋找新的商業模式等。「第三階段的基礎建設規模,將比現在的規模還要大四到五倍。」

Tap Liani剖析,因為企業不想將自己的數據交給大型雲端業者,為了將數據留在內部,必須建立自己的基礎設施。未來2、3年,企業會積極開始建立邊緣雲,將創新和算力帶到邊緣環境中。從第一階段到接下來的二、三階段發展,「AI基礎設施將是進入一個持續多年成長的發展周期。」

AI基礎設施如何降低成本?必須先區分出訓練和推論的不同,訓練不是節省成本最多的階段,推論才是。「AI推論更適合企業的應用,如果推論成本可以降低9成,甚至更高,將加快推論應用的部署,進而加速企業採用GAI。」Tap Liani觀察。

根據黃仁勳在今年GTC演講中揭露的數據,光是四大公雲業者在2025年就訂了高達360萬張新一代Blackwell GPU卡,比2024年的前一代Hopper GPU訂購量130萬張,多了快三倍。這個數據呼應了美銀超級研究部門主管的觀察,當前處於第一階段的發展,大型雲端積極投入AI基礎設施的建置。等到第三階段,企業大量採用後,知名研究機構如Dell’Oro也曾預測,2028年全球AI資料中心的資本投資規模將高達1兆美元。

發展生成AI的三大難題,推論算力增加100倍

不論處於哪一個AI發展階段,感知AI到生成式AI,推理AI或是物理AI,都要面臨三個根本問題的挑戰,這是基礎設施投資規模暴增的原因。第一個問題是,要如何解決資料問題。因為AI是一種資料驅動的電腦科學,需要大量數位化的經驗數據,才能讓AI獲得數位化的能力。第二個挑戰課題則是如何在不需要人工介入的情況下,能夠解決模型訓練的問題。因為人類的時間有限,必須能夠讓AI用超越人類,超越即時的速度來學習,就不能有人工的介入。最後一個課題是如何擴大規模。需要找到一套演算法,讓投入的資源越多,就能夠讓AI更聰明。

黃仁勳認為,AI資料中心的市場,將比預期更快的速度,達到1兆美元規模,因為代理型AI和推理能力需要的運算量,是去年預估需求的一百倍。

不同於兩年讓人驚艷的ChatGPT,當時單靠預訓練資料和一次性的回答(One-shot),現在的AI可以一步步拆解問題來推理,運用像是思考鏈(Chain of Thought)、Best Of N方法、一致性檢查、多重路徑規劃等不同的方法,一步一步推理。

尤其過去一年來,推理LLM成了代理AI的基礎模型,這類模型透過拆解問題,一步一步解決,可以用不同方法來解一個問題,再選出最好的答案,或是用多種方法解問題,再確認答案的一致性,也可以將找到的答案,帶入到方程式中來檢驗。代理AI運用模型推理能力給出的答案,不再是兩年前慣用的一次性回答。

-600-2.jpg)

圖片來源/Nvidia

這個改變帶來的影響是,「推理產生的Token(詞元)數量,比一次性回答,多了100倍以上。」因為現在出現了有能力產生10倍Token數量的複雜模型,也有10倍算力的技術,可以輕易達到100倍Token量的生成能力。

為了訓練AI的推理能力,需要大量已知答案的問題來合成訓練資料,提供數百類,每類上百萬個的問題範例,來提供多種解法嘗試的答案,需要兆級Token資料量,來訓練具備這類有能力推理的模型。「這是四大公雲GPU採購量特別在今年暴增的原因,這一年來AI基礎架構需求大爆發,訓練和推論所需的算力大大增加了。」

世界需要新的運算方法,AI工廠概念浮現

不過,通用型處理器運算的算力成長速度,有其侷限,「世界需要新的運算方法!」黃仁勳反覆強調這個觀點,點出當前AI,企業AI,甚至可說是企業IT運用模式的典範轉移,從「通用運算搭配手寫的軟體,轉移到,在GPU上執行的機器學習軟體。這樣的轉變已經通過不可逆的臨界點,甚至跨過了快速發展的轉折點,這是帶動資料中心需求暴增的第一股推力。

另一股算力暴增的推力是對軟體未來需求的投資。過去的軟體執行人寫的軟體,但未來將有一種電腦要為軟體生成Token,電腦過去從檔案中檢索現成的資料,現在則是用來生產各種Token。可說是從「檢索運算架構」變成了「生成運算架構」,既有資料中心架構,也要轉變成新的基礎架構設施,黃仁勳稱這個新IT基礎架構設施為「AI工廠」。

「AI工廠唯一任務就是生產Token,再重組成不同類型的資訊。」他解釋。黃仁勳舉例,未來的製造業會有兩種工廠,一間是實際生產線的工廠,另一間是生產製造資訊給生產線使用的AI工廠。像汽車工廠會需要汽車製造的AI工廠,半導體廠也需要生產製程資訊的AI工廠。像Nvidia有一套半導體巨頭都在用的Cuda函式庫cuLITHO,可以用GPU來加速運算半導體生產中的微影(Lithography)製程的設計圖樣資訊。

黃仁勳在GTC上所描繪的AI工廠,像是大型製造業才會用到的AI基礎架構,但若用發電廠來思考AI工廠,不只是大型製造工廠需要電力,一般企業也需要用電,甚至遇到營運不能中斷的需求下,企業還得自己準備一套備援電力或發電機。

當未來所有的應用程式,都如微軟執行長Satya Nadella所說的,會成為AI化的應用,Token生產能力就會像是「用電」需求一樣,成了每一家要用到AI技術的企業,需要的基礎資源,也不能單靠公共電力般的公共Token供應,像是公雲上的AI基礎架構和服務,企業也需要有一套自己的Token設備,類似發電機般的支援不能上雲的Token生產需求,像是處理高度機敏資料或法規禁止上雲的資訊。

推理能力的代理AI的出現,帶來了100倍的Token算力需求後,不只是大型製造業或大型公雲業者,需要打造黃仁勳口中的AI工廠,就連一般企業也將會有一套小型AI工廠,來支援內部AI推論所需。

「AI和機器學習重新發明了整個運算架構。」黃仁勳解釋,不只處理晶片不同、OS層不同,連AP層也不同。而且正因為AP層不一樣了,調度這類AI化AP的方式也不一樣,運作這類AP的方式更是不一樣。「技術架構的每一層都不一樣了。」他開場就強調生成式運算模式的轉變,發生在技術架構的每一層。

舉例來說,資料存取方式開始和過去截然不同,過去,要先精確存取到想要的資料,人們透過閱讀這些資料來理解。但未來,只需對AI問問題,AI就會告訴你答案。「這是企業未來的工作方式,AI代理會成為數位工作團隊的成員,未來將有上百億個數位助手,一起和幾億人協作。」像是Nvidia工程師到今年底也會全部都使用AI來輔助開發,全球3千萬名軟體開發人員,未來也都將用AI輔助。

「AI代理將無所不在,如何運作,企業如何使用,人們如何運用,都會從根本上開始改變。」黃仁勳。

-600-3.jpg)

圖片來源/Nvidia

在演講中,黃仁勳用一個如何安排婚宴主桌座位的問題,來凸顯AI代理結合推論後帶來的挑戰。用同一個問題,同時詢問傳統AI和推理型模型R1,傳統LLM快速(一次性回答)的推論,產生了439個Token,但回答沒有符合需求,而推理型R1則花了比較長的時間推論,過程和結果共產生8,559個Token,得到了有效可用的座位安排。兩者相比,推理型LLM的推論,產生的Token數多了20倍,算力需求更是多了150倍以上。「推論」的算力需求,正是黃仁勳眼中的Nvidia終極考驗。(後續報導請見:瞄準代理AI的推論需求,Nvidia的兩手戰略)

熱門新聞

2026-02-09

2026-02-06

2026-02-09

2026-02-09

2026-02-09

2026-02-10

2026-02-09