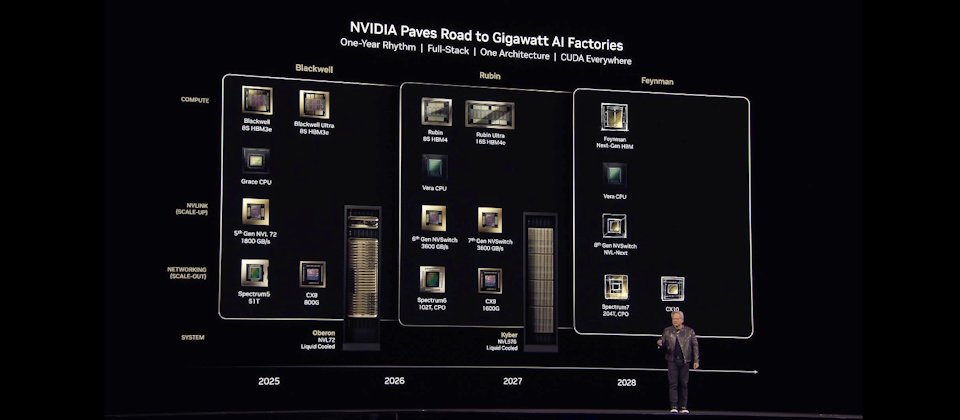

Nvidia未來兩年產品藍圖,2026年下半年將推出以發現暗物質的美國女天文學家為名的Vera Rubin NVL144,效能是GB300 NVL72的3.3倍。下一代的新架構則將以參與挑戰者號太空梭災難調查而聞名的美國物理學家費曼為名。(圖片來源/Nvidia)

在今年GTC大會上,黃仁勳主要揭露了兩手發展戰略,來瞄準未來代理型AI浪潮將帶來的「推論」終極考驗,包括了硬體戰略和軟體戰略。

在硬體戰略上,Nvidia仍舊不斷發展更強大的GPU,而且是採取先垂直擴張(Scale up)再發展水平擴張(Scale out)的做法,不只要發展出一款更強的整櫃式AI超級電腦,還要能夠組合大量機櫃,來發展出一整套的AI超級電腦,這是用來打造發電廠等級的AI工廠之用。

Nvidia今年大會上新發表的Blackwell Ultra 整櫃式AI超級電腦,可用來加強訓練及測試時間擴展推論(Test-time scaling inference),同樣採取了先前的Blackwell架構,但採用效能更高的GB300 NVL72,透過NVlink連接72個Blackwell Ultra GPU,可以提供到1.1 FP4精度的EFlops超強算力,GB300 NVL72的AI效能比GB 200 NVL72高出1.5倍。一套DGS GB300系統可以提供到15 EFlops的算力。Blackwell Ultra預計在2025年下半年開始提供,Nvidia透露,多家伺服器設備業者,如思科、戴爾、HPE、聯想、華碩、富士康、技嘉、和碩、廣達等都將推出相關系統,而AWS、GCP、Azure等雲端服務業者也會提供運算服務。

全新電腦產品線,便當盒大小的個人AI超級電腦

-600-3.jpg)

圖片來源/Nvidia

不只是發電廠等級的AI工廠設備,Nvidia也發表了全新的電腦產品線,來瞄準企業內部的推論需求,包括了DGX Spark與DGX Station個人AI電腦。前者類似Mac mini般的便當盒大小,可以提供到1 PFlops的算力。

臺灣2021年上線的臺灣杉三號超級電腦,5萬多顆核心提供的效能也不過是2.7 PFlops。經過4年,三臺桌上便當盒大小的個人AI電腦的算力,就超過了臺灣杉三號。預購網頁上的售價,128GB記憶體的DGX Spark是3,999美元(約臺幣13萬元)。這一類新的個人AI電腦,正是Nvidia用來瞄準企業未來內部AI需求的發電機等級AI工廠,甚至是可用於邊緣AI環境中。

在Blackwell Ultra之後,黃仁勳也發表了未來兩年的產品藍圖,包括將在2026年下半年,推出以發現暗物質的美國女天文學家Vera Rubin為名的Vera Rubin NVL144,效能是GB300 NVL72的3.3倍,記憶體容量、頻寬、NVLink速度的提升超過1.6倍以上。2027年下半年還將推出Rubin Ultra NVL576,效能比GB300 NVL72提高14倍,更可以搭配NVLink7、CX9大幅提升記憶體數量和頻寬速度。

-600.jpg)

圖片來源/Nvidia

在Vera Rubin之後,黃仁勳預告,新架構將以參與挑戰者號太空梭災難調查,而聞名的美國物理學家費曼為名。

Nvidia的產品戰略,向來都非常重視軟體,甚至比硬體更看重,在AI工廠需求的戰略布局也不例外。

全新的AI工廠作業系統Nvidia Dynamo

除了持續擴大AI加速函式庫CUDA-X到不同領域,發展不同領域的專用加速函式庫,另外,黃仁勳發表一套全新的AI工廠作業系統Nvidia Dynamo,而且還開源釋出。

Nvidia Dynamo是一套開源的推論服務框架,可以用來建立一個提供LLM推論服務平臺用的框架,可以部署在K8s環境之上,透過Dynamo來部署和調度大規模的AI推論任務。Nvidia也計畫將Dynamo納入到他們的微服務框架NIM中,成為Nvidia AI Enterprise企業AI框架的元件之一。

-600-%EF%BC%93-NVIDIA%20Dynamo.jpg)

Dynamo是Nvidia原有開源推論伺服平臺Triton專案的下一代產品,最大的特色是,Dynamo將LLM推論工作細分成兩個階段的任務,可以更彈性善用GPU來優化不同階段的推論處理,達到提高效率和優化GPU利用率的效果。甚至可以依據推論需求,動態調度GPU,也能加速GPU之間的非同步資料傳輸,來縮短模型推理的回應時間。

以Transformer架構為主的GAI模型,進行推論時還細分成兩個階段,第一階段稱為Prefill(預輸入),要將輸入資料轉換成Token儲存,這是一個高耗運算的平行處理任務,第二個階段則是Decode(解碼),這是一個序列式的處理,得依據前一次解碼的Token,來生成下一次的Token,速度慢,又相當消耗記憶體。

傳統的LLM推論會將Prefill和Decode任務都交給同一個GPU來處理,但這兩類任務的運算特性不同,Dynamo拆解了推論過程的這兩類任務,可以分別指派GPU資源來處理,也能跟對各自不同的任務特性來動態調度,達到優化GPU叢集的效果。

根據Nvidia的測試,同樣在GB200 NVL72上執行6,710億參數量的DeepSeek-R1模型,改用Dynamo後,可以將推論效能提高30倍,而用Hopper GPU 執行的Llama 70B的效能也可以提高一倍以上。

因為推論任務的運算非常複雜,再加上有不同類型的平行處理模型,管理推論工作是一件非常複雜的挑戰,黃仁勳強調:「這正是Nvidia推出Dynamo框架的原因,可以成為一套AI工廠的作業系統。」

傳統資料中心,主要靠像是VMware這類作業系統,來調度不同的AP,在企業IT資源上運作。AI代理是未來的應用程式,未來AI工廠需要的OS,不是VMware,而是Dynamo。

黃仁勳以引發工業革命的發電機Dynamo來命名,更揭露了他對這套全新AI工廠作業系統的期許和野望。

熱門新聞

2026-02-11

2026-02-11

2026-02-12

2026-02-10

2026-02-09

2026-02-10

2026-02-13