現今AI議題炙手可熱,企業無論行業屬性、也不管規模大小,都競相啟動AI發展計畫。

事實上AI技術問世迄今已長達數十年,絕非近年才初出茅廬的新產物,那麼為何此刻大家對它熱情簇擁?HPE資訊系統技術經理馬西聰指出,眾所周知其驅動因素正是生成式AI(GenAI),它迥異於以往帶有更高進入門檻、繁重模型訓練負擔的鑑別式AI,任何人只要會下Prompt,即便不具程式開發背景,都有機會駕馭AI,順勢開啟莫大的創新應用想像空間。

企業決定踏上AI旅程,自然需要佈建必要的算力。談到算力,大家直覺聯想到的投資標的,無非正是NVIDIA所提供的高階GPU伺服器,此類產品往往要價不菲。因此HPE提出建議,企業應先釐清AI使用情境,究竟較偏向Training、Fine Tuning或Inference,再決定適用的運算主機,最終正解未必是昂貴的GPU Server;完成主機的選型後,接著還需要考量散熱議題。

是否部署高階GPU伺服器?端看AI應用情境而定

針對GenAI,現在可望為企業帶來的立即性好處,主要彰顯於兩類應用,一是知識管理(KM),過往員工利用關鍵字搜尋,經常因下錯關鍵字而尋找不到所需檔案內容,如今利用自然語言對大語言模型(LLM)提問,可望得到更貼近需求的搜尋結果。二是數位客服,從前礙於難以編寫完善的腳本,導致Chatbot答題能力受限,如今結合LLM與GenAI,形同解題的素材增多,連帶提升Chatbot的應答實力。

但如果回頭檢視企業AI應用,他直言有頗高比例的臺灣用戶,除了像是製造業瑕疵檢測等少數場景外,基本上不太會有Training需求;尤其如果今天使用LLM,充其量要做的是Fine Tuning,更有甚者,比起Fine Tuning更常見的應用,其實在於推論(Inference)。換言之現今最普遍的AI應用情境,大致落在Fine Tuning或推論兩類。

以Fine Tuning和推論來看,都不會出現涉及多GPU的Job。當確認這個基本知識後,企業即應有所定見,知道自己並不需要斥資購置裝載8顆NVIDIA GPU的大型機器;反之若是以Training為主的AI環境,部署這類大型主機,才會順理成章。

論及需求,企業不妨先探索NVIDIA NVLink內涵。從NVIDIA主機來看,經常可見SXM5 GPU,此GPU與GPU間均透過NVLink連接,其中需要藉由NVSwitch串接眾多GPU,所以其規格往往是4或8顆起跳。好處是當一個像是模型訓練之類的多GPU工作負載運行時,可快速將大型資料集輸入模型,並於GPU間執行高速的資料交換。

惟目前大約70%的企業AI工作負載,都屬於Remodeling或推論,算力需求皆低於1顆GPU,不必採用NVSwitch如此大型的串接方式。換言之企業宜先跳脫迷思,審慎思考自己需要什麼,如此才能進行最適化選型。

混搭GPU+CPU,為進退皆宜的理想架構

馬西聰提到「AI運算架構選型的起始點,端看你要做什麼工作,」,假使做的像是推論之類仍需仰賴CPU的工作,那麼選擇帶有傳統CPU的彈性架構,會是「進可攻、退可守」的安全做法,不見得需要一味追逐像是DGX GH200這般超級電腦。

HPE提供的多款GPU伺服器,皆具備前述提到的彈性特質。

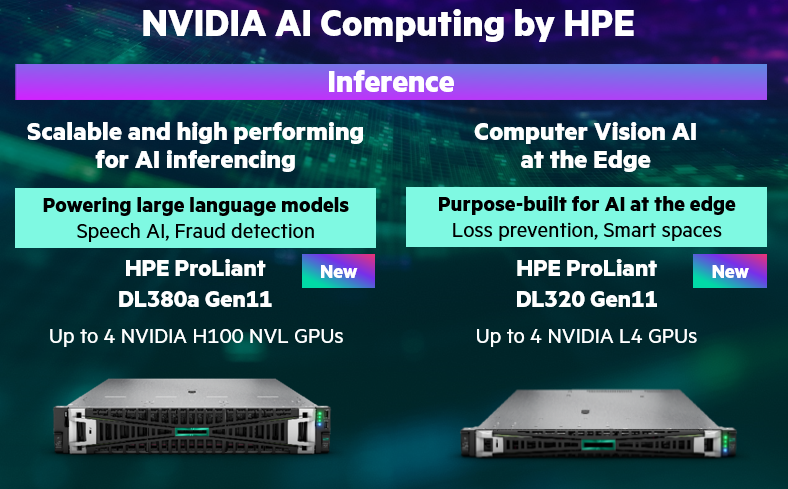

譬如針對Fine Tuning部份,HPE提供ProLiant DL380a Gen12和ProLiant DL384 Gen12兩款適用機種。另針對推論部分,則主推ProLiant DL380a Gen11、ProLiant DL320 Gen11。

其中380a Gen12至多可承載8張H200、搭配兩顆Intel CPU,當企業不確定其Workload態樣,此類機種堪稱是進可攻、退可守的理想選項。再來的DL384 Gen12,可承載兩片GH200 NVL2 GPU,因適用於「Grace Hopper」最新架構,就意謂其中會搭載一顆Arm CPU,沒有傳統x86 CPU;若企業利用它來執行訓練工作,便可串起兩片GH200,在其間進行高速資料交換,從而加快作業進程。

在推論方面,DL380a Gen11可裝載4張H100;DL320 Gen11則能裝載4張L4 GPU。談到單純的邊緣推論應用,甚至像是影像處理,L4 GPU都是非常適用的高CP值選項。

企業導入GPU之前,其實需要先做一件事,便是改造機房。因為以H100 GPU為例,每個耗電量約350瓦,一台伺服器安裝兩個GPU、合計就有700瓦,另外加上兩顆CPU,整體功耗直逼1,000瓦。綜觀國內當前最先進的IDC,每座機櫃大致能提供6,000瓦電力,意謂一座42U機櫃只能放置六台GPU Server,大約佔用12U,形成約莫30U的極大空間浪費。

但比起「電」,更棘手的難題在於「熱」。以往有眾多廠家提出浸潤式冷卻方案,但由於所用液體並非環境友善,發展之路稍稍受阻,使得水冷穩居主流;惟以現況而言,若非新建IDC,水冷機櫃供應量偏少,可說有錢都買不到或租不到;那麼是否有權宜做法?HPE提出RDHX方案,儘管基於氣冷架構,但在機櫃旁加裝水冷門,如打開冷凍庫般,能讓機櫃抽進冰空氣;或藉由ARCS方案,以較大的封閉循環方式,達到與RDHX類似的快速散熱效果。

除此之外,HPE還提供「100%水冷」及「70%水冷+30%氣冷」等方案,其中後者更被列為現階段主力推廣的選項;深究其因,在於企業即便部署水冷伺服器,但機櫃內放置的不只有伺服器,還有儲存、網路等其餘設備,仍需藉助氣冷方式進行散熱,足見透過水冷及氣冷混合設計,相對適用於AI機房。

總括來說,企業在佈局AI算力的過程,切莫淪落人云亦云、冒然追逐名牌超級電腦,應先認清自身使用情境,再據此選擇適用的運算架構,最終再配合適當的冷卻架構設計,便有望鋪排出最穩健的AI發展路徑。

其它相關文章:

HPE儲存技術突破AI與GPU應用效能瓶頸打造高效創新資料應用https://www.ithome.com.tw/pr/166692

HPE擴展直接液冷超級運算解決方案,推出兩款專為服務供應商與大型企業打造的AI系統 https://www.ctee.com.tw/news/20241126700636-431202

敦新科技為HPE伺服器及儲存設備的專業代理商,提供IT投資解決方案幫助客戶轉型數位化業務,協助HPE經銷夥伴專業銷售,凝聚從基礎架構建置到儲存設備,以及資料安全到專業服務的全面銷售能力。最新各種機種及HPE專業服務,歡迎洽詢HPE事業部: 02-8978-5386,或造訪: www.dawningtech.com.tw。

.png)

熱門新聞

2026-02-02

2026-02-03

2026-02-04

2026-02-02

2026-02-04

2026-02-03

2026-02-05