生成式AI暴紅一整年,Nvidia資料中心GPU產品H100成為整個IT市場追捧的重要物資,不只是伺服器廠商推出多款設備,大型公有雲業者也陸續發表搭配這款GPU的運算服務。以正式上線的時間為基準,AWS今年6月底正式推出Amazon EC2 P5,微軟Azure在3月發表ND H100 v5,8月在美國東部與美國中南部這兩個地區的資料中心正式開始提供這項GP運算服務,若是有意採用的企業與組織,需到Azure網站填寫需求表單、輸入預計執行的虛擬機器數量、虛擬機器保留期間、用途,以及企業與組織的員工規模,再由相關地區的微軟業務團隊與其聯繫、洽談後續的試用。到了11月,微軟Azure發表新的GPU運算服務NC H100 v5系列,能用於中型的AI模型的訓練與生成式AI推論,以及主打支援機密運算特色的GPU運算服務NCC H100 v5系列,這兩款服務目前都處於公開預覽測試的狀態。

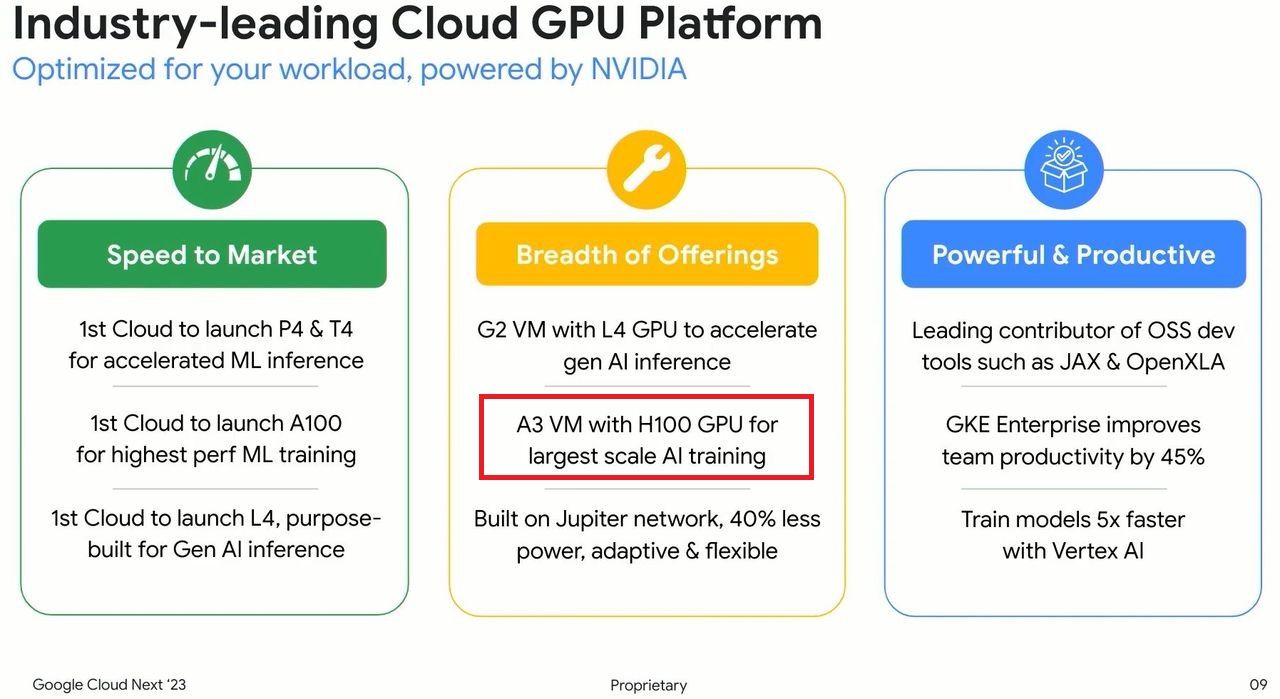

至於Google Cloud,在5月舉行的Google I/O大會期間,預告將推出搭配Nvidia H100的運算服務A3,由於此服務當時處於封閉預覽狀態,企業與組織若要進行評估,需填寫線上表單申請試用。

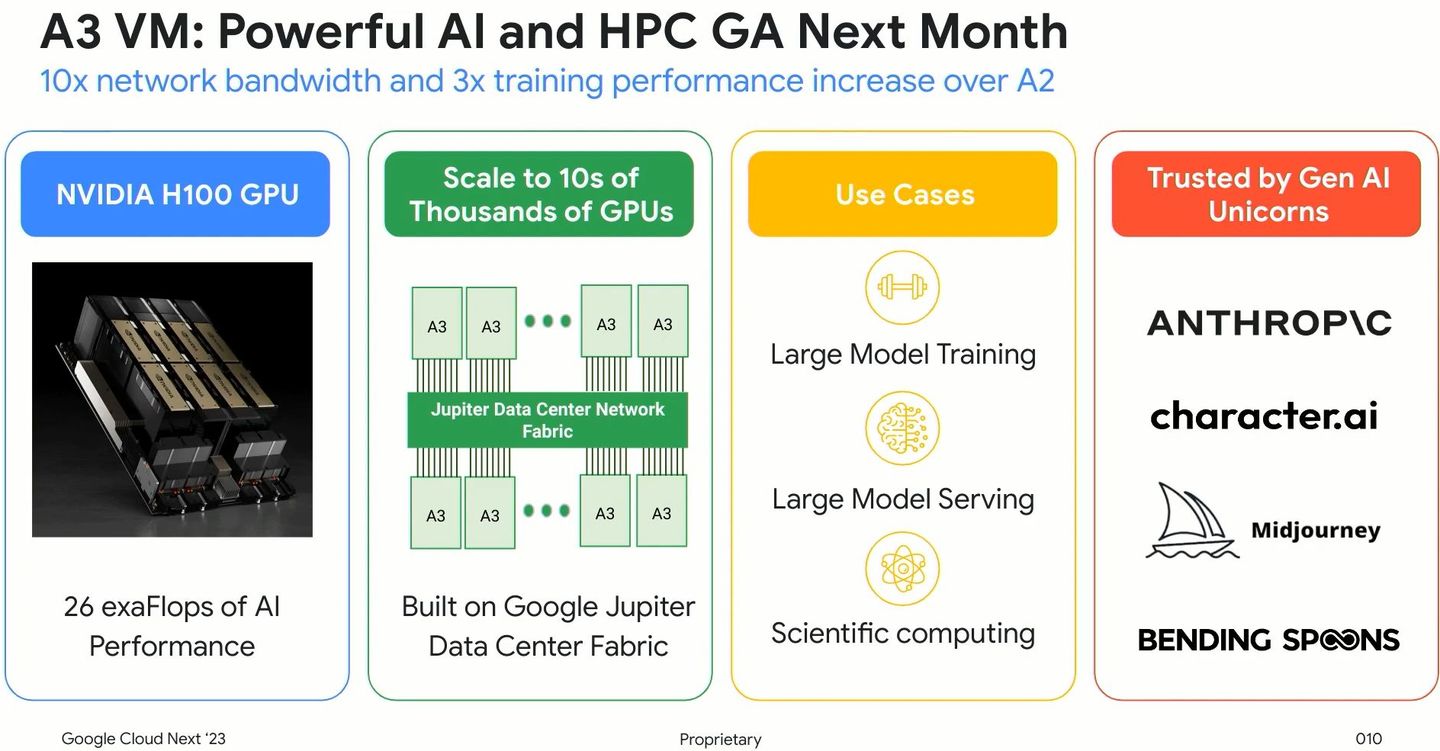

到了8月底舉行的Google Cloud Next大會期間,該公司宣布A3將於下個月正式推出,支援大型AI模型的處理。而在這項運算服務的組態與特色的描述,大致與先前相同,但也補充一些細節,例如,搭配的英特爾第四代Xeon Scalable處理器會是2顆,而網路效能改善源於IPU的部分,Google Cloud此時將這項連線加速裝置稱為Titanium網路卡。除此之外,他們也特別公布一個使用案例:因推出生成式AI繪圖應用而舉世聞名的Midjourney,他們的平臺採用Google Cloud今年新推出的兩個GPU運算服務,其中的A3可提供2倍的圖片生成速度(相較於搭配A100 GPU的環境)。

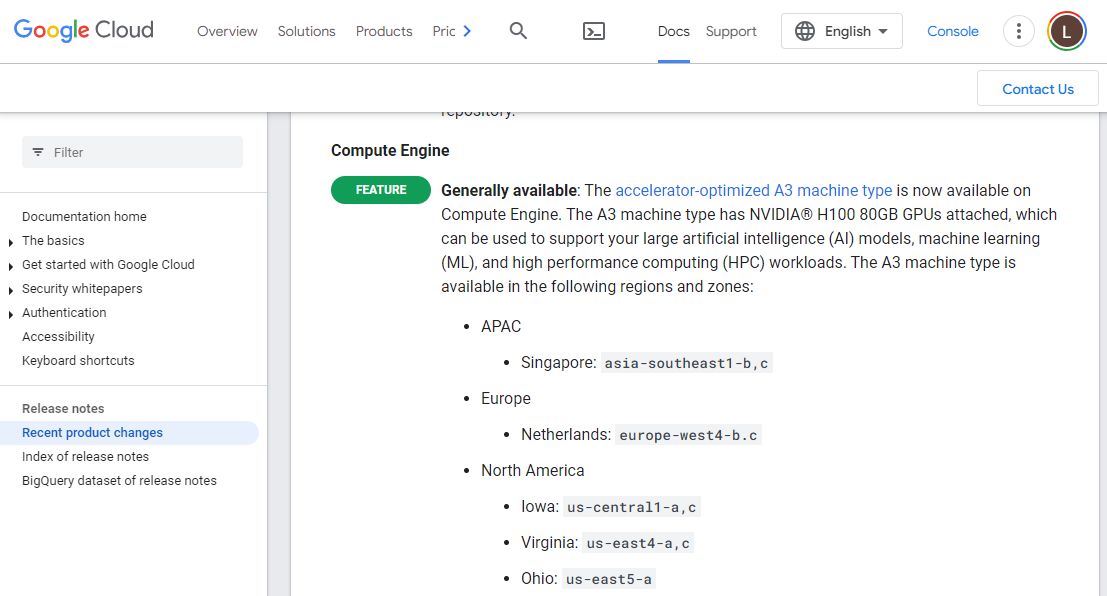

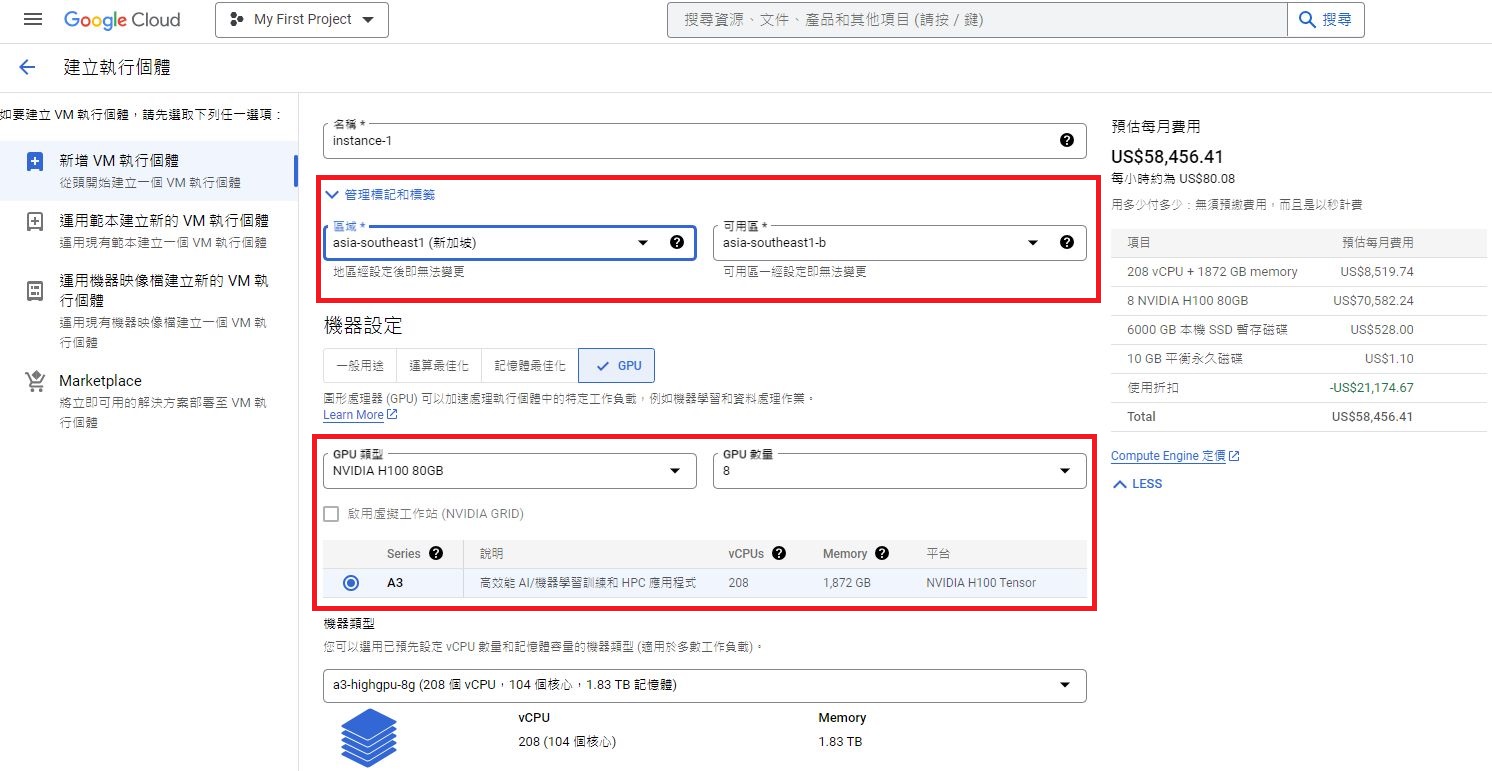

經過幾個月的等待,A3最近終於正式開放供應。根據Google Cloud release notes的12月21日公告,A3在Compute Engine上架,目前在亞太、歐洲、北美共5個區域的資料中心,均可選用A3。

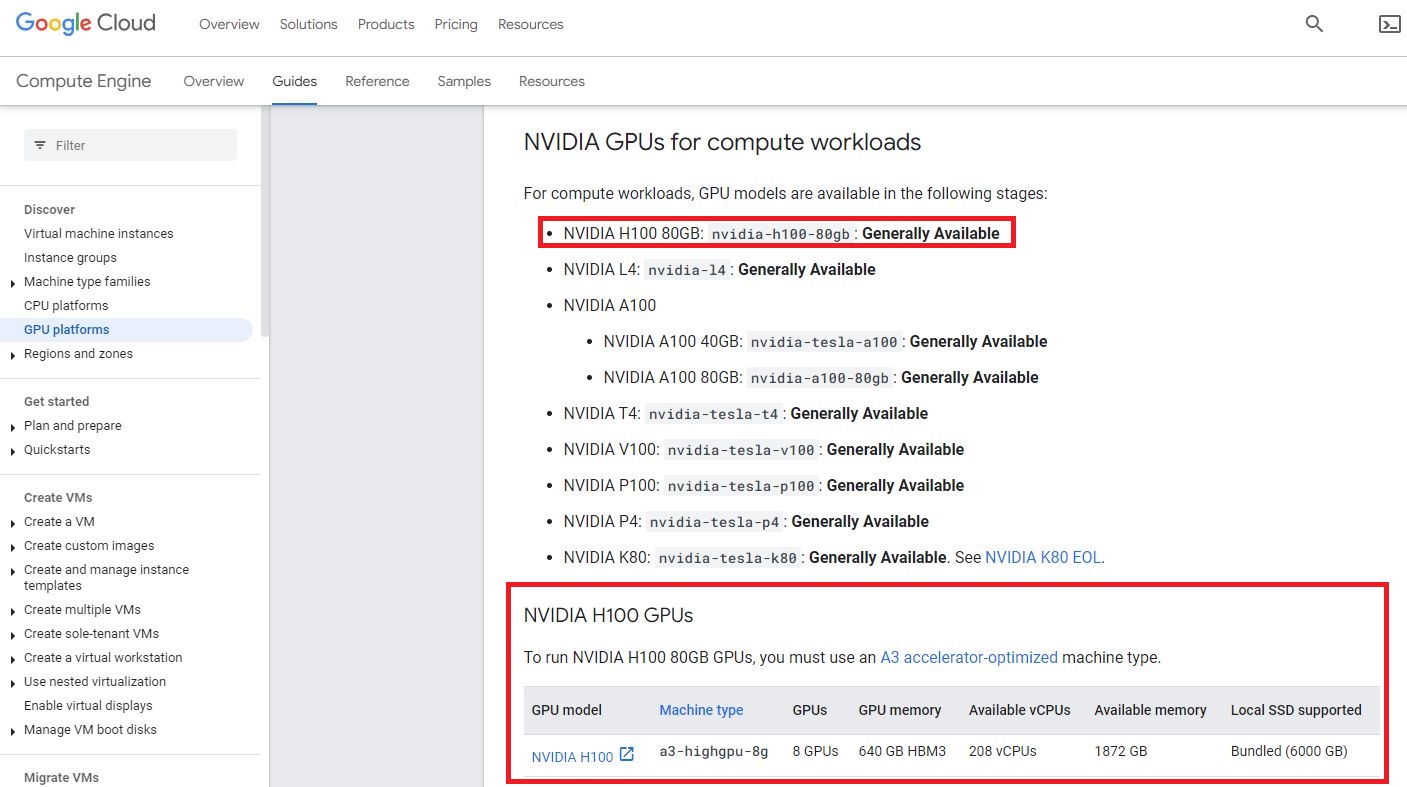

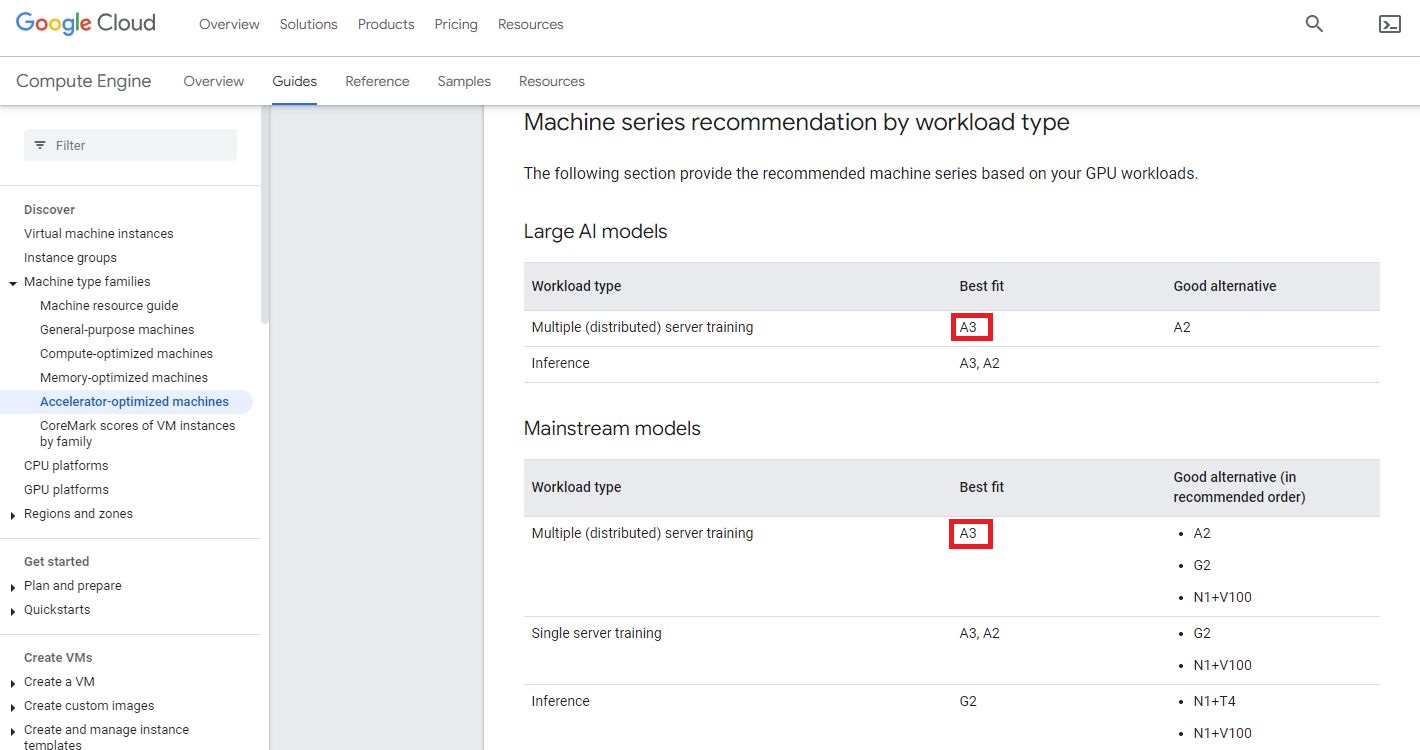

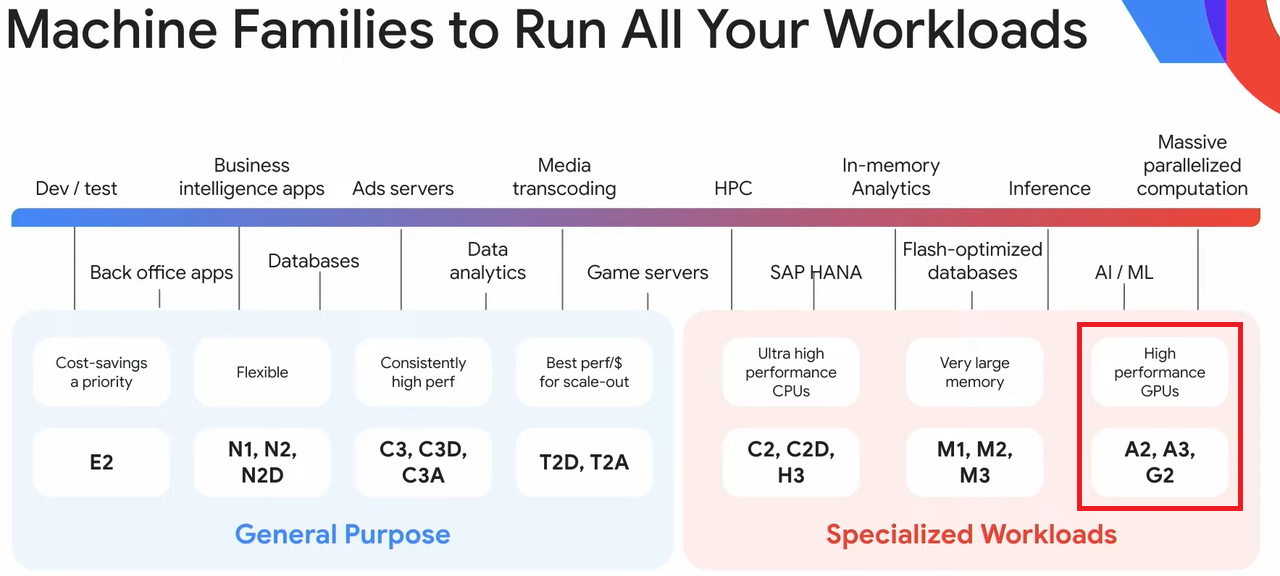

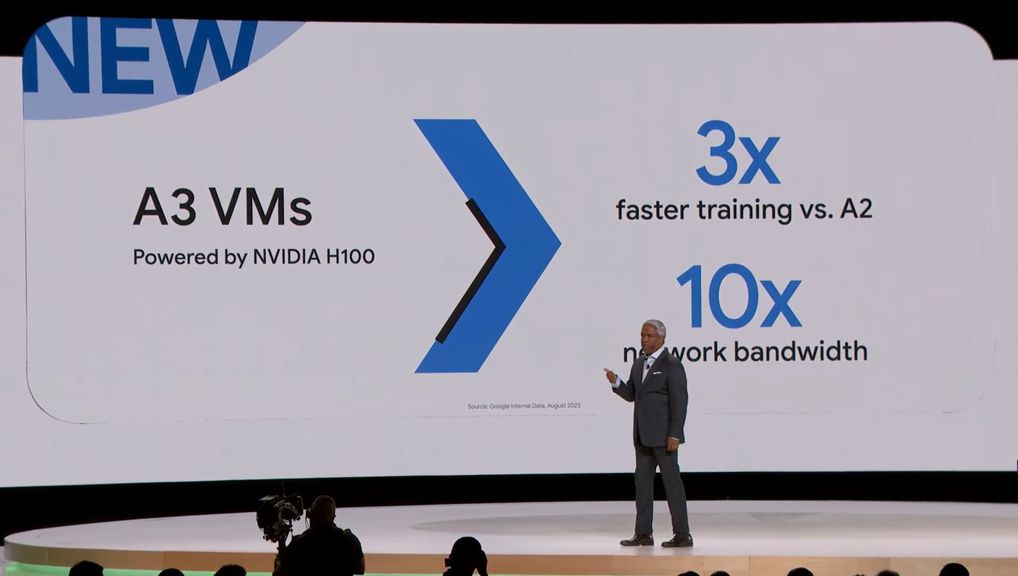

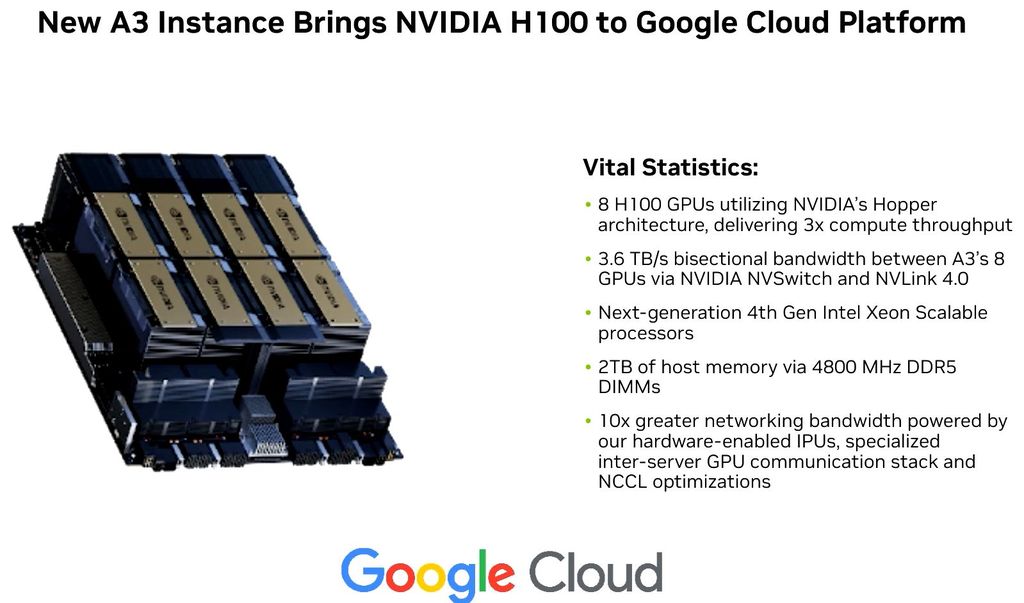

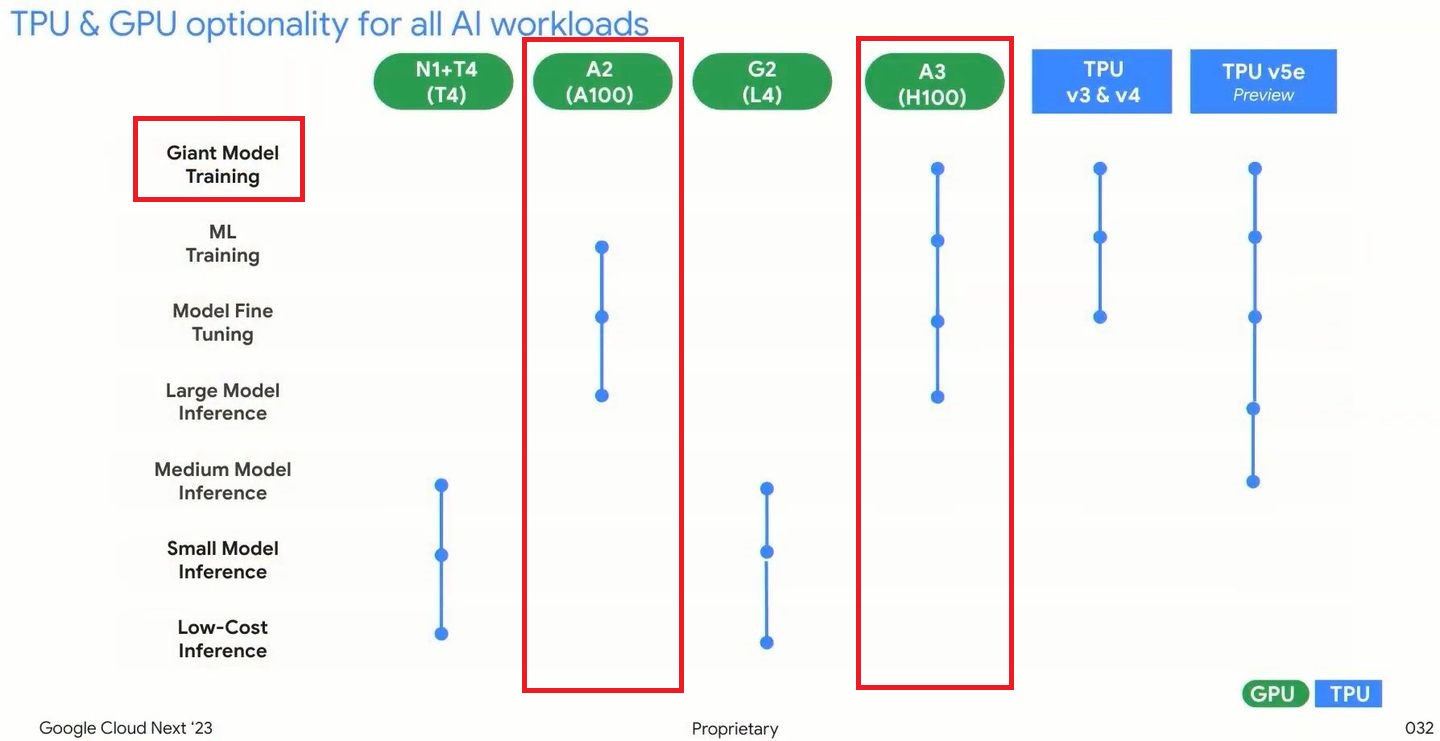

A3本身配備那些新技術?就運算層面而言,它搭配8個Nvidia H100 GPU,提供3倍的運算吞吐能力,而GPU之間的資料傳輸,會透過Nvidia發展的新一代高速I/O介面:NVLink 4.0與第四代NVSwitch,雙向傳輸頻寬可達3.6 TB/s;處理器與記憶體也升級到新一代規格,預計搭配英特爾第四代Xeon Scalable,以及2TB容量的DDR5-4800;在網路層面上,A3採用他們訂製設計的基礎設施處理器(IPU),亦即英特爾的IPU ASIC E2000,提供200 Gbps的網路傳輸介面,當中導入IPU硬體卸載、特製的跨伺服器GPU通訊堆疊,以及支援Nvidia集結通訊程式庫(NCCL)最佳化處理,能將A3的網路頻寬提升至10倍。

採用Nvidia H100之餘,由於A3設置在Google自詡最先進的網路環境,因此,也連帶獲得多種效益。

首先,在該公司現行的GPU運算服務當中,A3在IPU的幫忙之下,雲端運算服務底層伺服器GPU之間的資料傳輸,不需經過CPU,而且源自其他虛擬機器的網路與資料流量,可跨越個別網路介面傳輸,因此,相較於Google Cloud既有的GPU運算服務A2,新登場的A3網路頻寬可提升至10倍,而且能提供低延遲與高穩定的連線。

在底層交織網路的配置上,A3坐落在Google Cloud發展的資料中心網路環境Jupiter,可支援數萬個GPU互連,本身也能使用可完整運用所有頻寬、支援重新設置的光纖網路連接方式,提供隨需調整網路拓樸的彈性,可針對各種結構的工作負載,提供足夠的頻寬,與費用較高的市售交織網路相比,Jupiter能帶來相近的使用成效,但具有更低的總體持有成本。

關於AI運算效能的表現上,A3最大可供應26 ExaFlops的處理能力,可顯著減少訓練大型機器學習模型的所需時間與成本。若用在AI推論,A3的成效更為顯著,若以A2的運算效能為基準,A3領先幅度可達到30倍。

產品資訊

Google Cloud A3

●原廠:Google Cloud

●建議售價:新加坡資料中心(asia-southeast1)每月58,456.41美元

●處理器:英特爾第四代Xeon Scalable(Xeon Platinum 8481C)

●提供服務規模選擇與組態:a3-highgpu-8g,208顆虛擬處理器、1872 GiB記憶體、儲存空間最大為257 TB、8個Nvidia H100 GPU、網路頻寬為1,000 Gbps

【註:規格與價格由廠商提供,因時有異動,正確資訊請洽廠商】

熱門新聞

2026-02-06

2026-02-06

2026-02-06

2026-02-06

2026-02-09

2026-02-09