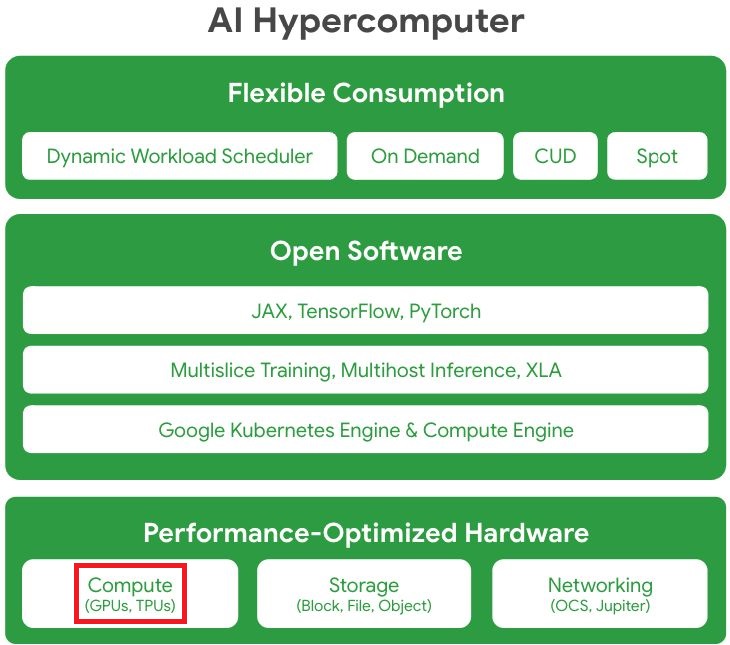

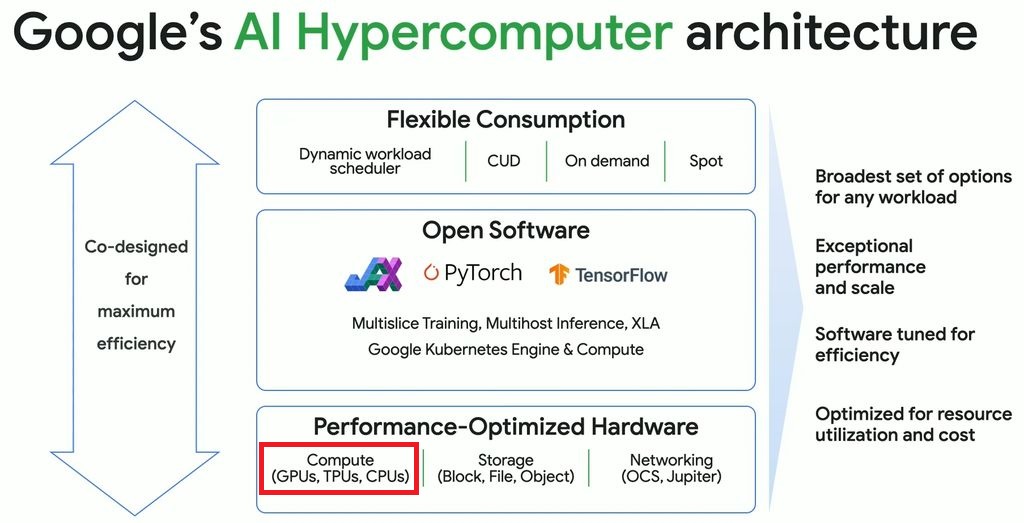

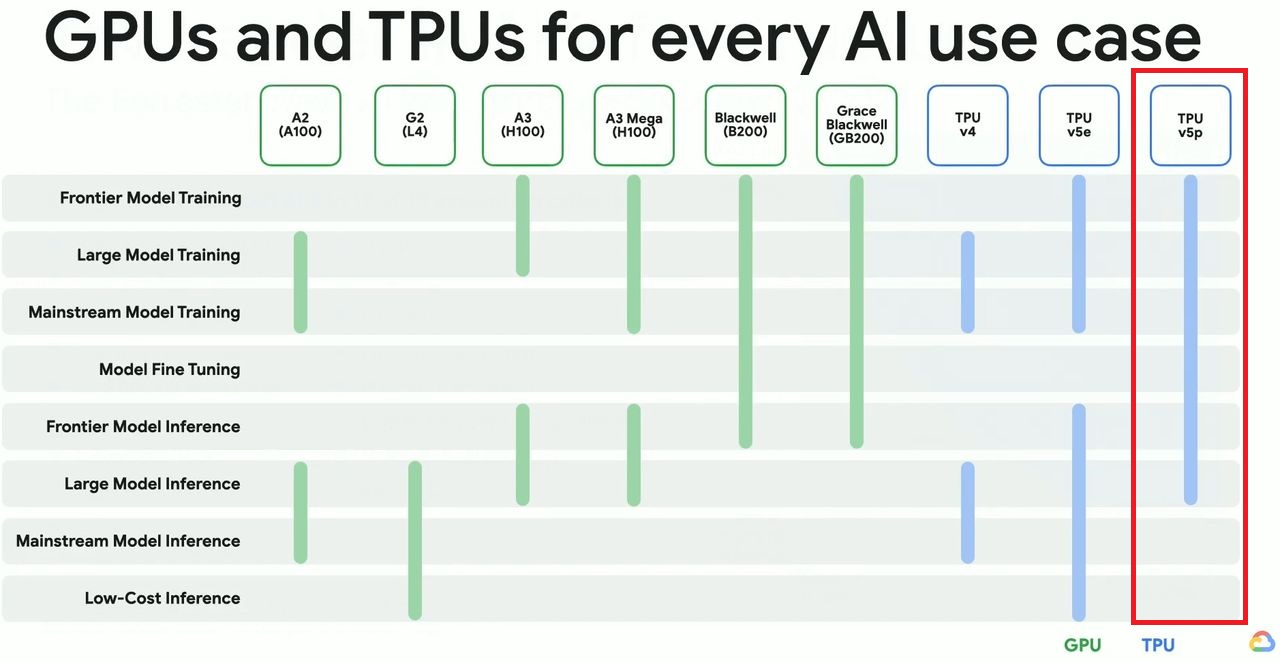

基於自行研發設計的第五代TPU晶片,Google Cloud去年8月發表AI加速運算服務TPU v5e,相隔3個月後正式上線,12月他們發表性能更強大的TPU v5p,並首度提出Google AI Hypercomputer的系統概念,公布多個先期導入案例,包含自家Google DeepMind、Google Research,以及CRM雲端服務廠商Salesforce、影片與圖片App開發商Lightricks,

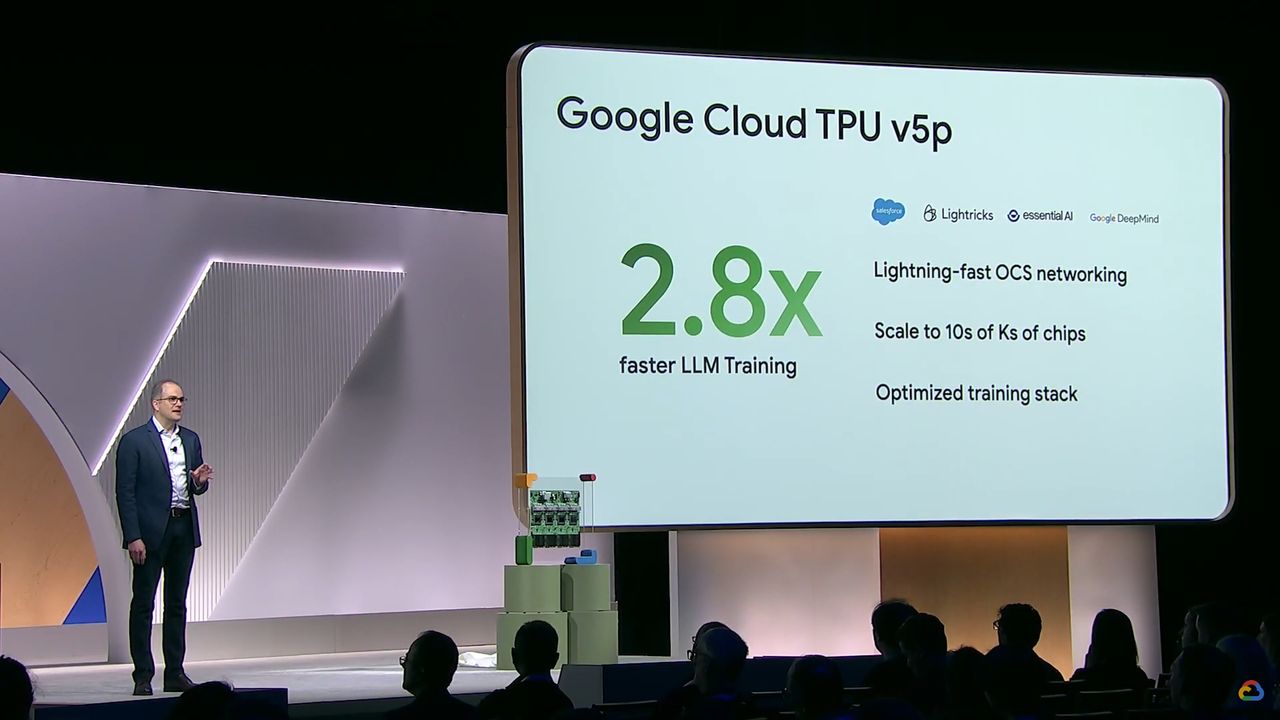

到了今年4月舉行的Next年度大會期間,TPU v5p宣告推出。

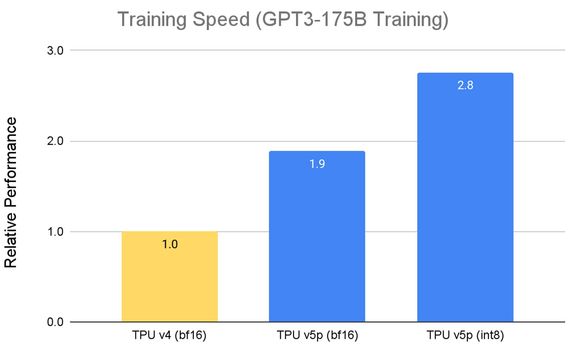

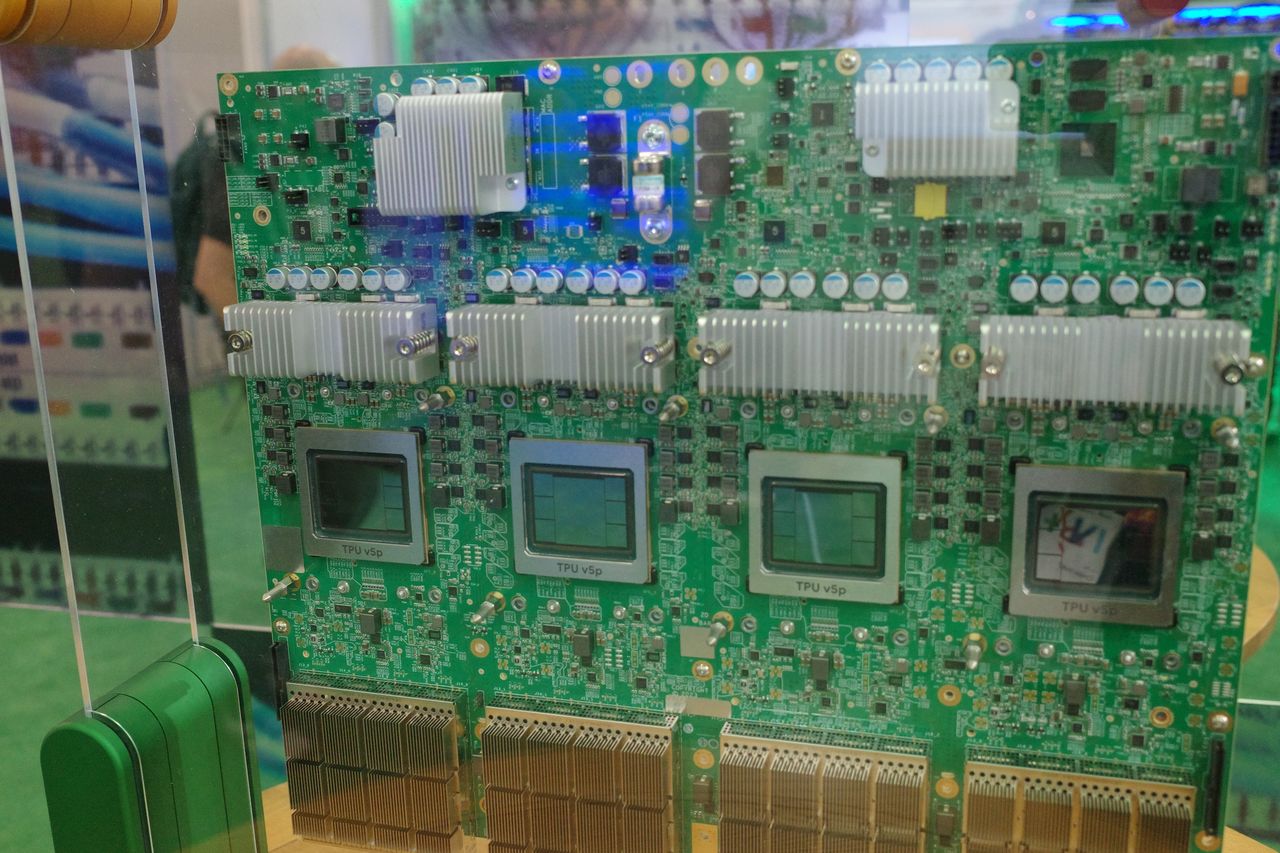

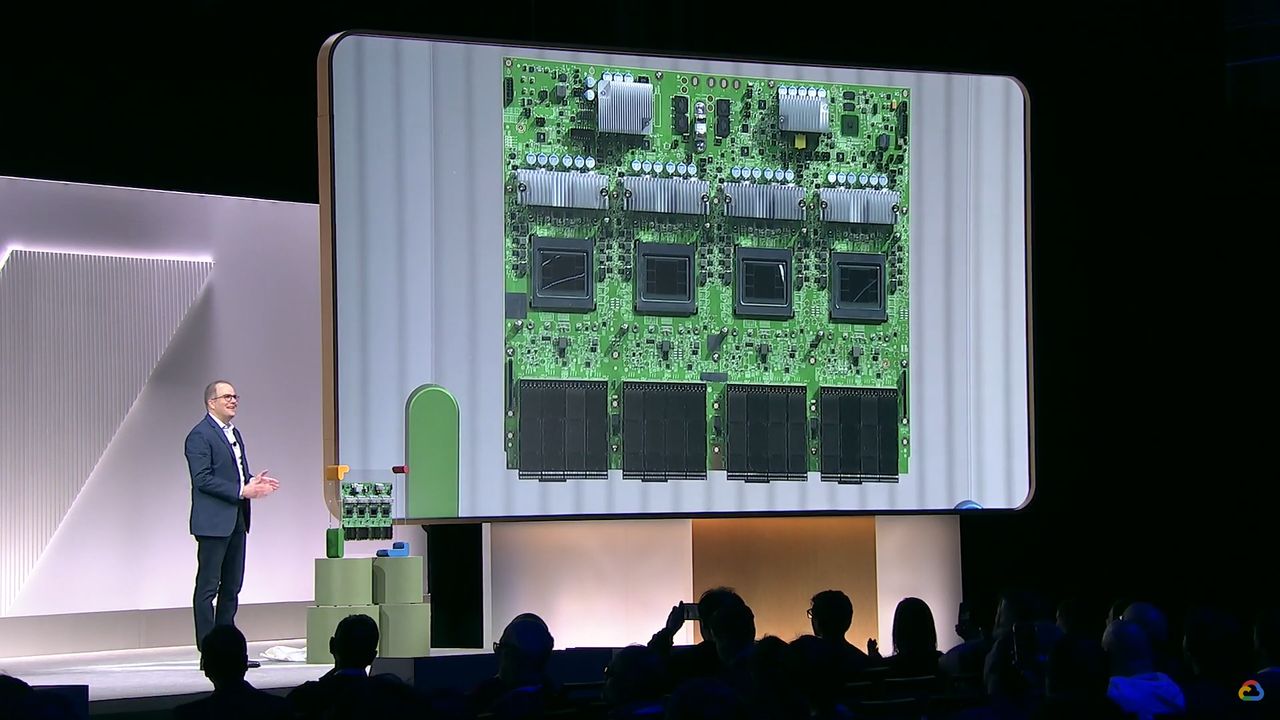

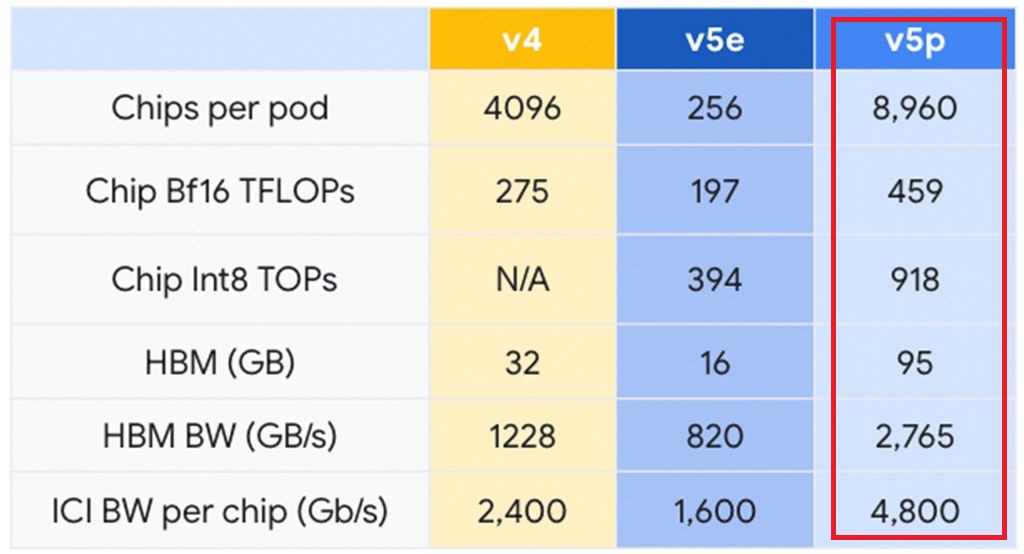

先從去年底Google Cloud揭露資訊來看,相較於上一代TPU v4,TPU v5p配備的高頻寬記憶體容量提升至3倍,額外內建第二代稀疏運算核心(SparseCore),可提供逼近2倍的浮點運算效能,訓練大型語言模型 (LLM)進行INT8整數運算時,處理速度可提升至2.8倍。

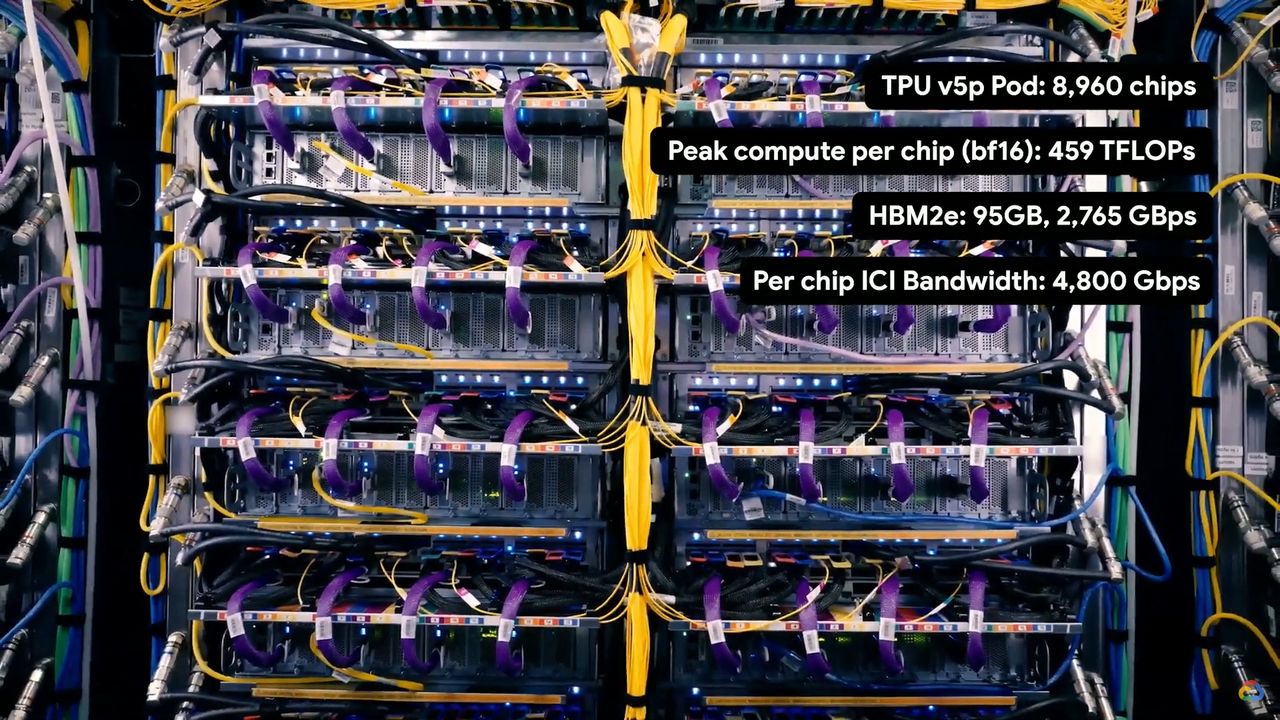

而在延展性的部分,就多個TPU組成的單座Pod而言,若全部搭配TPU v4,能使用3D網狀(3D mesh)拓樸架構,最多可連接4,096個晶片,晶片互連頻寬為2,400 Gbps;如果搭配TPU v5p,能使用3D環形網狀(3D torus)拓樸架構,最多可連接8,960個晶片,擴展規模提升至4倍,晶片互連頻寬為4,800 Gbps,提升至兩倍。

關於產品服務的性價比,Google Cloud當時也綜合內部測試資料,以及MLCommons MLPerf v3.1 Training公布資料,列出TPU v4、TPU v5e、TPU v5p執行GPT-3 175B模型訓練的比較,並以TPU v4為基準,結果顯示TPU v5e最實惠,單位成本效能可達到2.3倍,TPU v5p為2.1倍,而在單位效能成本的呈現上,TPU v4每小時每個晶片為3.22美元,去年底上線的TPU v5e為1.2美元,最新推出的TPU v5p則為4.2美元。

今年4月TPU v5p宣告上線之際,Google Cloud重申其特色,同時提到能在用戶設置更大型(slice)的Pod時,獲得更大的運算吞吐量,他們表示,若是搭配512個至6,144個TPU v5p組成一座Pod,運算吞吐量可提升至11.97倍,達到近乎線性增長的效能改善幅度。

攝影/余至浩

攝影/余至浩

在此同時,Google Cloud也宣布Kubernetes代管平臺GKE支援TPU v5p,以及TPU multi-host serving on GKE的工作模式。以後者而言,是指由多臺主機部署而成的AI模型伺服器,能夠以單一邏輯單位的形式進行集中管理與監控。

針對上述架構帶來的實際成效,App廠商Lightricks表示,同樣面對文字轉圖片、文字轉影片的AI模型訓練,相較於採用TPU v4,新支援的TPU v5p on GKE速度提升至2.5倍。

產品資訊

Google Cloud TPU v5p

●原廠:Google Cloud

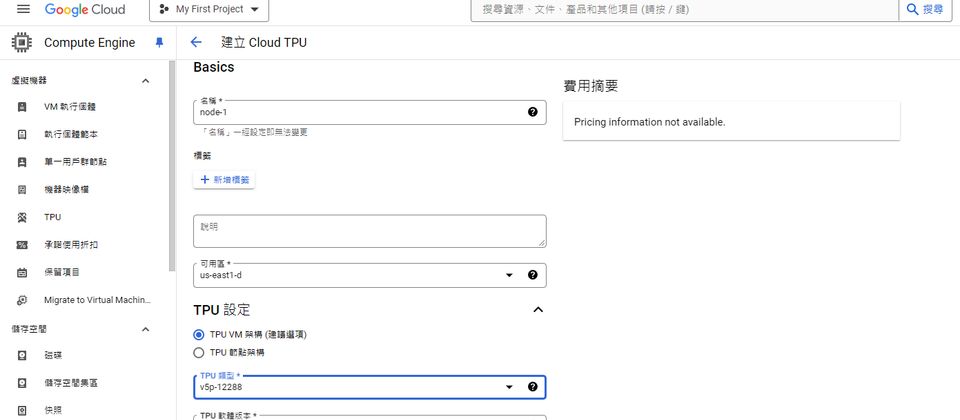

●建議售價:us-east1區域每個TPU每小時4.2美元

●系統架構:TensorCore核心(4個矩陣乘法單元、1個向量單元、1個純量單元)、高頻寬記憶體

●晶片互連頻寬:4,800 Gbps

●高頻寬記憶體類型與容量:95 GB HBM2e

●高頻寬記憶體頻寬:2765 GB/s

●運算效能:INT8為918 TOPS,BF16為459 TFLOPS

●單座Pod配置:最大容納8,960個TPU,3D環形網狀互連拓樸架構

【註:規格與價格由廠商提供,因時有異動,正確資訊請洽廠商】

熱門新聞

2026-02-09

2026-02-06

2026-02-09

2026-02-09

2026-02-09

2026-02-06

2026-02-09