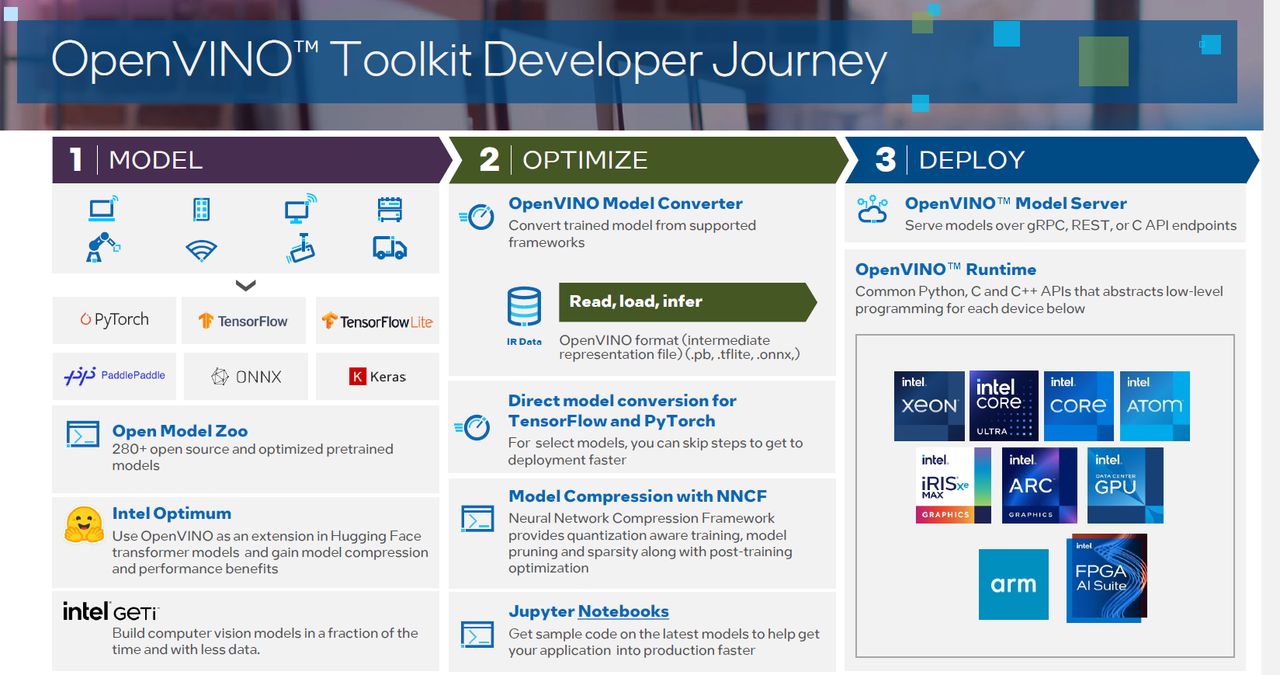

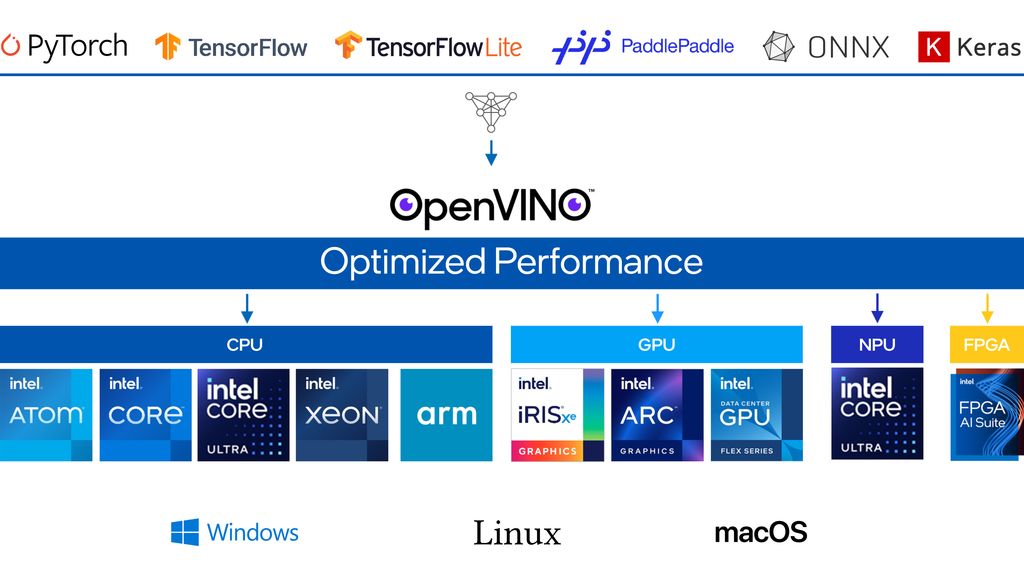

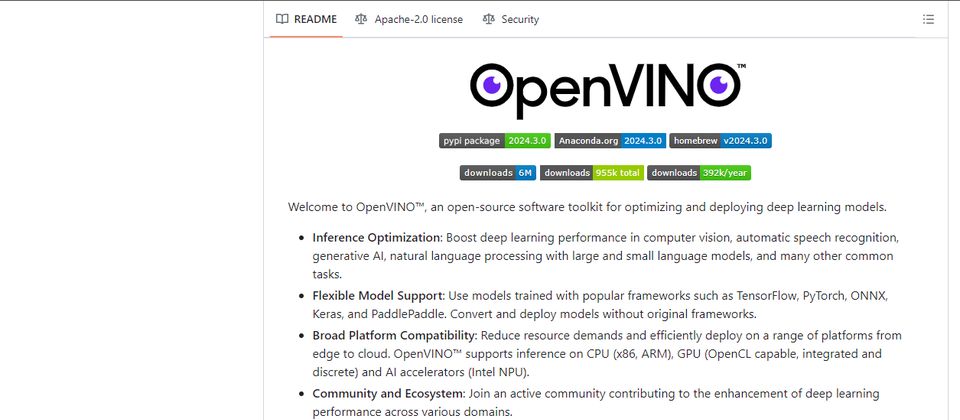

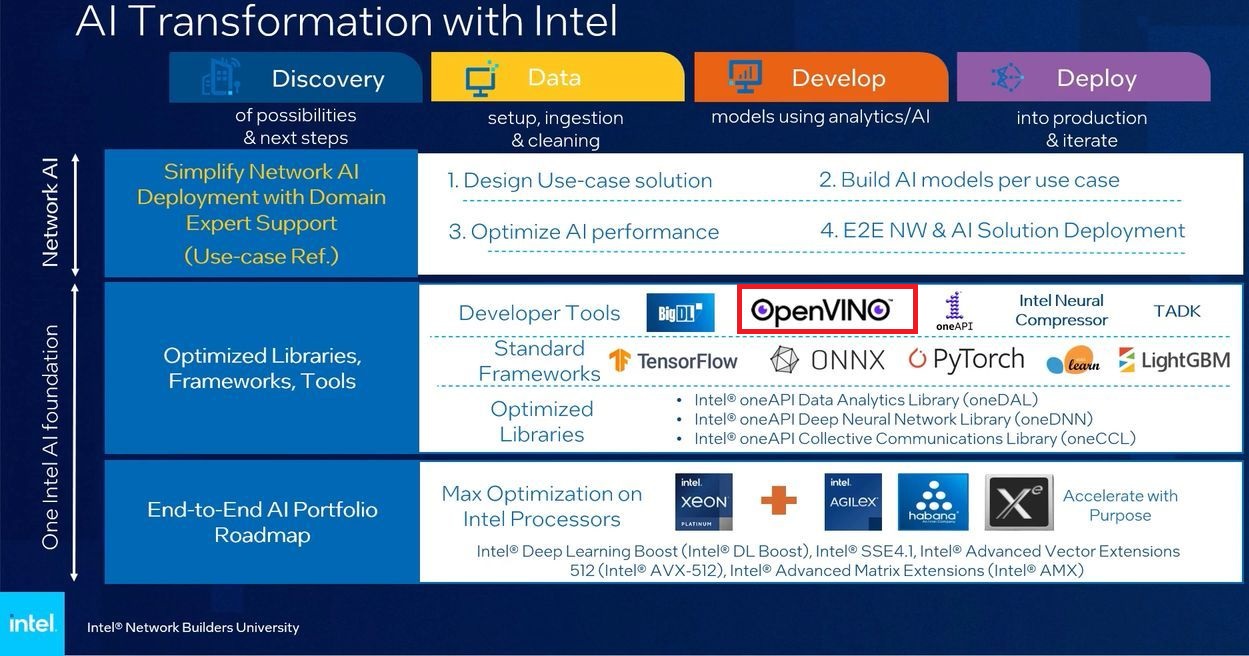

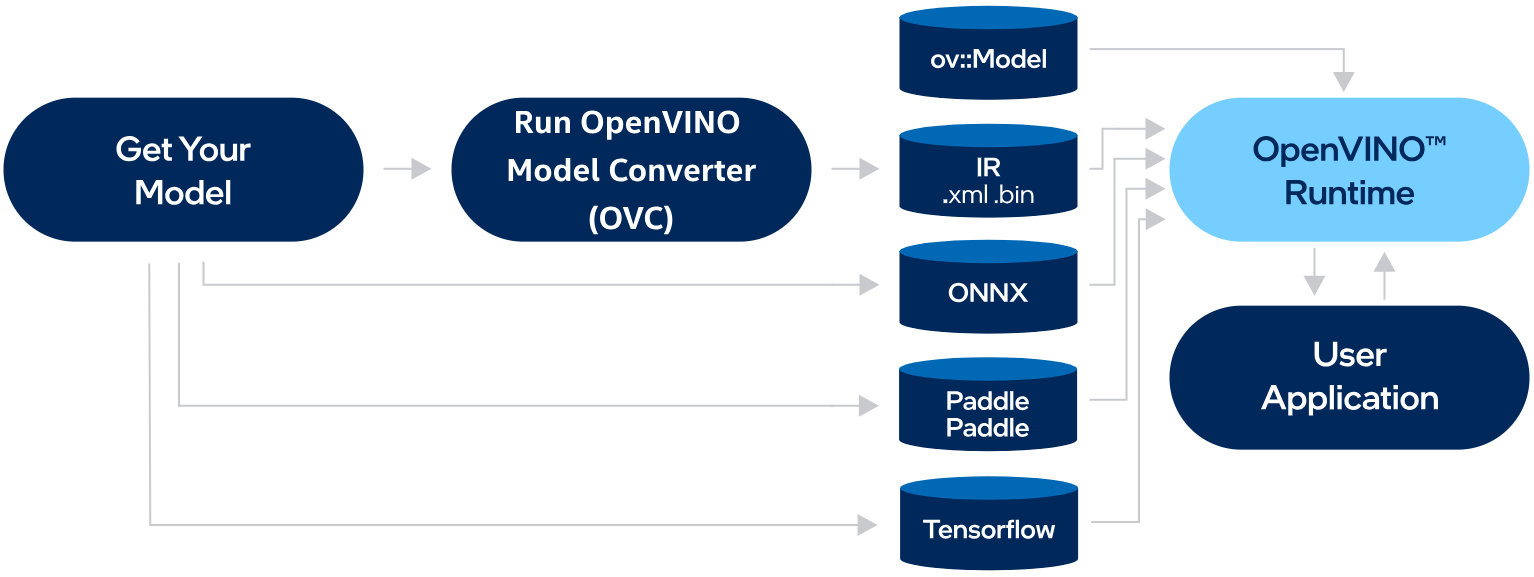

談到在英特爾運算平臺開發AI推論加速應用程式,2018年登場的OpenVINO toolkit,經過長期的發展,這套全名為Open Visual Inference & Neural Network Optimization的軟體套件,如今已然成為最能廣泛涵蓋該公司AI加速運算環境的開發工具。

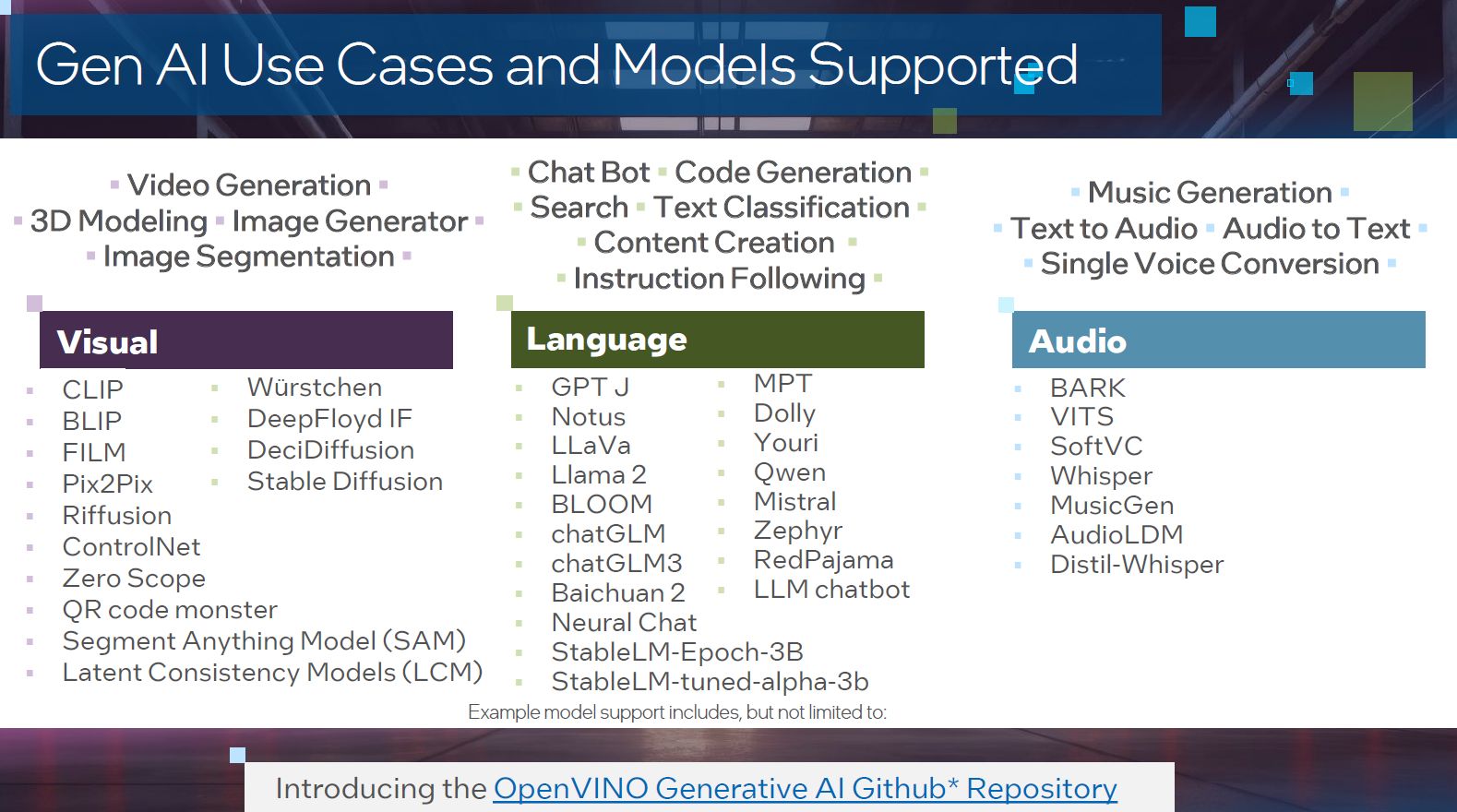

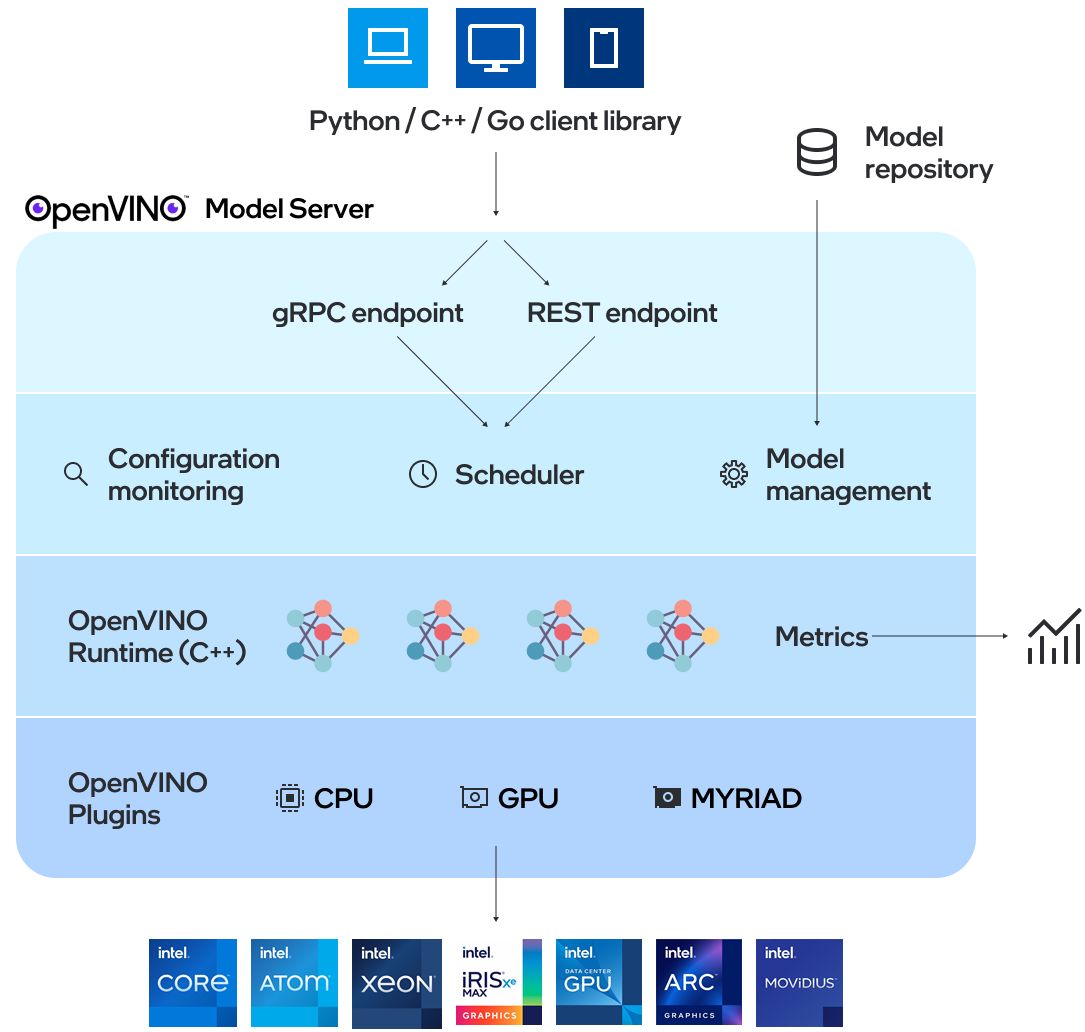

目前OpenVINO toolkit可同時支援CPU、GPU、GPU,因應深度學習應用的多種領域,像是電腦視覺、大型語言模型、生成式AI,

7月底英特爾釋出OpenVINO toolkit的最新版2024.3,以今年而言,先前發布2024.0、2024.1、2024.2、而在8月底對臺灣媒體舉行的英特爾商用AI PC平台與應用說明會,他們也特別對此進行介紹。

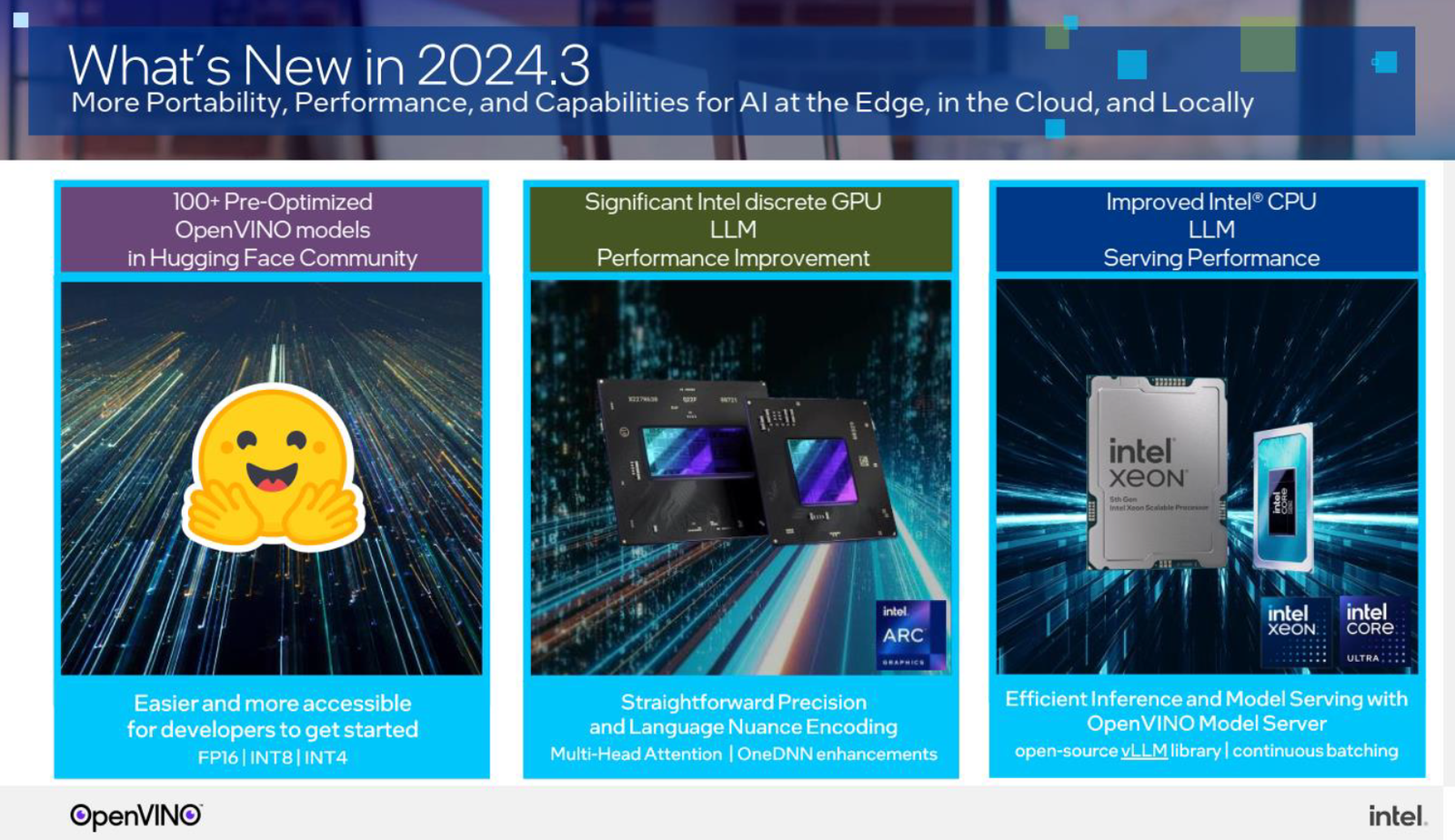

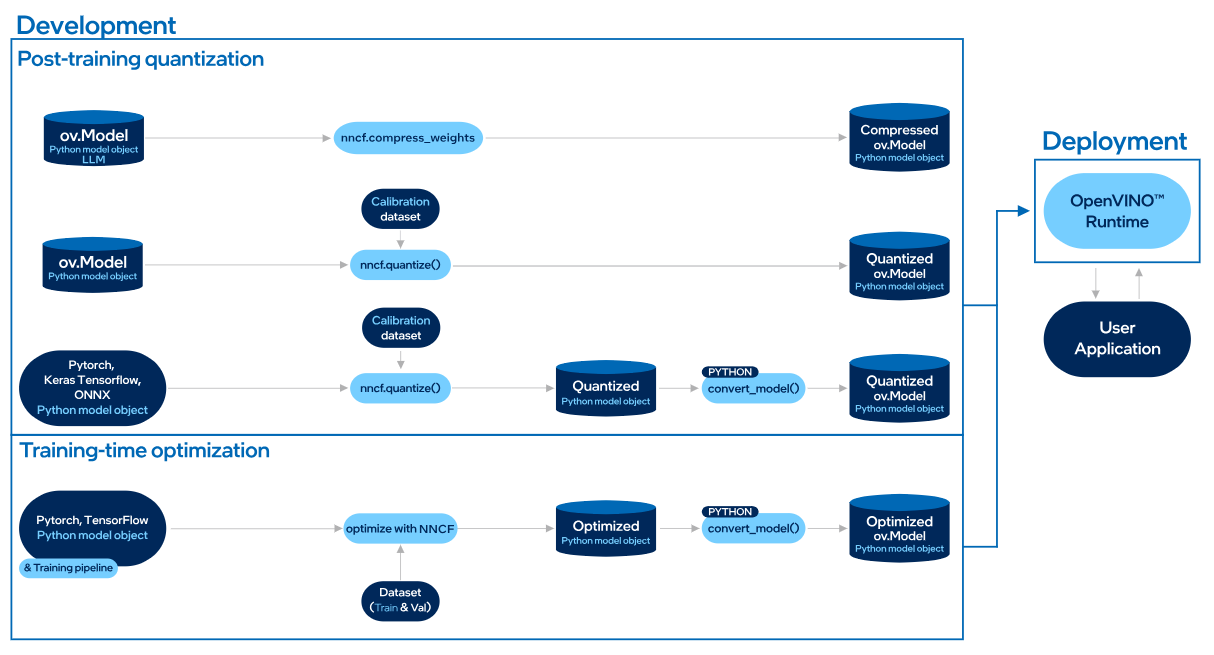

這一版OpenVINO改良大型語言模型的處理效能,並擴展AI模型涵蓋的範圍,也針對網路邊緣、雲端服務、本機的部署,強化可移植至這些環境執行的能力與處理效能。

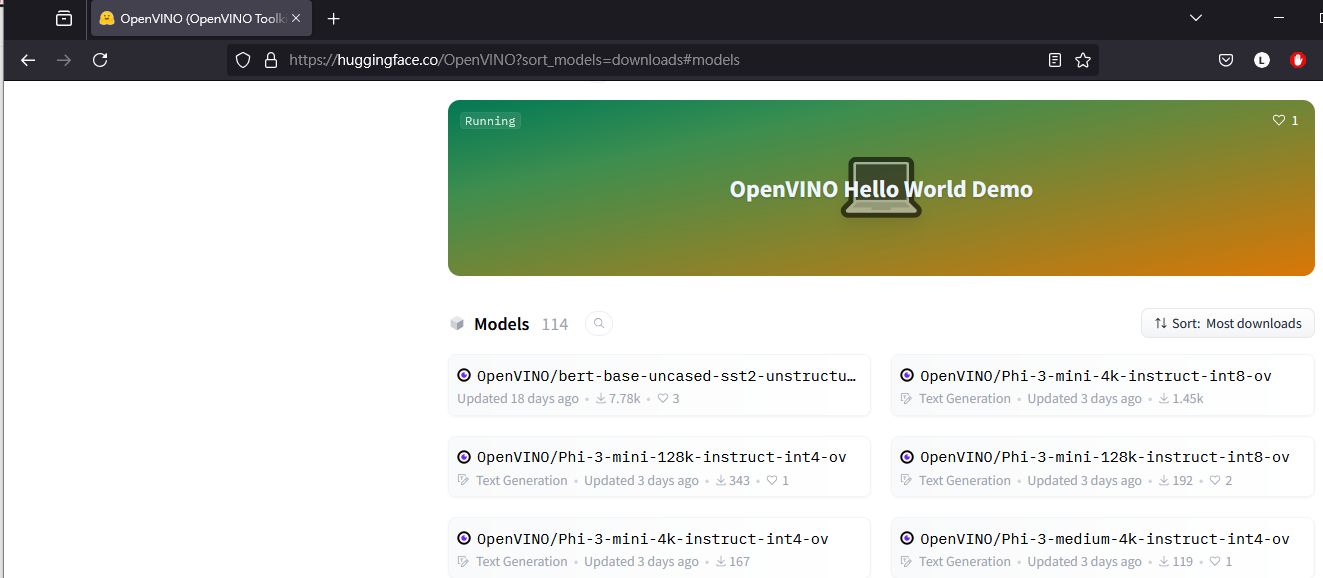

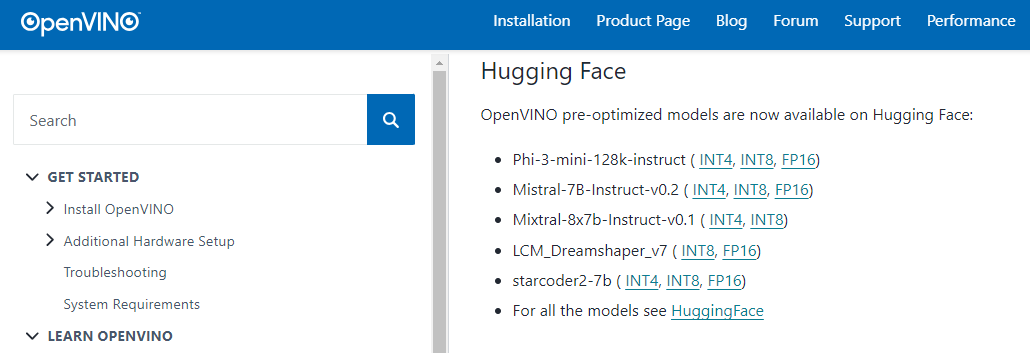

以AI模型而言,OpenVINO提供的預先調校模型,已經在全球最大的AI開發資源共享社群平臺Hugging Face上架,開發者能夠更容易著手使用,目前可在此存取與執行多達114種模型,像是Phi-3、Mistral、 Mixtral、LCM Dreamshaper、StarCoder2。

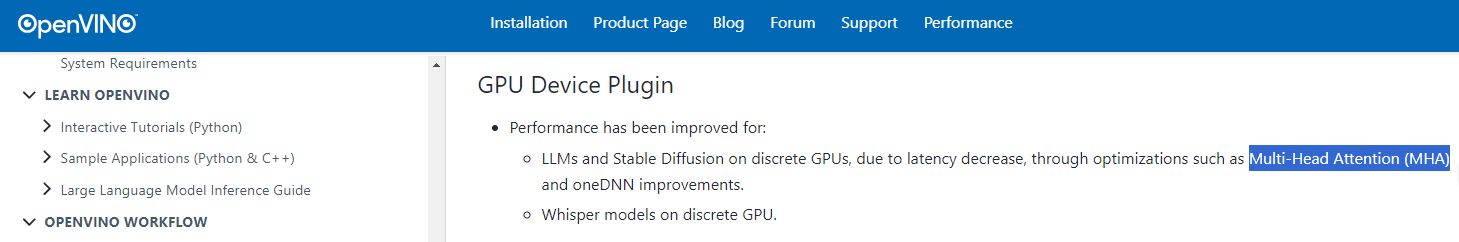

關於處理最佳化,OpenVINO目前已針對Intel獨立GPU加速卡或加速晶片,顯著改善大型語言模型與其他模型的執行效能,因為當中增加多重注意力(Multi-Head Attention,MHA)的機制。在此同時,英特爾也加強Intel oneAPI Deep Neural Network Library的運作性能。

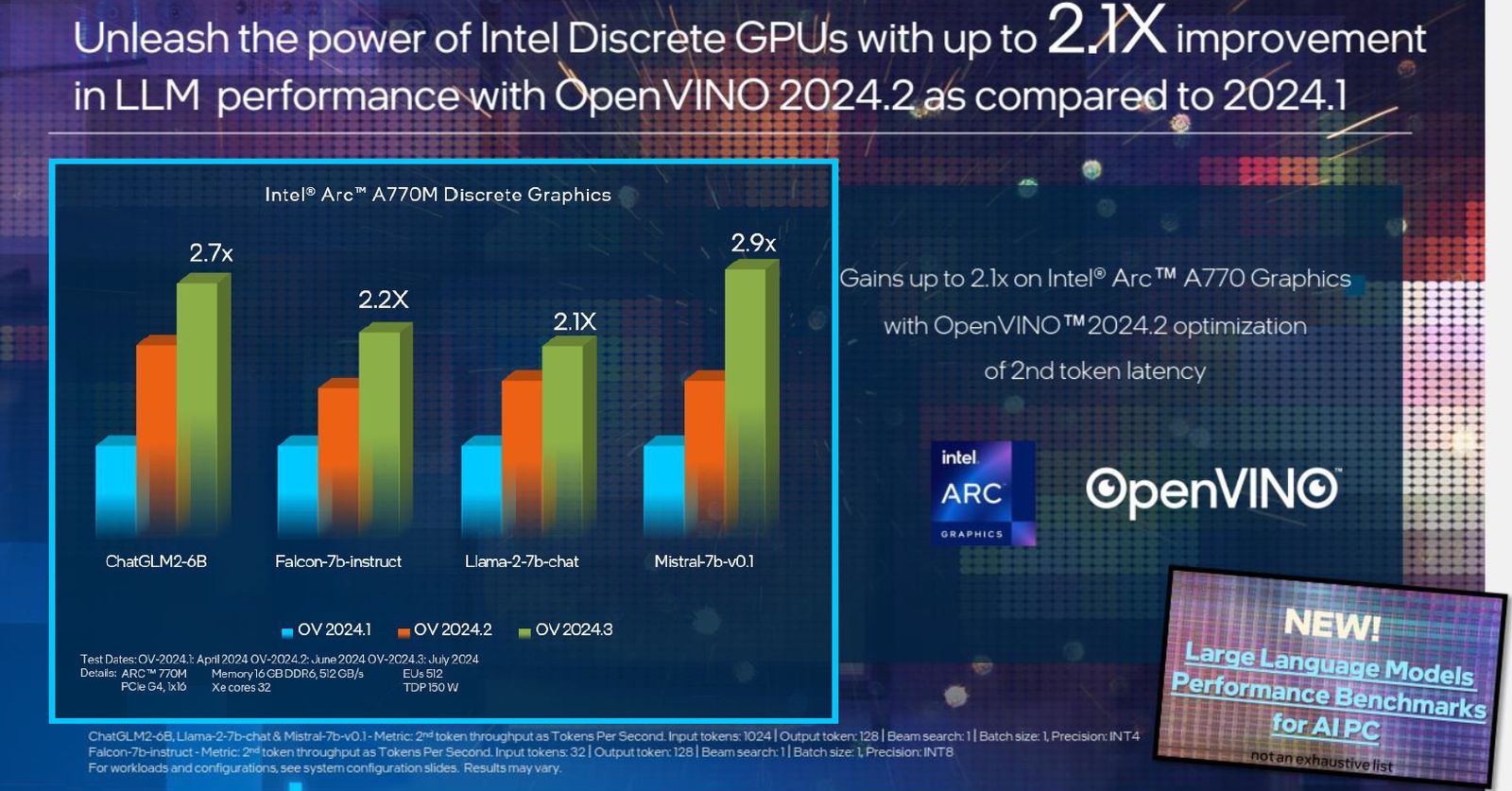

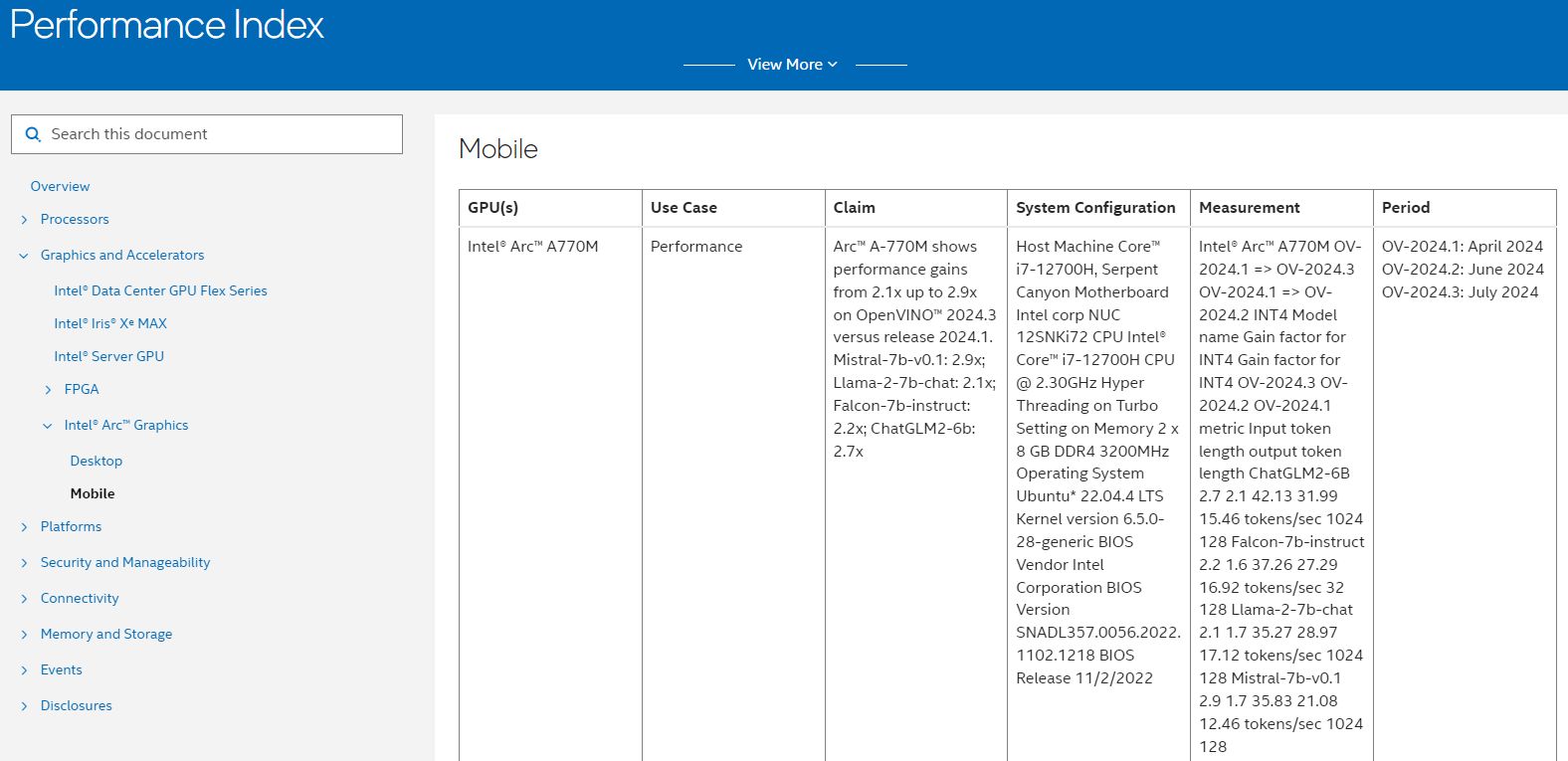

根據英特爾的內部測試結果指出,若在同樣搭配Intel Arc獨立GPU的系統,以OpenVINO今年釋出的第二個版本2024.1為基準,新出爐的2024.3版搭配多種生成式AI模型使用時,第1個詞元處理延遲改善幅度介於1.9至6.8倍之間,第2個詞元的吞吐量效能可增長2至2.9倍,而這些改良主要源於MHA與OneDNN的強化。

至於搭配其他AI模型,如Stable Diffusion、Whisper,OpenVINO 2024.3效能也提升至1.1至1.6倍,可縮短影片生成所需的時間。

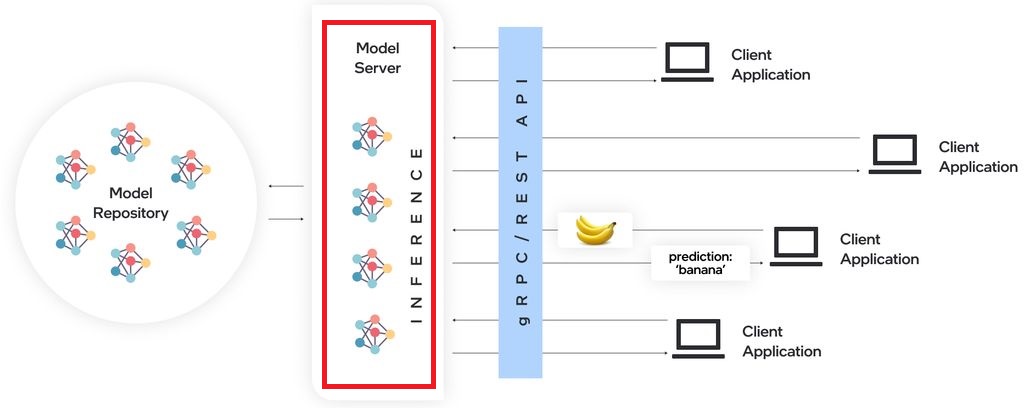

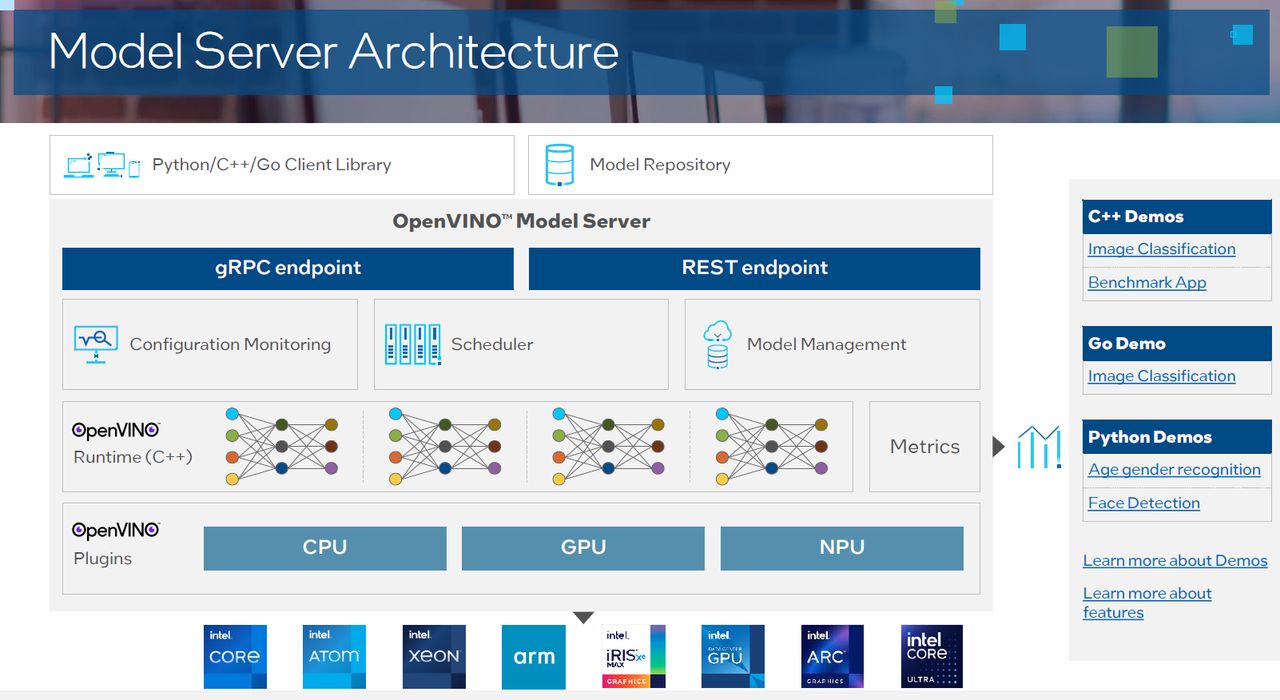

第三個英特爾強調的特點與部署層面有關,OpenVINO 2024.3針對以CPU處理大型語言模型的作業,由於OpenVINO Model Server(OVMS)內建開放原始碼的AI推論程式庫vLLM,可簡化模型推理的過程,以及提供模型的連續批次處理,而能提升CPU進行這類工作的效率。

產品資訊

OpenVINO toolkit 2024.3

●原廠:英特爾

●建議售價:免費

●支援作業系統:Windows 10與11、Linux(RHEL8,Ubuntu 20.04、22.04、24.04)、macOS 12.6

●套件安裝方式:壓縮檔、PyPI、APT、YUM、ZYPPER、Conda Forge、vcpkg、Homebrew、Conan、Docker、NPM

●軟體開發元件需求:Python 3.8至3.11、CMake 3.13、GCC 7.5,Visual Studio 2019(Windows環境)、Xcode 10.3(macOS環境)

●支援硬體:

CPU:x86伺服器(1到5代Xeon Scalable、Xeon 6)、x86嵌入式系統(Atom X、Atom支援SSE 4.2),x86個人電腦(6到14代Core、Core Ultra、Pentium N4200/N3350/N3450),Arm(v7-A、Arm64-v8a、Apple silicon)

GPU:Intel Graphics(HD、UHD、Iris Pro、Iris Xe、Iris Xe Max)、Intel Arc GPU、Intel Data Center GPU Flex系列、Intel Data Center GPU Max系列

NPU:Intel NPU(Core Ultra內建)

【註:規格與價格由廠商提供,因時有異動,正確資訊請洽廠商】

熱門新聞

2026-02-06

2026-02-06

2026-02-06

2026-02-06

2026-02-09

2026-02-09