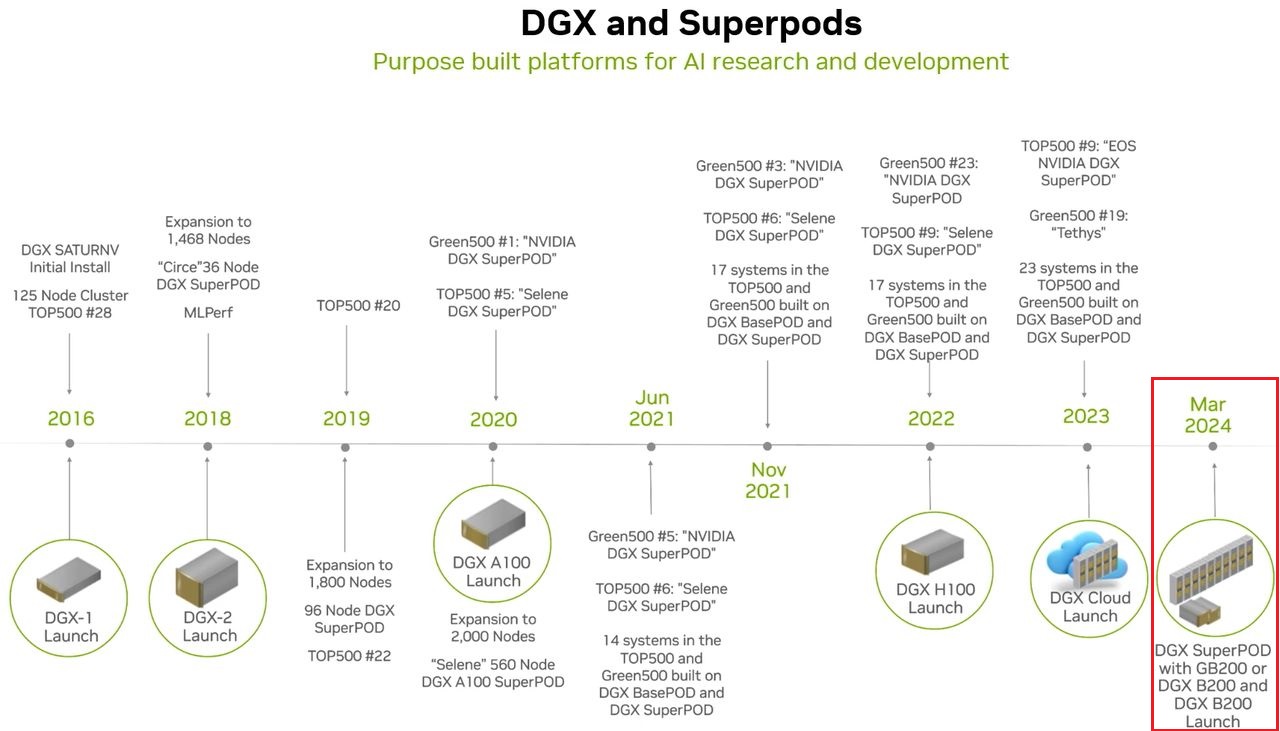

今年3月GTC大會期間,Nvidia發表新一代GPU架構Blackwell,也預告將推出B200 GPU與GB200 Grace Blackwell Superchip,搭載這些加速運算晶片的伺服器平臺HGX B200、GB200 NVL72、AI整合應用設備系統DGX B200、DGX GB200,以及基於DGX B200或DGX GB200而成的整櫃型系統DGX SuperPOD。

在這些產品當中,Nvidia率先在當時公布細部組態規格的是DGX B200,而在時隔7個月的此刻,執行長黃仁勳幾週前接受美國CNBC電視臺專訪時表示,Blackwell已全面投入生產,幾天後Nvidia將首批出爐的工程版DGX B200,送至近幾年引領全球生成式AI應用風潮的OpenAI公司辦公室,

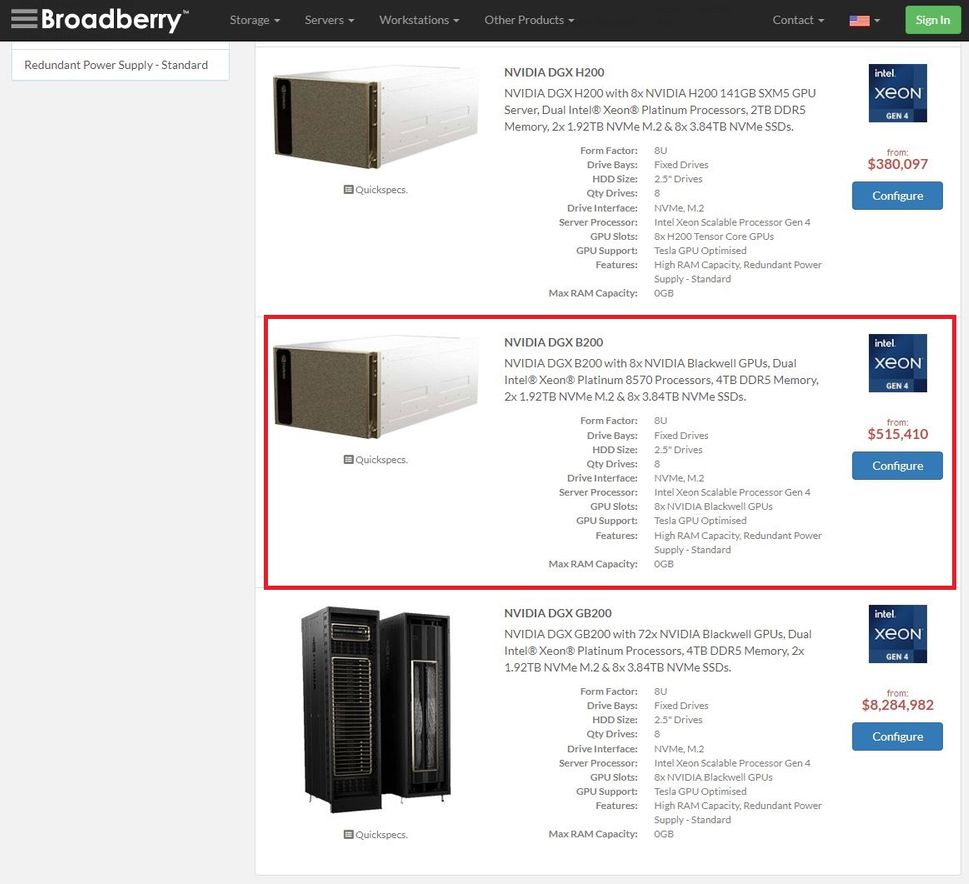

而在10月12日,根據科技媒體WccfTech的報導,他們發現伺服器與儲存設備供應商Broadberry Data Systems在網站列出DGX B200,並公布起價為515,410.43美元(換算新台幣為1,660萬元)。從這些跡象來看,意味著DGX B200越來越接近正式上市的時刻。

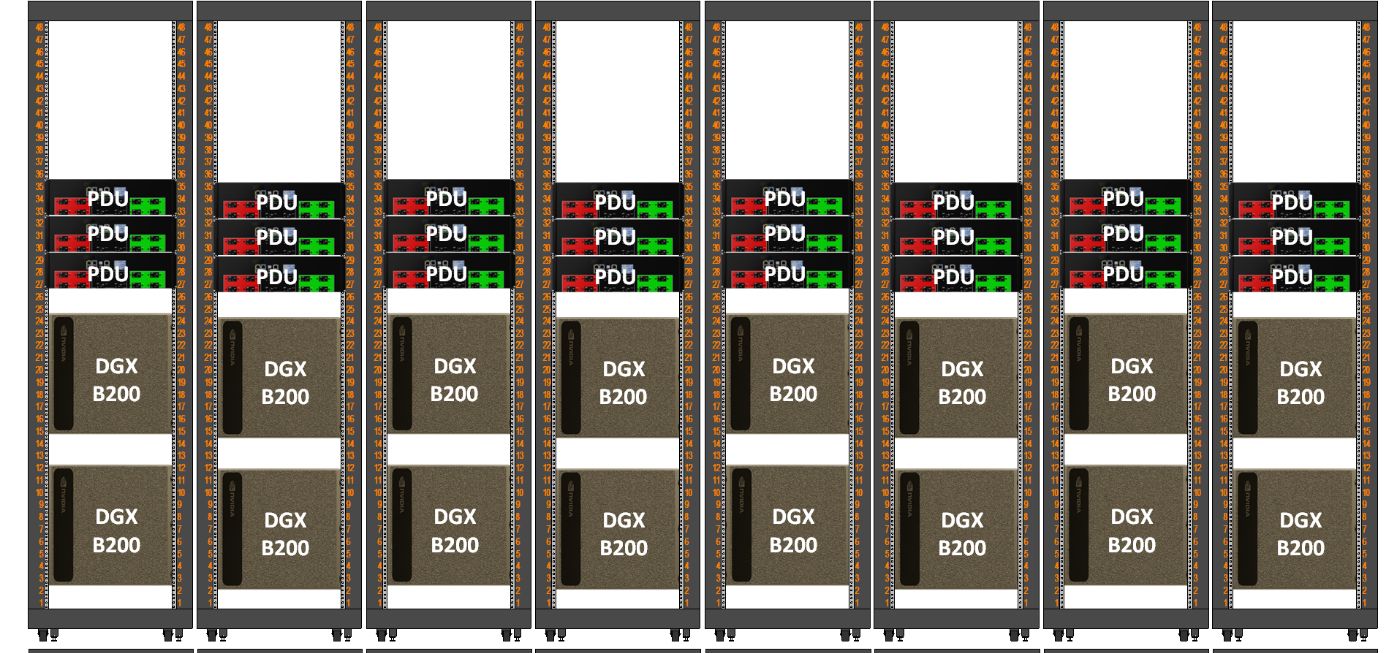

回顧3月Nvidia發布的新聞稿與產品規格,當中初步揭露DGX B200的主要特色,例如,可針對AI模型的訓練、微調、推論,提供統一的AI超級運算平臺;搭配8個Nvidia Blackwell架構的GPU,以及2個英特爾第五代Xeon Scalable處理器;機箱採用第六代氣冷、傳統機架式外形設計,能廣泛運用在全球各種產業;用戶能以此組建DGX SuperPOD,並且成立卓越AI中心,可支撐大型開發團隊的工作需求,執行各式各樣的職務。

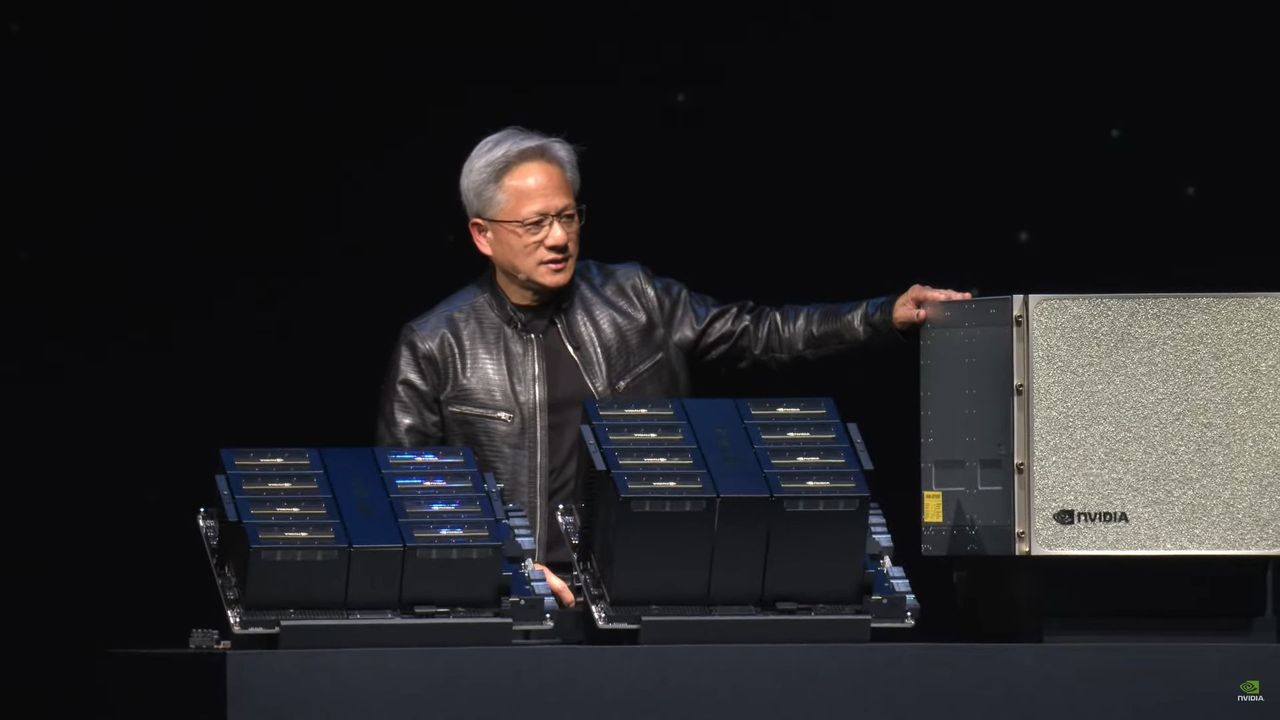

6月初在2024台北國際電腦展的前夕,黃仁勳介紹Nvidia目前與未來多種軟硬體技術之餘,也向全世界展示DGX B200,以及預載8個GPU的基板HGX B200、HGX B100。

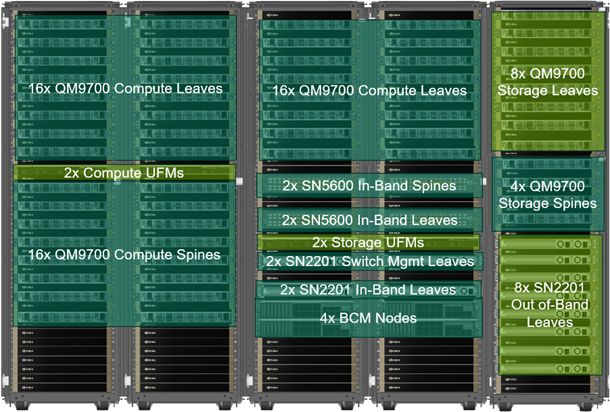

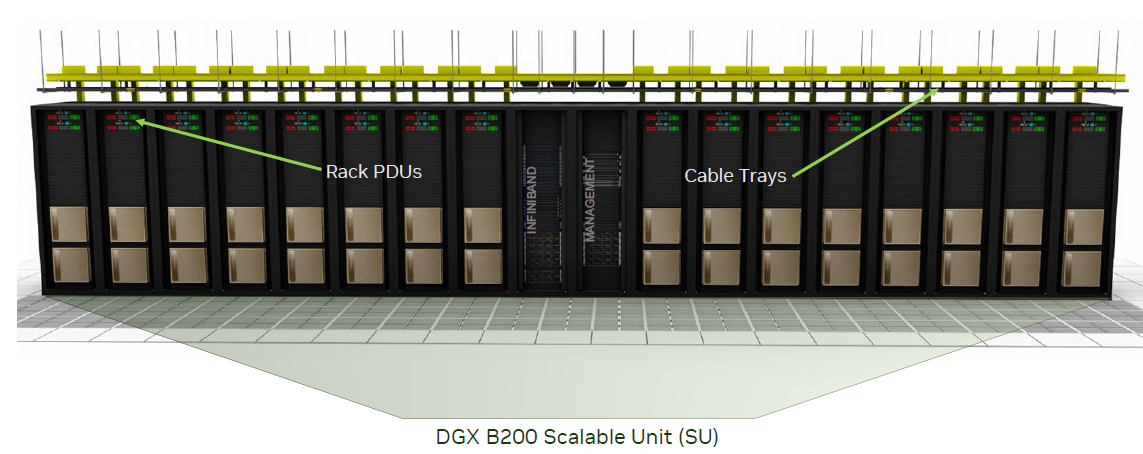

在這些即將問世的產品當中,DGX B200最先上市的機率應該是最高,因為目前Nvidia不僅在網站公布技術規格,也列出以此組成DGX SuperPod參考架構的技術文件。

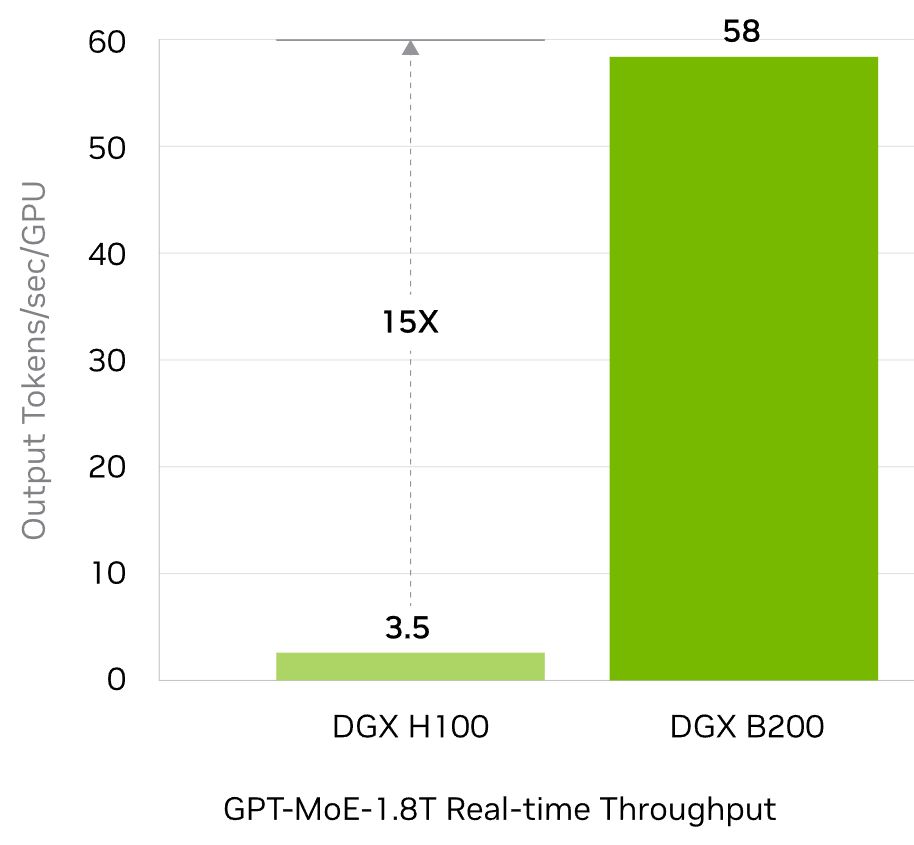

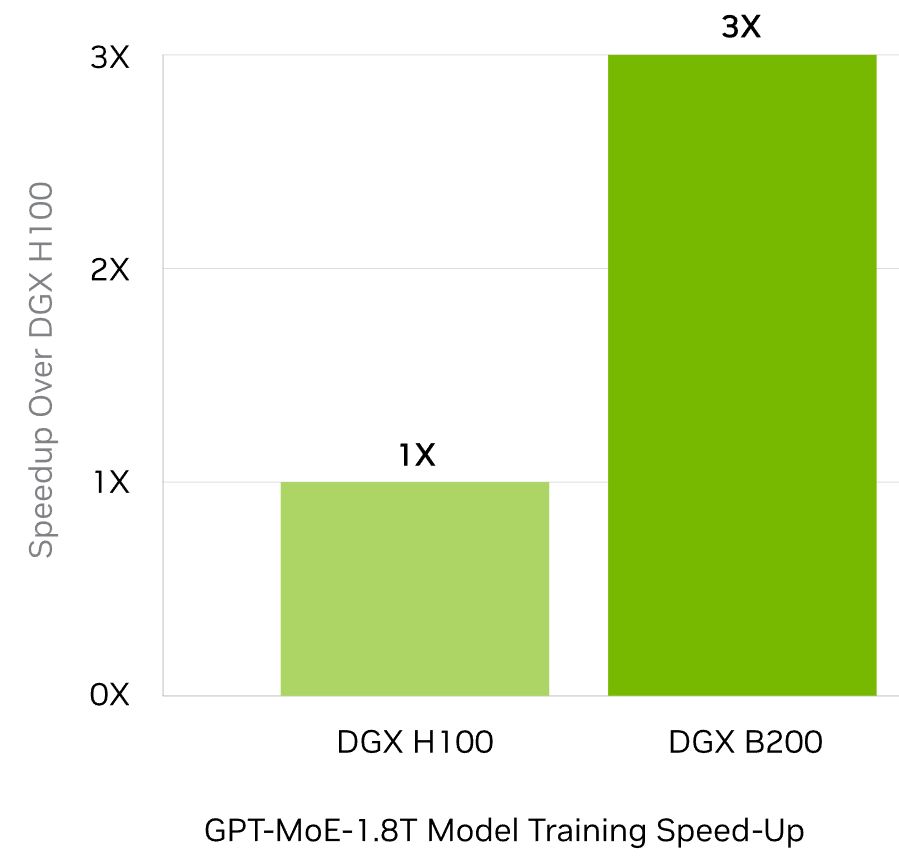

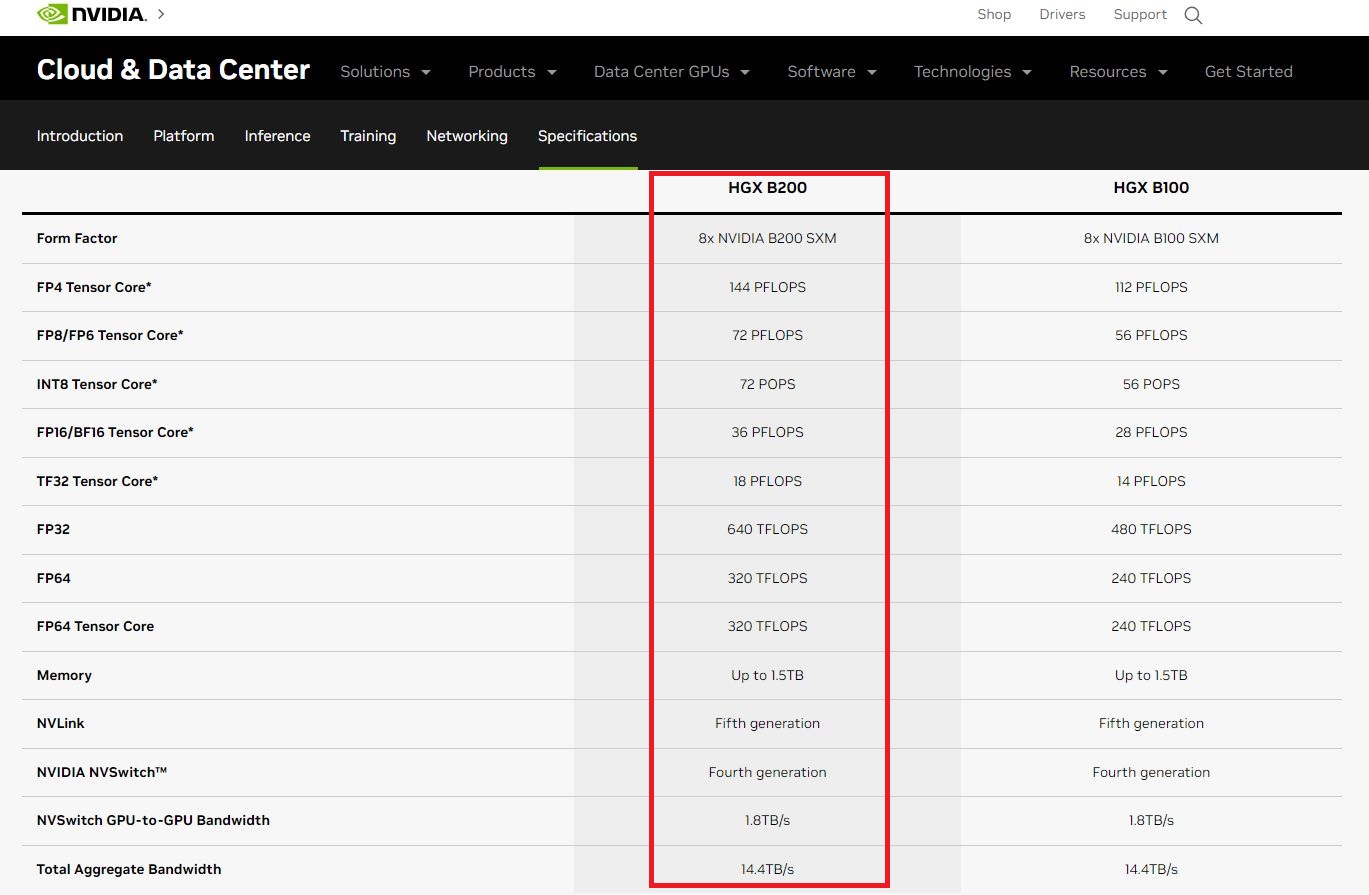

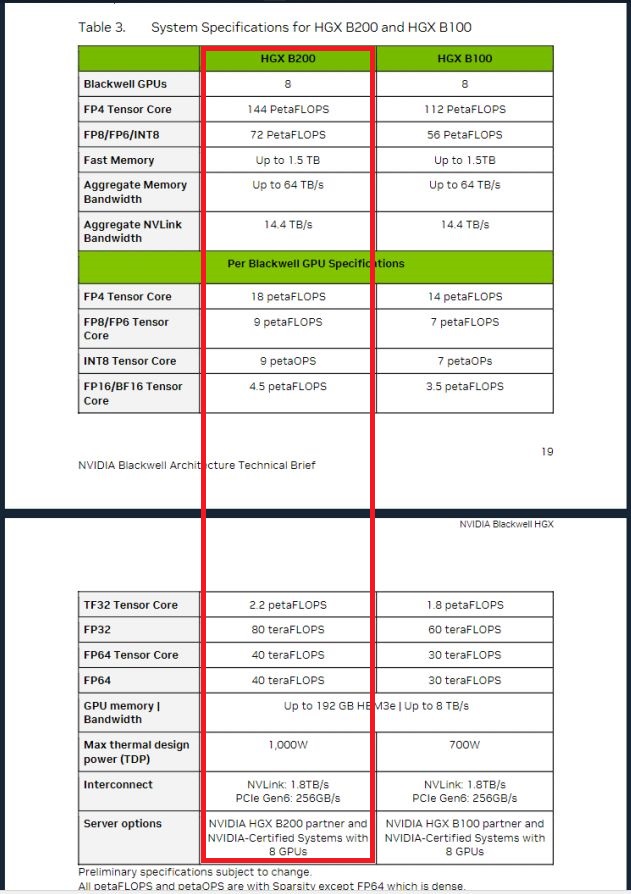

而關於DGX B200的運算能力突破,綜合Nvidia在5月更新的技術規格,若用於FP4精度的AI推論處理,可提供144 Petaflops的效能,以大模型GPT-MoE-1.8T執行即時推論,吞吐量可達到前代產品DGX H100的15倍;若用於FP8精度的AI訓練,可提供72 Petaflops的效能,以大模型GPT-MoE-1.8T執行AI訓練,速度為DGX H100的3倍。

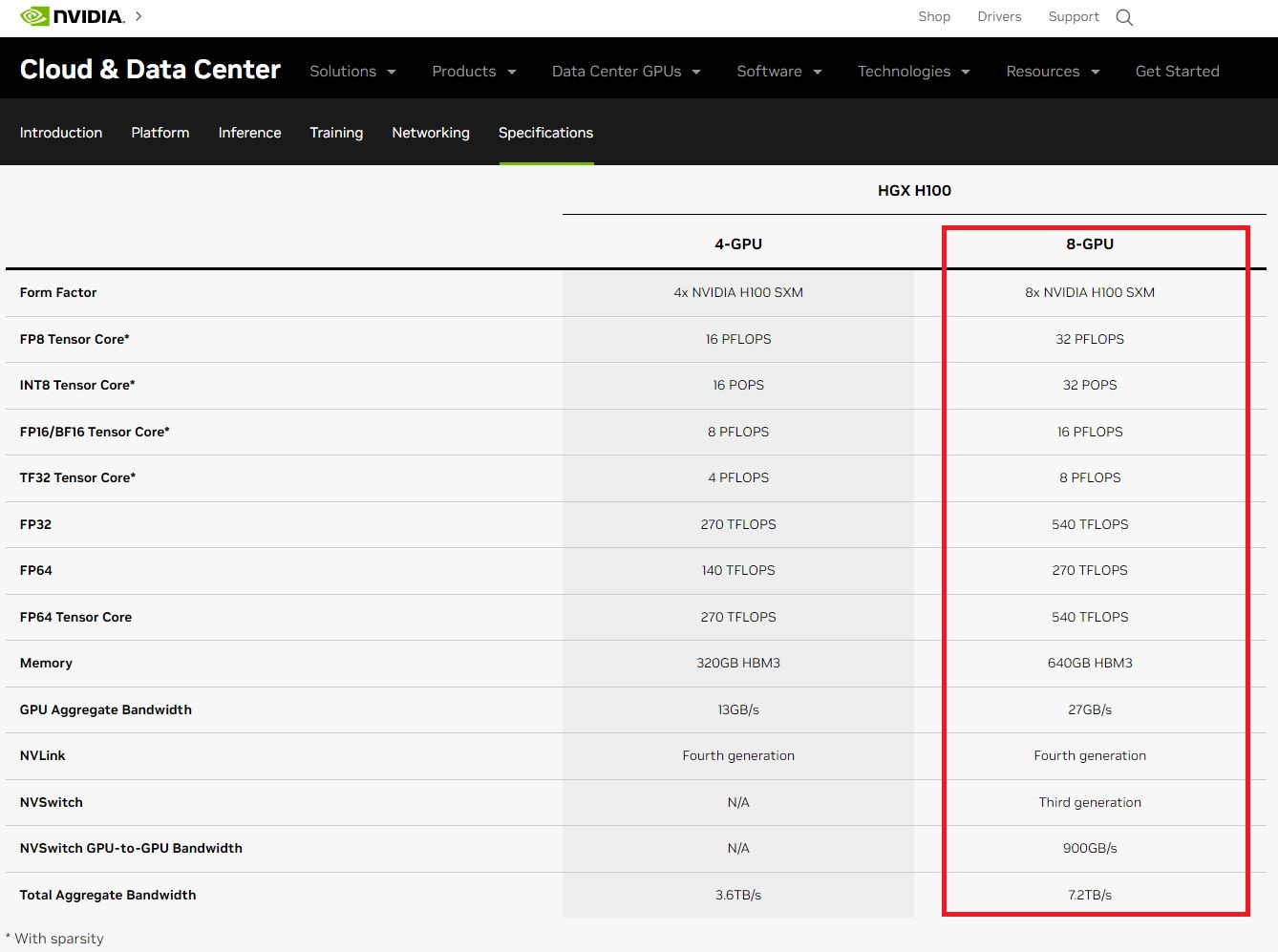

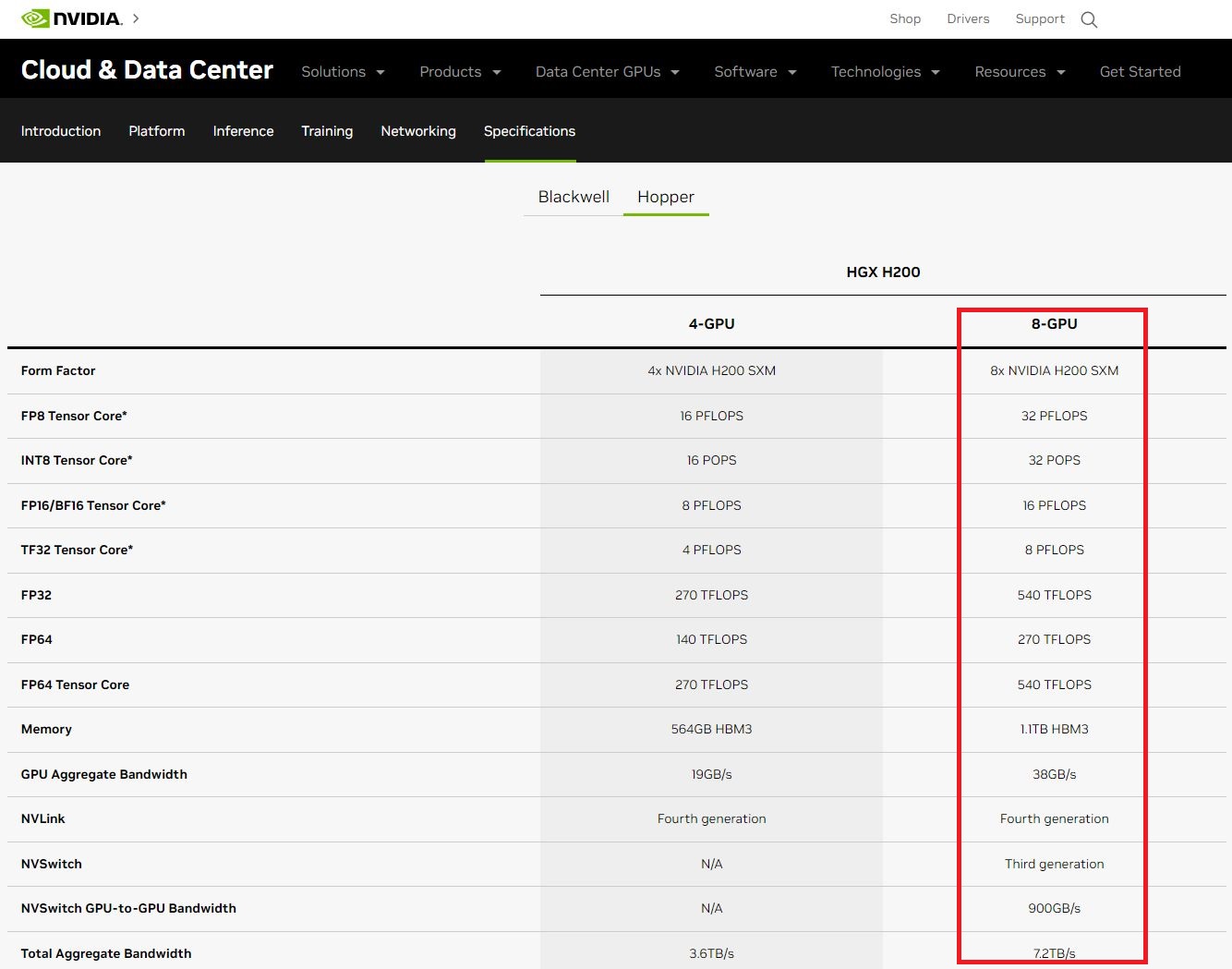

就整臺系統的GPU記憶體總容量而言,DGX B200提供1.4 TB(1,440GB)的HBM3e,GPU記憶體總頻寬為64 TB/s。相較之下,現行的DGX H100,總共提供640 GB的HBM3,GPU記憶體總頻寬為26.8 TB/s,後續推出的DGX H200,提供1,128 GB的HBM3,GPU記憶體總頻寬為38.4 TB/s。

關於I/O介面,DGX B200連接GPU之間的NVLink,屬於Nvidia發展的第五代技術,NVLink總頻寬為14.4 TB/s,同時,DGX B200也配備兩個第四代NVSwitch晶片;至於DGX H100與DGX H200連接GPU之間的NVLink,屬於第四代技術,NVLink總頻寬為7.2 TB/s,而且,這兩臺伺服器都配置4個第三代NVSwitch晶片。

在對外連接的網路介面,DGX B200內建ConnectX-7網路卡與BlueField-3資料處理器,可支援400Gb/s乙太網路或InfiniBand網路技術的使用,並分別搭配該公司的Spectrum-X,或Quantum-2、Quantum-X800網路平臺。

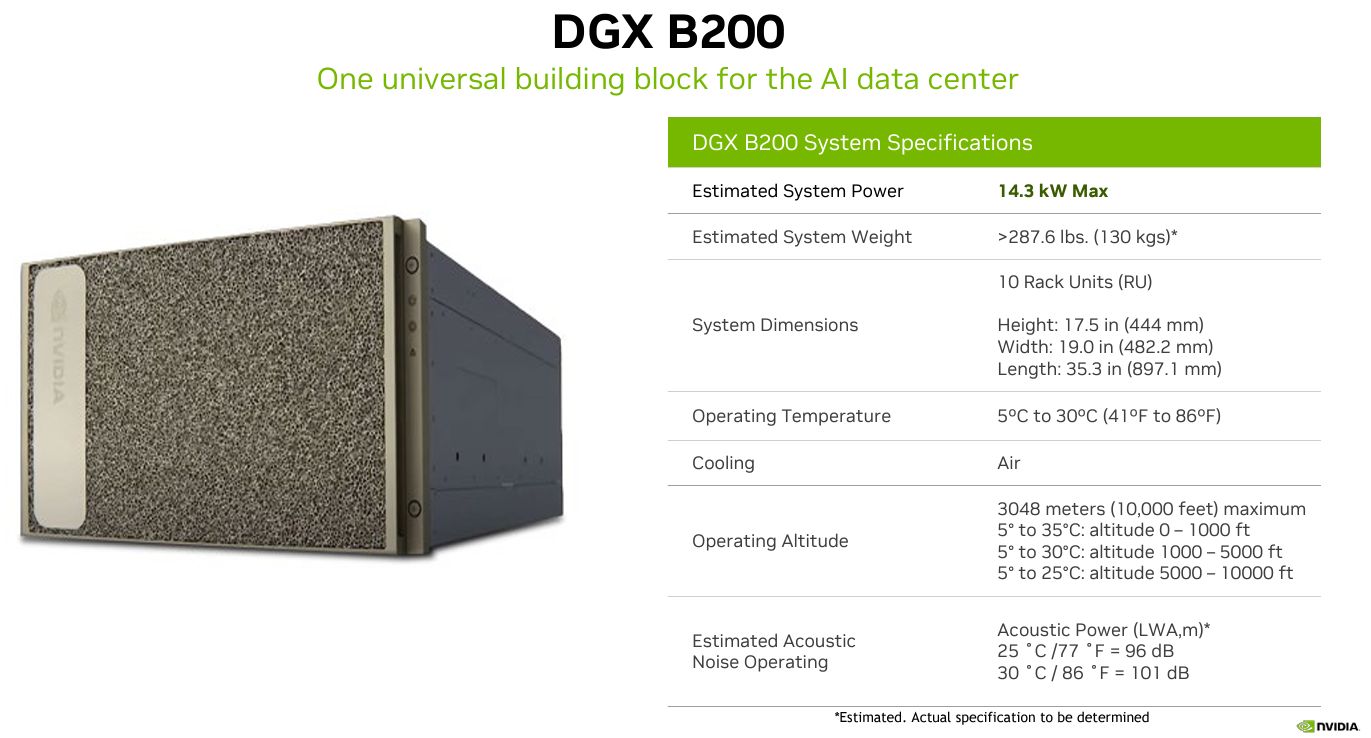

值得注意的是,導入Blackwell架構GPU,雖然帶來強勁的運算效能,但熱設計功耗(TDP)也隨之增加,根據Nvidia公布的Blackwell架構白皮書,與DGX B200同樣採用8顆GPU配置的HGX B200,TDP為1,000瓦,而從整臺伺服器系統的角度來看,DGX B200的最大耗電量為14.3千瓦,既有的DGX H100與DGX H200均為10.2千瓦。或許是因為需要具備更大散熱能力的關係,DGX B200的機箱外形為10U高度,目前的DGX H100與DGX H200採用8U機箱。

產品資訊

Nvidia DGX B200

●原廠:Nvidia

●建議售價:廠商未提供

●機箱尺寸:10U

●處理器:2顆56核心Intel Xeon Platinum 8570(第五代Xeon Scalable)

●記憶體:2 TB,可設置4 TB

●儲存:8臺2.5吋U.2 3.84 TB NVMe SSD(RAID 0),搭配2臺M.2 1.92 TB NVMe SSD

●GPU加速模組:8個Nvidia B200(HBM3e記憶體總容量1440 GB)

●網路介面:400Gb/s InfiniBand或Ethernet;4個OSFP埠,可連接2張ConnectX-7網卡;2張雙埠QSFP112規格BlueField-3 DPU;1個雙埠100GbE網卡

●軟體:Nvidia AI Enterprise軟體套件、Nvidia Base Command雲端管理平臺、Linux作業系統(DGX OS 或Ubuntu)

●最大耗電量:14,300瓦

【註:規格與價格由廠商提供,因時有異動,正確資訊請洽廠商】

熱門新聞

2026-02-06

2026-02-06

2026-02-09

2026-02-09

2026-02-06

2026-02-06

2026-02-09