AWS

所謂的GPU直連儲存傳輸,是指在儲存裝置與GPU之間,建立直接記憶體存取(Direct Memory Access,DMA),使儲存裝置直接將資料載入GPU記憶體,透過這種方式,可讓資料傳輸路徑,繞開主機CPU記憶體回彈緩衝區(Bounce Buffer)的中介,免除不必要的資料複製作業,並避開因主機CPU導致的效能瓶頸,不僅減少存取延遲,也有助於減輕主機CPU負荷。

Nvidia於2019年中發表的GPUDirect Storage(GDS)技術架構,是當前GPU直連儲存傳輸技術的開創者與領導者,憑藉Nvidia在GPU領域的壟斷性地位,自2021年起,已陸續獲得多家廠商與產品平臺支援,在不久前的2024年底,又有數家廠商加入。

Nvidia GDS支援生態系的新擴張

蔚為市場主流的GDS架構,先後獲得十多家儲存廠商的支援,例如,2021年有DDN、Dell、Hitachi Vantara、HPE、IBM、VAST與Weka,以及ScaleFlux;2022年有NetApp、Kioxia,2023年有華為、美光、PEAK:AIO。在2024年,又有Hammerspace、WD與Pure Storage。

在我們上次介紹GDS時(去年10月),支援GDS的儲存廠商生態系大致就是這些,基本涵蓋所有一線儲存大廠,以及重要的新創廠商。自那時到現在的短短3個月之內,又接連有AWS、Quantum等廠商宣布支援GDS架構,Nutanix也再次預告將支援這項架構,等於更進一步擴展了GDS的應用生態系。

AWS的FSx for Lustrez服務

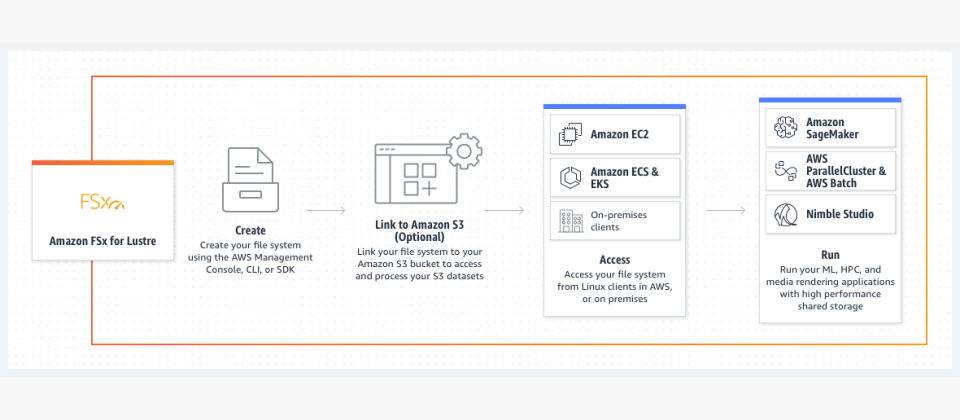

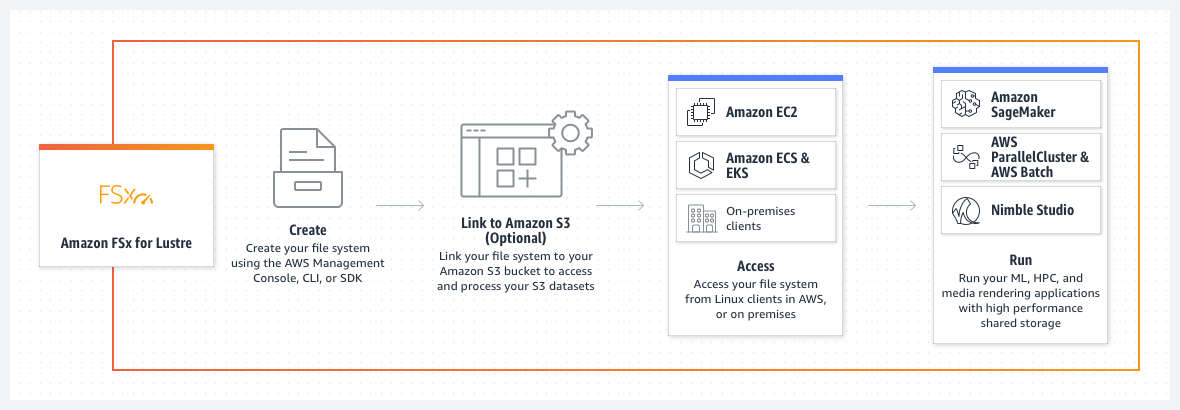

AWS是在2024年11月底時宣布,為其Amazon FSx for Lustre檔案儲存服務,新增對於EFA網路卡(Elastic Fabric Adapter),以及GDS傳輸架構的支援。

Amazon FSx for Lustre是AWS基於Lustre平行檔案系統,所提供的高效能、高擴展性SaaS檔案儲存服務,無論IOPS或傳輸效能,都是AWS旗下一系列SaaS檔案儲存服務中最高的。而透過引進EFA網路卡與GDS傳輸架構,AWS宣稱,比起先前的FSx for Lustre服務,可為每臺用戶端執行個體提供高出12倍的資料傳輸吞吐率。

EFA是專門搭配AWS EC2執行個體的網路介面,透過運行AWS專屬的可擴展可靠資料封包(Scalable Reliable Datagram,SRD)協定,在EC2執行個體間建立網路連線,並能繞過作業系統執行資料傳輸作業,達到減少延遲、提高傳輸速率的目的。

而FSx for Lustre對於GDS的支援,則是透過EFA網路介面來構建,可促使FSx for Lustre檔案系統與EC2 GPU型執行個體之間的資料傳輸,繞過CPU的中介,從而減少延遲,提高傳輸效率。

目前AWS是在FSx for Lustre最新的持久性2型(Persistent 2)服務上,提供EFA與GDS支援,且用戶無須額外付費,就能啟用這2項功能。

AWS FSx for Lustre新增支援GDS直連傳輸

AWS已在FSx for Lustre儲存服務最新的持久性2(Persistent 2)類型,提供EFA網路介面與GDS直連傳輸架構的支援,比起上一代服務,傳輸吞吐率可提升12倍。上圖為FSx for Lustre基本應用架構,透過支援EFA網路介面,可在儲存區與EC2執行個體之間進行高效率網路傳輸,並與EC2 GPU執行個體建立GDS直連傳輸。圖片來源/AWS

Quantum的Myriad平臺

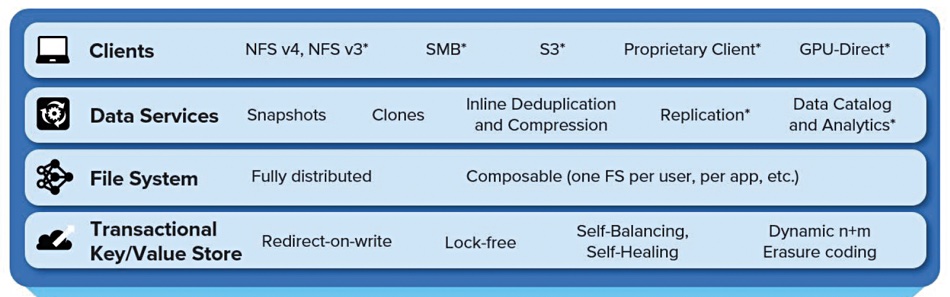

Quamtum在不久前的2024年12月中旬,宣布旗下的Myriad分散式物件與檔案儲存平臺,已能支援Nvidia GDS傳輸架構。

Myriad是Quantum在原有的ActiveScale物件與檔案儲存平臺之外,於2023年4發表的新一代高效能型分散式儲存系統,相較於ActiveScale這種重視擴展性,但效能表現較為欠缺的上一代平臺,全新開發的Myriad則能兼顧擴展性與高效能。

Myriad的特點,包括:可原生支援S3、NFS、SMB等物件與檔案存取服務,基於容器化、Key/Value架構,採用NVMe SSD全快閃儲存組態,叢集規模從5臺儲存節點起跳,可擴充到上千節點,而且部署時是採用標準x86伺服器硬體與SSD,沒有特殊硬體需求。

早在2023年初發表Myraid時,Quantum便已預告將會支援GDS架構,時隔一年半之後,Quantum終於透過新開發的平行檔案系統用戶端(Parallel File System Client)軟體,實現這個目標,藉此可讓Myriad儲存叢集以GDS架構連結GPU伺服器。

目前Quamtum預定從2025年第1季起,開放現有Myraid用戶透過搶先體驗計畫(Early Access Program)申請,以便進行平行檔案系統用戶端軟體的評估及試用,然後在2025年第2季正式發布。

Quantum Myriad提供GDS直連儲存

Quantum在2023年初發表Myriad儲存平臺時,便已預告將會支援Nvidia GDS傳輸架構,但直到2024年底,才藉由新發布的平行檔案系統用戶端軟體,兌現這項功能。上圖為Myriad發表時提出的功能框架,可見到Nvidia GPUDirect已被列入用戶端存取支援架構之一。圖片來源/Quantum

Nutanix的NUS平臺

Nutanix其實早在2024年7月,該公司執行長Rajiv Ramaswami便曾預告,對Nvidia GPUDirect架構的支援,已列入他們的發展路線圖,但並未提供進一步訊息。直到11月底,Nutanix資深副總裁兼總經理Vishal Sinha才於新發表的技術白皮書《Scaling Storage Solutions for Foundation Model Training》,正式確認Nutanix的NUS儲存平臺(Nutanix Unified Storage)對GDS的支援,以及採用的架構。

NUS是Nutanix以其AOS儲存系統為基礎,延伸而成的儲存解決方案,AOS原本是搭配Hypervisor應用的分散式儲存系統,與Hypervisor整合為超融合部署架構。NUS則可視為AOS的「獨立儲存產品化」版本,既可採用超融合架構部署,也能獨立部署、或是雲端部署,繼承了AOS的高擴展性,以及橫跨區塊、檔案與物件儲存服務的多協定服務能力。

Nutanix資深副總裁兼總經理Vishal Sinha在白皮書中表示,NUS將透過整合Nvidia GDS與NFSoRDMA協定來增強效能,藉由在儲存裝置與GPU記憶體之間直接傳輸資料、繞過CPU,減少存取延遲與CPU負載,從而加速AI與機器學習工作負載。

NFSoRDMA即NFS over RDMA協定,也就是在RDMA乙太網路執行的NFS檔案傳輸協定,是GDS常用的兩種底層傳輸架構之一(另一是InfiniBand)。

但Nutanix迄今仍未發布NUS開始支援GDS的具體時間,我們推測可能會在2025年上半年。

物件層級GPU直連傳輸架構問世

雖然GDS架構能達到減少GPU與儲存裝置間的存取延遲、提高傳輸效率的效率,但應用上也存在一項限制:只適用於檔案層級的資料傳輸。

GDS可以支援區塊儲存系統,以及網路附加裝置(NAS)等兩種類型儲存裝置,但存取都是在檔案層級上進行。

在區塊儲存裝置方面,無論GPU伺服器本機的NVMe SSD,或透過NVMe-oF掛載的外部區塊儲存區(Volume),都需格式化為EXT4或XFS檔案系統的形式,再掛載給GPU伺服器使用。

而在網路附加儲存裝置方面,支援GDS的外部掛載檔案系統,是透過修改的NFS協定(NFS over RDMA)或OFED網路介面,掛載給GPU伺服器使用。

而這也意味著:基於物件層級存取的物件儲存設備,無法獲得GDS架構帶來的傳輸加速效益,進而難以在以Nvidia GPU為核心的AI應用市場,與支援GDS的產品競爭。

所以,目前市面上一些物件儲存平臺產品,是透過兼容於物件儲存與檔案儲存的雙重服務能力,以檔案傳輸協定來支援GDS,例如:我們在前面曾介紹的Quantum Myriad,另外還有Pure Storage FlashBlade,以及Weka、VAST Date的平臺等。

但MinIO與Cloudian這兩家物件儲存廠商另闢蹊徑,自行發展了物件層級的GPU直連儲存傳輸架構,從而讓物件儲存設備也能獲得GPU直連傳輸的效益。

MinIO的S3 over RDMA架構

近來聲勢頗旺的新興物件儲存廠商MinIO,以其物件儲存平臺Object Store為基礎,在2024年11月推出專門對應AI與機器學習應用的版本AIStor,引進了一系列幫助提高AI應用效率的新功能,其中最吸引我們注意的,便是新增對S3 over RDMA協定的支援。

顧名思義,S3 over RDMA是基於S3物件儲存協定的RDMA直連存取架構,MinIO宣稱,用戶可以利用這項傳輸協定,透過400GbE、800GbE或更高速度的乙太網路,存取MinIO儲存伺服器上的S3物件,藉此獲得類似Nvidia GDS架構的效益,包括繞過CPU的RDMA直接存取,無須中介緩衝的零複製資料傳輸,卸載CPU負荷,以及更高效率的流量控制等。

而藉由引進S3 over RDMA,也促使MinIO的物件儲存平臺,具備角逐AI儲存應用的同等條件,能與眾多支援GDS架構的平行或分散式檔案儲存系統抗衡,在同等的條件下競爭。

Cloudian的GPUDirect for Object Storage架構

幾乎與MinIO同時,另一物件儲存廠商Cloudian也在2024年11月,發表自身的物件儲存GPU直連傳輸技術:GPUDirect for Object Storage,與其HyperStore物件儲存平臺搭配運用。

Cloudian宣稱這項直連傳輸架構,是透過Nvidia ConnectX與BlueField DPU技術所建立,可在Nvidia GPU與Cloudian儲存節點之間,建立直連通訊,透過S3協定的指令以RDMA方式存取資料,而不須繞經CPU與系統記憶體。藉此可讓單一Cloudian儲存系統提供超過200GB/s的速度,而且,無須依靠快取,就能讓這種傳輸效能維持長達30分鐘。此外,由於資料傳輸路徑繞過CPU,因此在資料傳輸期間,可降低45%的CPU耗用率。

Cloudian還表示,GPUDirect for Object Storage架構比檔案層級的直連技術(如GDS)更簡單,不需要修改驅動程式核心,因而能簡化管理,也減少安全性風險。

截至目前為主,Cloudian已開始提供內含GPUDirect for Object Storage功能的HyperStore平臺軟體,並與Supermicro的硬體整合為儲存伺服器,以便進行銷售。

邁向全面普及的GPU直連傳輸

MinIO與Cloudian這兩家物件儲存廠商,在2024年底率先發表物件儲存層級GPU直連傳輸技術此舉,將成為GPU直連儲存傳輸技術發展與推廣歷程中的關鍵節點,可望成為其他物件儲存廠商的「帶頭典範」,吸引其他廠商依循類似的方式,加入支援GPU直連傳輸架構的行列。

在當前的3大儲存產品形式中,區塊與檔案類型產品,原本就能透過Nvidia GDS技術來建立GPU直連儲存傳輸(兩者都在檔案層級上運作)。而現在在物件儲存產品領域,終於也出現了類似技術,可以建立GPU直連儲存傳輸,而這樣的突破,也讓儲存設備與GPU之間的存取,正式、全面進入GPU直連傳輸時代。

熱門新聞

2026-02-02

2026-02-03

2026-02-04

2026-02-02

2026-02-04

2026-02-03

2026-02-05