新一代機房與傳統有很大的不同,像是室溫設在攝氏22度以上,就足以應付高發熱量的高密度伺服器,而且連蜂巢地板也捨棄不用了,他們新穎的節能觀念不但幫公司省下大筆的金錢,也率先帶領公司進入了綠色機房時代。

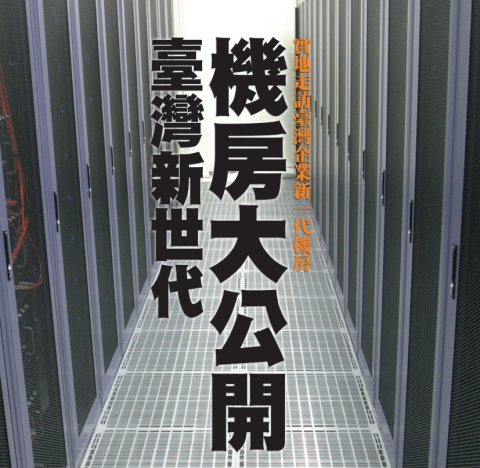

Case 1新世代機房

中華開發工業銀行─因應企業未來成長需求的高彈性機房

中華開發工業銀行在今年3月打造新一代機房,採用水平式空調,而非傳統下吹式空調,並依照機櫃密度佐以不同的散熱措施,以強化機房整體冷卻效率。

Case 2新世代機房

國華人壽─臺灣首座採用熱通道封閉、太陽能的機房

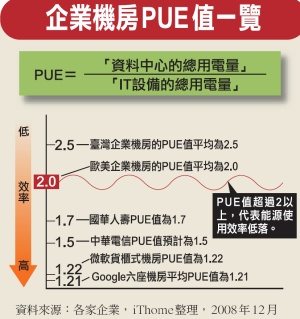

國華人壽的新世代機房,採用了熱通道封閉設計與水平式空調系統,其PUE值達到1.7的高標準,堪稱臺灣數一數二的綠色節能機房。

Case 3新世代機房

中研院網格計算小組─結合冷熱通道發揮下吹式空調系統的效率

中研院網格計算小組擁有1千5百臺刀鋒伺服器,面對龐大的高散熱IT設備,中研院則是透過冷熱通道的機制,強化伺服器冷卻的效率。

Case 4新世代機房

中華電信─亞洲最大的高標準綠色資料中心中華開發工業銀行─因應企業未來成長需求的高彈性機房

張愛蘭 |

|

一走進中華開發工業銀行位於臺北南港軟體園區的新機房,不禁令人懷疑這個機房是否已經啟用了,因為跟傳統冷颼颼的機房比起來,這個新機房絲毫不冷。

中華開發工業銀行資訊處協理張愛蘭說,這座新機房的迴風溫度設定在攝氏22度至24度之間,伺服器皆可正常運作,不會有過熱的疑慮。相較於傳統機房的迴風溫度普遍是在攝氏20度以下,中華開發工業銀行(開發工銀)的新機房,一點都不算冷。

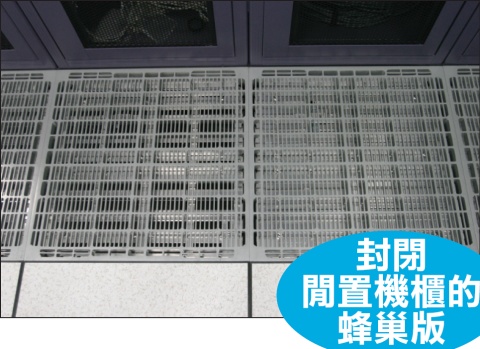

開發工銀在今年3月開始在南港新辦公室打造新一代機房,隨著資訊處在今年5月遷入,新機房也開始營運。望眼看去,映入眼簾的是整齊畫一、排排站的機櫃。再環顧機房四周,竟然看不到空調主機,地板也沒有機房該有的蜂巢板,而纜線則是拉在機櫃的上方。

|

|

| 開發工銀在今年3月開始在南港新辦公室打造新一代機房,隨著資訊處在今年5月遷入,新機房也開始營運。 |

再仔細端詳機櫃裏的伺服器,有些機櫃裝了不少刀鋒伺服器。張愛蘭說,1個機櫃可以應付的耗電量超過30千瓦,足以裝滿一整櫃的刀鋒伺服器。雖然目前開發工銀的機櫃並沒有裝滿刀鋒伺服器,不過若以他們所採用的機種來看,一整櫃裝到滿,總共可承載84臺刀鋒伺服器,然而,機房的迴風溫度依然可以設定在22度以上,絲毫不擔心伺服器會過熱。

到底這座新世代機房是如何在室溫22度的狀況下,應付高散熱量的伺服器?張愛蘭說,開發工銀新機房最大的不同,是併用水平式空調系統與水冷系統,而非傳統的下吹式空調系統。她認為:「為何要將空調冷卻的效能,耗費在機房的環境中,應該是將空調冷卻運用在IT設備上。」

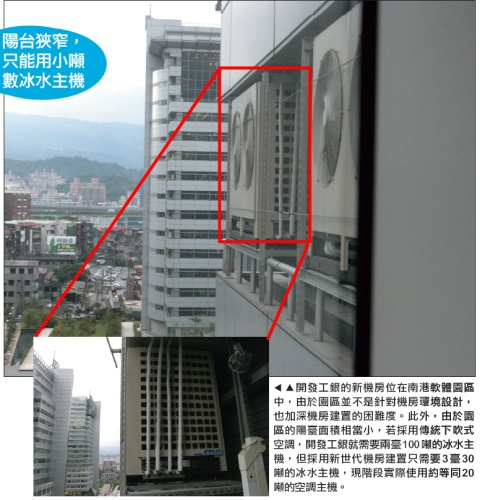

張愛蘭表示,新世代機房強化了冷熱對流的效率,空調冷卻需求與耗電量自然會降低,同時機房的配置將能因而精簡,而這也符合開發工銀新機房所在地點的狀況,因為南港軟體園區並非針對專業機房所設計。

水平式空調系統的主機,是放在機櫃與機櫃之間,主機的高度與深度都與標準機櫃一樣,但寬度則只有標準機櫃的一半。這個空調主機會將冷空氣平行送出,相鄰的伺服器就會將這些冷空氣吸入機箱,以達冷卻效果。如此,冷空氣的氣流路徑小,可提升空調效率。

而傳統的下吹式空調系統,通常會將空調主機配置在機房的某一面牆,由這個空調主機先將冷空氣吹進高架地板,接著冷空氣會從機櫃前方的蜂巢地板往上流動,伺服器再將這些冷空氣吸入機箱。因此採用下吹式空調系統,整個高架地板都是充滿冷空氣,因而冷空氣的需求量較多,冷空氣流動的距離較長,而且空調主機是朝機房的另一端單向送風,位於較遠的機櫃,可能會有送風量不足、空調冷卻不均的問題。

一旦有此問題,有些高散熱機櫃無法有效冷卻,就會成為機房內的熱點。為了解決這些熱點的問題,大多數企業能做的就是調低迴風溫度,例如一般機房的迴風溫度須設定在攝氏18度以下,有些企業的機房溫度甚至比這個還要低,更有設在攝氏10度以下者。如此為了解決特定熱點,而將整個機房的溫度都調低,自然會造成能源的浪費,但是大多數採用下吹式空調的機房卻不得不這麼做。這也難怪,一到夏天,機房的管理人員可以在高架地板下冰飲料。

|

|

開發工銀的新機房共有3間,目前營運的只有2間,其中一間主要是關鍵應用系統,以Unix伺服器為主,另一間則以x86伺服器為主。這兩間機房都有設計冷熱通道,機櫃都是面對面、背對背擺放,因而,每兩排機櫃的正面就是冷通道,而這兩個機櫃的背面也就隔出一道熱通道,如此可避免前方機櫃所排放出的熱氣,被後方機櫃吸入。

x86伺服器機房約有80坪,目前總共用到3排機櫃。第一排機櫃,主要放置x86伺服器主機,第二排機櫃則是放置高密度的主機,例如刀鋒伺服器,而第三排則是放置儲存與網路設備。

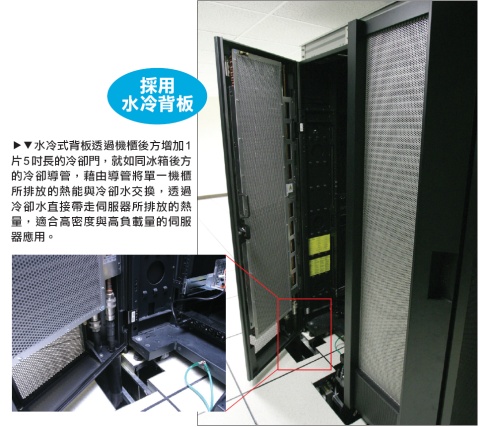

由於這三排機櫃的散熱量不同,開發工銀將水平空調系統做不同的組合。其中,x86機架伺服器發熱量高,開發工銀是以每間隔兩個機櫃就搭配1臺InRow RC空調主機;而發熱量更高的第二排高密度機櫃,除了也是以每間隔兩個機櫃就配置1臺空調主機,並且在機櫃後方搭配水冷背板。發熱量最低的第三排機櫃,則是以每間隔3個機櫃配置1臺空調主機。

針對高密度機櫃額外搭配的水冷式背板,是一片5吋長的冷卻門,就如同冰箱後方的冷卻導管,藉由導管將機櫃所排放的熱能與冷卻水交換,透過冷卻水直接帶走伺服器所排放的熱量。

目前開發工銀只有2個機櫃使用水冷背板,張愛蘭表示,水冷式機櫃主要針對高顯熱的刀鋒伺服器與光纖儲存設備,雖然目前機房密度並不高,但未來企業規模擴大,機櫃密度一定會增加,水冷式機櫃就能滿足刀鋒伺服器等高密度的空調需求。

張愛蘭說:「InRow RC方案雖然比其他廠商所提的下吹式空調系統至少貴上1成。」然而,除了空調效率的考量之外,開發工銀還考量了機房用電、冰水主機噸數與機房運用彈性等需求。

開發工銀評估過,若採用水平式空調系統,需要20噸(BTU)的冰水主機,若採用下吹式空調,則至少需要100噸的冰水主機。能減少冷卻用水量,對開發工銀而言也很重要,因為水也是他們得考慮的問題。

由於開發工銀新機房所在位置,是處於水路管線的末端,水量相當不穩定,所以,冷卻水需求量能越少是越好。以Unix主機為例,在舊機房時,2臺Unix機櫃需要10噸的冰水主機來伺候,但新機房採用水平式空調系統,雖然為此配置了2臺InRow RC空調主機,也是10噸等級,但實際的冷卻水用量則約等同於5噸等級,冷卻水用量省了一半。

|

|

| Unix 伺服器機房配置了2 臺InRow RC 空調主機,最高可達10 噸的冷卻能力,但實際的冷卻水用量則約等同於5噸等級,冷卻水用量可省一半。 |

空調噸數需求減少,就不需要大型的冰水主機,剛好也解決了開發工銀新機房會面臨的問題,因為南港軟體園區的建築都採用玻璃帷幕,陽臺面積相當小,擺放大噸數冰水主機有困難。因為可用小型冰水主機,開發工銀剛好可以在狹窄的陽臺擺上3臺。

南港軟體園區另一個限制,則是不能自設發電機,因為園區統一提供備用電力,但電費就比一般貴了1.33倍,開發工銀因而得更省電。張愛蘭表示,雖然新機房的建置費用比傳統機房貴了1成,不過,新機房省下的電費,預計5年就可以回本了。

南港軟體園區另一個限制,則是不能自設發電機,因為園區統一提供備用電力,但電費就比一般貴了1.33倍,開發工銀因而得更省電。張愛蘭表示,雖然新機房的建置費用比傳統機房貴了1成,不過,新機房省下的電費,預計5年就可以回本了。

在這種新型的機房裏,線路是架在機櫃上方,高架地板上則是配置冷卻水管,把冷卻水送到機櫃旁的空調主機或是水冷背板。但是,一直以來機房最忌諱的就是水,因為一旦漏水,電子設備就很容易故障。在傳統下吹式空調的機房裏,由於空調主機都設於機房的四周,漏水的話是從四周漫延至中央。然而採用水平式空調與冷水背板的話,機房的高架地板下都布滿水管,如何確保不會漏水,是開發工銀很關心的一點。

張愛蘭表示,高架地板下有建置止水墩,在水管旁建立類似堤防的裝置,高度大約是一支筆長,是用來預防水管一旦漏水,阻擋水流外洩。除此,為了避免水壓過大而造成水管爆裂,必須採用耐壓15倍的水管,而為避免冷水管發生結露的狀況,冷水溫度就必須設定在高於露點2至3度。

如果這些防範措施都無效,還是漏水了,止水墩內的水管也設有漏水感應器,只要偵測到有水流過,機房的主控臺就會顯示漏水警告。

開發工銀對於新機房還有一個考量,就是日後調整擴充的彈性。張愛蘭認為,傳統的下吹式空調,不容易變更機房設計,一旦機房蓋好了,就不可能再移動空調主機了,然而空調主機與機櫃的擺設息息相關,空調主機不能動,當然機櫃就不敢任意移動了。

水平式空調系統則解決了這個疑慮,張愛蘭表示,把空調主機設在機櫃旁邊的好處,就是以後要變更機櫃位置,只要是冷熱水管到得了,空調主機就可以跟著機櫃走,如此機房的空間調整會更有彈性。此外,傳統的空調主機占地面積太大,面對未來企業規模擴充,要在現有的機房中再增加一臺下吹式空調主機是相當困難的,然而要增加一臺水平式空調主機卻相對簡單。

為了確保未來的擴充彈性,開發工銀的新機房還採用模組化設計。張愛蘭指出,以前舊機房用了十多年,其間公司人數從2百人擴充到6百人,歷經數次人員異動後,機房的線路非常複雜,到底每一條線是做什麼用的,沒一個人知道,也沒有人敢動任何一條線,「寧願擺著,不去動這些網路線,動了之後不知道會發生什麼事情。」她說。

因而新機房就決定先為未來5年預留擴充計畫。總面積200坪的機房中,除了中控室、電力室外,還畫分出3個主要的機房環境,分為Unix主機機房、x86伺服器機房,以及一間備用機房,日後兩個機房達到滿載後,就可以直接拓展至備用機房。張愛蘭表示,過去大家都認為機房要越大越好,但大型機房在前幾年的使用效率往往不高,但卻又得供給整間機房足夠的空調冷卻,無形中造成許多電力成本的浪費。

目前,待用機房已經配置好電力系統與管線,未來只要機櫃與伺服器進駐,就能立即啟動,張愛蘭說:「這些機房的做法都是為了未來企業成長需求而做的準備。」

|

|

| ▲企業不斷成長,機房空間就會面臨不足,就會開始擴建機房,若機房沒有預先做好規畫,未來機房如要擴建,就會面臨配電與空調建置的問題,以開發工銀新世代機房為例,將200坪機房切割出數個小機房,部分閒置的機房就先預留配電與高架地板,只要添購空調、機櫃與IT設備就能立即啟用,提升擴充機房的靈活度。 |

|

|

| 不只機房要注意消防安全,連重機電區域也是要注意,開發工銀在重機電區設置防火裝置,避免意外發生。 |

國華人壽─臺灣首座採用熱通道封閉、太陽能的機房

邱瑞松 |

|

走進國華人壽的資訊部門,一眼就看到新機房玻璃隔間上刻畫著「Green(綠化)」「Virtualization(虛擬化)」等字眼,立即就能感受到國華人壽新世代機房最重要的精神:綠色節能。

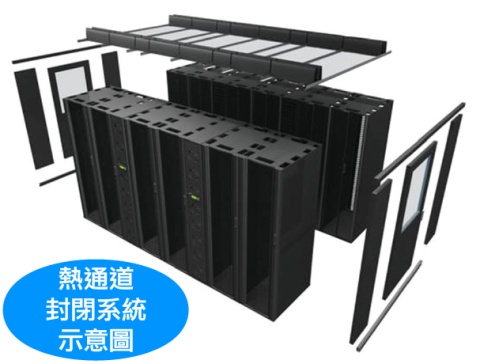

進到國華人壽的新機房裏,你會發現,機房裏好像還有一個小機房。其中有兩排機櫃,不只是在上方加蓋了屋頂,機櫃的通道也有一道門板,而且還是關上的。國華人壽資訊系統部副總經理邱瑞松說,這就是臺灣第一座採用「熱通道封閉」的新世代機房。

回顧國華人壽過去位於中山北路的舊機房,最大的問題就是機房空間的使用效率,而這個問題肇因於空調設計。

國華人壽的舊機房占地約22坪,採用下吹式空調系統。在使用的初期,由於IT設備並不多,下吹式空調還能應付IT設備的發熱量,但隨著企業規模不斷擴增,IT設備越來越多,機房的散熱量也就越高,此時,下吹式空調迴風距離過長的問題就浮現了。由於冷卻效率不夠高,而導致機房有熱點,當時國華人壽只能盡量將散熱量高的IT設備分散至各個機櫃,並且控制在單一機櫃的耗電量不超過2千瓦,然而此舉也造成機櫃密度受限,為了因應日益增加的伺服器,國華人壽就只有擴建機房一途。但是,受限於機房的環境,擴建後的機房只能採用一般廂型冷氣機,最後結果只是讓機房的空調問題更加惡化,邱瑞松說:「當初的情勢根本無法考慮冷熱對流的問題。」回頭想起來可是惡夢一場。

|

|

| ▲國華人壽去年搬遷至臺北市松仁路新辦公室,重頭打造能夠因應未來發展的新一代機房。雖然占地面積只比舊機房多了2坪,但採用了水平式空調系統與熱通道封閉機櫃後,就足以因應國華人壽未來10年的IT需求。 |

當國華人壽搬遷到臺北市松仁路新辦公室時,終於有機會可以拋開舊機房無解的問題,重頭打造能夠因應未來發展的新一代機房。國華人壽的新一代機房,雖然占地面積只比舊機房多了2坪,但採用了水平式空調系統與熱通道封閉機櫃後,就足以因應國華人壽未來10年的IT需求。邱瑞松說:「如果採用傳統下吹式空調,就需要40坪的機房空間。」

國華人壽新世代機房面積約22坪,主要分為IBM p系列主機與x86伺服器兩個區域。國華人壽在x86伺服器區採用熱通道封閉的設計,他們讓兩排機櫃背對背擺放,其中的通道就是用來聚集熱空氣的熱通道,而熱通道封閉的作法,就是把熱通道的上方整個封閉起來,而通道的前後各安裝一道門,只要門是關閉的,就能完全阻隔熱空氣外洩,所以機房外就都是冷空氣。如此完全阻隔冷通道與熱通道的效果,就能避免混風現象,提升空調冷卻的效率。

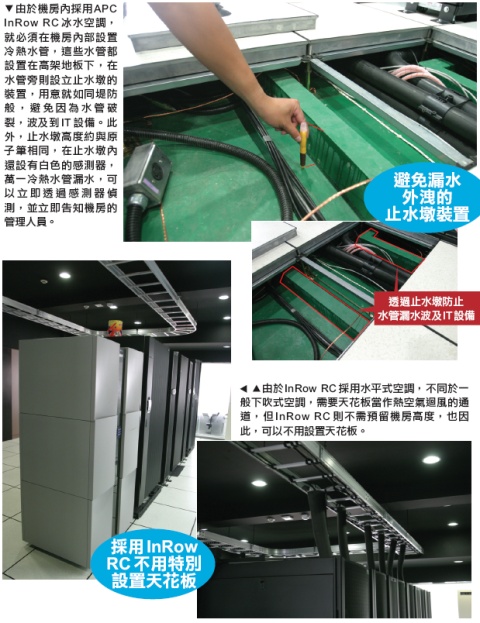

國華人壽同時採用APC InRow RC水平式空調系統,這套空調主機是跟著機櫃相鄰擺放,空調主機的背部朝向熱通道,會把熱氣吸進空調主機,經過冰水冷卻後,再把冷空氣由前方水平地吹出,因而相鄰機櫃的伺服器就能再吸入冷空氣,以此循環達到散熱效果。

|

|

| APC InRow RC空調主機,採用8個變頻式直流風扇,可以依機櫃溫度需求自動調整風扇轉速,達到節能與互為備援的效果。 |

這麼一來,熱空氣就不會擴散至整個機房,因此,就算國華人壽把機房迴風溫度設定在攝氏24度,也都不影響伺服器穩定運作。邱瑞松說:「進入新世代機房可不用再穿厚外套,機房溫度幾乎接近於室溫。」

也因為採用熱通道封閉,x86伺服器區的12個機櫃中,除了有2個是網路機櫃,其他機櫃都放x86伺服器。因為配電量的不同,其中有5個機櫃最高可承載10至15千瓦的設備,其他的機櫃則可承載20至25千瓦的設備,若以刀鋒伺服器來換算,1個42U高的機櫃最多可以承載84臺刀鋒伺服器,透過新世代機房設計、讓高散熱量的伺服器不會過熱。

由於採用水平式空調系統,以x86伺服器機櫃區為例,國華人壽共規畫2排機櫃,目前共放置20多臺x86伺服器,這兩排機櫃的擺設方式為背對背,每排放置6個標準尺寸的機櫃,並以每間隔2個機櫃就放置1臺InRow RC水平式空調主機。過去,國華人壽在舊機房的維運上曾經遇到漏水的問題,當初舊機房採用下吹式空調,由於下吹式空調都必須裝設天花板,以當作熱空氣的迴風通道,然而卻因為天花板的阻隔,當時他們沒有即時發現天花板有漏水。

新機房由於採用InRow RC水平式空調系統,並不需要裝設天花板,因此,機櫃上方的狀況可以一目了然。然而,採用InRow RC水冷空調的話,高架地板下都布滿冷熱水管,為此,國華人壽還是特別注意漏水的問題。為了避免冷熱水管有可能漏水,國華人壽新機房的高架地板下也蓋了避免漏水外洩的止水墩,以免漏水波及IT設備。

|

|

| 國華人壽新世代機房面積約22坪大,在22坪的機房空間中,主要可分為IBM p系列主機與x86伺服器。若發生冷熱水管破裂導致冷卻水外洩,就可透過中控室及時掌握災情,讓機房的管理人員能立即處理。 |

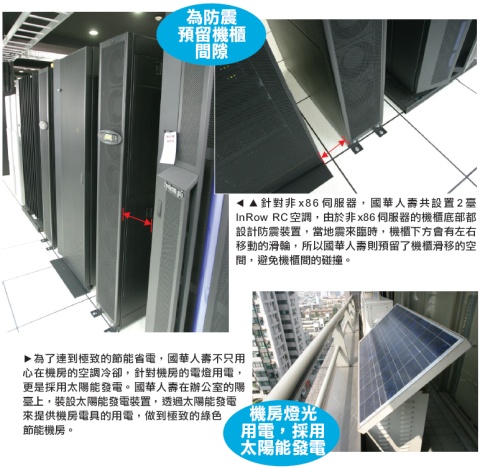

目前,國華人壽IT設備整體耗電量約130千瓦,但國華人壽新世代機房最高可承載的電力達到340千瓦,也就是說,國華人壽的新機房還能承載1倍以上的擴充量。邱瑞松說:「熱通道封閉就是為了強化空調冷卻效率,雖然新機房的建置費用因而高於傳統機房,但機櫃的密度得以再提升,可容納的設備更多,相對來說也省下機房的空間。以節省下來的空調費用與機房空間成本,至少3年就可回本。」

以國華人壽預計新機房壽命可超過10年來計算,至少就可賺回7年的電費。

由於採取了完善的節能措施,國華人壽新世代機房的PUE值計算出來是1.7,目前臺灣企業資料中心的PUE值平均為2.5,而歐美國家的PUE值平均則為2。PUE值越低,代表著機房的能源效率越高,空調冷卻所需的電力就會更少,國華人壽的新世代機房堪稱臺灣數一數二的綠色機房。

中研院網格計算小組─結合冷熱通道發揮下吹式空調系統的效率

中研院網格計算小組─結合冷熱通道發揮下吹式空調系統的效率

施宏良 |

|

|

|

| 中研院網格計算小組於2003年便開始導入刀鋒伺服器來因應龐大的運算量,至今,光是網格計算小組的機房就超過1千5百臺的刀鋒伺服器,儲存容量超過2TB。 |

為了因應「大強子對撞機實驗(LHC)」,人類有史以來最大的分散式電腦系統「全球網格」(WLCG)也隨之誕生。全球網格每年可處理至少15PB的數據,而臺灣身為全球網格的第一層網格中心,為了應付龐大的計算量,中央研究院(中研院)網格計算小組於2003年便開始導入刀鋒伺服器來因應龐大的運算需求,至今,光是網格計算小組的機房就部署了超過1千5百臺的刀鋒伺服器,儲存容量超過2TB,而今年底網格計算小組更將採購5百餘臺刀鋒伺服器,可說是目前臺灣最大的刀鋒伺服器用戶。中央研究院網格計算專案經理施宏良說:「散熱是高顯熱IT設備最大的問題。」也因此,網格計算小組於2007年在有限的經費下,打造出新一代機房,以因應高顯熱的刀鋒伺服器運算環境。

中研院網格計算小組,必須以有限的機房空間預期未來運算量的成長,然而運算量成長相當驚人,於是,網格計算小組透過採購刀鋒伺服器來解決機房空間不足的問題,施宏良說:「機房的空間有限,卻要容納數量龐大的IT設備,不用刀鋒不能解決空間的問題。」

目前網格計算小組共有兩座機房,都是採用下吹式空調系統,第一座機房是在2003年建造的,第二座機房,也就是新一代機房,則是從2007年開始建置,而這座新機房的使命,就是要有效解決第一座機房所面臨的問題。

網格計算小組在2003年開始建造的第一座機房,雖然到了建置末期也曾考慮到要建置冷熱通道,以提升機房的冷卻效率;然而,由於第一座機房的使用者除了網格計算小組外,還有其他單位,在管理上的因應有所困難,因此第一座機房並未落實冷熱通道。施宏良說:「第一座機房最大的問題就是熱對流效益不佳。」這也埋下日後難解的問題。

第一座機房目前約有100個機櫃,共分8排機櫃,除了第一排機櫃的走道是冷通道外,其他機櫃走道並未落實冷熱通道機制,各機櫃都是面向同一個方向,每一排機櫃都是朝著前一排的背面,於是,前一排伺服器排出的熱氣,就會被後一排的伺服器吸入,所以每隔一排機櫃,機櫃的溫度就會提升2至3度。

當然,中研院也曾想設法改善,但機房蓋好要再變更就不容易,於是,他們只好採取一個看似有效,但效果卻不大的作法。他們在每一排機櫃前面斜放著機櫃的玻璃門板,藉此擋住前方機櫃排出的熱風,希望能避免後方機櫃吸入熱氣,然而就整個機房來看,這個做法無法發揮多大的效果。

|

|

| 網格計算小組目前擁有1千5百臺的刀鋒伺服器,是臺灣最大刀鋒伺服器的用戶,目前主要有2座機房,第一座機房於2003年開始建造,由於第一座機房並未確實落實冷熱通道的概念,再加上,機櫃排線並未充分整理,於2006年完工的第二代機房,則是強化了冷熱通道機制,提升整體冷卻的運作效率。 |

另一方面,為了解決散熱量特別高的機櫃,他們在機櫃的後方加裝排氣管,讓一部分的熱氣能直接排到天花板,更快進入空調系統,而不要擴散到整個機房。

|

|

| 為避免機櫃後方排線過多造成出風口的阻塞,新機房在設計上則是強化線路的整理,強化空調冷卻的效率。 |

然而,就算中研院怎麼調整這間機房的空調溫度,整間機房的溫度還是高達25至26度,主要的原因就在於熱空氣無法順利進入空調箱,反而在機房內部形成混風,導致整體機房冷卻效率不彰,如此機房溫度就會不斷上升。最後,他們也把蜂巢板的出風量加大,甚至把電風扇搬到機櫃前,朝著伺服器吹,希望能降低局部機櫃的溫度。不過,由於整體機房環境空調冷卻運作不佳,這些作法實際的效用有限。

另一個問題則是機櫃排線混亂,由於機櫃後方的排線並未有效整線,卻也讓機櫃排熱問題更加嚴重,而導致伺服器運作不穩定。

最後則是配電的問題,因為第一座機房並無獨立的發電機,一旦電力系統出問題,就必須重新開機,雖然有UPS不斷電系統,但UPS只夠供應IT設備的用電量,無法維持空調主機運轉,中研院曾經評估過,電力中斷5分鐘後,機房的溫度就會高達攝氏50度至60度。所以,就算伺服器有足夠的備用電力能夠持續運作,幾分鐘之後就會因為機房整體過熱而導致系統不穩定。

|

中研院舊機房迴風效率差 |

|

|

有了第一座機房的慘痛經驗,網格計算小組在蓋第二座機房時,就想盡辦法來改善。雖然中研院的預算與經費依然有限,不過,由於第二座機房的運作全權歸屬於網格運算小組,因此在規畫上就可以詳細落實冷熱通道的機制。

網格運算小組在蓋第二座機房的目標,是要打造出一座落實冷熱通道機制的機房,不過他們要採用下吹式空調系統,施宏良表示,當初也曾經評估過APC InRow RC水平式空調系統與IBM的水冷背板,但這些新世代機房建置方案都太貴,於是,中研院打算以落實冷熱通道的機制,來強化機房的冷卻效率。

第二座機房的形狀類似一個三角形,共規畫5排機櫃,每個機櫃則以背對背、面對面的方式擺設,以建立冷熱通道。

首先,來看高架地板。下吹式空調主要將冷空氣送至整個高架地板,然而下吹式空調設計,最擔心的就是高架地板塞滿線路,而阻礙冷空氣的流動,於是,中研院的第二座機房就把數量龐大的網路線,全部集中在機櫃上方的線槽,而高架地板只收納高壓電線,讓高架地板下的冷空氣流通更為順暢。

不過,由於第二座機房內幾乎都是使用刀鋒伺服器,每一個機櫃都塞滿了刀鋒伺服器,所需的空調冷卻量相當驚人,也因此,網格運算小組針對高密度刀鋒機櫃的冷通道,設置兩排風量加大型的蜂巢板,至於發熱量較低的IT設備,則只安裝1排蜂槽板,避免浪費冷空氣。

|

|

此外,第一座機房曾經面臨的機櫃排線雜亂的問題,在建置第二座機房時,則強化機櫃的整線作業,所有排線都以束線帶整整齊齊地綁在機櫃的兩側,以避免排線阻礙伺服器排放熱氣。

在網路線路的安排上,中研院舊機房的網路設備全部都集中在一排機櫃中,由於中研院擁有數量龐大的伺服器,連結到網路設備的線路也是相當的繁多,線路其實相當複雜。在第二座機房的設計上,每一排伺服器機櫃則會設置一櫃的網路設備,讓每一排機櫃的網路線可以就近集中,也讓線路的管理更加方便。

|

|

由於第二座機房布滿了刀鋒伺服器,刀鋒的用電量相當驚人,網格計算小組則因而為每個機櫃規畫了3條20安培的迴路,強化機櫃供電的穩定度。為了確保用電的穩定性,網格計算小組還設置了發電機,確保系統運作不中斷。

不過,下吹式空調還有一個先天就存在的問題──迴風距離過長,容易導致熱空氣不易回流至空調主機。網格計算小組原本是希望在機櫃的後方增設一個迴風的導管,以強化熱器迴風的效率,但由於預算有限,因而中止了這項計畫。

從結果來看,相較於第一座機房,網格計算小組打造的第二座機房大幅改善氣流的動線,讓機房的迴風效率更好,施宏良表示,第一座機房由於熱氣較難排出,部分機房區域的溫度仍過高,但第二座機房由於冷熱通道的設計,提升了空調冷卻的效率,相較於第一座機房,第二座機房不會那麼熱。

未來,第二座機房的IT設備仍會持續增加,雖然目前尚未遇到設備過熱的狀況,然而若未來機房呈現滿載,為了避免伺服器過熱,施宏良說:「屆時會再考慮像是水冷背板方案,來強化冷卻的效率。」中華電信─亞洲最大的高標準綠色資料中心

|

|

中華電信與臺灣證券交易所(證交所)於今年2月簽訂策略合作夥伴契約,宣布將在板橋蓋一座綠色資料中心園區,其中將包括證交所的新機房與中華電信的資料中心。據了解,這個預計在2010年完工的新資料中心園區,占地8千坪,機房總面積將有1萬9千坪,並將採用新世代機房建置方案,中華電信的綠色資料中心預計將達到PUE值1.5的高標準。一位不願具名的機房建置顧問表示,這座綠色資料中心園區將會是全亞洲機房面積最大的資料中心。

|

|

中華電信的板橋綠色資料中心(Green Data Center)園區,據了解,將包含4座建築物,其中有兩棟12層樓建築物將做為資料中心使用。中華電信表示,為了配合中華電信光世代計畫與證交所的國際化發展計畫,計畫興建最穩定與最節能環保的資料中心,將符合LEED綠建築認證規範與資料中心節能設計。

在資料中心節能方面,中華電信將打造高標準的用電環境,納入多種節能設計,但目前無法公布細節,不過,中華電信的綠色資料中心要達到PUE值1.5的標準,目前臺灣企業資料中心的PUE值平均為2.5,而歐美國家的PUE值平均則為2。PUE(Power Usage Effectiveness)值是用來計算資料中心節能省電的標準,計算方法是以「資料中心的總用電量」除以「IT設備的總用電量」,PUE值越低,代表機房的空調冷卻所需電力就會更少。

除了中華電信外,目前包含Google與微軟的新世代機房PUE值都有相當不錯的表現,以Google來說,透過建立冷熱通道、提高電源供應器的使用效率、使用蒸發式的冷卻水塔等,讓Google六座資料中心平均PUE值為1.21,而微軟新世代機房則採用貨櫃式機房的設計,由於貨櫃式機房具有相當高的能源使用效率,讓微軟的PUE值達到1.22。

除了中華電信外,目前包含Google與微軟的新世代機房PUE值都有相當不錯的表現,以Google來說,透過建立冷熱通道、提高電源供應器的使用效率、使用蒸發式的冷卻水塔等,讓Google六座資料中心平均PUE值為1.21,而微軟新世代機房則採用貨櫃式機房的設計,由於貨櫃式機房具有相當高的能源使用效率,讓微軟的PUE值達到1.22。

除PUE值外,中華電信的綠色資料中心將符合LEED最高等級白金級的認證規範。LEED是美國綠建築協會於2000年設立的一項綠建築評分認證系統,共分為白金、黃金與銀級,其評分的標的像是能源使用效率、土地規畫使用、省水設計、再生能源、建材回收與室內空氣等。

| 強化下吹式空調效率的新作法 透過建立冷熱通道、移除高架地板下的多餘纜線、整理機櫃後方的雜亂線路等,都可以進一步強化下吹式空調的效率 新世代機房不同於以往最大的特色就是「不會冷」,包含國華人壽與中華開發工業銀行(開發工銀)的新世代機房,迴風溫度都能設定在22度至24度,並擺設超過20千瓦的IT設備,然而,這些現象很難在一般下吹式空調機房看見。

目前企業大都採用下吹式空調設計,甚至部分企業還採用家用分離式冷氣,很少能做到如國華人壽或開發工銀一般,可以採用水平式空調冷卻系統,然而,難道下吹式空調就無法有效因應高密度高顯熱機櫃嗎?其實,從建立冷熱通道、移除高架地板下的多餘纜線、整理機櫃後方的雜亂線路、分散高密度設備、空調系統對齊熱通道、封閉地板孔隙、加裝氣流輔助設備等著手,對於解決高密度伺服器的散熱問題仍有很大的幫助。

方法1:建置冷熱通道

以現階段大多數的機櫃為例,機櫃的前方為進氣口,後方為散熱口,如果機櫃的正面都朝向同一面,就容易讓前方機櫃的熱氣被後方機櫃吸入,因而造成後方機櫃溫度過高,因此,機櫃的擺設必須調整為面對面、背對背。兩個機櫃的正面能面對面,就能建立起冷通道,而兩個機櫃背對背的區域也就建立起熱通道了,這麼一來就可以改善混風的問題,強化空調的冷卻效率。

方法2:空調系統對齊熱通道

方法3:分散負載

方法4:整理機櫃後方的雜亂線路

方法5:加裝氣流輔助設備 |

熱門新聞

2026-02-02

2026-02-03

2026-02-04

2026-02-02

2026-02-04

2026-02-03

2026-02-05

▲水平式空調系統的主機,是放在機櫃與機櫃之間,主機的高度與深度都與標準機櫃一樣,但寬度則只有標準機櫃的一半。這個空調主機會將冷空氣平行送出,相鄰的伺服器就會將這些冷空氣吸入機箱,以達冷卻效果。如此,冷空氣的氣流路徑小,可提升空調效率。

▲水平式空調系統的主機,是放在機櫃與機櫃之間,主機的高度與深度都與標準機櫃一樣,但寬度則只有標準機櫃的一半。這個空調主機會將冷空氣平行送出,相鄰的伺服器就會將這些冷空氣吸入機箱,以達冷卻效果。如此,冷空氣的氣流路徑小,可提升空調效率。