Nvidia推出用於語音、影片、圖片以及推薦服務的TensorRT超大規模推理平臺(TensorRT Hyperscale Inference Platform),其使用的Tesla GPU提供高速處理深度學習工作負載的能力,而推理最佳化引擎TensorRT則可以充分利用Tesla GPU的效能,處理影片串流、語音和推薦系統等應用,並為Nvidia DeepStream SDK提供運算基礎。

Nvidia提到,現在大規模資料中心可以借助超大規模推理平臺的能力,使用增強的自然語言互動,並直接獲取查詢的答案,而非只是一些預存的可能候選答案。

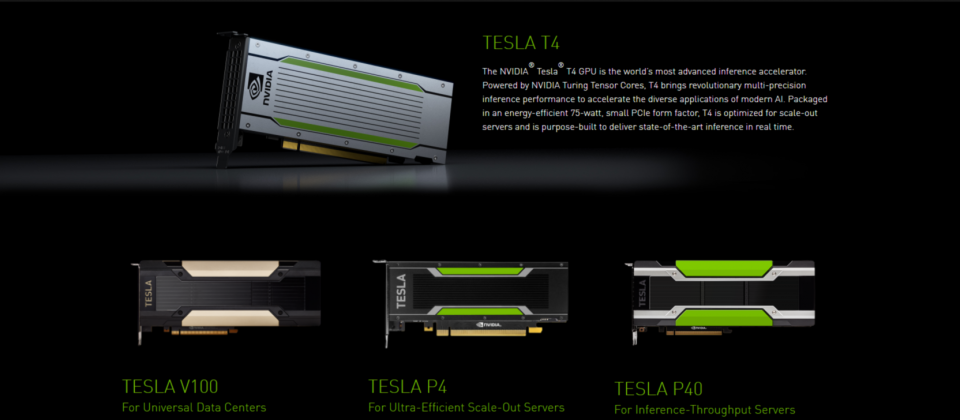

超大規模推理平臺由三個主要部分組成,Tesla T4 GPU、TensorRT 5以及TensorRT推理伺服器。Tesla T4 GPU擁有320個Turing Tensor Cores以及2,560個CUDA核心,提供靈活的FP32、FP16、INT8和INT4的多精度運算,其推測速度是相同耗能CPU的40倍。

而TensorRT 5則是推理最佳化程式和Runtime引擎,TensorRT 5支援Turing Tensor Core,針對多精度工作負載擴展了神經網路最佳化,能低延遲提供推薦系統、語音辨識和機器翻譯等高吞吐量的應用服務,並且TensorRT還能將使用32或是16位元資料訓練的模型,為Tesla T4和P4上最佳化成INT8操作,以及在Tesla V100上最佳化為FP16。同時還賦予DeepStream SDK利用Tesla GPU,同時解碼和分析影片串流。

TensorRT推理伺服器是容器化的微服務軟體,可以在資料中心環境讓應用程式使用人工智慧模型。TensorRT推測伺服器是一個可以立即執行的容器,其提供的微服務可以讓使用者透過API,在一個或是多個GPU上,使用Caffe2、TensorRT和TensorFlow等任何支援ONNX標準的框架進行推測。

熱門新聞

2026-02-11

2026-02-11

2026-02-09

2026-02-10

2026-02-10

2026-02-06

2026-02-10