圖片來源:

medium

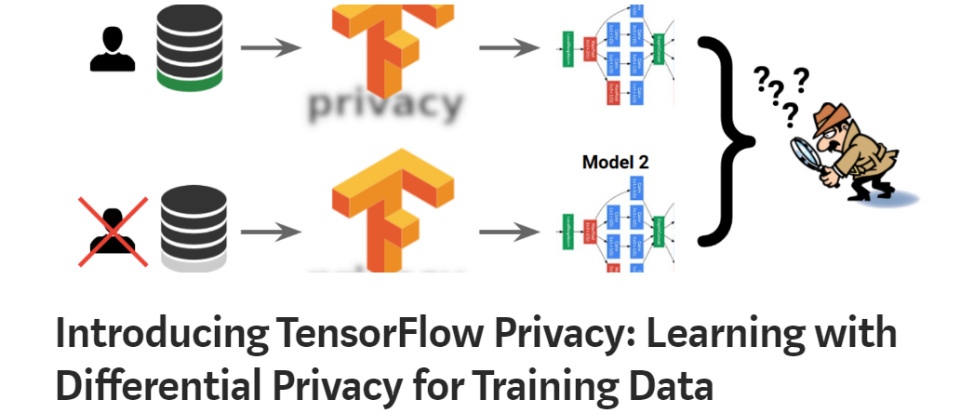

Google釋出TensorFlow Privacy,藉由嵌入「差別隱私」(Differential Privacy)技術來改善AI模型的隱私問題。

TensorFlow為一專門用來建立機器學習模型的框架,它從大量的資料中學習,找出通則,再建立各種應用。不過,有不少被用來訓練的資料牽涉到個人隱私,例如個人照片或電子郵件等,在理想的狀況下,已經訓練的機器模型參數應該納入一般模型而非特定事實,但坊間的機器學習演算法的預設值,並無法自動忽略這些涉及隱私的事實。

舉例來說,假設開發人員正在建立一個涉及醫療診斷的機器學習模型,打算找出抽煙與心臟病之間的關聯性,但一不小心就可能會曝露出抽煙或得到心臟病的病患姓名。儘管一般的訓練資料都會先遮蔽諸如姓名或電話等機密資訊,但研究人員依舊有辦法還原這些資訊。

為了確保此事,Google在TensorFlow中嵌入了差別隱私技術,這是一個透過演算法來測量隱私保證的框架,藉以設計可保護隱私資料的機器學習演算法,其基本概念是隨機化部份機制的行為來保障隱私,Google的作法則是自動過濾那些與演算法主要擷取資訊無關的內容。

Google強調,即便未具備隱私或底層計算專長的開發人員都能使用TensorFlow Privacy,而那些正在使用標準TensorFlow機制的開發人員也不用改變模型架構或訓練程序,只要變更某些程式碼並調整與隱私相關的參數即可。

熱門新聞

2026-02-16

2026-02-13

2026-02-16

2026-02-16

Advertisement