MIT CSAIL

麻省理工學院電腦科學和AI實驗室最近發表一篇縮小神經網路的論文,能在不改變準確率的情況下,找出與最終結果預測相關的子網路,該子網路相比原本的神經網路小10倍,有時候子神經網路,甚至能夠比原本的網路更快做出預測。

MIT指出,目前大部分的AI都建立在深度神經網路的預測結果上,而神經網路通常相當龐大,且需要大量的訓練資料集,訓練的過程也需要耗費數天的時間,硬體方面,也要搭配昂貴的GPU,甚至是需要客製化所需的硬體設備,但是,如果其實根本就不需要這麼龐大的神經網路呢?

現在縮小神經網路所採取的方法,並非特別有效率,在找到成功的子網路之前,必須針對整個神經網路進行多次的訓練和修剪,但是MIT的教授Michael Carbin表示,若能夠準確地在原始的網路中,找出與最終預測相關聯的部分,科學家就有可能可以跳過這段昂貴的處理過程,找出這樣的關聯性,能夠省下數小時的工作,還能讓個別的開發者,更簡單地打造出有意義的模型,而不是只有大型科技企業才有能力辦到。

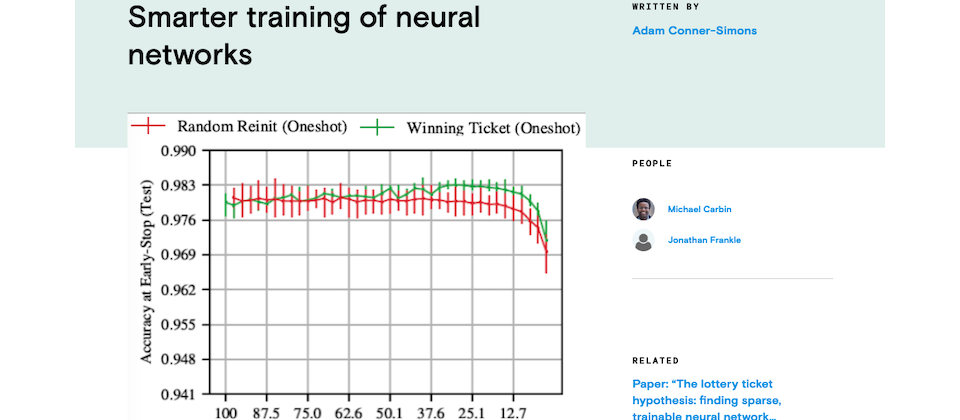

MIT團隊將傳統的深度學習方法比喻成樂透,訓練大量的神經網路就像是試著盲目地買所有可能會中獎的票券,有沒有可能,在一開始就選擇中獎的號碼呢?為了測試所謂的「樂透票券假說」(lottery ticket hypothesis),並證明與最終預測結果相關的子神經網路確實存在, 團隊首先透過常用的方法,從訓練網路中,將最低權重的連結修剪掉,透過去除不必要的連結,使得神經網路能夠在低功設備上執行,像是智慧型手機。

這項實驗關鍵的創新想法在於,在神經網路訓練後修剪掉的連結,是不是再也不需要,為了測試這項假設,團隊試著再一次訓練同一個神經網路,但是這一次並沒有包含被修剪掉的連結,隨著修剪越來越多連結,團隊就能找出在不影響網路學習的情況下,可以刪除多少連結,團隊也針對許多不同的網路,重複這個過程上萬次,來找出與最終結果預測相關的子網路。下一步,MIT團隊計畫探索為什麼特定子網路對學習特別在行,並開發出找出這些子網路的有效方法。

熱門新聞

2026-02-09

2026-02-10

2026-02-06

2026-02-09

2026-02-10

2026-02-10

2026-02-10

2026-02-09