螢幕上顯示的CNN模型,KL520均能支援。

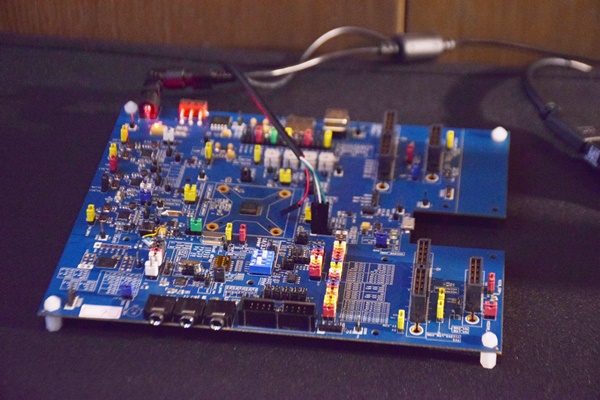

攝影/翁芊儒

耐能(Kneron)日前推出一款AI晶片「KL520」,結合了自家研發的可重組式AI神經網路技術(Reconfigurable Artificial Neural Network,RANN)與模型壓縮技術,並搭載同為自家設計的神經網路處理器(NPU),來支援多種機器學習框架與CNN模型,目前已落地應用於手機、IoT、家居、安防等場景,預計在今年Q4放量出貨。

KL520晶片體積約40nm,算力達350TOPS,平均功耗降至300-500mW;算力效能的部分,在運行Tiny Yolo V2模型時,每TOPS算力可處理的圖片幀數可達49 FPS/TOPS,運行MobileNet V2時也能達到152 FPS/TOPS,低功耗、高效能為其特色。

耐能研發出可重組式AI神經網路技術,可以根據不同CNN模型的運算結構進行重組,來減少運算複雜度、提高效能。耐能董事長劉峻誠形容,這個技術就像是把神經網路的共同小模塊打散,變成很多小的樂高晶片,再依照不同的深度學習模型,透過編譯器自動編譯來組成需要的神經網路,這個技術也曾登上電路及系統領域的頂尖期刊TCAS。此外,KL520也能透過資料(data)排程,來減少記憶體資料搬運(movement)的電力消耗。

運用可重組式AI神經網路技術後,KL520可以支援主流框架和第三方算法,包括ONNX、Tensorflow、Keras、Caffe,以及支援運用上述框架所開發的CNN模型,如Resnet、Vgg16、GoogleNet、Yolo、Lenet、MobileNet、DenseNet等,劉峻誠表示,舉凡被業界與學界大量採用的CNN模型,耐能幾乎都可以支援,也能客製化支援少見的模型。

除了可重組式AI神經網路技術,KL520還有另一個特色是模型壓縮技術,透過遷移式學習(Transfer Learning)、量化(Quantization)、剪枝(Pruning)、 蒸餾(Distillation)等四種方式,在模型精度的損失小於0.5%的情況下,將模型中較不影響表現的小網路拿掉,來有效將模型壓縮變小,進而降低在終端部署的儲存成本與記憶體頻寬的需求。

劉峻誠說明,模型越大,功耗、成本、算力都會提高,因此必須提高晶片運算效能。傳統上要提高效能的方式,無非增加MAC數(乘積累加運算,Multiply Accumulate, MAC,執行運算的硬體電路單元被稱為「乘數累加器」),並將製程工藝提升(晶片從8nm變成7nm),但前者不斷累加MAC數會增加晶片功耗跟面積乘比,後者的提升則會增加成本,讓晶片變大變貴,不利於新創公司的市場競爭。

因此,耐能也自行研發了NPU,目的要提高MAC利用率,盡量讓每個MAC不閒置。劉峻誠表示,耐能可用更小的面積、更低的生產成本來提供更好的運算效能。

要讓AI晶片落地,還需要與各類軟硬體、系統供應商合作

不過,劉峻誠坦言,要讓KL520落地應用,還需要串聯起生態系的合作夥伴。

由於耐能不只生產AI晶片,也自主研發3D人臉辨識技術,因此需要結合提供各類影像感測技術的廠商來讓產品落地。例如人臉辨識結合結構光,可以應用近距離、高精準度的手機屏幕解鎖功能;若結合雙目視覺感測技術可以偵測較遠的距離,適用於智能零售,紀錄顧客人數、位置、停留時間等;或者結合偵測距離介於兩者之間的ToF,可應用於手機後設的自動對焦功能。耐能也已經與奇景光電合作,將人臉辨識技術結合SLiM 3D感測解決方案,實際應用於智慧安防等場景。

此外,深度學習模型等軟體的合作夥伴也很重要,許多客製化適用於不同場景的影像辨識技術,還是需要不同的夥伴來做。例如,老人家是否跌倒暈倒、冰箱的食物有沒有過期、小女孩靠近火爐便自動斷電、烤箱自動辨識燒焦部位、或是空調在人多時降溫且不會對著老人吹等。由此可知,系統供應廠商也不可或缺,因為單獨一顆晶片可以做的只有辨識,但要加上系統,如掃地機、冰箱、冷氣、電視機等,才能貼近民眾生活。

目前耐能主要投入在智慧手機、智慧家居、智慧安防的邊緣運算領域。劉峻誠表示,未來的願景是要賦予終端裝置有判斷能力的AI引擎、建立Edge AI Net,並以去中心化、多模輸入、離線本地處理、算力共享、主動智慧等五大核心,串起邊緣運算的網絡。

熱門新聞

2026-02-11

2026-02-11

2026-02-09

2026-02-10

2026-02-10

2026-02-06

2026-02-10