微軟發表一款文字轉語音AI,利用非監督式學習和總共20分鐘長的200個音頻樣本及其文字檔,就能開發出準確度達99.84%的模型。

重點新聞(0524~0530)

微軟 語音辨識 非監督式學習

微軟發表新文字轉語音技術,只要200個樣本就能訓練出準確度99.84%的模型

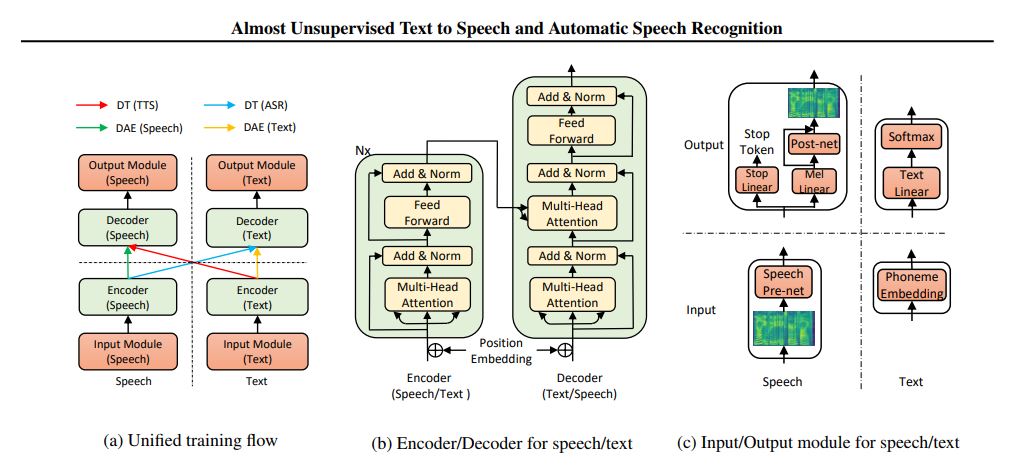

微軟日前發表一款文字轉語音AI,利用非監督式學習和200個音頻樣本(總共約20分鐘長)及其文字檔,就能開發出準確度高達99.84%的文字轉語音模型。

研究員表示,這項研究的關鍵在於採用了Transformer類神經網路架構;Transformer的特別之處在於其注意力(Attention),能讓每個輸出值與每個輸入值相連,而且能動態調整權重。另一方面,研究員使用了開源的LJSpeech資料集,隨機取其中的200個音頻與相應的文字檔作為訓練資料集,並採用去噪自動編譯器來重建受損的音頻和文字檔。研究員表示,利用這小型語料庫打造出的AI,其測試時的表現比另外3個AI基準模型還要好,準確度可達99.84%,儘管生成的語音仍帶有些許的機器腔。(詳全文)

三星 3D建模 對抗生成網路

不必3D建模,三星的AI可以直接讓圖像「動」起來

位於莫斯科分部的三星AI中心近日發表一項研究成果,透過自家設計的模型,只需幾張臉部表情的影像,就能讓靜態的人物肖像做出表情或開口說話,而且不必依賴3D建模等傳統方法。

在這項研究中,三星團隊首先以VoxCeleb2影片資料集來進行元訓練,再利用3套類神經網路來打造這個系統,包括負責將幀映射到向量的嵌入式網路、負責將臉部特徵映射到合成影片的生成器網路,以及評估生成影像真實性的鑑別器網路。研究員也以瑪麗蓮夢露、愛因斯坦和蒙娜麗莎等著名人物肖像來實驗,因此,現在大家可以看到照片中的瑪麗蓮夢露或愛因斯坦開口說話了,甚至是在畫作中的蒙娜麗莎也有不同的表情,而且研究人員在蒙娜麗莎身上套用了來自3個不同人的模型,創造出3位個性迥異的蒙娜麗莎。(詳全文)

視覺模型 臉書 深度學習框架

臉書開源用於視覺和語言模型的深度學習框架

臉書最近開源釋出能支援視覺和語言領域的深度學習框架Pythia。Pythia建立於臉書自家的開源框架PyTorch上,其模組化和隨插即用的設計,方便研究人員能快速建置、複製和檢測AI模型。Pythia框架的功能包括參考工具,能顯示之前模型的基準測試結果,並快速評估新模型的效能。

Pythia框架是為視覺和語言任務設計,像是與視覺資料相關的回答問題模型,以及自動為影像產生標題的模型。此外,該框架也支援分散訓練和多種資料集,還能自訂損失函數、指標、排程和優化器。(詳全文)

KCL Nvidia AI醫療

倫敦國王學院聯手Nvidia,要打造醫療AI平臺來改善英國醫療體系的影像判讀流程

倫敦國王學院(KCL)聯手Nvidia,要打造一款醫療AI平臺,來簡化、加速英國國家醫療體系(NHS)專科醫生判讀醫療影像的流程。該專案為KCL長期計畫的一部份,旨在改善NHS心臟科、神經科和腫瘤科等12個領域的臨床流程,以及病患照護等層面。

目前,KCL正部署算力為2 petaflops的Nvidia DGX-2超級電腦,來完成該專案的第一階段,之後將利用Nvidia Clara AI工具套件和第三方類神經網路框架(如NiftyNet),來開發影像判讀系統。另一方面,KCL研究員和Nvidia也將與英國數家NHS主要醫院合作,來整合技術開發與臨床應用,也方便未來快速部署到其他醫療機構。為保障資料隱私,此次專案將採聯合學習(Federated Learning,也稱為分散式機器學習)來開發演算法,讓各機構的資料不必向外傳輸,透過醫院內部的資料即可自行開發AI演算法。而這些各家開發的模型,除了能精準反映該區域的病患特性,NHS也可整合這些模型,來發展為層面更廣的模型。(詳全文)

JINS AI店員 機器學習

不怕選錯!AI店員幫你挑眼鏡

日本平價眼鏡連鎖品牌JINS日前宣布引進JINS Brain AI智慧判讀服務至臺灣分店,來幫臺灣消費者「挑眼鏡」。該服務由日本總部的JINS Brain實驗室開發,他們利用半年的時間,讓3千位不同年齡的男女店員來看30多萬張不同臉型配戴不同框型眼鏡的照片,並評斷每張照片的配戴適合度,再利用這些資料來訓練機器學習模型,開發出一套JINS Brain AI智慧判讀系統。

現在,消費者只要對著店內iPad螢幕試戴眼鏡,系統中的AI男店員或AI女店員就會在幾秒內告知適合度百分比,幫助消費者挑選合適的眼鏡。目前,JINS臺灣分店已有4家開始提供免費的Brain AI智慧判讀服務。(詳全文)

MIT RoboRaise 機器人

不需下指令,MIT打造出能與人類合作抬起物體的機器人

麻省理工學院電腦科學暨AI實驗室(CSAIL)最近發表能與人類合作抬起物體的機器人,該機器人系統RoboRaise是利用肌電圖檢查(EMG)感測器,來監控人類的二頭肌和三頭肌運動,演算法會不斷偵測人類手臂高度的變動和上下的手勢,來調整自身的動作,與人類一同合作抬起物體。

MIT的研究團隊使用RoboRaise系統執行一系列的任務,包括撿起物體、組裝模擬的飛機零件等。在實驗過程中,人類可透過手臂動作(如抬舉、伸縮)來控制機器手臂的活動,而機器手臂的活動範圍可精準至數英吋;此外,機器人還可正確回應人類70%的手勢。研究團隊希望,未來在系統中加入更多肌肉或不同類型的感測器,增加機器人的活動自由度,最終目標是要機器人能夠完成更複雜的任務。(詳全文)

微軟 對話機器人 SDK

微軟更新對話機器人開發框架SDK,提供適應性對話框靈活解決問答

微軟更新了其用於建立文字對話機器人的開發工具Bot Framework SDK,幫助企業建立能確實解決用戶問題的機器人與虛擬助理,提升客服體驗。Bot Framework SDK加入了適應性對話框,能讓開發者根據情境和事件,來動態更新對話流程。開發者可自定義行動(Action),而行動可包含一系列的步驟,這些步驟是由對話中發生的事件結果定義;這樣的設計對於切換或中斷對話內容時,格外好用。

Bot Framework SDK還提供了模組化對話功能,微軟稱之為技能(Skill)。開發者可將拼湊不同技能,來形成完整的對話體驗,而技能包括了跨應用程式的語言模型、對話框以及卡片,目前預覽版本的技能則有電子郵件、日曆和興趣點。中央對話機器人可以由企業各團隊維護的子機器人組合而成。(詳全文)

耐能 AI晶片 CNN

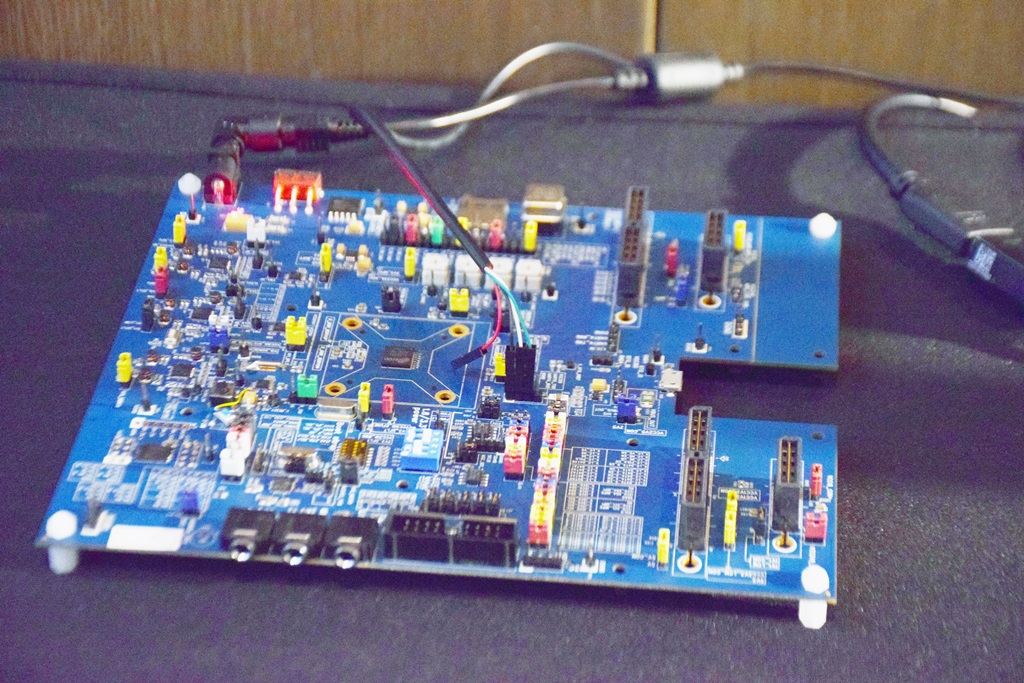

耐能新款低功耗AI晶片KL520能支援多種CNN模型,今年第四季出貨搶攻邊緣運算市場

耐能(Kneron)日前推出一款AI晶片「KL520」,主打低功耗、高效能,結合自家研發的可重組式AI神經網路技術(RANN)與模型壓縮技術,並搭載自家設計的神經網路處理器(NPU),來支援多種機器學習框架與CNN模型。耐能研發的RANN,可以根據不同CNN模型的運算結構進行重組,來減少運算複雜度、提高效能。另一方面,KL520可支援主流框架和第三方演算法,比如TensorFlow、Keras、Caffe,也支援運用上述框架所開發的CNN模型,如ResNet、Yolo、MobileNet等,也能客製化支援少見的模型。

KL520還具模型壓縮技術,透過遷移式學習、量化、剪枝、蒸餾等四種方式,在模型精度的損失小於0.5%的情況下,將模型中較不影響表現的小網路拿掉,來壓縮模型。Kneron目前已落地應用於手機、IoT、家居、安防等場景,預計今年Q4放量出貨。(詳全文)

攝影/翁芊儒 圖片來源/三星、JINS、MIT

AI趨勢近期新聞

1. 美國空軍和MIT推出AI加速器計畫,聚焦於國家級安全挑戰

2. Google打造肺癌預測模型,表現超越人類放射科醫師

3. 為突破AI能力限制,臉書要教機器人在真實世界中自主學習

4. IBM要讓Watson協助農夫導入智慧農業

資料來源:iThome整理,2019年5月

熱門新聞

2026-02-11

2026-02-11

2026-02-09

2026-02-10

2026-02-10

2026-02-06

2026-02-10