由於倒伏的水稻會露出莖,不似其他水稻露出稻穗,在顏色及紋理上有所不同,因此可以用影像辨識技術來分辨出倒伏面積。

圖/翁芊儒

颱風、豪大雨等天災造成的農損,可說是農民的最大噩夢,一旦有災情發生,政府將會依據勘災結果發放補償金,來保障農民生活。而勘災方法也與時俱進,從過去耗費大量成本的人力勘災,進展到現今常用的無人機空拍方法,一再提高了農損判賠的效率,比如農試所就從民國105年就開始應用無人機勘災,目前也已經能初步分析12種作物的災損影像。

可是,一旦遇上大型颱風,災情往往遍及數鄉鎮的農田,就算用傳統的無人機空拍,最快得花上7~10天才能完成鄉鎮大小(約3,000-5,000公頃)的災情分析,讓農夫開始進行後續處理,可是,伏倒泡水多天的稻穗往往難以收成了。

中興大學土木工程學系教授楊明德所領導的研究團隊,日前在一場活動上揭露無人機勘災的創新突破成果,首創了在無人機上結合深度學習模型的即時農損辨識技術,辨識率不但達9成,分析完約3,000-5,000公頃鄉鎮級田地所需的時間,也能從7天縮短到1天。

中興研究團隊成員曾信鴻指出,農民在天災後,常因為政府的勘災作業而延遲作物搶收的時間,甚至有些農民等不及農損影像蒐集完整,就開始搶收農作而破壞景觀,都增加了後續判賠的困難度,而更快且精準的大規模航拍以及影像分析技術,能進一步解決這個痛點。

因此,研究團隊首先用該技術來解決稻米倒伏的問題。稻米倒伏是指在結穗期因天災而傾倒的稻米,泡在水中會發芽或無法成熟而降低產量,依政府規定,只要受損面積超過20%就能獲得補償。曾信鴻說明,由於稻米倒伏的空拍影像,會露出稻莖而非稻穗,在顏色、紋理及高度上有所不同,所以能用影像辨識方法來判斷倒伏面積。

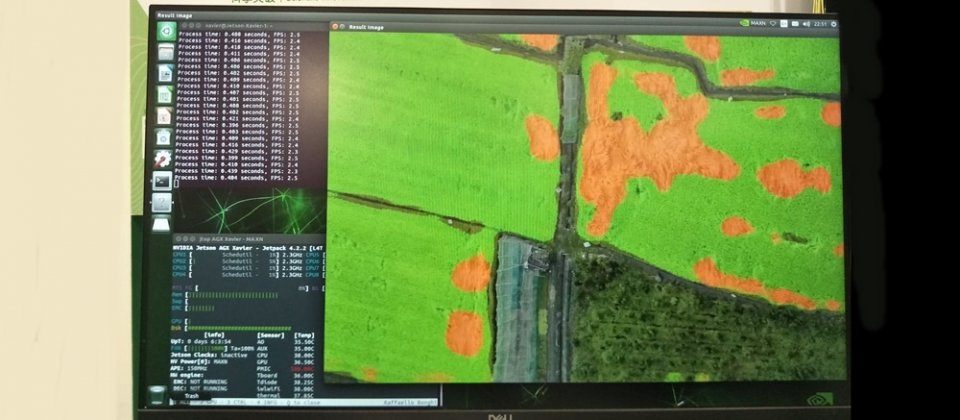

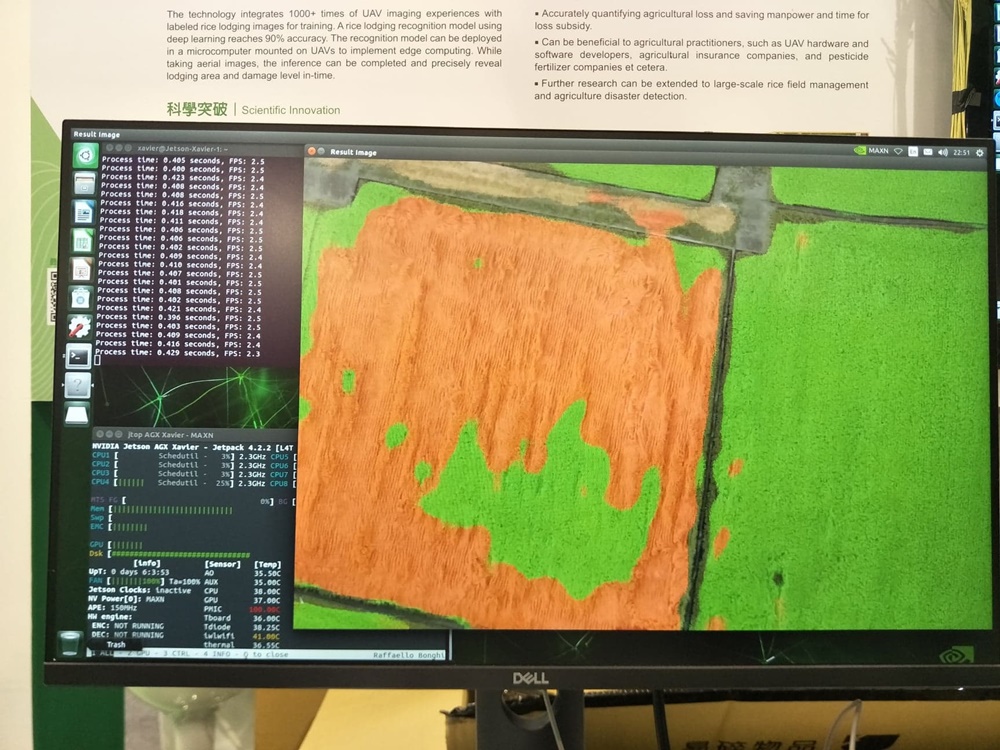

首先,研究團隊運用無人機拍攝的農地照片,標註出水稻倒伏的影像,再以SegNet深度學習架構來訓練水稻倒伏農損辨識模型,目前辨識率已超過90%。接著,為了讓無人機具備邊緣運算的能力,研究團隊試著將含GPU在內的邊緣運算裝置,部署到無人機上進行即時推論,再透過4G或LoRa回傳坐標資訊與辨識結果。

而將影像傳回地面後,就能根據重疊區域的特徵來拼接出初步辨識過的農地影像,此時,針對災損區域,還能再切割成小張圖像來進行影像辨識,重複驗證邊緣運算的結果,或再次進行低空拍攝,來建立起3D的DSM數值表面模型,找出更精確的地表高度數值,比如紅色區域代表高度較低的稻穗倒伏面積,綠色區域則代表高度正常的健康稻穗面積,藉此更準確的辨別農損。

以SegNet深度學習架構訓練的水稻倒伏農損辨識模型,目前辨識率已超過90%,且能在無人機上即時辨識。

曾信鴻表示,大多現行研究單位或業界的無人機勘災流程,尚未導入深度學習、自動化及分散式的運算工作,而是透過無人機回傳影像後,再應用傳統的最大概似法(Maximum Likelihood Estimation,MLE)來估算災損面積。相較之下,同樣3,000到5,000公頃鄉鎮級的災損評估時間,用傳統辨識方法可能1個禮拜,但運用深度學習技術只需要一天,能節省7倍時間,關鍵在於前者的辨識方法需要不斷重複資料前處理的過程。

不過,在將技術實際應用到農作災損辨識的過程中,也有不少挑戰。其一,是硬體整合的問題。由於無人機在空中飛行的時間越久、能拍攝的面積越廣,蒐集資料的速度也越快,因而需要充足的電力來支持無人機飛行更久時間,不過同時考量到無人機的重量負載限制,裝設更多電池增加的重量,可能造成飛行時更多的電力消耗,反而縮短了無人機的航拍時間,「硬體整合會需要經過最佳化的階段,這部份正在與廠商合作來解決問題。」

其二,則是訓練深度學習模型的前提,是先取得足夠多且高品質的資料,但除了稻米之外,其他如香蕉、茶葉、玉米災損期間的航拍影像,都面臨資料不足的問題,除了部分作物在臺灣的種植數量不多以至於影像較少,農損期間的照片也不易取得。為此,研究團隊也跟農試所、農改場合作,來取得不同作物類型的影像資料。

除了農損評估,研究團隊也透過結合影像辨識技術的無人機,來判讀秧苗的密度是否符合經濟效益,若特定範圍的植株數量不足,就能通知農民進行補秧,來輔助農作物完整生命週期的栽培。

透過影像辨識模型來辨識秧苗植株的數量,能成為農民評估是否需要補秧的參考。

目前,研究團隊正在爭取政府今年的水稻災損辨識委託案,要將技術實際應用到政府災損評估作業中;且隨著影像辨識技術成熟,也預計在明年成立新創公司,將技術產品化,進軍東南亞的水稻管理與勘災應用。

熱門新聞

2024-11-18

2024-11-20

2024-11-15

2024-11-15

2024-11-12

2024-11-19

2024-11-14