為了加速災害評估的速度,Google開發了使用卷積神經網路處理衛星圖像,檢測建築物損壞範圍的方法,以機器學習自動比對衛星資料,產生災區建築物損害評估。這項研究是Google與世界糧食計畫署的創新加速器合作開發,目的是要加速災害評估,對受災嚴重的地區,提供即時救難資源。

Google提到,諸如地震、風災和洪水等自然災害,嚴重時影響的面積將非常廣闊,甚至可能對數百萬人造成衝擊,而這對於後勤救援是個很大的挑戰,政府、非政府和聯合國等組織,都需要對災情進行快速評估,以最佳化配置有限的資源。

現在有不少工具,能夠使救災評估更快速,像是解析度高達30公分的超高解析度(VHR)衛星圖像,便成為應對災難的重要工具,讓救災單位可以掌握災區狀況,包括災害可能大幅改變災區地形,也能查看基礎設施和人口等狀態。

不過要從原始衛星圖像中,查看倒塌的建築物、出現裂縫的橋樑以及臨時避難所等地點,仍需要大量的人力,Google舉例,當2010年海地發生地震,分析人員對太子港地區衛星圖像,以人工檢查9萬棟建築物,並以5個等級分類這些建築物的損壞程度,就花了數周的時間,但是災難發生後黃金救難時間,卻只有48到72小時,這個時候最需要即時的災區評估資訊。

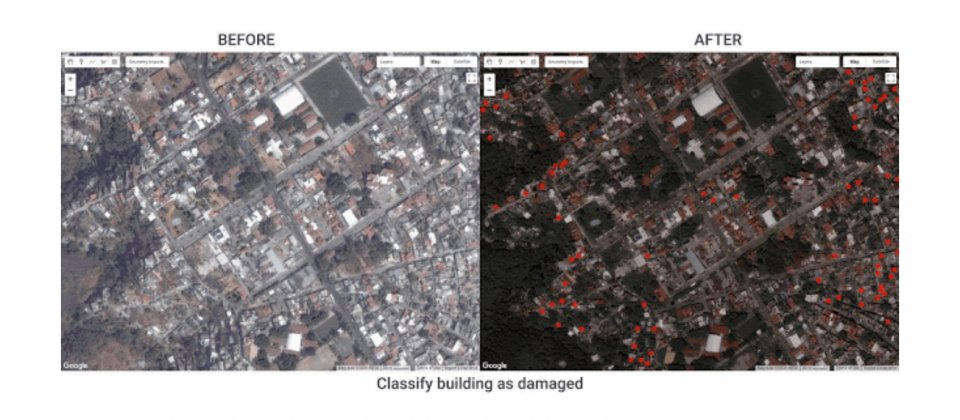

Google使用機器學習技術來加速災害評估,自動損害評估的過程有兩個步驟,其一是建築物偵測,其二則是損害分類。在建築物偵測步驟,Google使用物體偵測模型,在衛星圖像中對每個建築物繪製包圍盒(Bounding Box),並且擷取災害前與後的圖像,之後以分類模型來決定建築物受損與否。

分類模型由卷積神經網路組成,在卷積神經網路輸入以給定建築物為中心,災難發生前後的兩張圖像,圖像大小為161乘161畫素,對應50平方公尺的占地面積。分類模型會分類兩個圖像的差異,並輸出0.0到1.0的分數,數值接近0.0代表建築物未損壞,接近1.0則代表建築物已損壞,Google提到,閾值設為0.5可用來預測損壞與否,但仍可依據敏感度調整。

對於不同時間所拍攝的衛星圖像,可能出現亮度、對比度和色彩飽和度等差異,Google對災難前後的圖像顏色,進行直方圖均衡化校正,並使用標準資料增強技術,透過在訓練過程干擾圖像的對比度和飽和度,使模型對顏色差異更具強健性。

Google提到,這項工作最困難的部分在於收集訓練資料,因為有用到高解析度衛星圖像的災難並不多,而且有做災難評估的次數又更少。在標籤資料上,Google取用自人道組織UNOSAT與REACH手動產生的損害評估資料,並使用Google地球引擎將損害評估標籤,與衛星圖像相結合,以產生最終的訓練資料。

Google將這個系統分別用於評估2010年海地地震、2017年墨西哥城地震以及2018年印尼所發生的一系列地震,並把UNOSAT和REACH的人類專家評估作為基準真相,評估系統的準確度,結果顯示該系統表現良好,3個事件的預測精準度都在70%到80%間。

目前的模型使用同地區的建築物圖像進行訓練和測試,雖然效果很好,但是最終的系統是希望只靠一個模型,便可以用在世界各地發生的災難,對當地建築物進行評估,Google表示,這相當具有挑戰性,因為要評估的不僅是訓練資料地區的建築物,但可用的訓練資料,又僅限於少數幾個地區的災難,因此擴展模型可以處理的範圍,將是研究人員接下來的工作。

熱門新聞

2026-02-06

2026-02-06

2026-02-06

2026-02-06

2026-02-09

2026-02-09

2026-02-09