YOLOv4為邊緣應用帶來更輕量更準確的物件辨識能力,中研院資科所所長廖弘源指出,他目前正另組團隊,要打造另一款世界第一的物件追蹤AI。

攝影/王若樸

YOLOv4今年問世以來,不僅廣受全球AI社群討論,在9月28日的MSCOCO物件偵測競賽中排名世界第一。「但這還不夠,」開發YOLOv4關鍵技術的核心人物中研院資訊科學研究所所長廖弘源指出,他現在還另組國家隊,鎖定物件追蹤AI,發豪語要打造全世界最好的追蹤器、再次打敗Google、AWS,拿下另一個世界第一。

無心插柳柳成蔭,為產業解題意外催生YOLOv4

YOLOv4的誕生,還得從2017年的科技部計畫說起。當時,科技部提出「業界出題、學界解題」AI計畫,由企業提出問題,再由學界提供技術來解決,讓學界技術得以落地應用。

在這項計畫中,中研院資科所與義隆電子媒合,要來解決義隆電子提出的交通車流分析問題。為了解題,廖弘源找來以前的博士班學生組隊,包括後來YOLOv4的共同作者、中研院資科所博士後研究員王建堯,以兩大共識來執行任務,也就是要挑選能以科學解決的現實產業問題,以及「先把手弄髒,」先不要考慮論文發表,如此才能從動手做的過程中,找出最佳解法。

經雙方討論,團隊制定出2018年至2021年的解題目標。首先,2018年要完成魚眼車流分析、多攝影機行人識別技術、行動裝置人臉防偽技術,2019年鎖定路口停等車隊與車流分析、混流車牌識別、行車魚眼多物件追蹤,2020年則是結合前兩年的魚眼車流分析技術和停等車隊與車流分析技術,來建立路口交通號誌控制系統;2021年則要完善智慧交通路網號誌控制系統,要透過混流車牌識別技術,以科技執法來揪出違規車輛。

有了年度目標,團隊也進一步規畫開發流程。2018年,他們聚焦於魚眼十字路口車流分析,將使用場景鎖定於路口交通號誌燈,在號誌燈上裝設魚眼鏡頭,搭配Nvidia Jetson TX2平臺,來拍攝、分析道路路口影片。其中的技術要求,包括要能辨識車輛、車種和數量統計,比如認出汽車、機車、自行車、聯結車等,此外,還要能辨識車流量、車行平均速度、路口平均佔有率和車輛間距等。

同年6月,團隊也部署魚眼鏡頭,實際測試用來分析車流量的演算法,並根據偵測到的數據,來調整交通號誌燈號。

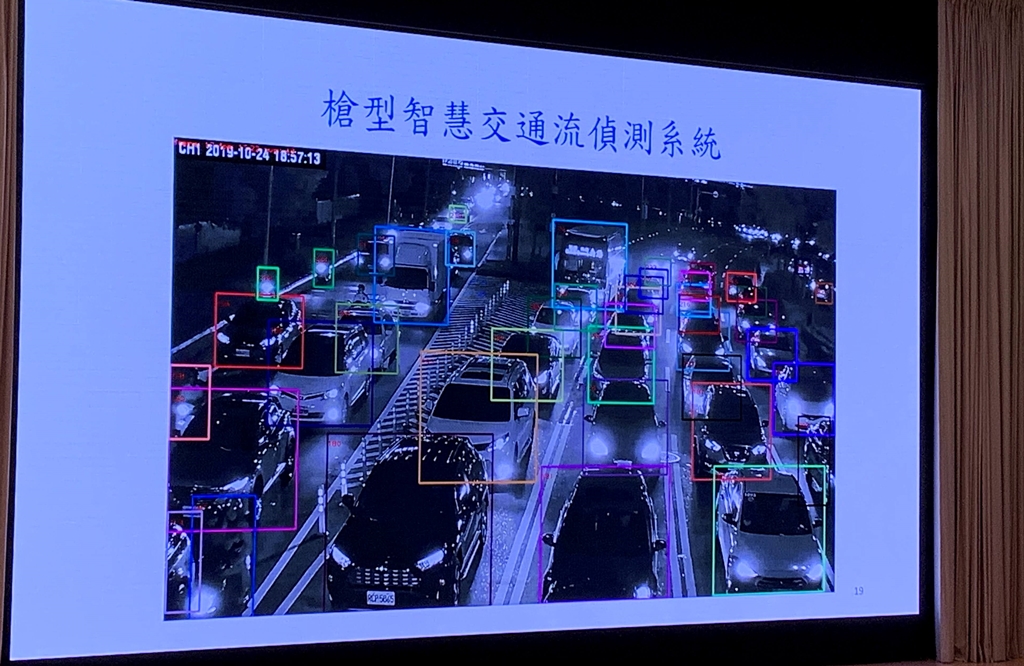

接下來,2019年,團隊將開發目標擴展至停等車隊分析,將槍型式攝影機裝設於交通號誌燈或一旁立桿上,每個方向裝一支,一樣搭配Nvidia Jetson TX2平臺,來拍攝、分析路口影片。而技術目標,則是要辨識各車道線內的停等車種和間距,比如機車、小客車及大型車,以及這些車間的距離。

在實作上,他們進行了停等車隊與車速的分析,以及停等車隊與車流的分析。而當時槍型攝影機所搭配的物件偵測演算法,就是「意外發展出來的YOLOv4。」

以PRN和CSPNet為基礎,今年YOLOv4正式誕生

YOLOv4就在這些階段性的任務中誕生了。2018年,為配合硬體平臺限制,廖弘源與王建堯以ResNet為基礎,改善了學習策略,自行開發一套快速、較不耗費運算資源的輕量級類神經網路:局部殘差網路(Partial Residual Networks,PRN),來進行影像辨識。雖然PRN比YOLOv3快上兩倍,但準確度比YOLOv3稍差。

隔年,為改善這個問題,他們著手研發跨階段局部網路(Cross-Stage Partial Net,CSPNet),不只耗費的硬體資源更低,準確率也更高。這是因為,CSPNet可增加梯度組合(Gradient combinations),也能最大化梯度多元性,一改卷積網路為人詬病的梯度消失問題(也就是學習效率不佳的主因)。

2019年11月,廖弘源和王建堯開源了CSPNet程式碼,立刻吸引了Alexey Bochkovskiy的注意,也就是維護YOLOv3 DarkNet的電腦視覺專家。「他對CSPNet很有興趣,」廖弘源指出,他也邀請團隊以三種GPU來測試CSPNet效能,包括Maxwell、Pascal和Volta。

今年3月,他們完成所有GPU測試,發現「CSPNet在三種GPU的表現,都是世界最好的。」後來,他們將測試程式碼開源出來,也另外寫了篇論文,並發表為YOLOv4,作者就是廖弘源、王建堯和Alexey Bochkovskiy。

在架構上,YOLOv4以CSPDarkNet53為Backbone,來加強卷積網路的學習能力,而Neck部分則加入空間金字塔池化層(Spatial pyrimad pooling)和PANet,前者用來強化接受區域(Receptive field)作用,能將最重要的特徵區分出來,後者則取代YOLOv3的FPN,在不同等級的偵測器中聚合參數(Parameter aggregation)。最後,在YOLOv4的Head,則採用YOLOv3。

在效能上,YOLOv4比EfficientDet快上兩倍;而且在採用Tesla V100 GPU的情況下,以MSCOCO資料集來測試物件辨識能力,YOLOv4可每秒辨識65幀(fps)、平均精確度(AP)達43.5%,「優於其他R-CNN網路表現。」

9月拿下世界第一,下個目標瞄準物件追蹤AI

不只如此,在今年9月28日的一場MSCOCO資料集物件偵測競賽中,團隊以CSPNet加上Mish啟動函數參賽,拿下第一、第二、第四和第六名,打敗Google、高通、Amazon和臉書的類神經網路(如下圖),「從9月28日到現在,這個排名都沒有改變過,臺灣一直是世界第一,」廖弘源說。

YOLOv4也帶來嵌入式應用的新作法。比如,邊緣裝置系統不須將資料上傳至雲端,也能即時分析、回饋,「享有與雲端運算同等的高精確度,」而且裝置成本低、耗電量也低(小於30瓦)。

話鋒一轉,廖弘源指出,「我們並沒有停下來,」反而找來國內大學教授、組了10人臺灣隊,鎖定物件追蹤AI,要打造「全世界最好的Tracker,再次打敗Google、Amazon,讓臺灣再榮光一次!」文◎王若樸

熱門新聞

2026-02-11

2026-02-12

2026-02-11

2026-02-10

2026-02-09

2026-02-13

2026-02-10

.JPG)

.JPG)

.JPG)