中研院院士暨哈佛大學電腦科學與電子工程教授孔祥重指出,AI模組未來可置於區塊鏈上,不僅提高重複使用率,也可用來交易。

螢幕截圖(取自Galaxy Summit 2022直播影片)

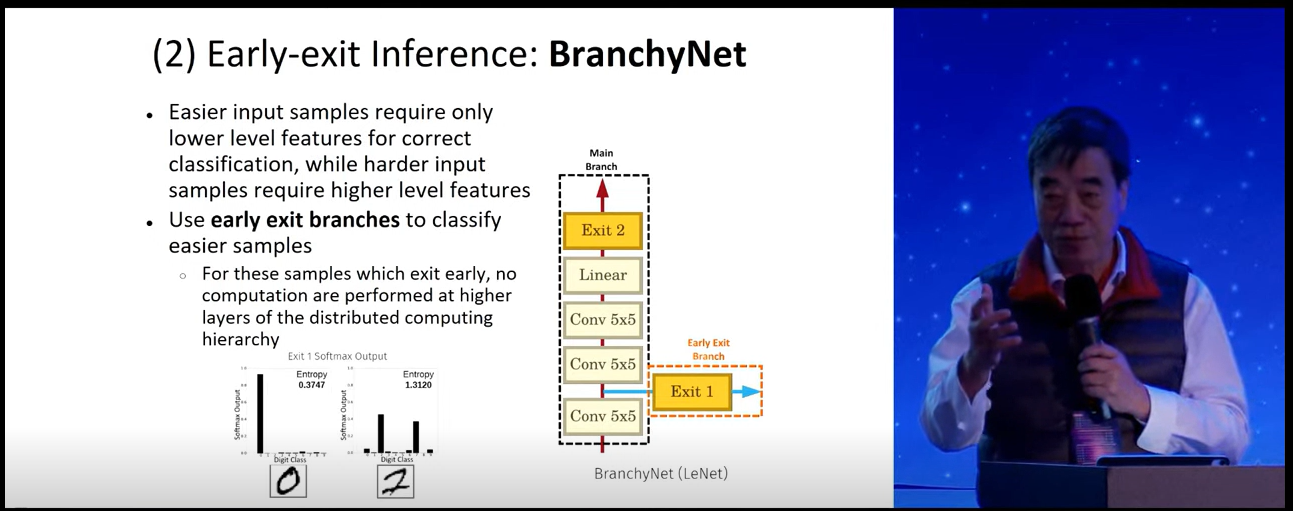

長年鑽研AI的中研院院士暨哈佛大學電腦科學與電子工程教授孔祥重日前出席Galaxy Summit 2022指出,AI將繼續朝分散式方向發展,目前除了分散式聯合學習(Federated learning)方法,和分散式的GPU算力網路來協助訓練超大AI模型外,他與哈佛實驗室團隊也提出不少創新嘗試,比如利用Early Exit方法,讓AI預測時,不必每層類神經網路都得運算,來降低延遲,又或是將AI模型模組化,來提高重複使用率。甚至,他認為,AI模型中的模組,未來也會放置於區塊鏈上來交易。

AI資訊洪流中找角度,將AI視為分散式系統

孔祥重回顧目前AI發展,光是2019年,就產出12萬篇同儕評閱過的AI論文。數量之多,一般人就算只閱讀其中的5%,1天就要看上16篇。為了跟上AI進展、不在資訊洪流中迷失,孔祥重說:「我們必須找出角度,」而他的角度,就是分散式系統。

這個分散式系統,可分為幾個層面。以運算來說,分散式運算是AI系統擴展的主流做法,比如分散式資料庫交易、雲端運算,或是單純的雲端文件編輯,可由不同位置的使用者更改,這些都是分散式運算實踐。作為主流運算典範的AI系統,也勢必會朝分散式系統繼續發展。

分散式AI系統:分散式運算網路、聯合學習方法

AI圈目前也有不少分散式做法,比如最常見的分散式運算網路,透過連結各處的GPU來提供算力,訓練超大型AI模型。另一種分散式做法則是聯合學習,透過集結不同參與者、共享模型而非共享資料,集眾人之力來訓練一套AI模型。

聯合學習不只能用於不同參與者,也可用於大量的分散式裝置訓練,比如,Google就用來優化數以萬計Android手機的Gboard鍵盤選字推薦模型。

然而,孔祥重點出,分散式AI系統仍有些挑戰待克服,像是用於模型訓練和推論的算力應再減少、推論的延遲性應該降低,而且,如何適當處理不同參與者的資料分佈(Non-IID),也是聯合學習中常見的挑戰。

此外,「模型如何分享、再利用,也是一大課題,」孔祥重點出,模型的再利用應該要更容易,才能讓分散式AI更有效率,而非各自閉門造車。

哈佛實驗室最新研究:模型模組化、利用區塊鏈交易AI模組

針對這些挑戰,孔祥重也帶領哈佛實驗室團隊,做了不少嘗試。比如,他們研究專用ASIC加速晶片,也研究Early Exit方法(如下圖),讓類神經網路運算時,不必每一層都執行,就能提早給出預測結果,來降低延遲。舉例來說,在手寫數字辨識上,0非常好辨認,這類簡單的輸入值,不需執行所有類神經網路層運算,就能得出答案。

不只如此,他們也研究頭戴式裝置的分散式AI運算(如下圖),比如讓裝置上每個鏡頭,能自行進行簡單的運算,較複雜的綜合運算,則交由裝置後方的晶片來運算。而運算資源,也可分為雲端、邊緣端和本地端來進行運算。「比較難的是運算資源的切法,」他補充。

.png)

今年,他們更嘗試打造模組化的類神經網路StitchNet,將預訓練過的模型元件組裝起來,成為一個可行的模型,不需大量資料、也不必再多做訓練,就能執行任務。

最後,他還點出,AI模型中的模組,還能放到區塊鏈上。2019年時,他與實驗室團隊發表一篇論文,說明如何用分散式的AI模型網路DaiMoN,來證明模型準確率,以及經同儕評閱、模型改進的準確率。而最近,孔祥重與實驗室團隊就在研究,不僅要將AI模組放到區塊鏈上,讓AI模組更容易重新利用,能組裝成大小不一的模型外,還能拿來交易。

這就好比,數位內容以NFT形式在區塊鏈上販售。「讓AI模組在區塊鏈上進行商業交易,現在說來雖然有點遠,但遲早會走到這一步,」孔祥重說。

熱門新聞

2026-02-09

2026-02-06

2026-02-09

2026-02-09

2026-02-09

2026-02-06

2026-02-09