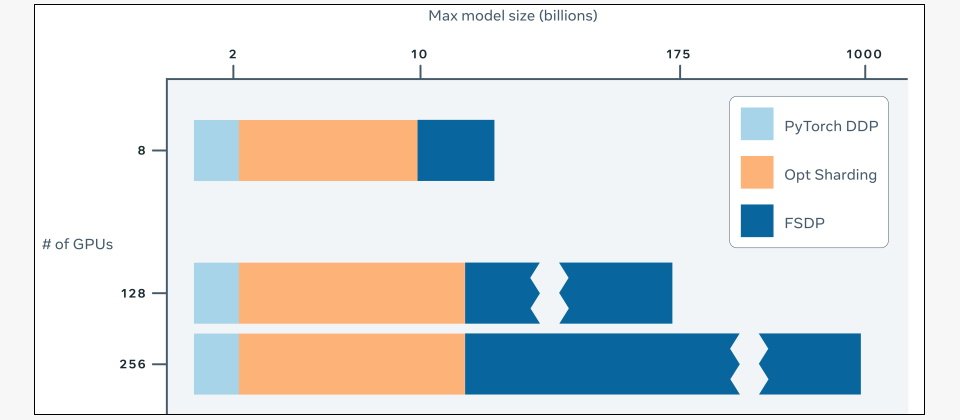

Meta OPT-175B語言模型所使用的參數數量,與OpenAI號稱全球最強大語言模型GPT-3一樣多,不過,Meta強調它們只使用了16個Nvidia的V100 GPU就完成該模型的訓練與部署,結合了Meta所開源的Fully Sharded Data Parallel(FSDP)API(如上圖所示)與Nvidia Megatron-LM中的張量並行提取,所產生的碳足跡只有GPT-3的1/7。(圖片來源/Meta)

Meta的AI實驗室於本周二(5/3)釋出了具備1,750億個參數的Open Pretrained Transformer(OPT-175B)的語言模型,此一模型採用非商業式授權,免費開放給學術研究人員,政府與公民社會相關單位,以及全球的產業研究實驗室使用,目的是為了讓缺乏經費的研究人員能夠一窺大型語言模型的奧妙,並協助改善它可能產生的偏見或危害。

這類超過1,000億參數的大型語言模型能夠產生文字段落,還能模仿人類的對話,已經成為近年來最熱門的人工智慧主題,不過它們也有缺陷,可能從藉以訓練的公開資料集中學到不實資訊、偏見或是有害的語言。

不過,外界或研究人員若要與這些大型語言模型互動,必須使用付費API才能進行,要完整研究一個大型語言模型通常只侷限於少數擁有豐富資源的實驗室,使得研究人員無法深入了解相關語言模型的運作模式,而無從改善語言模型的健全性,或減少對人類社會可能帶來的危害。

為了讓更多的研究社群得以參與最新的AI技術,Meta AI實驗室不僅釋出了OPT-175B,也公布用來訓練及使用模型的程式碼,並針對與規模相關的研究,提供採用同樣設定但不同規模的語言模型,這些語言模型所使用的參數數量從1.25億、3.5億、27億、67億、130億、300億到660億不等。

OPT-175B語言模型所使用的參數數量,與號稱全球最強大語言模型的OpenAI GPT-3一樣多,不過,Meta強調它們只使用了16個Nvidia的V100 GPU就完成該模型的訓練與部署,結合了該公司所開源的Fully Sharded Data Parallel(FSDP)API與Nvidia Megatron-LM中的張量並行提取,所產生的碳足跡只有GPT-3的1/7。

熱門新聞

2026-02-11

2026-02-11

2026-02-12

2026-02-09

2026-02-10

2026-02-10

2026-02-06