Google宣布在其Kubernetes服務GKE中加入Cloud TPU支援,也就是說現在用戶可以在GKE中,使用TPU處理大規模人工智慧負載,可選用的型號包括Cloud TPU v4或是最新的Cloud TPU v5e。GKE也提供了許多實用工具,供用戶更好地運用TPU執行機器學習模型,以及進行日誌記錄、監控與自動配置等任務。

Cloud TPU是Google設計專門用於機器學習工作負載的硬體加速器,其特別設計的晶片,可以加速模型運算,像是大型語言模型、Vision Transformer模型或是其他擴散生成模型。用戶過去要使用Cloud TPU大規模處理人工智慧工作負載,需要自己手動操作繁瑣的程序。

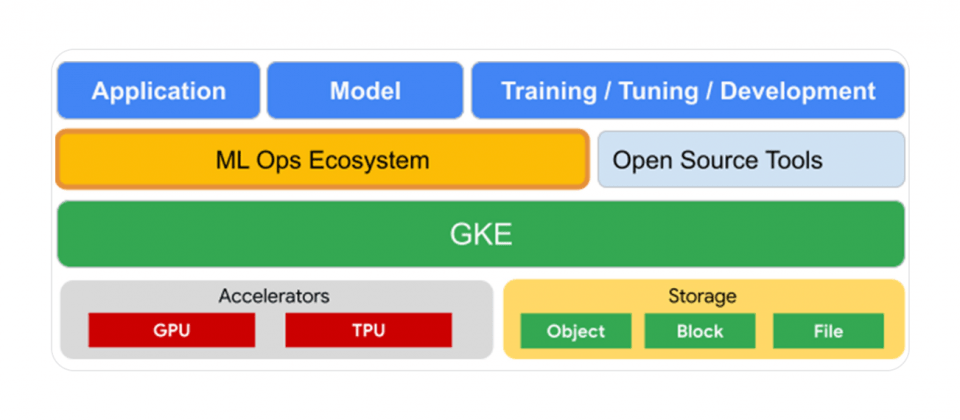

透過在GKE提供Cloud TPU支援,用戶不只可以使用GPU加速模型運算,現在還可以選用TPU,並且在GKE一致的操作環境中,執行各種類型的工作負載,並且獲得自動擴展、自動配置、自動修復和自動升級等一系列自動化功能,降低營運負擔。

Cloud TPU節點池可以自動配置並擴展,簡化用戶調度工作,Cloud TPU上的水平擴展能力極高,透過新的Multislice技術,用戶可以在單次訓練中使用數萬個晶片,更快速且大規模地訓練模型。

官方特別強調,Cloud TPU高效擴展的能力,能夠在增加資源的同時,獲得幾乎等比例的加速,有效率地執行工作負載。另外,Google還推出JobSet API來抽象Multislice的操作,能夠對跨數千個TPU晶片的工作負載,提供故障處理機制。

GKE用戶也可以透過Kueue等API在團隊中共享TPU資源,Google解釋,雖然用戶的工作負載仍透過Kubernetes調度,但是在Kueue中,用戶可以建立不同優先等級的工作負載,並且將空閒資源先分配給高優先等級的任務。此外,用戶只要啟用GKE系統指標,便可以在Cloud Monitoring查看Cloud TPU基礎設施指標,在Google雲端控制臺的GKE區塊,監控TPU資源使用。

熱門新聞

2026-02-06

2026-02-06

2026-02-06

2026-02-06

2026-02-09

2026-02-09

2026-02-09