奧義智慧

面對AI帶來的科技風險,企業憂心AI成為網路犯罪的催化劑之際,AI在資安防禦應用的重要性,也變得更加顯著。

事實上,關於AI在資安領域應用(AI for Security)的潛力,已是有目共睹。早在六七年前,資安業者就開始發展其應用,像是將AI/ML模型用於惡意程式偵測,隨著2023年底大型語言模型(LLM)興起,帶動了生成式AI發展,資安領域也將LLM用於理解惡意程式的意圖,提升資安監控、偵測與回應的處理,以及簡化資安產品查詢與操作。

到了2025年又有哪些重要進展?我們找來臺灣資安業者奧義智慧,該公司過去幾年經常強調AI資安的重要性,去年也舉辦首次AI資安年會,能夠提供更多具體的見解。

從CDM矩陣看AI如何幫助各種網路防禦工具

如何用AI幫助資安防禦?除了上述方式,最近世界經濟論壇(WEF)發表2025網路安全展望報告,當中列出多個場景,包括:提升威脅警報的分類與優先排序、異常行為偵測與模式辨識,也可以自動分類系統漏洞、加速漏洞修補、提升資料處理效率,以及強化系統配置管理。

由於這些AI應用涵蓋面向很廣,WEF並未深入解析,加上又有傳統AI與生成式AI的差異,因此我們想知道能否從產品或技術角度來審視?

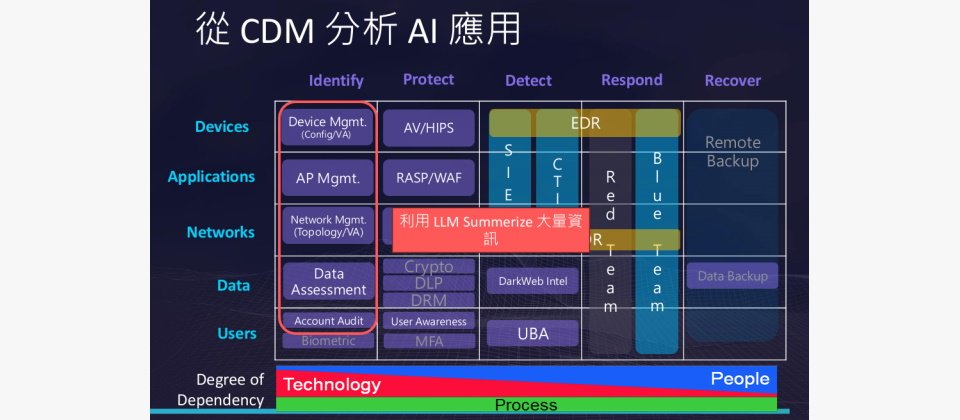

對於AI的各式資安應用發展,奧義智慧科技資安研究主任陳仲寬表示,先前他曾運用網路防禦矩陣CDM(Cyber Defense Matrix)的結構,以觀察不同資安產品工具的核心任務,是否可以運用AI來強化。

.jpg)

要檢視AI資安應用的態勢,透過網路防禦矩陣Cyber Defense Matrix(CDM)的呈現,可以幫助大家了解目前可運用的對策。奧義智慧科技資安研究主任陳仲寬指出,LLM的應用在識別面向的應用有很大助益,除此之外,在回應面向採用的相關解決方案,以及CTI情資、UBA使用者行為分析等,也將因為採用LLM而大幅提升成效。圖片來源/奧義智慧

簡單來說,基於保護的解決方式,很早開始利用傳統AI來強化其核心任務,如今LLM、生成式AI的出現,在識別、回應的解決方案核心任務中,將能帶來很大的幫助。不過這只是大致的分類,中間還有許多細節差異,接下來我們將一一探究。

保護(Protect)

根據陳仲寬的觀察,以保護的層面而言,包括裝置端的防毒、應用程式端的WAF,以及網路端的防火牆,早已開始導入傳統AI演算法,也就是利用特徵(feature-based),以及神經網路(Neural Network)建立偵測模型。

值得留意的是,在保護與偵測中的使用者端行為偵測,雖然現在多是利用異常偵測(Anomaly Detection),以及神經網路的方式,以強化這些異常行為的偵測,不過,陳仲寬認為,未來這方面很有機會再搭配運用生成式AI,做到進一步的能力強化。

識別(Identify)

在識別的層面,生成式AI的資安應用相對較多。主要原因是這類任務涉及大量資料的處理與盤點,因此將能幫助有效總結並分析海量資訊,現在已經有這方面的應用跡象,他相當看好這個領域的應用發展。

回應(Respond)

在回應的層面,適合使用生成式AI的場景也不少,包括:端點偵測及回應(EDR)、藍隊(Blue Team)、安全資訊與事件管理(SIEM)。基本上,只要涉及文字資料較多或Log類型資訊,都可以進一步帶來幫助。

偵測(Detect)

至於偵測的層面,雖然多是運用AI/ML機器學習技術,因為更具精準性,不過陳仲寬特別談到威脅情資(CTI)的應用範疇,可以運用LLM。

用LLM解決威脅情資的問題

關於威脅情資的應用面向,奧義智慧科技創辦人邱銘彰深有所感,他表示,普遍而言,大家對於「情資」一詞可能會有兩種不同的想像:一種是以故事描述給人看的分析報告,另一種則是具體的威脅指標。

他特別強調,產生報告、理解報告是LLM目前最大的優勢之一,這兩項是資安產業過去需要花很多時間做的事,如今,可節省這方面的人力成本,並且讓客製化變得更容易。

邱銘彰舉例,當資安業者向客戶提供資安報告時,由於不同企業和角色關注的重點各異,常常需要準備多個章節來滿足需求,像是A角色主要關注某個章節內容,B角色重視其他章節內容。

有了LLM加持之後,現在資安報告的呈現方式,可以有很大的轉變,例如,只要提供一個精簡的報告內容與聊天互動介面,就可以讓用戶透過提問的方式,更精準獲取其角色所需要的資訊。

對此,陳仲寬也提到另一應用場景,是將非結構化文字(Free Text)轉換為結構化格式。他解釋,由於很多資安研究報告的呈現方式,是以提供人員閱讀的形式為主,但沒提供業界公認為情資標準的STIX資料格式,此時,若是能夠運用LLM來轉化這些內容,可以加快很多流程。

這主要也是因為,現今情資來源相當廣泛,不論是研究報告、部落格發表、會議發表,或是社群平臺,因此不只是IoC入侵偵測指標,還有許多有價值的資訊,像是惡意程式、威脅組織、TTP等,但需要花費大量人力時間來整理。

另外,其實還有很多工作環節也可以用LLM、生成式AI帶來助益,像是用於建立規則,對於資安管理設定的工作,還有像是資安教育訓練、培育新人出考題等,也都可以用AI去做。

用AI找出未知產品漏洞,促進軟體開發安全

另一AI資安的重要焦點,在於漏洞挖掘方面的應用。過去模糊測試(Fuzz)已經帶來很大幫助,但如何進一步應用AI找出連模糊測試也無法發現的漏洞,也是一大課題,近期我們已經看到相關進展。

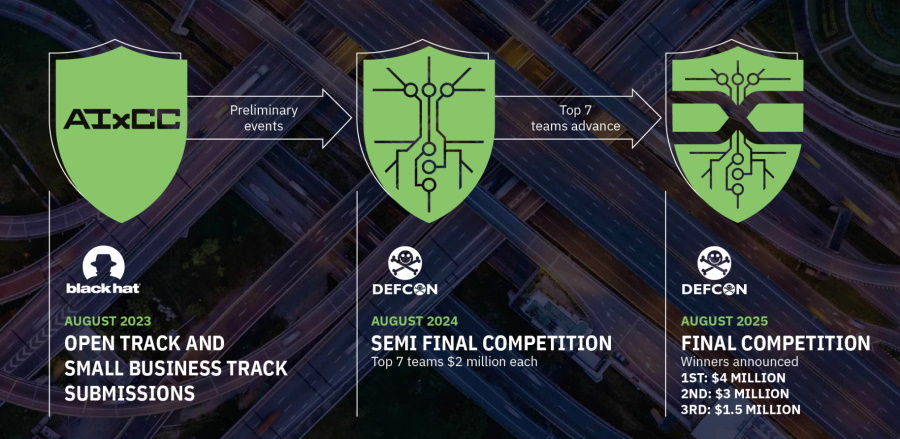

例如,美國白宮在2023年發起為期2年的AI Cyber Challenge(AIxCC),目的是透過AI來發現及修復軟體漏洞,3個月前(2024年11月),Google也揭露AI抓漏專案Big Sleep,並公開該計畫已實際找出首個未知記憶體漏洞。

美國白宮在2023年美國黑帽大會期間宣布,將由DARPA主辦名為AI Cyber Challenge(AIxCC)的競賽,活動目的聚焦於透過AI來發現及修復軟體漏洞,並祭出1,850萬美元的獎金,這項活動進行為期兩年,預計在今年2025年DEFCON大會上進行總決賽。

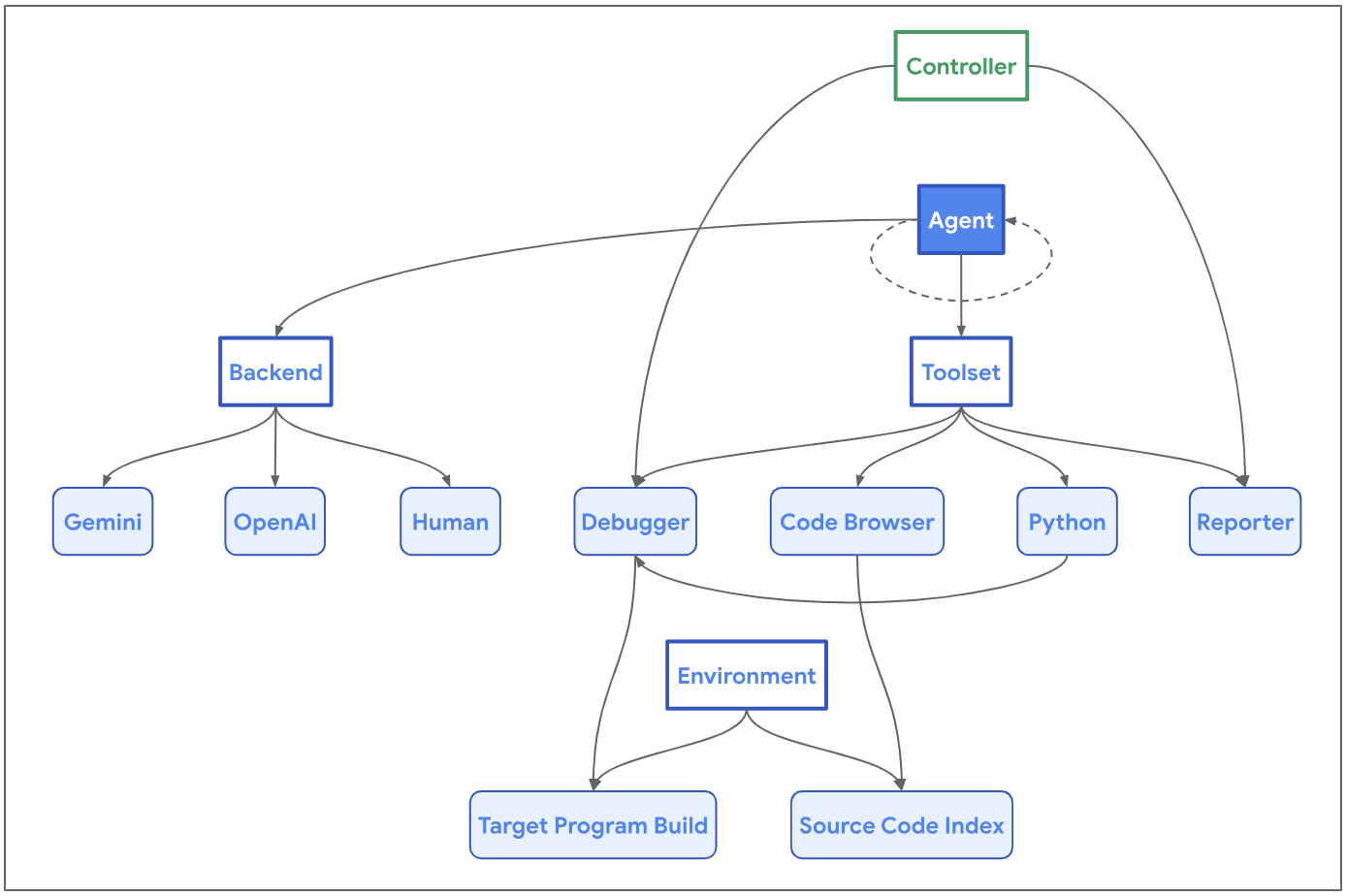

將大型語言模型(LLM)應用至真實世界的漏洞發現工作,Big Sleep是一例,這是由Google Project Zero與DeepMind合作的成果,並採用Project Zero發展的AI框架Naptime(如圖)。圖片來源/Google

對此議題,邱銘彰表示,LLM分為「知識模型」與「推理模型」,現在的LLM推理模型越來越強,並且擅長分析程式碼,他並認為,LLM雖然不能幫助直接找到漏洞,但能夠幫助做到縮小範圍,這將是可以運用的強項。

由於這幾年GitHub也推出Copilot,以及加入AI漏洞過濾功能,可幫助減少程式碼錯誤和漏洞,以及偵測程式碼中存在漏洞的寫法,改變開發人員處理漏洞的方法。

因此我們也好奇,這樣的應用是否能融入安全軟體開發生命週期(SSDLC)的範疇?邱銘彰認為,在程式碼審核(Code Review)的工作上,會帶來很大的助益。

他們推測,應該已經有很多人在這麼做,無論是用AI幫助程式碼審核,以及發現未知的潛在漏洞。雖然他們並未對這方面進行調查,不確定目前是處於研究階段,或者產品化階段,但仍認為這的確是相當適合的場景。

此外,在幫助SSDLC階段找出潛藏未知漏洞之餘,外部參與漏洞懸賞計畫的資安研究人員,同樣也能試著用AI輔助,以便找出更多資安漏洞。

虛擬資安長、AI代理的概念發展,開始備受關注

2024年還有一些新的AI資安議題,值得我們持續關注其發展,例如WEF提到兩個主題,一是AI資安長(AI-CISO)或虛擬資安長(Virtual CISO),一是AI代理(AI Agent)的發展。

以虛擬資安長的概念而言,從目前資安界的設想來看,並非完全取代人類資安長的角色,而是透過AI技術,幫助企業在有限資源下提升資安管理效率。

陳仲寬認為,雖然AI資安長、虛擬資安長的名稱很吸睛,但以資安長小助手來稱呼,或許更適合。原因在於,現在的生成式AI很擅長歸納,因此可以幫忙資安長整理情資、歸納現況。

此外,由於企業與組織普遍面臨資安人力缺乏,資安長的技能也有落差。因此,邱明彰提到一個有趣的應用場景有可能出現:現在一些公司資安長可能受到指派而擔任,許多專業領域知識不是那麼了解,但又不好意思問下面的人,因為怕這件事傳出去,此時可詢問AI,因為AI也不會到處跟別人講。

總體而言,由於臺灣中小企業相當多,這方面的發展確實令人引頸期盼,能提供更多類似顧問、小助手的能力,來幫助資安長摸索與成長。

但邱明彰也強調,現階段AI在外部的資料整理工作,可以有所幫助,但如果是公司內部情報整合的內容,由於內部資料都須考量隱私、安全等因素,現階段可能還沒辦法這麼做。

但我們可以想見的是,隨著2025年初DeepSeek模型的爆紅,帶來的最重大意義是加速全球小型LLM的演進,未來企業若都有內化的LLM來處理內部資料,並且做好相關風險防範,屆時將會有不一樣的局面,值得期待。

此外,現階段資安長可能還不敢將內部資料送到Open AI等外部服務,但這些服務如果也開始因應需求、提供更具有私密使用的方案,也同樣會讓應用變得更廣。

過去一年來,AI代理(AI Agent)成為AI領域的熱門發展焦點,不只多個專業領域看重其發展,資安領域也不例外。基本上,AI代理是一種能夠自主感知環境、與使用者或其他系統溝通,並執行任務來達成目標的系統。

陳仲寬指出,目前業界還沒有定義必須具備那些功能才能稱為AI Agent,但是,關於在資安領域應用AI Agent的概念上,這種做法與現行的「安全協調、自動化和應變(SOAR)」有點相像,它們都是強調自動化作業、快速應對資安威脅,但SOAR主要聚焦資安維運,且核心技術與適應能力也不太一樣。

對於AI代理目前的發展態勢,陳仲寬認為,在第一階段,可能大家已經開始嘗試與使用,像是很多員工為了加速個人工作,可能會用AI來串接流程,因此,這時AI對於產業的貢獻可能是隱形。而到了第二階段,才會應用於資安產品之內,像是資安廠商會將這些工作內化到自己產品中。

較特別的是,WEF還提到將LLM與密罐(Honey Pot)技術予以整合,這代表一種全新的欺敵技術將會出現。

對此陳仲寬有不同觀察。他可以想像,若LLM用於建立更擬真的環境,應該有幫助,但這些年來Honey Pot早已不是主流,兩者結合後是否真有更多效益,仍有待觀察。邱銘彰更認為,用AI可以模擬更真實的世界,但擬真成本太高,或許可用更簡單的方式達到目的。

AI新興科技帶來新的風險,發展對應解決方案也成必需

不只是上述種種AI For Security的議題,AI資安其實還有Security For AI的議題,同樣需要我們關注。也就是說,在既有資安產品透過AI來強化其能力之外,對應AI衍生的新興風險,也需要新的資安解決方案來應對。

例如,LLM技術導致Deepfake技術更進化,因此我們在2024年也看到資安市場開始出現對應之道,如今號稱能夠偵測Deepfake威脅的技術,已經被廠商實做出來了,陸續進入商用化的產品。

還有為了保護LLM不被濫用與受到攻擊,許多國際資安大廠陸續推出AI護欄(AI Guardrails)、AI防火牆(Firewall for AI),或是AI網路閘道(AI Gateway)的資安產品。

儘管各家定義不同,其功能也有差異。例如,普遍能夠提供防範提示詞注入(Prompt Injection)、模型DoS,以及敏感資訊洩漏的攻擊,還有不只可阻擋外對內的攻擊,也能阻擋內對外的洩漏,防範有意或意外造成的結果。

甚至也有對應影子AI問題,偵測企業中是否有人員使用未經授權的AI應用程式,又或是解決AI開發、部署的挑戰,可檢查AI模型的各種潛在安全問題。

對此發展態勢,陳仲寬指出,他們在2024年RSA大會的創新沙盒競賽中,就觀察到有許多國際新創公司,聚焦在AI模型生態系的安全,但臺灣目前比較少有這方面的發展,他認為,我們也應該有這方面的產品研究。

熱門新聞

2026-02-11

2026-02-09

2026-02-11

2026-02-10

2026-02-10

2026-02-06

2026-02-10

2026-02-10