OpenAI、Google等生成式AI業者擷取網路上圖片訓練AI模型引發創作者不滿。有研究人員發展出一個名為Nightshade的工具,可擾亂AI業者的底層模型,而且很難發現。

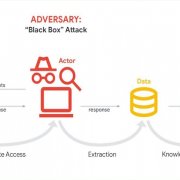

現有一些對文字轉圖片的生成式AI模型的攻擊法,像是後門攻擊法是在提示中加入一些觸發字,使之生成特定圖案,但仍假設攻擊者可改變模型的降噪步驟或變更損失函數。

但一群芝加哥大學研究人員發展出的Nightshade,是一種專從提示發動的下毒攻擊手法,手法更簡單,也不需介入模型的訓練或部署等流程。他們主要是稍稍變更圖片,像變造狗圖片(如擬人化的狗),當這些「含毒」圖文成為訓練資料集,就可能擾亂AI模型。研究人員並選擇攻擊從頭打造的模型,以及知名模型如Stability AI的Stable Diffusion V2、SDXL及DeepFloyd驗證其攻擊效果。

測試顯示,只要很少的有毒樣本就能擾亂AI模型。例如不到100個變造過的「狗」圖片,即可污染SDXL模型的「狗」的概念,使其在接受「狗」的提示輸入時產出貓的圖片。而且Nightshade攻擊還會有「出血」(bleed-through)效果,即原本攻擊者只擾亂一種概念,如「幻想藝術」,但會漸漸影響AI模型對「龍」以及以幻想藝術知名的畫家「Michael Whelan」的生成結果。

此外,這些圖片變造的資料集是很難防範,因為它影響的是訓練資料集的特徵空間,人無法察覺,人眼覺得正常的圖片,其實會「教壞」AI模型。而且攻擊效果是累積性。研究人員還發現,對單一模型攻擊多次,例如對SDXL發動250次Nightshade攻擊,就能毁壞SDXL的圖片生成功能。

研究人員表示,Nightshade是給內容創作者及持有者對抗不尊重版權聲明、或故意繞過do-not-scrape/crawl opt-out的AI業者的強大武器。

一些生成式AI業者也有自我約束作法,像是OpenAI公布爬蟲,允許網站業者阻擋。不過在有效方法出現前,像BBC主流媒體則直接拒絕這些業者的爬蟲。

熱門新聞

2026-02-13

2026-02-13

2026-02-13

2026-02-13

2026-02-13

2026-02-13

2026-02-13

![<a href="https://arxiv.org/abs/2310.13828">圖片引用自:arXiv:2310.13828 [cs.CR]</a>](https://s4.itho.me/sites/default/files/styles/picture_size_large/public/field/image/1025-nightshade_attack-prompt-specific_poison_attack-tu_pian_yin_yong_zi_arxivwang_zhan_.jpg?itok=VQQaub6w)