若以單一CPU插槽的Emerald Rapids伺服器來舉例,英特爾資料中心平臺工程與架構事業群總經理Zane Ball表示,這種伺服器適合處理100億參數的模型推論任務,他強調,雖然執行更多參數的模型是有可能,但考慮到系統的效能, 100億個參數會是較為合理的數量。

攝影/余至浩

隨著生成式AI迅速崛起,企業開始思考未來資料中心設計,來因應生成式AI應用發展,甚至一些科技巨頭已經開始打造AI資料中心。例如臉書Meta正在打造下一代AI資料中心,該資料中心將具有液冷式人工智慧硬體,以及高效能人工智慧網路,將數千個MTIA人工智慧晶片連結在一起,以建立起資料中心規模的人工智慧訓練叢集,支援未來10年生成式人AI應用研究。

英特爾資料中心平臺工程與架構事業群總經理Zane Ball在近日的英特爾創新日會後一場媒體活動上表示,生成式AI的興起,對於資料中心帶來了重要變革之一,將加速企業資料中心對於液體冷卻(liquid cooling)技術的採用。

Zane Ball表示,執行生成式AI應用對於系統能耗負擔很大,因此需要新的硬體散熱機制。他認為,越來越多的企業將在新資料中心中導入液體冷卻技術,來協助伺服器系統的散熱,不僅是為了節省能源,還為了支援更高能耗的加速運算元件所需。他認為這有助於加速企業資料中心採用液體冷卻技術。

但他直言,要實現實用且易於部署的液體冷卻技術,需要產業間的合作,「雖然這需要時間,但這件事讓人感到興奮,也代表新機會。」他說。

不只是冷卻散熱機制的改變,未來伺服器硬體設計需要有新的變革。為了提升伺服器所能處理的推論模型參數,Zane Ball指出,未來將持續改進Xeon處理器在AI運算效能方面。他表示,過去英特爾已經取得了顯著的進步,例如與第三代Xeon處理器相比,第四代Xeon處理器的AI處理效能提升多達14倍。因此未來將持續發展能夠支援更大參數的模型、更高記憶體頻寬的伺服器系統,「這正是我們未來CPU發展的方向。」

英特爾將在12月14日推出代號為Emerald Rapids的第5代Xeon伺服器處理器,也是針對企業資料中心AI應用需求所設計,採用和前一代相同節點,但核心數達到64核,而且具備更快的記憶體傳輸速度。

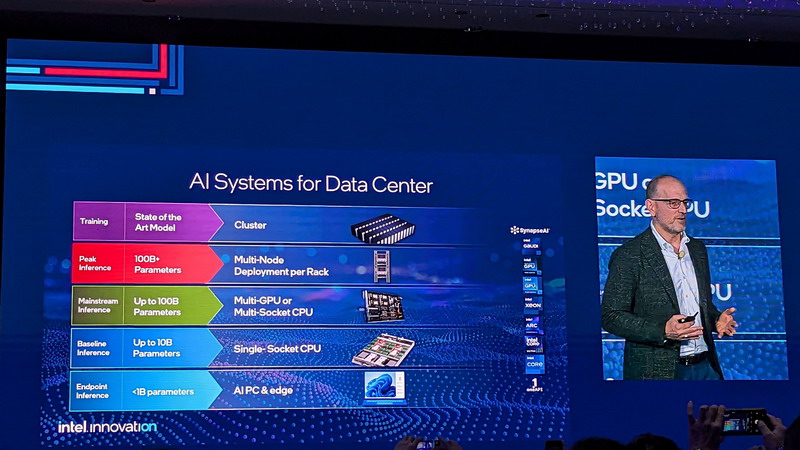

從英特爾對於資料中心AI系統的分類,也能夠反映出不同型態伺服器,能夠支援處理的推論模型參數的規模。

若以單一CPU插槽的Emerald Rapids伺服器來舉例,Zane Ball也表示,這種伺服器適合處理100億參數的模型推論任務,他強調,雖然執行更多參數的模型是有可能,但考慮到系統的效能, 100億個參數會是較為合理的數量。

熱門新聞

2026-02-06

2026-02-06

2026-02-06

2026-02-06

2026-02-09

2026-02-09

2026-02-09