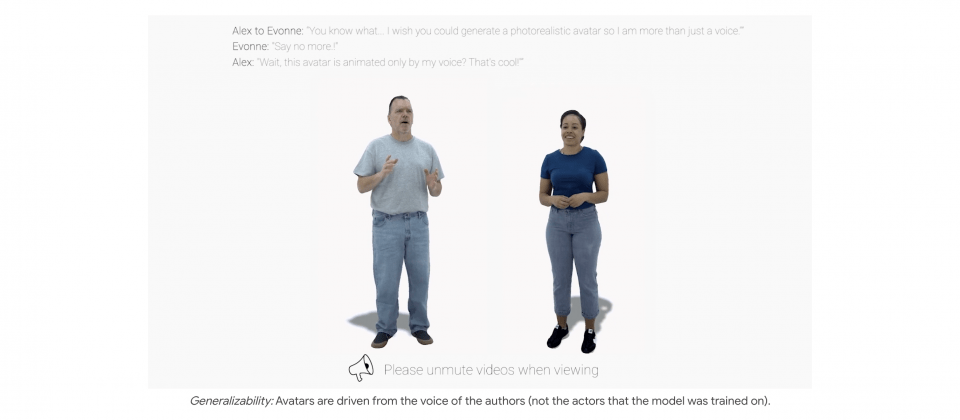

Meta新的人工智慧研究audio2photoreal技術框架,能夠根據對話語音,生成相對應逼真的臉部、身體和手勢。研究人員開發audio2photoreal框架的目的,是用於創建真實的虛擬人物,並讓這些虛擬人物能夠根據人們說話的內容和方式,做出各種自然的手勢和表情。

Audio2photoreal研究的主要貢獻,在於結合向量量化(Vector Quantization)技術以及擴散(Diffusion)演算法,生成動態和更具表現力的動作。向量量化在這個研究扮演的角色,是提供手勢動作的樣本多樣性,簡單來說,向量量化是一種將大量資料壓縮成較少量代表性資料的技術,而用在audio2photoreal上,則可以有效地從大量手勢動作中,選出具代表性的樣本。

而擴散技術的作用,則是能夠提供高頻率細節和改善手勢動作品質。擴散技術通常用於生成和改善圖像與影片,特別是需要恢復細節,或是增加視覺真實感的場景中,當應用在虛擬人物手勢生成的過程,擴散技術可以讓手勢更自然流暢,使其更接近真實人類的動作。

研究人員還在這個研究創建了一個多視角雙人對話資料集,裡面收錄從不同角度拍攝的對話場景,讓audio2photoreal能夠更好地製作虛擬人物。

而經過實驗驗證,audio2photoreal在生成合適且多樣化的手勢上,明顯比僅仰賴擴散或是向量量化的方法還要好,此外,相較於傳統網格模型,audio2photoreal生成高度真實的虛擬人物,在準確捕捉對話手勢動作的細節上,像是模擬用手指點、手腕快速轉動或是聳肩等動作,表現得更加自然真實。研究團隊現在公開相關程式碼和資料集,以促進相關研究領域發展。

熱門新聞

2026-02-11

2026-02-11

2026-02-09

2026-02-10

2026-02-10

2026-02-06

2026-02-10

2026-02-10