自從ChatGPT從2023年橫空出世以來,這種一問一答的方式,展現出「類人類」的互動模式,也讓背後的生成式AI模型成為各界關注的熱門議題。

當AI變得越來越聰明的時候,有許多人也開始擔心,未來人類應該如何面對這麼聰明的AI。

甚至於,也有不少調研預測機構開始在觀察,想了解在未來社會中,究竟會有多少人類社會存在的工作,將可能會進一步被AI所取代。

臺灣KPMG安侯企管顧問執行副總經理林大馗表示,回顧2023年,生成式AI對於人類社會帶來了重大衝擊,我們也必須正視並體認到:AI已經是進入2024年後,不管是企業或組織,甚至是個人,都無法被忽視的重要議題。

他也表示,當企業營運開始思考未來各種AI發展和應用,以及使用AI提供新產品和服務的同時,必須意識到,包括駭客和各種網路犯罪集團在內,也在使用AI來提高其攻擊入侵和詐騙成功率。

因此,隨著AI應用越來越普及,林大馗則點出,AI本身面臨的7種資安風險,並從四步驟拆解AI攻擊鏈,強調AI在某些最新的、專業領域的應用上,仍有其侷限;而AI如今也成為駭客詐騙、偽冒身分利器時,也成為企業和一般民眾必須留意的風險。

AI在暗黑情境的應用日漸廣泛,資安風險也與日俱增

「AI對人類帶來的威脅,其實比氣候變遷更為急迫,」林大馗特別引述深度學習泰斗、神經網路之父Geoffrey Hinton的觀點指出,人類已經找出減碳的路徑或方向,只要去落實,情況可能會好轉;但關於人工智慧的發展,大家目前根本「置身迷途」。

其實,特斯拉執行長馬斯克在2018年3月,就已提出「AI比核彈還要來的危險」的觀點;美國國會在2023年舉辦人工智慧影響的公聽會,聯邦參議員霍利(Josh Hawley)也警告:「生成式AI的規模宛如網際網路的全球布局,可能釀成類似原子彈的巨大災禍」。

甚至,ChatGPT推手OpenAI的CEO阿特曼(Sam Altman)也表示,生成式AI的出現好比「印刷機發明」,雖然能夠改善和創造工作,但他對AI可能對世界帶來的危害,更是深感憂心。

因此,林大馗也觀察到,隨著AI應用越來越普遍,不僅開始有一些暗黑情境的AI應用,甚至還帶來相關的危機。

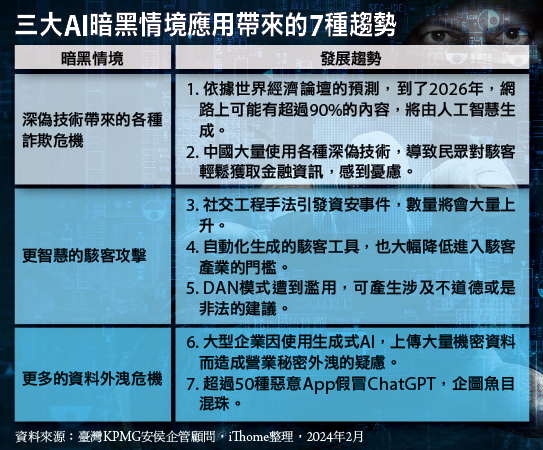

他說,目前AI的暗黑應用可從三個主要方向來看,包括:深偽(Deepfake)詐欺技術的使用、更有智慧的駭客攻擊,以及更多企業機敏資料外洩的風險。

他指出,暗黑的情境也帶來危機,在深偽技術帶來的各種詐欺危機的暗黑情境應用,可以發現兩大發展趨勢。

首先,依據世界經濟論壇(WEF)的預測,到了2026年,網路上可能有90%以上的內容將由人工智慧生成。

舉例而言,在2023年4月,中國甘肅省網路警察發現搜尋引擎百度出現經查證後確認為虛假消息的新聞,內容聲稱:「甘肅省有一列火車撞到修路工人而導致9起死亡事故。」而這個由AI生成的假新聞,在同一時段,就有21個帳號發布相同文章,更達到1.5萬餘次的瀏覽量。

其次,中國大量使用深偽技術,也增加民眾對駭客能夠輕鬆獲取金融資訊的憂慮。

根據一篇2023年5月的報導指稱,駭客使用先進的人工智慧軟體,說服中國北方的一名男子將錢轉給他的朋友,實際上,該筆金錢卻轉到一個詐欺帳戶。

在駭客攻擊越來越智慧化的暗黑情境應用中,林大馗也觀察到三大發展趨勢。

首先,社交工程手法引發的資安事件會大量上升。例如,之前曾發生駭客偽造美國勞工部(DoL)的社交工程郵件,偽冒的網域以dol-gov[.]com取代正確的reply@dol[.]gov,藉此取得受駭者微軟365的憑證。

其次,因為自動化生成的駭客工具,也大幅降低進入駭客產業的門檻。

資安公司Forcepoint的資安研究員Aaron Mulgrew表示,完全沒有任何撰寫程式經驗的他,可用ChatGPT快速寫出國家級複雜程度的惡意軟體,因此,他擔心任何人其實都可以輕鬆用ChatGPT打造駭客武器。

第三,ChatGPT本身有個不受OpenAI設計準則規範、可自由發揮的DAN(Do Anything Now)模式,而這種模式一旦遭到濫用,就可以讓ChatGPT產出涉及不道德,或是非法的建議。

最後一個暗黑情境的AI應用,則會帶來更多機敏資料外洩的風險。

林大馗指出,許多大型企業因為使用生成式AI,而上傳大量機密資料,造成營業秘密外洩疑慮。

最知名的案例就是,2023年3月起,因韓國半導體公司三星電子允許員工使用ChatGPT,包括半導體設備測量資料、產品良率等內容,都被存入ChatGPT的資料庫中。

因此,這也讓許多企業因擔心公司的商業機密遭到外洩,便禁止員工在公司擁有的資訊設備當中,使用ChatGPT這類型的服務。

資安專家Dominic Alvieri也發現,單是Google Play Store軟體市集,假冒ChatGPT名義而推出的「ChatGPT Plus」服務,已經有超過50種惡意App,假冒ChatGPT,試圖魚目混珠,會在上當受騙的使用者裝置植入惡意程式。

解構AI引發的資安風險成因

因為各種新的AI應用,也讓資安成為重要議題。

林大馗表示,AI應用便引發資安攻擊手法的變革。原本的資安攻擊手法,例如:駭客會透過繞道潛伏的方式,滲透到企業內部,但當這些資安攻擊手法再加上AI後,就可以做到深度偽裝後、滲透企業內部,而不被察覺。

其他,像是以往的網路攻擊都是透過「知識」驅動,但加上AI後,就會變成是由「資料」驅動造成的網路攻擊。

另外,像是駭客原先就能藉由多點突襲的方式入侵企業,現在加上AI之後,就可以做到更精準地攻擊;甚至以往須透過專家創造才能完成的產品,當加入AI之後,就會成為某種「智慧製造」。

他認為,AI應用讓原本企業面臨的資安威脅瞬間升級,也變得更難以對應。

不過,AI不僅帶動各種網路攻擊手法發生質變,甚至於,AI本身也會面臨資安風險。

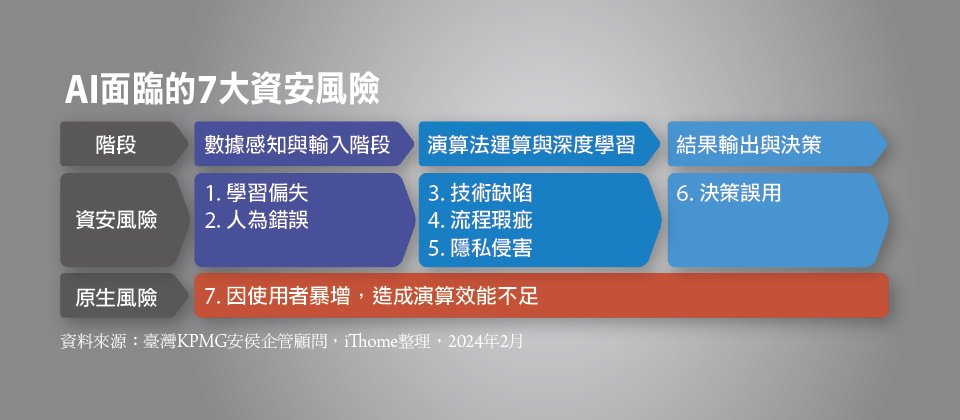

林大馗歸納出AI在不同階段預計要面對的7大風險成因,他分成:學習偏失、人為錯誤、技術缺陷、流程瑕疵、隱私侵害以及決策誤用等6大類;另外還可以加上第7種:因使用者暴增,而造成演算效能不足的原生風險。

學習偏失的主要原因是訓練數據的偏差,例如,使用了過時或不完整的訓練數據母體,或機器學習期的數據與實際情境不一致。

至於人為錯誤,則包含設計者或是使用者,對於演算法專業疏失,或其他人為道德與管理問題。

林大馗認為,不論學習偏失或是人為錯誤,最主要都是發生在數據感知,以及輸入階段所面臨到的資安風險。

他進一步表示,在演算法運算與深度學習階段,所面臨的資安風險有三大類型,分別是:技術缺陷、流程瑕疵,以及隱私侵害等。

其中,技術缺陷的資安風險,主要是設計者在演算法開發過程當中,因為缺乏對使用者情境與安全性的完整設計,以及測試,進而產生演算法錯誤(Bugs)。

至於流程瑕疵造成的資安風險,主要是因為使用者未瞭解演算法或是技術的限制,進而產生的過度依賴與誤用情境。

另一個常見的資安風險,則是因為演算結果濫用,導致侵犯當事人隱私權。

至於結果輸出階段與決策階段,林大馗表示,資安風險包括決策者對於分析結果的錯誤解讀或誤用造成的決策誤用,以及演算法運算與決策效率仍待提升,導致演算效能不足的風險。

從四個步驟拆解AI資安攻擊狙擊鏈

針對AI所面臨的各種資安風險,我們可以參考美國NIST所推出的MITRE ATLAS框架(Adversarial Threat Landscape for Artificial-Intelligence Systems),也能從MITRE的戰術、技術和程序(TTP),看出AI的確面臨前面提到的6大資安風險,包括學習偏失、人為錯誤、技術缺陷、流程瑕疵、隱私侵害,以及決策誤用等。

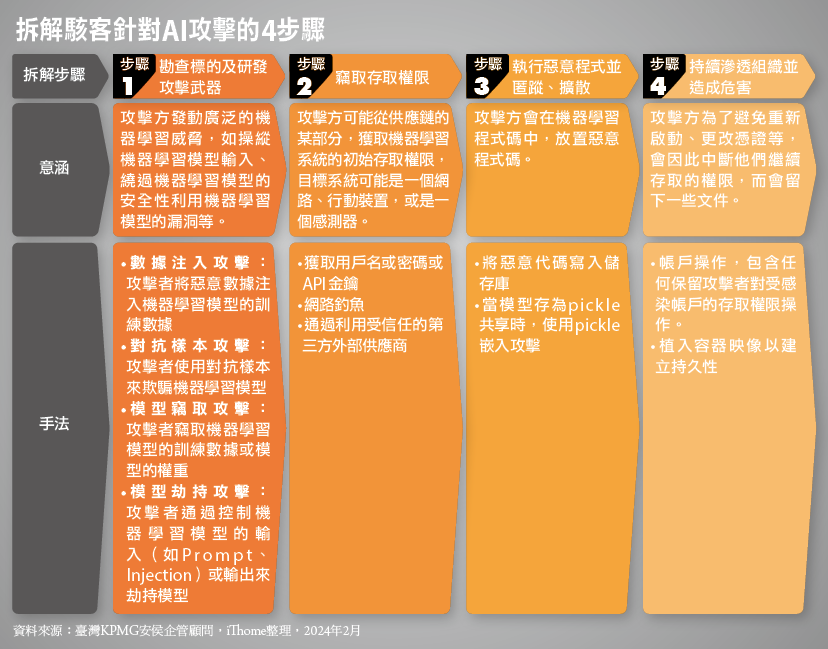

針對AI的資安攻擊狙擊鏈,我們可以進一步拆解針對AI的攻擊方法,可以拆解成下列主要步驟。

一、勘查標的,以及研發攻擊武器

二、竊取存取權限

三、執行惡意程式,並且匿蹤、擴散

四、持續滲透組織,並且造成危害

在第一個步驟中,駭客會勘查標的,以及研發攻擊武器。

林大馗指出,像駭客等攻擊方,會廣泛利用機器學習模型去了解與熟機各種威脅形式,例如,操縱機器學習模型的輸入、 學習如何繞過機器學習模型的安全性,並知道該如何利用機器學習模型的漏洞等。

如果再經過進一步的細分,我們可了解從哪些面向操控機器學習模型的輸入,例如分成下列模式:首先是數據注入攻擊,便是攻擊者將惡意數據注入機器學習模型的訓練數據。

第二是對抗樣本攻擊,由攻擊者使用對抗樣本,以此欺騙機器學習模型。

第三,則是模型竊取攻擊,攻擊者竊取機器學習模型的訓練數據或模型的權重。

最後,就是模型劫持攻擊,相關的攻擊者通過控制機器學習模型的輸入,例如Prompt(詠唱)、Injection(注入),或是輸出,以此劫持模型。

在這些機器學習模型當中,輸入錯誤資料之後,會改變最後的產出結果。

到了步驟二,則是竊取存取權限。

林大馗表示,攻擊方可能從供應鏈的某部分,獲取對機器學習系統的初始存取權限,鎖定攻擊的目標系統,可能是一個網路、行動裝置,或是一個感應器。

而在這個步驟當中,最重要的目的在於:獲取用戶名稱、密碼、API金鑰,或是藉由網路釣魚、通過利用受信任的第三方外部供應商,進入企業組織內部以獲取相關的存取權限。

接著是步驟三,重點在於:執行惡意程式並匿蹤、擴散。

也就是說,攻擊方會在機器學習程式碼中放惡意程式碼,例如,可以將惡意程式碼寫入儲存庫;或是當模型存為pickle共享時,便可以使用pickle嵌入攻擊(pickle是Python專屬的序列化∕反序列化模組,可用來儲存機器學習的模型)。

最後的步驟便是:持續滲透組織並造成危害。

林大馗表示,攻擊方為了避免重新啟動、更改憑據等作為,有可能會中斷他們繼續存取的權限,所以會留下一些文件,而這些文件包括:帳戶操作,也會包含任何保留攻擊者對受感染帳戶的存取權操作,甚至會藉由植入容器鏡像以建立持久性。

而在步驟四持續滲透的過程中,攻擊方也會透過下列三種方式,以便達到他們滲透到組織內部的目的。

對此,他進一步提出解釋。方式一是繞過防禦,畢竟攻擊方會想盡辦法避免「在整個入侵過程中被偵測到」的技術。

方式二則是攻擊方藉由滲透的方式,試圖竊取機器學習的產物,或取得有關機器學習系統的相關資訊。

林大馗指出,不論駭客是製作對抗性數據,以影響機器學習模型的結果,或是透過投毒方式使模型的性能變差,還是發起大量請求以癱瘓服務,或者是發送大量無關緊要數據,使組織花時間審查不正確的推論,甚至於是透過加密大量數據,以勒索金錢補償等方式,最終都會影響機器學習模型的正確性及效能。

ChatGPT目前仍難承擔專業責任

當大家驚艷ChatGPT的互動方式,後續開始察覺ChatGPT回覆的答案其實存在很多錯誤,甚至,後來發現ChatGPT執行的效率也變差了。

臺灣KPMG安侯企管顧問執行副總經理林大馗坦言,該如何讓「人工智慧」不要變成「人工誤會」,避免AI成為治理的陷阱,是大家在關注並應用AI時,必須注意的重點。

臺灣KPMG實測ChatGPT能否作為報稅顧問

為了印證生成式AI到底有多聰明,是否真的可以取代專業服務,林大馗表示,他們本身也特別以稅務專業的問題進行測試,驗證「以ChatGPT作為報稅顧問是否可行?」。

KPMG稅務服務部執業會計師張智揚實際以臺灣綜合所得稅申報作為情境測試,並將納稅人的家庭成員、撫養狀況、薪資收入、投資獲利等基本資料輸入ChatGPT,之後他們發現,ChatGPT的確能針對單純的個人情況,依據臺灣所得稅法回答出正確的免稅額及扣除額;不過,針對比較複雜的扶養親屬狀況,例如學齡前或七十歲以後的長輩等,ChatGPT提出的答案有誤。

若再進一步詢問深入且涉及需要判斷的問題,例如:應該如何申報最有利?或是夫妻應該要合併計稅或分開計稅、實際可列舉扣除項目、是否有其他特別扣除額、列舉扣除額等節稅建議,ChatGPT提供的建議不僅非常侷限,甚至出現錯誤的答案。

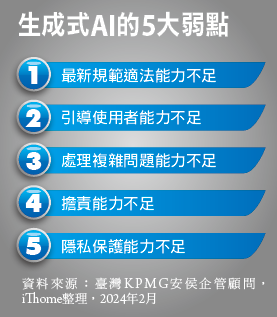

生成式AI還須克服五大弱點

林大馗根據他們實測的結果為例表示,目前看來,生成式AI要能提供真正專業顧問諮詢服務,例如稅務專業諮詢等,至少還需要克服五大弱點。

他表示,第一個存在的弱點就是對於最新規範適法能力不足,畢竟,生成式AI的訓練樣本並不是最新的資料,所以,只要是針對最新規定的詢問,例如:2023年臺灣綜合所得稅調高免稅額、標準扣除額、薪資與身心障礙特別扣除額、課稅級距,以及2023年新增的民眾協助烏克蘭難民,賑濟烏克蘭捐贈項目得以全額列報捐贈列舉扣除額等相關新規定,生成式AI的ChatGPT都無法正確處理。

再者,引導使用者的能力不足。他認為生成式AI需由使用者「完整提問」相關情境,以及背景資料後,才有機會提供正確答案,然而,一般使用者對稅務規則並不熟悉,往往無法提供完整資料或背景說明。

第三,經過實際測試發現,ChatGPT處理複雜問題的能力不足。林大馗表示,生成式AI僅能提供簡單稅務問題的基本建議,若遇到複雜的稅務情境,經過東拼西湊而產生錯誤答案的機率非常高。

第四個弱點是擔責能力不足。國外已有許多利用生成式AI開發的人工智慧稅務輔助系統,例如加拿大的TaxGPT.ca,但在聲明中即明確提到:TaxGPT.ca目的是提供友好和平易近人的方式,讓使用者開始學習稅務,並不是稅務計算器或專業稅務顧問,所以並無法承擔相關的稅務責任。也就是說,生成式AI提供的答案不管對錯都只是參考,也不需要承擔任何責任和義務。

最後一點,就是對於隱私的保護能力不足,林大馗表示,這也是大家最擔心的事情之一。因為報稅資料涉及許多個人隱私,雖然多數生成式AI都強調不會蒐集使用者的隱私,但實際上,有許多實驗證明,系統還是會「暗中記住」線上提問者的個資,而且,使用者也無法確認其資料保護的能力,因此仍存在高度隱私風險。

熱門新聞

2026-02-11

2026-02-11

2026-02-09

2026-02-10

2026-02-10

2026-02-06

2026-02-10

2026-02-10