建立在Meta首席人工智慧科學家Yann LeCun,所提出的人工智慧模型架構JEPA(Joint Embedding Predictive Architectures),Meta人工智慧研究團隊公開用於影片預測的非生成式人工智慧模型V-JEPA,透過預測影片中缺失或是被遮蔽的部分,來有效提升人工智慧對這個世界的理解。

Yann LeCun在2022年的時候提出JEPA架構,目標是要建立進階的機器智慧,讓人工智慧可以像人類一樣學習,建立起周圍世界的內在模型,以便學習、適應,並且有效地制定計畫,完成複雜的任務。所謂的內在模型,指得是人類或人工智慧,在大腦或是神經網路中所建構的心智表示,其反映出對於世界的理解或是知識。

人類透過觀察周遭世界學習許多知識,研究人員舉牛頓第三運動定理說明,即便是嬰兒(或是貓)在多次將物體從桌面推落並觀察結果之後,皆能直覺理解物體上升必會下降的道理,事實上,人們並不需要花費數個小時學習,閱讀大量的書籍才能得到這個結論。人們藉由觀察世界所建立的內在模型運作非常高效,能夠準確快速地預測這些事物的結果。

Meta在2023年的時候,運用JEPA架構開發電腦視覺模型I-JEPA(Image Joint Embedding Predictive Architecture),其特色在於能夠關注真正的圖像重點,而I-JEPA高效能的秘訣在於,能夠以更像人類理解抽象表示的方法,來預測缺失的資訊。而現在Meta進一步擴展JEPA架構,發展可以處理影片的V-JEPA,V即代表影片(Video)。

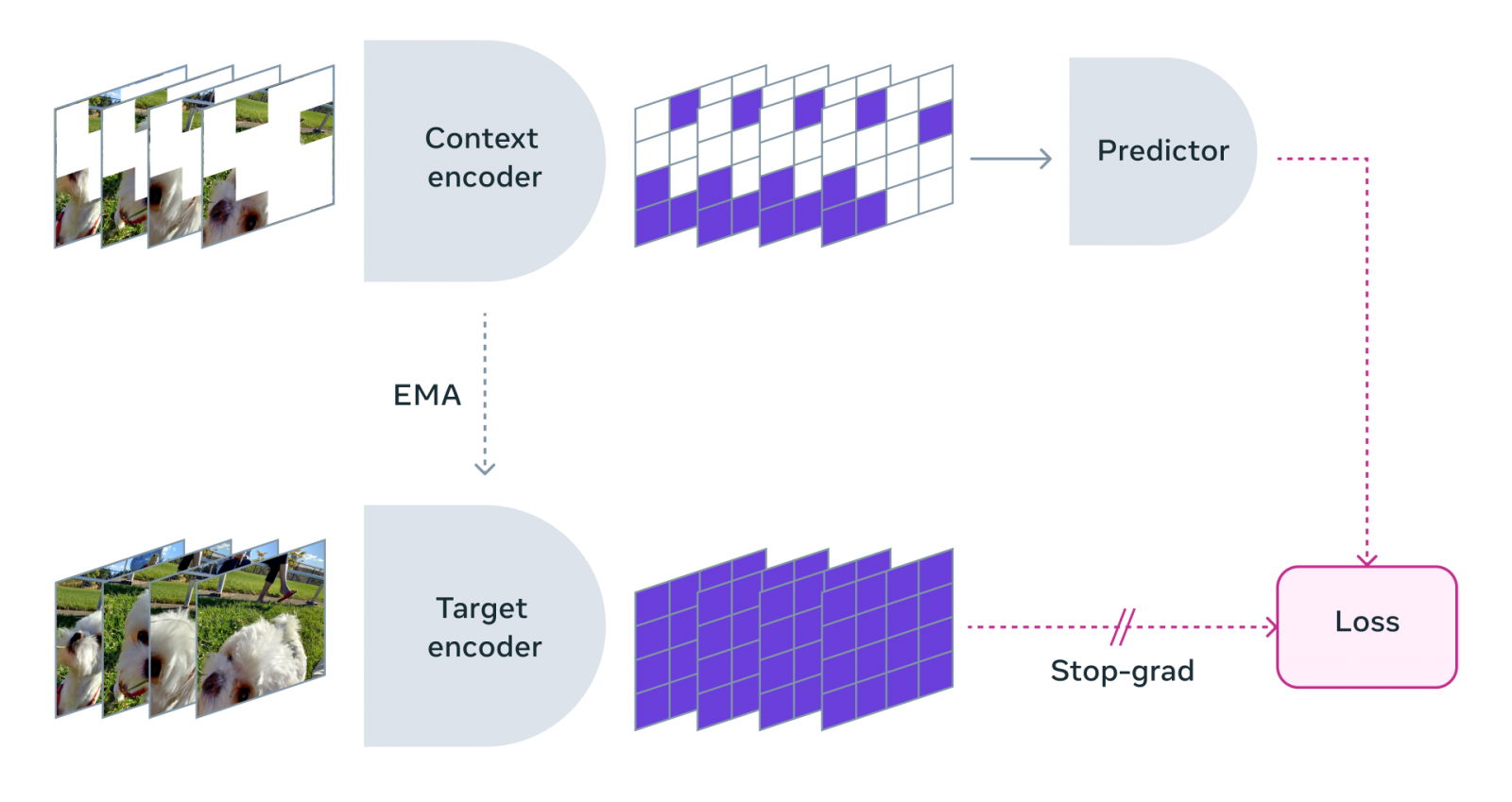

V-JEPA方法類似於I-JEPA,比較圖像的抽象表示而非直接比較畫素本身,V-JEPA與嘗試填充缺失畫素的生成式方法不同,V-JEPA有能力丟棄不可預測的資訊,這使得訓練和採樣效率可提升達1.5到6倍。V-JEPA採用自監督學習方法,使用未標記的資料進行預訓練,唯有於預訓練後,要讓模型適應特定任務的時候才會使用標籤。

研究人員訓練V-JEPA的方法,是讓模型觀看一系列的影片,使其能夠掌握世界運作的方式。這些影片會經過遮蔽處理(下圖),透過遮蔽大面積影片內容,要求預測器在只有一小部分影片內容的上下文中,填充缺失的內容,且填充並非填充實際的畫素,而是表示空間中的抽象描述。

研究人員解釋,如果僅是隨機抽選遮蔽影片中的小區塊,則會讓任務過於簡單,使得模型無法真正學習到關於世界的複雜事物。因此Meta特別制定涵蓋空間與時間的遮蔽策略,迫使模型學習並且發展對場景的理解,進一步預測未來的事件或是動作,進而達到對世界更深層次的理解。

該方法的優勢讓模型能夠專注於影片的高層次概念,而不會鑽牛角尖於對下游任務不重要的細節,像是人類觀看在有樹木的影片,不會特別關心每片葉子的細微動作一樣,如此便能提高了學習效率和任務適應性。

V-JEPA還有一個重要的創新是凍結評估(Frozen Evaluations)的能力,模型在預訓練之後,核心的部分不會再改變,因此只需要在其上添加小型專門層即可適應新任務。該設計避免了傳統模型針對新任務需要全面微調的麻煩,減少學習新任務的資料和時間要求,並使得模型能夠在不同任務中重複使用,諸如動作分類、精細地物體互動辨識以及活動定位等。

Meta會繼續擴展V-JEPA模型,從只有處理影片的視覺內容,增加整合音訊實現多模態學習,研究團隊認為,透過更豐富的上下文資訊,將能夠加深模型對影片內容的理解。此外,他們也會繼續強化模型長期規畫和預測能力,使其能夠處理長時間跨度的任務,而這將是發展高階機器智慧的重要方向。Meta現在以創用CC BY-NC授權釋出V-JEPA模型,促進人工智慧領域發展。

熱門新聞

2026-02-09

2026-02-06

2026-02-09

2026-02-09

2026-02-06

2026-02-09

2026-02-09