生成式人工智慧拜ChatGPT之賜,不到一年就竄升為家喻戶曉的人工智慧代名詞,而在各行各業積極探索新興應用商機之際,對於生成式人工智慧(Generative AI)潛在的資安顧慮也隨之湧現。亞馬遜(Amazon)安全長Steve Schmidt在re:Inforce 2024的演講中指出,生成式人工智慧並非橫空出世,而是承襲機器學習與人工智慧技術數十年發展脈絡的最新階段,因此資安的基本原則與人工智慧安全防護經驗都仍適用,他也公開亞馬遜的人工智慧安全團隊成立的經驗,包括資安組織的定位如何不會限制人工智慧的創新可能性、如何協助開發團隊做出正確的安全決策,以及在安全檢驗方面有別於傳統資安測試之處。

身為全球電子商務巨擘的亞馬遜,運用機器學習與人工智慧技術已有十多年經驗,Schmidt表示,從2012年物流倉儲中心引入Kiva倉儲機器人、2014年推出Alexa個人虛擬助理,以至2017年推出個資保護服務Amazon Mice,皆是機器學習與人工智慧技術的應用。

面對發展速度越來越快的新興技術,如生成式人工智慧,Schmidt指出,資安防護的基本原則依然不變,像是人人當責的資安文化、必要的防護工具與檢驗機制、安全守則指引、多因素認證,以及可將資安擴及全組織的分散式資安的觀念等。因此,因應人工智慧安全的三個基本問題依然可運用在生成式人工智慧,包括:資料的來源?資料經查詢後會發生什麼狀況,以及會對與之相關的任何資料造成什麼影響?第三則是人工智慧模型輸出的資料是否準確?

人工智慧安全團隊的定位:守門員 vs. 助攻員

企業要探索人工智慧的機會,首先需要人才,然而,不只人工智慧人才難找,資安人才也很難找,而要同時兼顧兩個領域的人工智慧安全人才,更是難上加難。找到人才之後,人工智慧安全團隊的職能定位更是關鍵,因為資安團隊最終扮演的是守門員或助攻員的角色,將決定人工智慧應用的創新機會。

Schmidt表示,通常企業會賦予人工智慧安全團隊守門員的角色,由這些擁有專門知識技能的安全專家肩負起防護人工智慧的責任,然而由少數幾位專家來審查把關,一方面會成為開發流程的瓶頸,影響開發效率,拖累創新速度;另一方面,重重審查所帶來的額外負擔,也會造成開發人員為了避免審查而變相繞道,反而無法達到提升資安的效果。

因此,如何讓人工智慧安全團隊既為資安把關又不阻礙創新的速度?Schmidt指出,亞馬遜最後採取的權衡作法,是讓資安團隊成為助攻員,協助開發人工智慧安全防護的解決方案,包括防護工具、檢驗工具與防護機制,再提供給開發團隊,協助開發人員以更安全的方式,更快開發出安全又創新的人工智慧應用。而這也與亞馬遜提倡的「分散式資安」—將資安作法散布到各個部門的作法如出一轍。

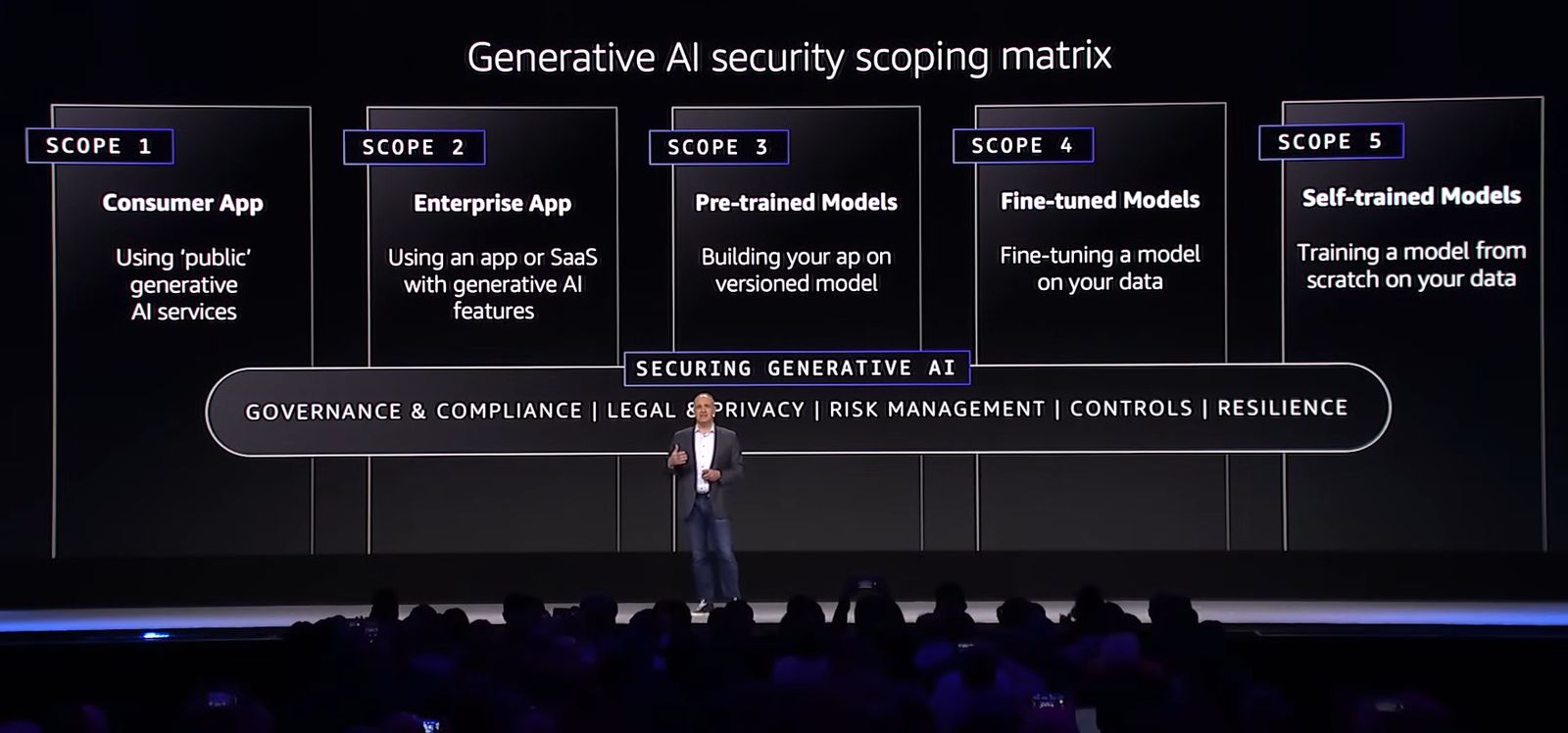

生成式人工智慧安全需求評估框架

亞馬遜人工智慧安全團隊因而開發出一系列評估框架、決策準則與最佳作法建議。其中,他們針對生成式人工智慧安全提出的需求評估框架「Generative Artificial Intelligence Scope Matrix(生成式人工智慧範疇矩陣)」,可協助開發團隊評估專案範疇與資安防護構面。

生成式人工智慧範疇矩陣界定五種應用類型,第一種是如ChatGPT、Midjourney這類人人都能直接使用的生成式人工智慧服務;第二種是已整合生成式人工智慧功能的企業SaaS服務;第三種是利用基礎模式開發生成式人工智慧應用;第四種是利用基礎模式與自有資料微調模型;第五種則是自主訓練模型。而這五種範疇應用的資安防護,都必須顧及治理與法遵、法律與隱私、風險管理、管控措施與韌性等五個構面的要求。

四大措施強化人工智慧安全

此外,亞馬遜人工智慧安全團隊也發展出一系列可協助開發團隊強化安全的措施,包括生成式人工智慧安全標準、威脅模型分析指南、測試工具與安全審查等。

第一項措施是建立生成式人工智慧安全標準,內容包含如何處理機密資料,以及檢測模型、提示工作流程與人工智慧應用服務的安全性所要考量的測試條件。有標準可循,開發人員就更加清楚需要考量的安全措施,使他們能夠在一開始就結合安全設計,而不是在審查過後才做資安補強,Schmidt表示,不光只是生成式人工智慧,任何軟體若是在開發完成後才做資安補強,那就太晚了。

第二項措施是建立生成式人工智慧威脅模型(Threat Modeling)分析指南,威脅模型分析是以系統性的方法分析潛在威脅、設計緩解措施,並排定優先順序,以確保將有限的資源挹注在能發揮最大安全成效的工作。Schmidt指出,威脅模型分析是亞馬遜愛用的方法,由人工智慧安全團隊建立威脅模型,再提供給所有開發團隊參考運用,對於提升安全有很大的幫助。

第三項措施是提供測試工具,亞馬遜人工智慧安全團隊依據威脅模型分析的結果,開發對應的測試工具,協助開發人員據以檢驗生成式人工智慧應用程式的安全態勢,例如為了確保模型如何因應一些古怪的提示,他們就開發一套工具來檢驗。而隨著人工智慧安全團隊學習到越來越多攻擊樣態,把這些知識都集中在一起,整合成工具提供給開發人員使用,那麼所有開發人員自然而然直接受益,因此組織持續提升安全的效果就會發揮到最大。

第四項措施是安全檢驗,Schmidt表示,亞馬遜的應用程式在上線前都必須通過滲透測試的檢驗,而且日後程式碼若有重大改變,則要再一次進行;然而,立基於基礎模型運作的生成式人工智慧卻不是如此,因為在生成式人工智慧的世界中,模型就是程式碼,而且生成式人工智慧應用的反應,會隨著使用者與模型的互動方式與時間推移而有所不同。也就是說,生成式人工智慧的安全檢驗永遠沒有完成的一天,必須從傳統一次性檢驗方式,改為持續性檢驗。

Schmidt指出,為了因應生成式人工智慧特性所需的持續性檢驗,亞馬遜的人工智慧安全團隊因而開發防護機制(Guardrail)工具,例如評估每一次使用者的輸入與模型輸出的內容,依據管制政策拒絕使用者輸入或過濾模型輸出的內容或主題,如有害內容、提示攻擊或含有機敏個資的資訊等。

生成式人工智慧應用上線四大安全守則

由於生成式人工智慧技術從模型建立到面向使用者的應用服務,整個過程都涉及大量資料的輸入與輸出,Schmidt因此建議企業在推出生成式人工智慧應用前要重視四大安全守則。首先,在訓練人工智慧模型時要確保正確處理機敏機料,必須清楚掌握你的資料、儲存的地點與保管方式、資料存取權以及使用目的,並且要檢視日誌檔以了解資料實際上被使用的情形。

再者,於企業陸續採用的檢索增強生成(Retrieval-Augmented Generation,RAG)領域,Schmidt提醒要注意信任邊界的問題,確保人工智慧應用帶出用戶正確的上下文,而且只能存取用戶授權的資料。

第三項守則是依據人工智慧應用的特性設計合適的測試方法,例如定期或持續以特別設計的提示測試模型,主動偵測潛在的注入攻擊或資料外洩問題。第四項則是部署合適的防護機制,Schmidt表示,任何AI應用都會需要防護機制,才能依照用戶的性質去過濾不適當的術語或主題。

「在人工智慧世界裏,安全工作永無境。」Schmidt表示,人工智慧安全的相關研究非常活躍,未來勢必會有更多新的進展,需要持續保持觀注。

熱門新聞

2026-02-11

2026-02-11

2026-02-09

2026-02-10

2026-02-12

2026-02-10

2026-02-06