繼2016年推出基於Pascal架構的Tesla P100加速器,引領一波波深度學習與高效能運算應用的風潮,Nvidia今年再接再厲,發表了最新的Volta架構,並且以此推出首款產品Tesla V100,強調這是一款資料中心等級的GPU,可提供更快的運算速度與擴展性,支援人工智慧的推論與訓練,以及高效能運算與繪圖處理的工作負載。

就Nvidia GPU運算技術的發展歷程而言,Volta屬於第7代的架構,內建了210億顆電晶體,在深度學習應用當中,Nvidia可宣稱該架構的GPU可提供相當於100顆CPU的效能。若以上一代的Pascal架構為基準,Volta架構提供的浮點運算效能,最高可達到5倍的提升,若用兩年推出的上上一代Maxwell架構相比,Volta超越的幅度甚至達到15倍。

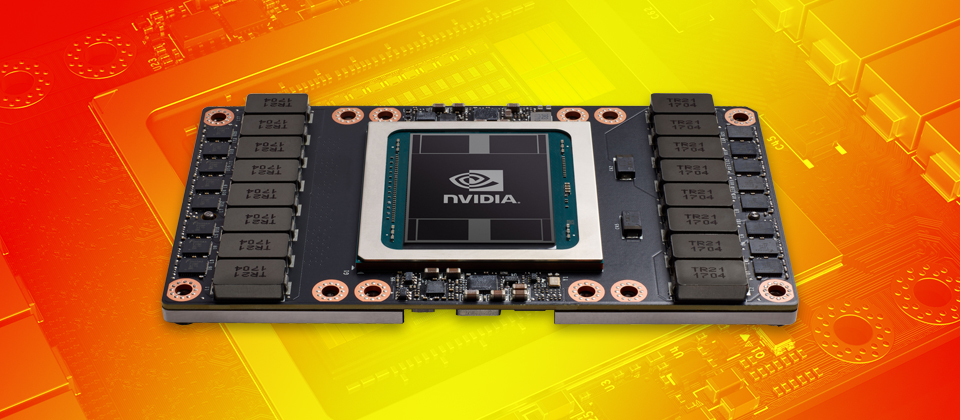

圖中是在今年GTC大會上,Nvidia所公布的Tesla V100基本規格,裡面提到了採用台積電12nm FFN製程,配備了5,120顆CUDA核心,Tensor核心可提供120TFLOPS運算能力。而在記憶體的部份,雖然跟P100同樣內建了16GB的HBM2,但頻寬達到900 GB/s,此外,在NVLink的部份,也有所提升,可達到 300 GB/s。

除此之外,Volta架構也特別採用新的作法,以提升高效能運算應用的效能。Nvidia主要是將CUDA核心與新的Volta Tensor Core核心,進行配對,並統合在單一架構之下,如此一來,即可在單顆GPU當中,提供相當於一座AI超級電腦的效能。

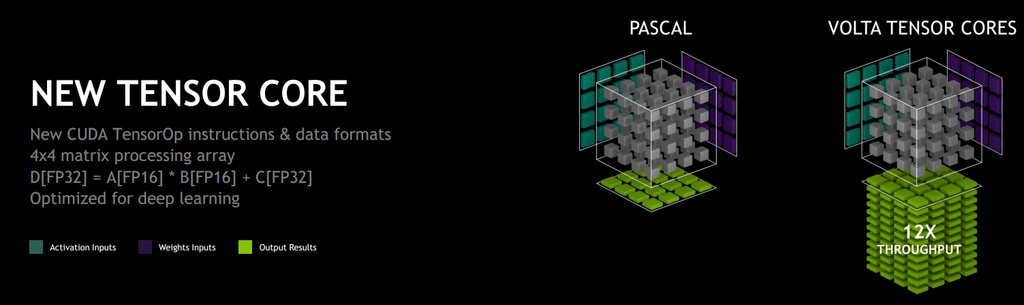

與Pascal架構相比,Tesla V100採用了新的Tensor Core核心,增加了新的CUDA TensorOP指令集與資料格式,提供了4x4x4矩陣處理陣列的運算方式,可針對深度學習應用做到最佳化。

若以Pascal架構為基準,Volta架構在高效能運算領域,可提供1.5倍的浮點運算量,對於深度學習的訓練,達到12倍的Tensor浮點運算量,而針對深度學習的推論處理,可達到6倍的Tensor浮點運算量。

基於這樣的原因,Nvidia也強調,僅需運用單臺可配備多個Tesla V100 GPU的伺服器,就能因應高效能運算環境的需求,而非沿襲傳統的作法,繼續採用數百顆CPU、大量伺服器互相串連的架構。

而在這樣的整合架構下,目前Tesla V100總共配備了640顆Tensor Core,針對深度學習的應用,這款GPU加速器可提供120 TFLOPS的效能,而Nvidia提出的這項數值,也是他們認為Tesla V100效能相當於100顆CPU的主要根據。

Tesla V100在NVLink互連架構上,也支援新一代的技術,吞吐量可達300 GB/s,若以目前NVLink為基準,超越的幅度可達到將近兩倍。同時,針對GPU之間的連結,以及GPU與CPU之間的連結,新的NVLink介面,提供更高的頻寬(25 Gb/s,先前是20 Gb/s)、更多連結(6個,先前是4個),以及更強大的延展性(可支援IBM Power 9處理器平臺的CPU主導與快取凝聚)。

而在記憶體的搭配上,Tesla V100同樣是採用HBM2,但記憶體頻寬更大了,可達到900 GB/s,比前一代產品(Tesla P100的PCIe板卡)提升了50%。這部份特色的加入,主要得力於Nvidia與三星的合作。

對於軟體最佳化支援的部份,Nvidia也針對Volta架構,提供了CUDA、cuDNN、TensorRT等軟體框架與應用程式,可加速AI與相關研究分析的進行。

產品資訊

Nvidia Tesla V100

●原廠:Nvidia(02)6605-5700

●建議售價:廠商未提供

●處理器製程:12奈米FFN

●外型:SXM2(NVLink)、介面卡(PCIe)

●GPU架構:Nvidia Volta

●GPU核心:5120顆CUDA核心

●GPU記憶體:16GB CoWoS HBM2

●記憶體頻寬:900 GB/s

●運算效能:雙精度(FP64)為7.5 TFLOPS

●支援運算API:CUDA、DirectCompute、OpenCL、OpenACC

●耗電量:300瓦

【註:規格與價格由廠商提供,因時有異動,正確資訊請洽廠商】

熱門新聞

2026-02-09

2026-02-06

2026-02-06

2026-02-06

2026-02-06

2026-02-06