VMworld

在vSphere即將推出2015新版的前夕,我們想要回顧一下VMware從去年8月舉辦的VMworld 2014大會所公布的資訊,再加上目前有幾家國外IT媒體也已經在10月初報導的vSphere 6.0候選發行版(Release Candidate,RC)相關消息,VMware這次發布重大改版的幾個主要重點,其實已經越來越明確了。

這次vSphere推出新版的功能中,我們認為最具突破性的特色,是針對vMotion功能的再強化,對於規模日漸擴張、對於可靠度提升有迫切需求的大型資料中心環境而言,會相當渴望這方面的進展。

vMotion的重要性與發展歷程

事實上,在伺服器虛擬化的應用當中,vMotion一直是非常關鍵的技術,因為有了它,你就能做到VM的不停機線上遷移,讓多臺承載VM執行的伺服器主機,能夠透過手動、甚至自動方式的作業,更有效率地共享工作負載、交互運用彼此各自的運算資源,這也是它最為人稱道的地方。

早期微軟Hyper-V還沒有成長到現在的程度時、甚至還沒有推出之前,VMware就已經讓當時的ESX Server搭配VirtualCenter,而提供了鼎鼎大名的vMotion,這項功能獨領風騷長達五年之久,幾乎成為同類技術、甚至是很多人心中伺服器虛擬化應用的代名詞。微軟推出Hyper-v,也是一直到2009年推出的Windows Server 2008 R2時,才提供足以與之匹敵的Live Migration,最早微軟甚至只能提供中斷時間較久、轉移即時度較差的Quick Migration。

另一個基於vMotion所發展出來的DRS(Distributed Resource Scheduler)技術,也是VMware虛擬化平臺得以受重用的特色之一。也有人稱它為automated vMotion,因為它能讓VM不停機遷移可自動進行,若系統偵測到既有ESXi主機端的負載工作量太大,或是遇到預定的停機維護作業期間,可將VM自動遷移到叢集內其他臺(性能較有餘裕的)ESXi主機。而有了這項技術,也使得VM應用具有自動調節、均衡主機工作負載的能力。

之後,VMware在每次改版時,又陸續添加了針對儲存設備檔案即時移轉的Storage vMotion,以及可藉此均衡使用儲存設備資源的Storage DRS,前者可協助VM將原本存放在一臺共用儲存設備的虛擬磁碟檔案,即時轉移到另一臺共用儲存設備,後者則是基於這種不停機的轉移,做到儲存空間與I/O負載的整併或均分。

到了vSphere 5.1,VMware又特別加入了新的Enhanced vMotion,讓vMotion可以拓展到缺乏預算而無法建置共用儲存設備的多主機環境上,也有人稱之為vMotion without share storage。無獨有偶,想要迅速趕上虛擬化浪頭的微軟,也在同一年推出的Windows Server 2012 Hyper-V,提供了類似的功能,稱之為無共用儲存式的即時移轉(Shared Nothing Live Migration),巧合的是,雙方在推出這部分功能的想法和時機,居然都相當接近。

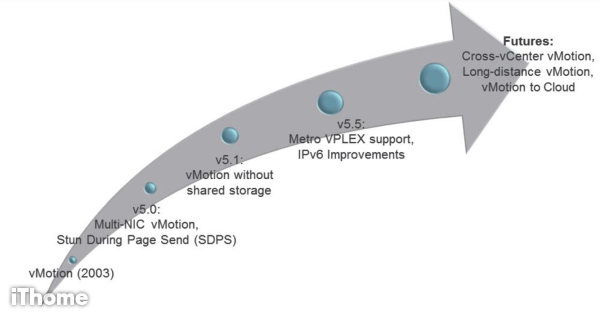

vMotion歷經10多年的功能演進,為VMware開創新願景

2013年開始推的vMotion,是VMware虛擬化平臺的關鍵技術,有了它,VM不只是在一臺臺ESXi伺服器上運作,而是可以依照管理者需求,任意搬移到叢集內的其他ESXi主機,如此能夠使虛擬化應用的整體成效,發揮到更高的層次。隨著vSphere功能的演進,近年來的VMware每一次改版,都持續提升vMotion的能耐,例如,5.1版支援不需共用儲存也可vMotion,5.5版開始為提升遠距離vMotion能力做準備,6.0版之後,將支援更多模式,以適應大型資料中心、混合雲服務整合的應用需求。(圖片來源/VMworld)

在長距離vMotion技術上,取得了關鍵技術的進展

在這之後,vSphere 5.5又有新突破,其中一項,是使vMotion的功能擴大,支援儲存大廠EMC的VPLEX Metro儲存虛擬化異地叢集方案,讓分散在兩地的資料中心ESXi主機叢集能夠運用這個環境提供的分散式虛擬Volume,以及主機叢集之間互連的私有GbE網路、VPLEX叢集之間互連的光纖通道網路,藉此做到遠距離的VM線上遷移作業。

另一項跟長距離vMotion有關的進展,是改良了vShere在IPv6網路環境上執行各種傳輸相關作業的效能。

在vSphere 5.1版時,VMware新增了三項提高網路存取效能的機制,包括TCP Checksum Offload、Software Large Receive Offload,以及Zero-Copy Receive,基於這些新技術,vSphere即可將TCP封包同位元檢查,卸載到實體網路卡;也可將匯聚多個封包為一的減量工作,交由vSphere的網路堆疊處理;以及提供直接處理一些封包訊框(packet frame)的能力,節省資源與時間,而不需白白拐一圈,將非必要處理的封包,複製到vSphere網路堆疊的記憶體空間。

但這些特色當時僅能針對IPv4網路的應用發揮效果,若在IPv6環境執行vMotion、NFS、Fault Tolerance等功能,就無法受惠,所拿到的頻寬也相對較少。到了5.5版之後,這些功能對IPv6的支援已經納入,而在VMware公布的實驗數據當中,若在兩臺ESXi 5.5主機之間,各自搭配4個10GbE的網路介面,取得40Gb/s頻寬的情況下,不論是用IPv4或IPv6網路通訊協定,皆可獲得相當高且彼此接近的吞吐量(IPv4是37.09Gb/s,IPv6是36.04Gb/s)

終於實現長距離vMotion,並開始允許跨資料中心的vMotion

然而,上述這些已經是正式推出一段時間的功能,接下來,vSphere 6還能做什麼呢?有了這些技術和持續改良打好基礎,VMware即將推出的,是基於vSphere自己的長距離vMotion方案──Long Distance vMotion。

簡而言之,VMware希望新版vSphere裡面的vMotion,能夠支援封包來回時間長達100毫秒(100ms RTTs)的運作模式。如果真能做到,vMotion有了較長的延遲忍受時間,就有機會做到長距離的VM不停機遷移,若以美國境內為例,想要做到跨州、甚至跨東西兩岸的vMotion,都是有可能做到的。

.png)

VMware規畫混合雲架構下的vMotion運作方式

有了長距離vMotion(LD vMotion)的執行能力,在VMware的理想當中,企業資料中心能將所屬的VM,任意即時遷移到在VMware營運的IaaS混合雲服務vCHS(VMware vCloud Hybrid Service,2014年下半已改名為vCloud Air)。在這架構下,使用者帳號可跨越不同的單一登入網域;vMotion本身的協定標準當中,也將支援多租戶使用模式;此外,VMware也將提供可基於VM層級的EVC模式(Enhanced vMotion Compatibility),來隱藏VM原本所用的各種CPU。(圖片來源/VMworld)

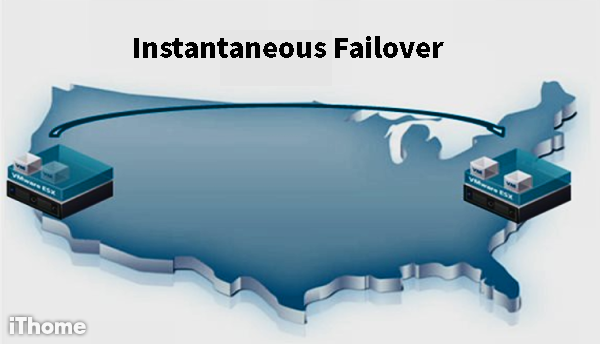

長距離vMotion的簡單示意圖

vMotion在VMware接下來推出的vSphere新版中,預計支援VM遠距離即時容錯移轉的機制,作業時間預計將延長至100毫秒,VMware希望這項技術能做到跨州、甚至跨國的不停機搬遷,讓工作負載的承擔,不只是局限在本地的資料中心,而是能夠聯合位於遠距、異地站點的資料中心,一起協力運作。(圖片來源/VMworld)

就VMware本身的想法而言,他們希望藉此再一次擴增VM轉移作業的彈性,並且支援各種應用模式。例如;一旦發生突發事故,還有一點時間可以作業的情況下,管理者可啟動預防性的系統遷移,這樣一來,等於在既有的A/A或A/S模式的HA高可用性、容錯機制,以及異地備援之外,維持系統可靠度能有更多選擇。

這項特色也可以搭配VMware自己的Site Recovery Manager(SRM)方案,進行災難預防演練,或者實現多站點負載平衡(Multi-site load balancing),甚至可配合跨國公司的業務模式,提供日不落式的(Follow the sun)全天候應用系統服務(應用系統的VM可透過這種方式、搭配自動或排程設定,全球跑透透)。

對於長距離vMotion,我們也請教與VMware關係相當緊密的EMC,他們提出了一些相當具參考價值的觀點。

vMotion現在從原有的10ms RTT限制,放寬到100+ms RTT,讓遠距離跨資料中心的vMotion成為可能,EMC認為,需注意下列幾件事:首先是,遠距離下的vMotion將VM記憶體透過網路複製所需的頻寬和時間;其次,原始端和目的端VM網路環境之間,仍然需要透過Layer 2網路傳輸,以現有的資訊研判,每一個vMotion的作業需要250 Mbps的頻寬,雖然vMotion可使用路由式網路環境(Routed Network),但在VM(Guest OS)這一層,還是需要Layer 2網路連線能力。

最後,則是VM原本所用的IP位址,在目的端必須是可用的,這樣才能確保遷移過去之後,VM的網路仍能繼續正常運作。

而對於長距離vMotion未來可衍生的應用形式,EMC認為,這除了可以支援遠距離跨資料中心的維運管理外,另外一個可能的用途,就是能將VM線上搬遷到vSphere-based的公有雲,例如VMware自家的vCloud Air,就現有資料來看,若要這麼做,。他們研判屆時應該可以做到移入(Move Onto),但是還不確定是否可以做到線上簽出(Online Check-out)。

除了長距離vMotion,vSphere新版對於這類型應用還提出兩個突破性的特色:跨多臺vCenter Server的vMotion,以及跨多臺vSwitch的vMotion。

前者是讓VM能夠跨越本身所在的vCenter Server、資料中心物件與資料夾物件,即時遷移到另一臺vCenter Server上。後者則是讓VM在不同的虛擬交換器環境之間,都能夠進行即時遷移。

持續多年(版本)以來,每臺VM若要進行vMotion搬遷,範圍通常無法超出每臺vCenter Server之外。而且,雖然vCenter Server之內,可建立多個DataCenter物件,但是想要跨不同DataCenter執行vMotion,也是不被VMware所允許的。

但現在可能是由於資料中心對於虛擬化應用程度越來越高,所架設的VM數量激增,為了管理的便利性、甚至是整體使用規模已經大到一定程度,使得企業本身需同時架設與管理多臺vCenter Server,為了讓資源更有效調配、運用,所以這種跨管理伺服器、跨資料中心的vMotion需求,也隨之大增。

類似的情況則是發生在虛擬網路的配置。vMotion再怎麼搬VM,也無法超出一臺虛擬交換器之外,然而,也是因為資料中心虛擬化環境日益複雜,你可能擁有多臺虛擬交換器,為了增加VM或主機的資源調度彈性,有可能會需要即時遷移到其他臺虛擬交換器所在的網路範圍。於是,跨vSwitch的vMotion需求,也逐漸浮現。

對此,EMC表示,這讓vMotion的網路需求,由原本要求的Layer 2網路降至路由式網路,而且,他們認為,相關的改進,主要是為了突破單一vCenter Server的限制,避免單一vCenter Server架構的風險,預防這裡故障就會導致系統全面癱瘓(Single Failure Domain),並且降低對網路架構的需求,使跨資料中心的vMotion更為可行。

不論是哪一版的vSphere,vMotion都是屬於Hypervisor層的功能,然而一個完整的vMotion所涵蓋的範圍,不僅僅是VM的處理器和記憶體的動態線上遷移,VMs所使用的資料,尤其是存放在外接儲存設備上的資料的動態遷移,也是相當重要的課題。而EMC認為,他們的VPLEX Active-Active Datacenters方案,能與vMotion相輔相成,因此,vSphere 6的長距離vMotion,並不會和VPLEX產生競爭──透過在Local或Metro環境下Active-Active Storage的功能,確保跨資料中心儲存設備資料的一致性和立即可用性,遠端資料中心的外接式磁碟陣列上的資料,可以與本地端設備同步,vMotion只需將VM映像透過vMotion 網路傳送至遠端,之後,即可完成作業。

相對地,EMC認為,有了這樣的架構,也會讓長距離vMotion的運作機制更快更好。如果沒有這種機制,vMotion須等待原始VM所使用的資料在遠端資料中心複製完成,才能進行,而且,這會造成在vMotion期間頻寬需求增加,搬遷時間也會隨之增長。

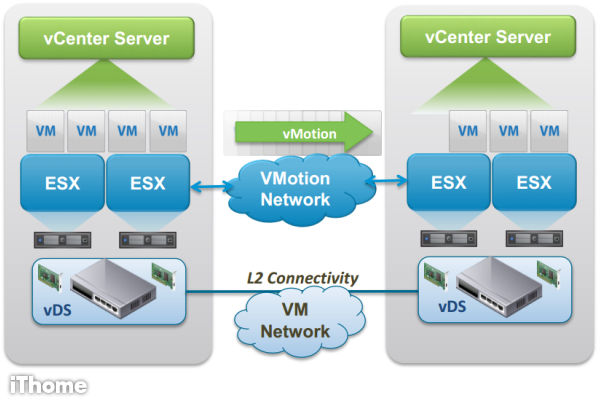

vSphere 6:可橫跨不同vCenter的vMotion架構

vSphere新版所提供的vMotion模式當中,包含了可跨越不同vCenter Server、vSwitch、長距離與路由式網路的vMotion,以因應更大規模的資料中心應用需求。

具有跨越vCenter能力之後的vMotion,等於讓管理者能夠做到同時變更運算、儲存、網路、管理的能力──以往管理伺服器若要停機維修、更換硬體,甚至發生故障,所屬範圍內的VM也等於跟著停擺。而有了這樣的功能後,就算是搭配伺服器本機儲存的vMotion,也能支援更遠距離的遷移。(圖片來源/EMC)

.png)

vSphere 5.5:vMotion搭配EMC VPLEX Metro的架構

vSphere 5.5推出之際,VMware讓vMotion發展出支援EMC VPLEX兩地資料中心同步運作的方案,當中的關鍵技術除了vSphere的vMotion,讓VM能在兩地的ESXi主機叢集之間搬移,還搭配了EMC的VPLEX Metro,當中包含分散式虛擬Volume、叢集主機與光纖網路。

要建置這樣的環境,需滿足一些條件:例如IP網路的頻寬,至少要提供到622Mbps,ESXi伺服器之間的傳輸延遲需低於5毫秒。(圖片來源/VMware知識庫)

.png)

VM搭配Virtual Volumes後的儲存陣列遠端複製架構差異

當vSphere啟動VMware所發展的儲存虛擬化機制Virtual Volumes,之後,儲存系統執行遠端複製的目標會跟著改變──原本VMDK檔是位在LUNs上,然後,儲存系統再將LUNs複製到遠端;現在改為複製VMDK映像檔,因為vSphere會將VMDK直接放在儲存系統上,而儲存系統再將VMDK映像檔複製到遠端,而且,在這樣的新架構下,vMotion還是能夠進行。(圖片來源/VMworld)

熱門新聞

2026-02-02

2026-02-03

2026-02-04

2026-02-02

2026-02-04

2026-02-03

2026-02-05