雨林保育團體Rainforest Connection改良出太陽能智慧型手機,藏在亞馬遜雨林樹上、24小時收音,並利用TensorFlow即時分析音頻,監測是否有盜伐等非法活動。

重點新聞(0323~0329)

IBM Watson 語音助理

IBM推出Watson Assistant語音助理,可供企業客製自家語音助理

IBM近日推出Watson Assistant語音助理,可讓企業自行開發專屬的虛擬助理。不同於亞馬遜的Alexa和蘋果的Siri,企業只能將自家服務整併到原廠語音助理中,Watson Assistant反而採取了白標策略(white label),企業也不需套用IBM商標,也不需強迫使用者得說出「Watson Assistant」來喚醒它。企業取得IBM授權申請後,可以使用自己的資料集,來訓練Watson Assistant,並整合到自己的產品中。

例如音響公司哈曼卡頓,就用Watson Assistant打造了馬莎拉蒂概念車中的語音助理。或像慕尼黑機場,將Watson Assistant整合到Pepper機器人中,為旅客帶路。(詳全文)

TensorFlow 雨林濫伐

靠TensorFlow實現24小時監聽,追蹤雨林濫伐有新招

Google最近在官網揭露了一起用機器學習搶救雨林的例子。雨林保育團隊Rainforest Connection運用TensorFlow來分辨出盜伐者的活動聲音,幫助亞馬遜雨林中的Tembé部落保護土地。保育團隊會在高盜伐風險的雨林樹上,藏了使用太陽能的改良智慧型手機來收音,再將聲音資料傳到雲端,利用TensorFlow即時分析這些聲音檔,以判定收音點附近是否有鏈鋸、伐木車或其他非法活動。Google指出,透過這套自動化監聽機制,能夠24小時不間斷地即時分析環境聲音,不易有遺漏。(詳全文)

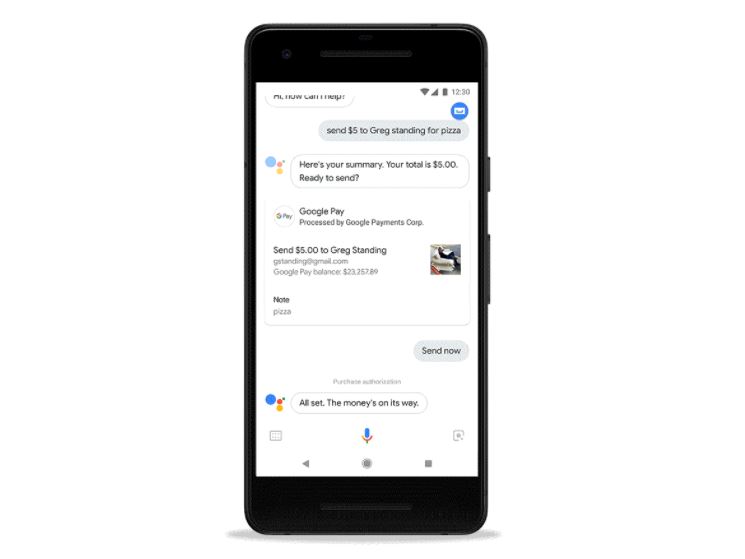

Google Assistant 語音支付

靠嘴說就能付款,Google Assistant語音支付指令來了

Google Assistant日前宣布加入新指令,讓Android和iOS使用者可以透過Google Pay應用程式,以語音方式、向家人和朋友付款或請款。使用者得先完成Google Pay帳戶的設定,才能透過語音方式支付或請款。可以使用如「OK Google,付$20給Simon」或「OK Google,跟Andy要今天的午餐錢$15」這類的句子來付款或請款。另外也會透過簡訊、電子郵件或Google Pay應用程式的通知,來告知對方付款訊息。這項語音支付服務免費,不過,目前只開放美國地區使用。(詳全文)

AI 認知神經科學

認知神經科學家用軟體模擬大腦神經元,讓AI模型學會辨認圖中新物件

第25屆認知神經科學年會(CNS)於3月25日登場,來自MIT的Aude Oliva團隊,展示了一個效法人腦根據上下文線索來辨識圖像的神經網絡模型。Aude Oliva表示,他們利用軟體技術設計出「人工神經元(artificial neurons)」的程式,建立了一個模擬大腦運作的神經網路模型,可以用來辨識出圖像。Aude Oliva用了1千多萬張圖像,才訓練出這個神經網路模型,可以辨識出350個不同的地點,比如廚房、客廳、公園等,也能辨識這些地點中的物件,例如房間中的床。但出乎Aude Oliva意料的是,這套模型竟也學會了「上下文分析」,能辨識出不在他們預料中的物件,如公園中的狗、客廳中的貓等。他指出,這個成果有助於科學家理解人如何在眨眼間辨識物體。(詳全文)

沃爾瑪 盤點機器人

沃爾瑪開始實測機器人盤點商品,連貼錯標籤都能發現

沃爾瑪最近宣布,在加州4家分店測試商品盤點機器人。沃爾瑪指出,貨架盤點機器人也是實現無人商店的第一步。這些機器人由Bossa Nova Robotics開發,機身大約60公分,但可以伸出一個帶有攝影機鏡頭的訊號發射塔,90秒就能掃完一個貨架,來盤點架上商品的庫存情況,也可以分辦出放錯位置或遺失(庫存有但架上沒有)的商品,甚至可以分辨出價格標示錯誤和貼錯標籤的商品。Bossa Nova Robotics表示,這款機器人和自駕車原理相似,使用LIDAR、光感測器、攝影機和距離感測器,來幫助它們「看清」周遭環境並導航。 (詳全文)

AI輔助駕駛 情緒分析

降低車禍風險,新創用AI偵測駕駛人情緒與分心程度

一家分析人類情感的AI新創Affectiva,最近推出可偵測駕駛人情緒的服務。Affectiva與汽車設備製造商合作,結合傳統RGB鏡頭和近紅外線鏡頭,來偵測駕駛人每分鐘眨眼的次數、臉部表情,再透過深度神經網路擷取臉部特徵,和預先訓練的駕駛情緒機器學習模型比對,來分辨駕駛者是否處於疲勞、打呵欠等特徵,來判斷駕駛人適不適合開車。若駕駛人處於憤怒的情緒,系統會建議沿途先停止駕駛,虛擬助手甚至會播放輕快音樂;若駕駛處於疲勞狀態,也可以轉為自動駕駛。(詳全文)

MIT 機器魚

研究海洋生物有新幫手!MIT打造出更仿真的機器魚

麻省理工學院電腦科學與AI實驗室(CSAIL)團隊最近打造了取名為SoFi的機器魚,猶如真實魚類在海中游泳。在斐濟Rainbow Reef的潛水測試中,SoFi可以潛入50英尺深的海底珊瑚礁,最常游動40分鐘,並透過魚眼鏡頭拍照和錄影。團隊透過防水的控制器,再加上自行開發的特製聲學通訊系統,來改變SoFi移動的速度和方向,SoFi靠著仿魚尾巴的構造,在海洋中可以直線游動、轉身,甚至能在海中向上浮或向下潛。SoFi的後半部是用矽橡膠和軟性塑膠所製成,頭部則是用3D列印製造。(詳全文)

Chatbot Dialogflow

設計Chatbot更容易,Google新推視覺化的對話流程設計工具

Google的Chatbot引擎Dialogflow近日在分析平臺中,推出對話分析流程圖Session Flow的功能。Dialogflow曾在9個月前推出分析控制臺Analytics dashboard,讓企業監控Chatbot的狀況,近日則是將這樣的分析結果,加入互動式視覺化的設計,將大多數用戶與企業所有平臺上Chatbot的對話過程,以流程圖的方式呈現。

這項功能可以讓企業得到改善使用者體驗的答案,像是最常見和最不常見的對話流程、用戶離開對話的時間點和原因、用戶在對話中的意圖是如何轉換等,這些關鍵的問題都有助於企業修改Chatbot的對話設計。(詳全文)

臉書 AI伺服器

臉書自家AI伺服器再升級!

臉書近日發布了Big Basin v2,GPU效能比前一代Big Basin提升了66%。臉書表示,機器學習是臉書平臺多項服務的關鍵技術,包括自然語言翻譯、圖像分類、語音辨識、圖像和人臉辨識等,都需要大量的執行機器學習的模型,而運行機器學習模型的需求也日益增長。

近年來臉書在自家資料中心,投資機器學習的相關硬體,從2013年開始為AI研究部署HP SL2705 G8系統,後續分別推出Big Sur和Big Basin,最近則是將AI伺服器再升級,推出能處理更複雜機器學習模型的Big Basin v2。(詳全文)

Watson iOS

IBM和Apple聯手,將Watson企業級AI帶進iOS

IBM近日與Apple連手合作開發AI解決方案Watson Services for Core ML,可用IBM Watson先建立和訓練機器學習模型,再發布為可在Apple Core ML上執行的模型,以整合到iOS裝置(如iPhone、iPad)的App,來打造機器學習應用。簡單來說,就是可以將Watson機器學習的能力,放到iOS App執行。

目前可產生Core ML模型的Watson服務是視覺辨識(Visual Recognition)服務,也可客製打造專用的模型,並享有持續訓練的機制。視覺辨識內建預先訓練好的模型,可以快速且正確地辨識圖像中的物件、景色、臉部、顏色、食物等各種內容。(詳全文)

圖片來源/Google、Walmart、MIT

AI趨勢近期新聞

1. Airbnb用機器學習打擊信用卡盜刷,最小化退款損失

2. Google在臺大秀AI 應用

3. CPC揭雲端戰略新布局,也要搶進AI市場

資料來源:iThome整理,2018年3月

熱門新聞

2026-02-11

2026-02-11

2026-02-09

2026-02-10

2026-02-10

2026-02-06

2026-02-10

2026-02-10