NVision研發出一套可精準模擬現實的機器人控制系統,並運用到實體機器人身上,不須其他感測器、只靠單鏡頭,就能偵測物體、避開障礙物。

Nvidia

重點新聞(0406~0412)

NVision Nvidia

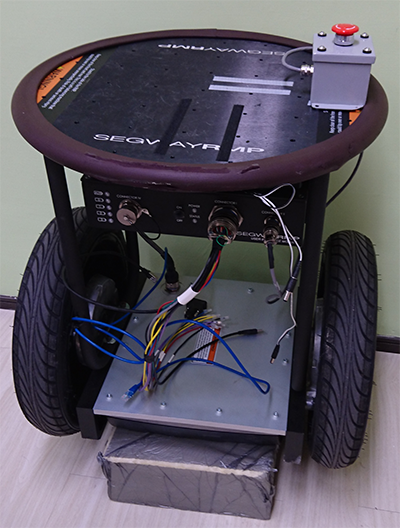

清大NVision團隊創新機器人打敗80國團隊,奪下Nvidia 機器人大賽冠軍

清大資工系NVision隊伍在全球80國2千多位參賽者中脫穎而出,奪下2018年Nvidia機器人大賽(Jetson Robotics Competition)冠軍。NVision研發出一套可精準模擬現實的機器人控制系統,並運用到實體機器人身上,讓它不但能偵測物體、避開障礙物,還能跟隨目標物移動。此外,這套系統只需要單鏡頭、不需其他感測器,就能執行。這個控制系統的架構,將學習模型分為感知模型和控制模型,並利用語義圖像分割來關聯這2項模型。NVision團隊表示,所有模型都在NVIDIA Jetson TX2開發板上執行,而動作指令則透過乙太網或USB口傳送,RBG影像則由NVIDIA Jetson TX2板上的相機取得。(詳全文)

AlterEgo MIT

MIT可讀心的AI頭戴式耳機AlterEgo

MIT日前由研究生Arnav Kapur及其同事,開發一款AI頭戴式耳機:AlterEgo,讓使用者不必出聲說話,就能執行指令。當使用者戴上AlterEgo、不出聲地在心裡默唸某些單字,這套裝置就會透過電極,捕捉下巴和臉部神經、肌肉的訊號,然後送到機器學習系統中,讓AlterEgo分辨語意並執行指令,比如選擇頻道或加減運算等。雖然AlterEgo為頭戴式耳機,但它並沒有耳塞,而是以骨傳導方式,透過臉部骨骼傳遞震動訊息至內耳。此外,在一項有10位受試者的實驗中,AlterEgo的準確率高達92%。(詳全文)

韓國 AI國防

韓國KAIST成立AI國防發展中心,遭到國際AI科學家連署抵制

來自29國的57位科學家,日前針對韓國科學技術學院(KAIST)成立AI國防發展中心一事,連署要求KAIST停止該中心的運作。這些科學家指控,KAIST正在開發的是AI自主武器和殺手機器人(killer robots),而大學高層則表示,AI中心的成立目的,是為改善韓國目前的防禦系統。KAIST在2月20日時,慶祝「國防與AI研發中心」的成立,並在一個後來遭移除的網頁中提到,將與韓國防衛公司韓華系統(Hanwha Systems)合作,發展以AI下達指令和做決策的系統、大型無人海底船艦的複合導航算法、AI飛機訓練系統,以及AI物體追蹤和識別技術。(詳全文)

OpenAI 遷移學習

OpenAI辦競賽,看AI能不能闖過音速小子遊戲新關卡

OpenAI近日在其官方網站宣布,為期2個月的OpenAI Retro Contest正式開賽。這場比賽要求參賽者以增強式學習(reinforcement learning)來挑戰未知的任務:闖過音速小子新關卡。OpenAI表示,這項比賽重點在於遷移學習(transfer learning),即以過去習得的經驗,來處理新的、沒接觸過的任務。為了幫助參賽者,OpenAI也釋出retro-baselines,讓參賽者了解如何在比賽中執行幾種RL算法。(詳全文)

Cowlar 智慧項圈

AI新創Cowlar開發智慧項圈,幫農夫掌握乳牛健康

美國一家AI新創Cowlar,推出專屬乳牛的智慧項圈,可即時監控個別乳牛的狀態,幫助農夫即時察覺牛隻異狀、防止牛隻過早死亡,進而提高產乳量。Cowlar已在巴基斯坦牧場進行試驗,共同創辦人Umer表示,試驗非常成功,提高了8~14%的產乳量。這條智慧項圈,透過運動感測器、不斷追蹤牛隻的體溫和各種動作,包括進食、睡眠、交配和其他活動等。Umer說,蒐集到的資料會送進一套演算法中,分析牛隻的健康狀況,也會預測牛隻體溫變化的循環,以及是否會出現異常行為。 (詳全文)

AI水質檢測 Intel

AI水質檢測,能知道水中是否有致命細菌

英特爾軟體創新員Peter Ma,透過圖形辨識和機器學習技術,開發一套AI水質檢驗系統,可以檢測水中是否有致命細菌。該分析系統可離線執行,只須與一臺數位顯微鏡連接,而該顯微鏡則與配有Ubuntu操作系統的筆電連線,並使用英特爾Movidius神經運算USB。分析後,系統會直接在地圖上即時標示水源受汙染的區域。而檢測系統核心的卷積神經網路,能分辨細菌的形狀、顏色、密度和邊緣等,目前能檢測的細菌為大腸菌,和會引起霍亂的細菌。Peter Ma同時也在擴大系統能辨識的有害菌種和微生物種。(詳全文)

Google MobileNetV2

Google第二代行動裝置版電腦視覺神經網路模型出爐!

Google近日在官方部落格中宣布,推出第二代MobileNetV2,改善了分類、物件偵測和語義分割(Semantic Segmentation)技術,不論是速度和準確率都有所提升。MobileNetV2是以第一代為基礎來改善,延續了第一代透過深度可分離卷積(Depthwise Separable Convolution)的方式,也新增了2項特性:層間的線性轉換方式(Linear bottleneck),以及Bottleneck之間的捷徑連接(Shortcut connections)。(詳全文)

DeepMind AI導航

AI靠強化學習看街景,自行學會導航

DeepMind最近於官方部落格公布新一項研究,以強化學習、讓AI在沒有精準地圖作為訓練資料的情況下,只透過Google的街景圖學會導航,就像人在學習認路一樣。首先,DeepMind透過神經網路建立AI模型,來辨識多個城市街景圖中的像素,程式如果成功到達目的地,就會得到獎勵。與過往導航相比,DeepMind不使用既有的地圖資訊、GPS或是其他定位工具,只透過視覺感知來觀察環境,並依此建立對環境的認知,透過強化學習加強點到點的訓練。目前導航AI模型已經於倫敦、巴黎和紐約完成訓練,能夠穿梭於複雜的交叉路口、人行道、隧道等。(詳全文)

Chatbot 微軟小冰

微軟小冰學會對話的藝術,能和朋友一樣對談

微軟在自然語言技術上又有新突破,微軟的社交型對話機器人小冰,現在學會人類對話的藝術,能預測人類接下來可能會說的話,自然地與人對談,還能隨時切換,執行不同任務。微軟小冰工程師Li Zhou表示,小冰現在可以同時進行雙向溝通,就像講電話一樣,微軟稱之為完全雙重語音意識(Full duplex voice sense)。此外,小冰現在還會暫停手邊的工作,先執行當下的任務,再繼續未完成的任務。比如,小冰在講故事的時候,使用者可以要求小冰開燈,小冰開完燈後,還會記得剛剛在講故事,於是繼續說故事,可隨時切換不同任務。(詳全文)

圖片來源/NVision、MIT、Cowlar、Google

AI趨勢近期新聞

1. EFF指Google高層說謊,聲援員工反對AI軍用化

2. Google開源iOS自動化測試框架GTXiLib

3. 微軟手把手教你開發人工智慧應用

資料來源:iThome整理,2018年4月

熱門新聞

2026-02-11

2026-02-11

2026-02-09

2026-02-10

2026-02-10

2026-02-06

2026-02-10

2026-02-10