人工智慧技術的安全性逐漸受到重視,IBM剛開源了統計偏差修正框架Fairness Kit,以阻止種族歧視機器人產生。而今DeepMind提出人工智慧安全框架,防止人工智慧做出不可預期,甚至是有害人類的事情,必須要從規範(Specification)、強健性(Robustness)和保證(Assurance)三方面下手。

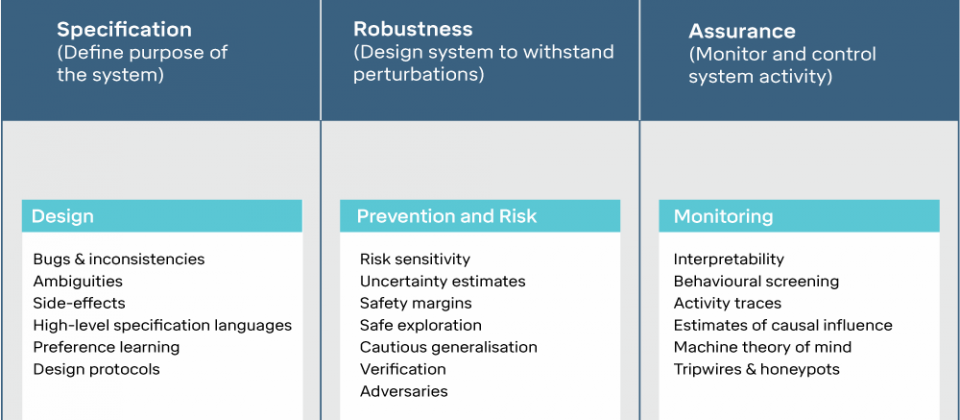

安全是人工智慧系統的關鍵要素之一,DeepMind提到,要保證人工智慧的安全性,必須要仔細從頭開始設計系統,以確保系統每個部分都按造預期協同工作,同時還需要對人工智慧進行監控,即時掌握系統運作狀況。人工智慧安全是一個新穎但發展快速的領域,研究範疇涵蓋高階應用、理論、經驗和實作,DeepMind的安全研究團隊專注設計可靠系統,並且發現可能出現的短期與長期風險,以規範、強健性和保證三個面向的框架來討論人工智慧的安全性。

規範用來定義人工智慧系統的用途,不良的規範可能使人工智慧做出符合規範但並非預期的結果。DeepMind舉了邁達斯國王的神話故事做為比喻,邁達斯向神要求自己要有點石成金的能力,所有接觸的東西都變成黃金,不過這樣的神力卻帶來災難,邁達斯碰到的水和食物瞬間都成為了黃金,不只進食困難,最後連自己的女兒都變成了黃金雕像。DeepMind表示,規範很重要可以用來陳述期望的結果,確保人工智慧按造設計者意願運作。

DeepMind提到規範分為三種,理想規範(Ideal Specification)或是稱為期望,是與人類設計者期望一致的理想人工智慧假設性描述。第二種是設計規範(Design Specification),相對於人類難以清晰表達的描述,設計規範是實際用於建構人工智慧系統的藍圖,像是增強學習系統中的獎勵功能。第三種則是展現規範(Revealed Specification),也就是人工智慧實際表現的行為,經常會與理想規範或是設計規範有差距。

當理想規範與展現規範存在差距,人工智慧系統未按照設計者希望的方式運作時,就會出現規範問題。DeepMind提到了OpenAI賽艇遊戲CoastRunners的分析,對大多數人類來說,遊戲的目標是要快速的完成一圈賽道並超越其他玩家,但這個目標要轉化成精確的獎勵並不簡單,因此設計規範可能會讓快艇不停的撞擊路線中的障礙物。而如果是透過增強學習訓練代理人,則會重複繞圈撞擊和著火,以捕獲重新產生的獎勵品,而不是完成整個的比賽,DeepMind認為,這樣的結果是遊戲的短程獎勵和長期獎勵平衡出現問題,有許多人工智慧系統都像CoastRunners的遊戲代理人一樣,會從客觀的規範中找到漏洞。

在這個框架中的第二個面向是強健性,DeepMind指出,人工智慧系統必定存在風險、不可預測性和波動性,因此要具備對抗不可預測或是可能的故障,甚至是攻擊的強健性。強健性的目的,是要讓人工智慧代理無論遇到什麼情況,都能維持在安全的限制中活動。當系統追求效能最大化實現目標,就可能讓人工智慧產生不安全的探索行為,強健性設計是要保證家用清潔機器人不會在學習最佳打掃策略時,把濕拖把放到插座上。

如下圖所示,AI代理人(藍色區塊)必需能夠在改變熔炎(橘色區塊)的位置時,可以安全的抵達目的地(綠色區塊),而不是為了最快抵達目的地而直接衝向熔炎地帶。

雖然安全工程已經可以排除許多安全性風險,但是仍然難以在一開始就萬事就緒。因此需要框架的第三個面向保證,在部署人工智慧系統後,以工具來持續監控與調整。監控包含了檢查系統的所有方法,以人工進行摘要統計或是系統自動掃描大量的日誌,以分析或預測系統行為。另外,還必須要有關閉人工智慧系統的中斷機制,DeepMind表示,設計可靠的開關非常具有挑戰性。其引用的文獻顯示,獎勵最大化的系統通常具有強烈的動機防止中斷產生,而且中斷頻繁出現時,也可能會改變人工智慧的任務,導致從經驗取得錯誤的結論。

DeepMind正在打造一技術基礎,將能使用在許多重要應用程式中。DeepMind提醒,許多應用在設計時可能貪圖一時方便,輕忽安全的重要性,而這將可能導致一系列不可逆的結果,並且難以在系統沒有全部重新設計之下修復該問題,而當應用被廣泛運用時,產生的影響更是巨大。

熱門新聞

2026-02-06

2026-02-06

2026-02-06

2026-02-06

2026-02-09

2026-02-09

2026-02-09