現今AI用大數據解小問題,但人擅長靠小數據解大問題,再從因果關係來類推出一般性,這是AI未來該走的方向。──微軟全球執行副總裁 沈向洋(攝影/洪政偉)

「能不能知道AI為何這麼想?」這是最近好幾位銀行CIO,遇到微軟AI及研究事業部負責人沈向洋時,都會問他的一個問題。

不只金融業想知道,醫療業也一樣,甚至連美國國防部高等研究計畫署(DARPA)的20億美元新一代AI計畫中,都把可解釋性AI(Explainable AI)列為重點補助項目之一,美國軍方也想知道AI到底在想什麼。「可解釋AI就是目前AI研究中最夯的議題之一。」沈向洋說。

沈向洋是世界級電腦視覺研究權威,投入AI研究超過了27年,擁有50多個美國專利,上百篇AI相關論文。2004年更擔任微軟亞洲研究院第三任院長,率領微軟團隊投入電腦視覺、圖學等AI相關領域研究,後來還負責打造微軟Bing搜尋引擎。後來他更成為微軟全球執行副總裁,主導微軟全球AI戰略和研究。2015年以152層卷積神經網路新架構ResNet,奪下ImageNet競賽冠軍的研究員,就是沈向洋指導的學生。

DNN快速崛起,讓不可解釋問題越來越嚴重

「AI並非一直是黑盒子,早期AI的解釋性很高,」沈向洋指出,AI近兩年有兩大發展方向,包括了符號人工智慧(Symbolic AI)和神經網絡,早年AI發展主軸是專家系統,就如符號人工智慧一類,透過大量規則(Rule-base system)來模擬專家的知識和判斷,也因此,他表示:「Rule-base系統的規則是由人訂定的,解釋性很高,」直到近幾年,深度學習這類深度神經網絡技術(Deep Neural Networks,簡稱DNN)快速崛起之後,「不可解釋的問題才變得越來越嚴重。」

最近7、8年,因為資料累積得夠多,再加上電腦晶片的運算能力大增,更出現了多層式的DNN神經網路等新式演算法,三者結合後的效果非常強大,尤其DNN在語音辨識(Speech Recognition)和視覺辨識(Vision Recognition)的進展最快。

DNN一開始先發現可以用於語音辨識。在DNN崛起之前,語音辨識大多採用HMM演算法(Hidden Markov Model),但錯誤率依舊很高,直到改用DNN來處理後,辨識品質就快速提高了,後來DNN應用到視覺辨識也很有效果,甚至在特定應用,AI程式可以做得比人更好,例如人臉辨識。

除此之外,DNN在自然語言理解(NLP)上也頗有建樹,例如機器閱讀理解(Machine Reading Comprehension)應用已經可以逼近人類水準,或像是微軟針對特定新聞資料集的中英翻譯上,也可以達到人類的水準,這也得歸功於DNN。

沈向洋甚至更預言,藉助DNN,語音辨識技術,5年內可以完勝人類,而視覺辨識技術,可能10年內就能完勝人類,「只是時間的問題。」他強調。

但是,DNN成為主流趨勢後,也帶來了新的問題,一開始,DNN剛崛起時,研究人員最常問的問題就是,要建立多少層(隱藏層)才能訓練出好的模型。微軟ResNet架構提供了一個設計多層DNN架構的模式,以152層訓練出來的模型,辨識圖像的準確率已經達到96%,超越了人類的辨識能力,從此幾乎一統了江湖,後來想要訓練圖像辨識AI模型的人,幾乎都不考慮架構,直接先採用了一個50層ResNet,「因為這個數量,不會太多,也不會太少。」沈向洋解釋,50層架構,不會帶來太高的運算負擔,也不至於因為太少而影響了準確度。

但是,那位想出ResNet的沈向洋學生,卻無法回答沈向洋提出的這個問題,「數學上,能不能證明,多少層是最佳架構。」這也是許多研究者至今難解的問題。

甚至,微軟亞洲研究院後來還發表了一個1,001層的架構,沈向洋問那項計畫的研究者,為何停在這個數量,結果得到答案竟然是「系統的記憶體都用完了,無法再算更多層。」

AI研究人員不只無法證明為何需要這麼多層,甚至,「訓練出模型後,儘管得到很好的預測成果,卻不知道為什麼會出現這樣的結果。」沈向洋觀察,這才促使Explainable AI成了AI領域的熱門題目,而且「這不只是理論上的問題,更是應用上非常重要的需求。」

以金融界為例,那些積極向沈向洋求教的銀行CIO們想要知道,該如何向顧客解釋,AI模型為何拒絕了這位顧客的信用卡申請,甚至還得對監理機關說明,AI通過申請或拒絕的共通原則是什麼。「CIO們對我強調,這個問題對顧客和監理機關雙方都非常重要。」不只銀行,可解釋AI對醫療業也很重要,例如,醫生也想要告訴病人,為何AI判斷出病人的眼睛發生了病變,才容易說服他展開治療。

但是,「DNN發展太快了,導致大家更認為,AI像是一個黑盒子。」沈向洋苦笑著說。

圖片來源_DARPA

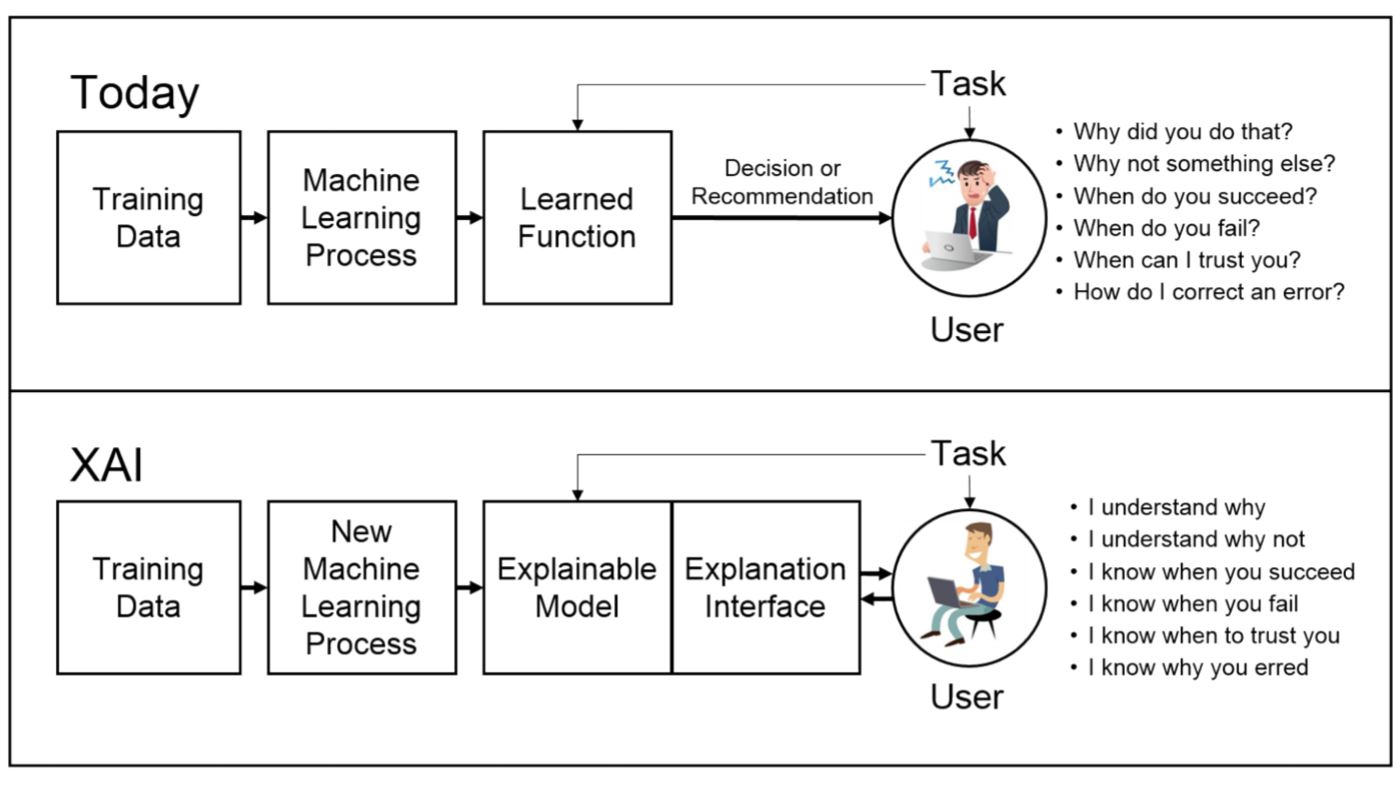

美國國防部DARPA早在2016年8月提出的Explainable Artificial Intelligence(XAI)補助計畫,列出可解釋AI和現今AI模式的差別,要能提供AI解釋模式。

圖片來源_DARPA

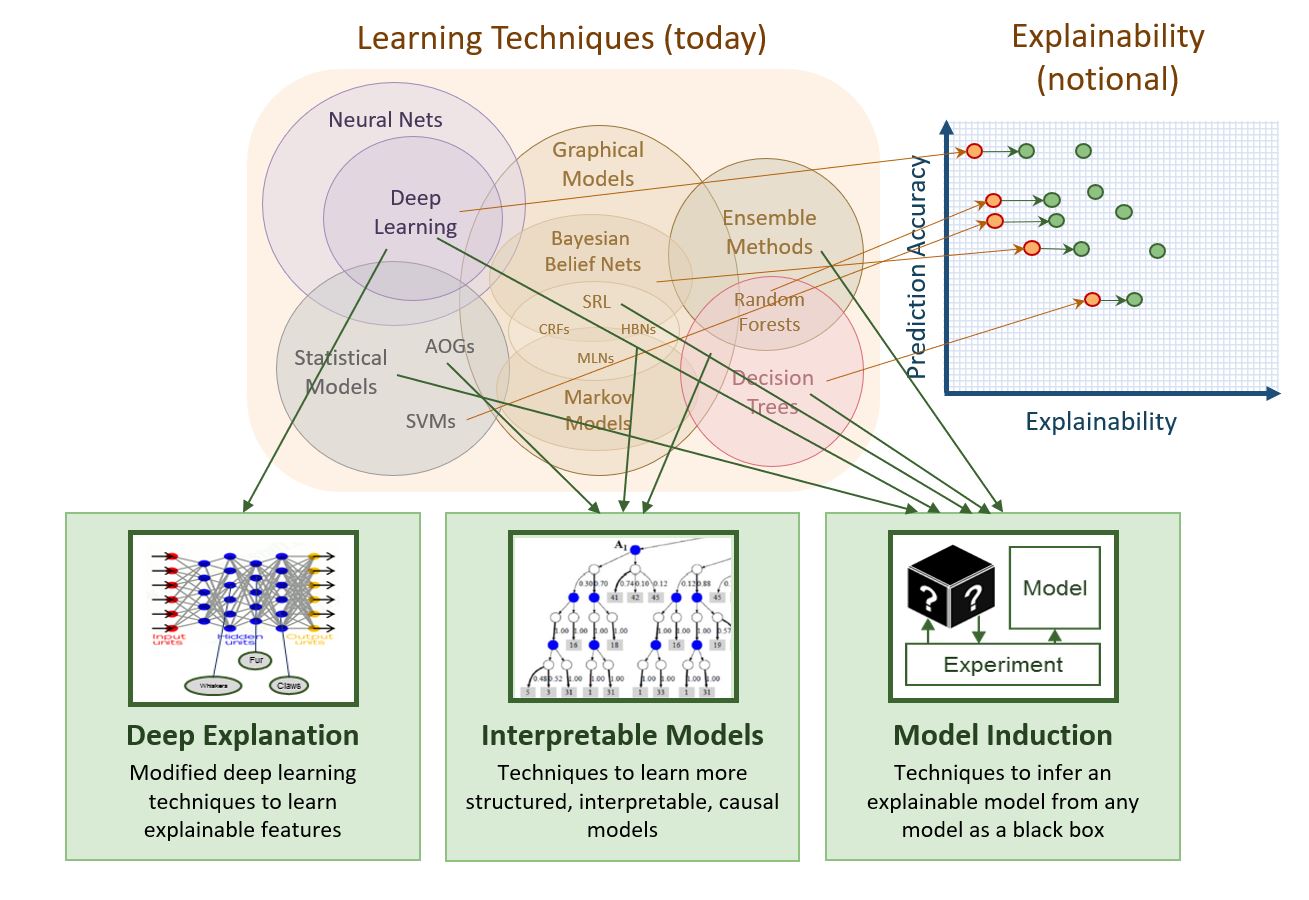

DARPA的XIA計畫目標,是在2021年發展出可解釋AI相關工具,要做到深度解釋能力、可解釋模型和這些模型的初步應用。

熱門新聞

2026-02-09

2026-02-06

2026-02-09

2026-02-09

2026-02-09

2026-02-09

2026-02-06