由於AI與雲端運算市場的爆發性成長,使得今年全球資料中心的需求強勁,而看準這波應用需求的大漲,AMD在Next Horizon大會上,不只展示首款超多64核心EPYC處理器,還針對伺服器GPU發布了最新一代Radeon Instinct加速運算卡產品,同樣使用7奈米新GPU架構設計,搶攻雲端AI與深度學習加速運算市場。

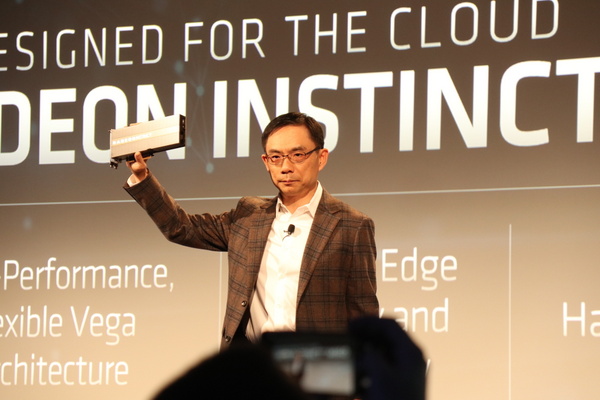

AMD這次一共推出兩款全新GPU加速卡Radeon Instinct MI60和MI50,裡面皆採用下一代Vega 20 架構GPU設計,相較於前代採用14奈米製程Vega架構GPU,新一代Vega 20 架構GPU,採用更先進7奈米製程,晶片面積擴大到331平方公釐,內含有132.3億顆電晶體,不僅比起前一代效能提高25%,而且更省電,功耗只有原來一半。

若進一步以MI60和MI50兩款產品規格來看,前者配備有69個運算單元 (Compute Units),並且最高可提供到29.5 TFLOPS的半精度浮點運算,記憶體容量也翻倍,加大到32GB HBM2,後者也有內含60個運算單元,半精度浮點運算也達到26.8 TFLOPs與搭配16GB HBM2記憶體容量。

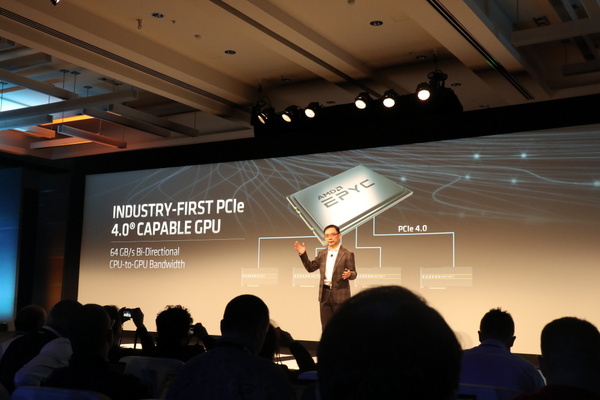

AMD這回也針對深度學習與AI加速運算做出不少改進,通過降低延遲和提高頻寬設計,來大幅提升AI與深度學習加速的效能。不僅同樣支援了新一代PCIe 4.0,可以提供更高速I/O使用,就雙向互連頻寬來看,PCIe 4.0可提供到64 GB/s,對照原先採用PCIe 3.0的32 GB/s,兩者相差2倍。

除此之外,新款GPU加速卡還加入 Infinity Fabric Link高速互連技術,可以讓AI或深度學習訓練模型的執行得以同時橫跨到多個GPU來執行,每張GPU卡之間資料傳輸頻寬最高可提供到200 GB/s,比單獨採用PCIe 3.0速度還快2倍,並且還將每張GPU卡記憶體頻寬提高到了1TB/s ,資料吞吐量還高於競爭對手Nvidia V100 GPU 擁有的900GB / s,以滿足需要密集運算的AI任務、深度學習與HPC應用需求。

在測試數據上,不論是在各項基準效能測試上,採用Instinct MI60的效能表現,都遠高於前一代Instinct MI25,例如在進行ResNet-50 機器學習影像模型訓練時,MI60每秒可以辨識498張,MI25則只有179張,兩者速度相差了2.8倍之多。即使是與Nvidia的Tesla V100 GPU相比,Instinct MI60表現也毫不遜色,多項效能測試,彼此幾乎不相上下。

為了支援7奈米Vega GPU,AMD也推出ROCm 2.0新版本,這是一個GPU加速運算的開放軟體平臺,新版除了加入對於7奈米Vega GPU的支援,來加快深度學習系統的開發,還加入更多數學函式庫、支援更多不同軟體框架,與眾多優化深度學習開發工具。像是該平臺目前已支援主流的機器學習框架,包括像是TensorFlow 、Caffe2、PyTorch、MXNet等等。

MI60加速卡將率先在今年Q4推出上市,而另一款MI50最快則要等到明年Q1才會正式出貨。AMD也預告還有下一代MI-Next產品尚未發布,目前仍在開發階段。

熱門新聞

2026-02-11

2026-02-11

2026-02-12

2026-02-09

2026-02-10

2026-02-10

2026-02-06