人們越來越倚重人工智慧解決關鍵任務,因此機器學習是否具備包容性(Inclusive),能夠良好兼容各種多元屬性,成了重要的課題,臉書在研發其智慧視訊裝置Portal時,發現人工智慧進行影像辨識時,對膚色以及性別存在偏見,因此發展出一個框架以打造具包容性的人工智慧,並擴大應用到內部其他專案中。

臉書在F8大會分享了他們發展包容性人工智慧的歷程,事件就發生在臉書AR/VR技術業務主管Lade Obamehinti身上,該團隊在Portal早期測試階段,發現其人工智慧相機作出了出乎意料的判斷。由於Portal的相機會透過電腦視覺計算,根據人們在房間中的移動與分布,動態構圖找出最適合容納多個主體的視野,但是在某一次Lade Obamehinti說話且做出豐富的手勢,Portal的人工智慧並沒有焦點放在Lade Obamehinti這個明顯的興趣點上,而是將鏡頭聚焦在另一名白人男同事身上。

Lade Obamehinti是來自奈及利亞的優秀女性,他發現,人工智慧模型之所以會對不同的人,做出不一樣的表現,部分原因在於用來訓練模型的資料集存在限制與缺陷,由於人類天性就會對事物進行分類,如果不加以控制,則會造成人工智慧系統出現偏差,而且還可能會放大人性負面的部分。為此臉書發展出一套包容性人工智慧開發程序,其提供人工智慧開發人員可依據的指南,幫助研究人員設計資料集、測量產品效能,以及測試包容性的系統。

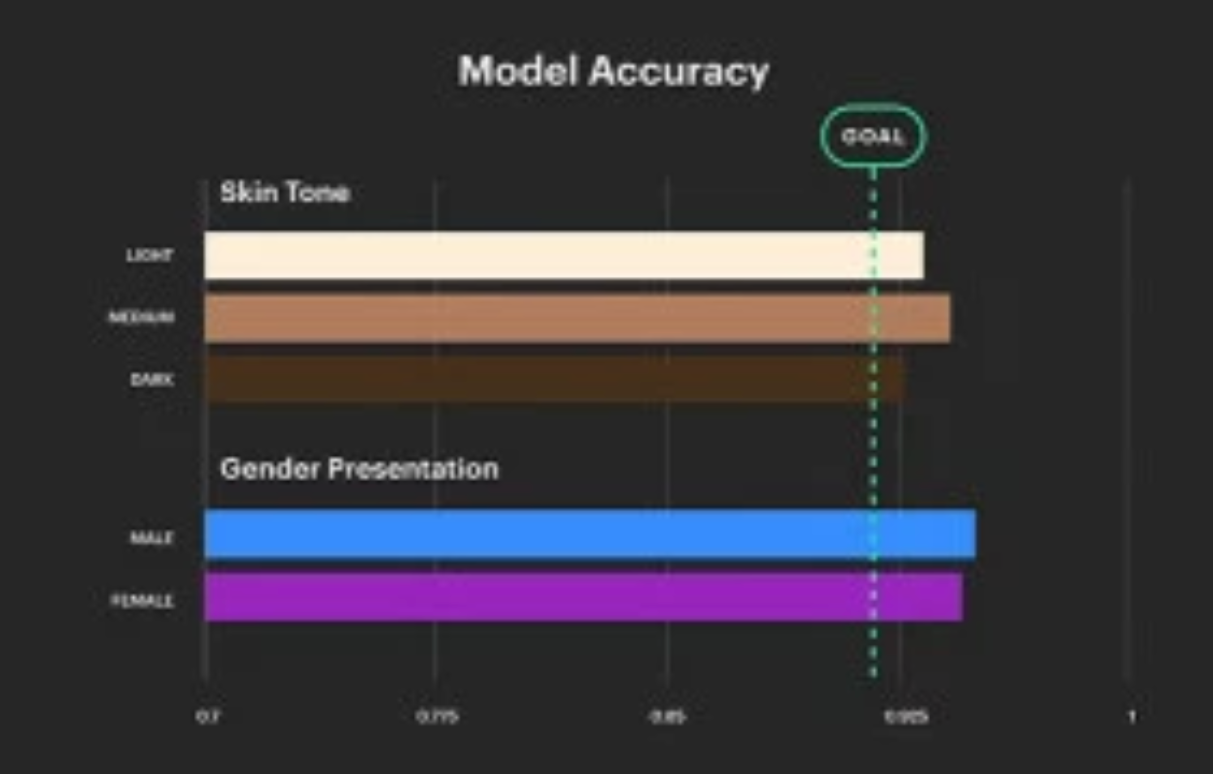

當臉書把包容性考慮進人工智慧的訓練時,發現原本訓練Portal智慧相機模型的資料集,膚色以及性別的樣本分布不均,而樣本偏差會使得訓練出來的人工智慧服務,不完全適用於真實世界,因此Portal團隊重新調整了資料集,使用更加平均的性別、年齡和膚色樣本,並在驗證以及訓練模型時,遵守包容性人工智慧指南,以最大程度降低Portal智慧相機模型可能出現的風險。

Lade Obamehinti為臉書建立了一套程序,來描述包容性人工智慧,其包含使用者研究、演算法開發以及系統驗證,使用者研究用來分析產品功能在不同的人出現的各式回應,演算法則是關於資料集設計、訓練與評估,而系統驗證則專注於效能表現以及各項體驗上。在過去一年中,臉書內部開始將包容性人工智慧程序,導入到開發流程中,用來確保臉書與Instagram的照片濾鏡,在各式膚色與因素下都能良好運作,Messenger中的AR特效,在各種臉部形狀與膚色都能正確的表現。

但臉書也提到,並非每種應用都能應用包容性流程,因為在某些領域上,整個行業都沒有足夠具代表性的資料集,為了解決這樣的問題,臉書正在推動建立全球使用者研究,將包容性人工智慧測試擴展到聲音上,臉書表示,聲音資料集需要考量方言、年紀以及其他更多的屬性,才足以建立能夠聽懂不同人們說話的人工智慧。

機器學習的包容性議題持續受到關注,特別是當機器學習的應用影響人們權益或是生命時,像是去年美國警方開始使用AWS Rekognition的人臉辨識服務,美國公民自由聯盟(American Civil Liberties Union,ACLU)指稱系統存在辨識誤差,可能對無辜的人造成負面影響。另外,Google與美國軍方合作的Maven計畫,以人工智慧辨識無人機拍攝的物體,並以導彈摧毀這些物件,電子前線基金會(Electronic Frontier Foundation,EFF)則表示,人工智慧仍處於難以控制的階段,可能造成不必要的傷害。

也越來越多的學者提出對於人工智慧的不信任,萊斯大學電腦科學副教授Genevera Allen發現,科學研究使用機器學習分析資料,但由於找到的模式只會存在於資料集,而非來自真實世界,將模式直接套用在真實世界,則會得到錯誤的結果。而臺大資工所助理教授陳縕儂則提到,人工智慧之所以存在偏見,是因為人們存在意識偏見,人工智慧只是真實的學習人們提供給他們的資料。

熱門新聞

2026-02-11

2026-02-11

2026-02-09

2026-02-10

2026-02-10

2026-02-06

2026-02-10