Mistral AI

法國AI新創公司Mistral AI上周公布開源高速、低延遲的模型Mistral Small 3 24B,效能超越參數量3倍大的Llama 3.3 70B。

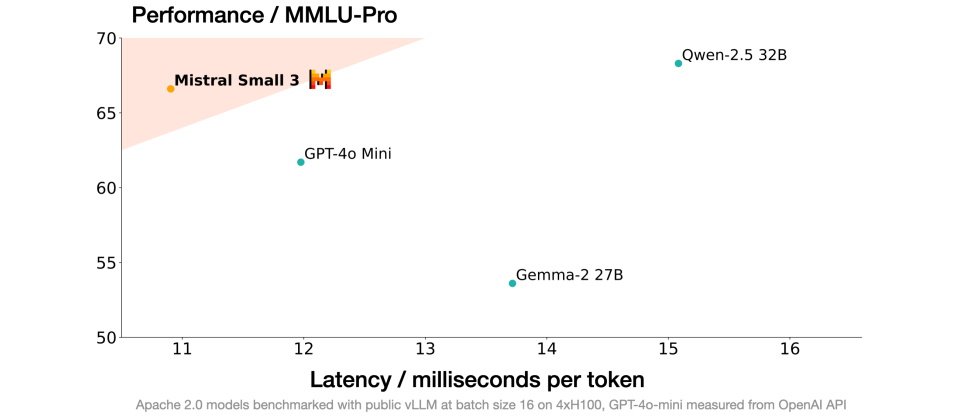

Mistral Small 3是為了能完成80%生成式AI任務而以指令預訓練的模型,參數量240億,以便在本地部署且仍能提供強大效能。Mistral表示,Mistral Small 3比競爭模型少很多層,大幅縮短每次前向傳遞(forward pass)的時間。它在MMLU測試精準度達81%,延遲性為150 token/s。Mistral Small也是目前同類別中最有效率的模型。

以標竿測試表現而言,Mistral Small 3在MMLU、Math、GPQA Main都超越Llama 3.1 70B和Google Gemma 2 27B,而在不同語言的MMLU測試中,Mistral Small也都超越Llama 3.1 70B及Gemma 2 27B(但落後於Qwen 2.5-32B)。

這家新創公司指出,Mistral Small 3 24B模型適用場景包括反應快速的口語協助、低延遲的函式呼叫、微調後自建特定領域專家、以及在PC或Mac平臺上執行本地推論。經過量化(quantized)壓縮的Mistral Small 3可執行在單一顆RTX 4090或一臺具32GB RAM的MacBook上。該公司稱Mistral Small 3已有金融、醫療、機器人/自動化/製造業客戶評估中。水平使用場景則包含客服和情感與回饋分析。

Mistral以Apache 2.0授權開源預訓練和指令微調的check point版本。這些checkpoint版本可作為其他開發人員改進的基礎。業者相信,和最近爆紅的開源推理模型像是DeepSeek類似,Small 3也可促進AI推理能力的演進。

但Mistral提醒,Mistral Small 3不是以強化學習和合成資料訓練,因此在AI模型產製上屬於較前期結果,不像新興的DeepSeek R1那麼成熟。

Small 3 24B模型已以Apache 2.0授權在la Plateforme開源,顯示名稱為mistral-small-latest或mistral-small-2501。Mistral AI同時也公告,該公司逐漸捨棄非傳統開源MRL授權,因而其通用模型也將改用Apache 2.0授權。因此連同Mistral Small 3,其模型權重也可開放下載於本地供自由修改和使用,或在la Plateforme開放Mistral AI本地部署及VPC環境、客製化和協同平臺、以及其推論與雲端合作夥伴平臺上以serverless API存取。需要特殊能力(像是加快速度和加大context、特定領域知識、特殊任務能力如完成程式撰寫等)的企業和開發人員,也可以在Mistral Small 3之外再使用額外的商用模型補強。

Mistral AI也和AI平臺包括Hugging Face、Ollama、Kaggle、Together AI、IBM watsonx和Fireworks AI等合作上架Small 3模型。不久之後也會在Nvidia NIM、Amazon SageMaker、Groq、Databricks和Snowflake上架。

熱門新聞

2026-02-09

2026-02-06

2026-02-09

2026-02-09

2026-02-09

2026-02-10

2026-02-09