當使用AI打造更多元的服務,成為現在企業的常態,企業不再只是關注AI可以應用的面向,更是進入到如何做可以更好的階段。臺灣知名的社群網路平臺「痞客邦」(PIXNET)就是一例,近年他們不僅是開發各式AI服務與演算法,例如,個人化文章推薦的演算法、興趣族群演算法等,為使用者推薦感興趣的主題,也讓擁有相同興趣的人,能有更好的交流與互動方式,甚至他們為了讓AI服務上線可以更即時,增加社群網站競爭力,因此希望縮短演算法部署上線的過程。

鑑於AI的需求,痞客邦已經成立研究團隊,負責相關演算法的開發工作。在今年5月中舉行的臺灣雲端大會上,PIXNET研發中心資深高級工程師賴義偉,更是進一步揭露了他們的團隊的組成,目前他們共有5位演算法工程師、2位資料分析師,以及1位數據工程師。而他們的任務,就是開發各式AI服務和演算法。

目前,在痞客邦社群網站上,已經有不少他們團隊的成果上線,賴義偉舉例說明,像是他們開發了垃圾(Spam)文章偵測演算法,原因在於,痞客邦目前站上有超過8億篇文章,每天新增就有40幾萬篇,若是要人力一個個審核顯然不太可能,因此利用演算法去偵測這些文章相當重要,快速判斷那些是垃圾文章,或者是優質文章。

最近,他們開發了個人化文章推薦演算法,當用戶進入痞客邦首頁時,將可以看到一個興趣牆的文章建議,這是根據用戶追隨與興趣主題所推薦出來。另外,他們也開發圖片辨識的演算法,目的是為了想要知道,那些圖片呈現在預覽頁面的效果較好,並且研究圖片風格轉換的演算法,希望能進一步豐富部落格所呈現的內容。

此外,還有像是關鍵字的主題分析服務、文章標記(Tag)搜尋服務、Chatbot數據指令服務,以及性別年齡預測演算法與興趣族群演算法等。

為加速服務部署上線,借助SRE介入程度低的App Engine

值得注意的是,在這次臺灣雲端大會上,賴義偉特別分享了使用雲端技術,來加速AI服務上線過程的經驗。

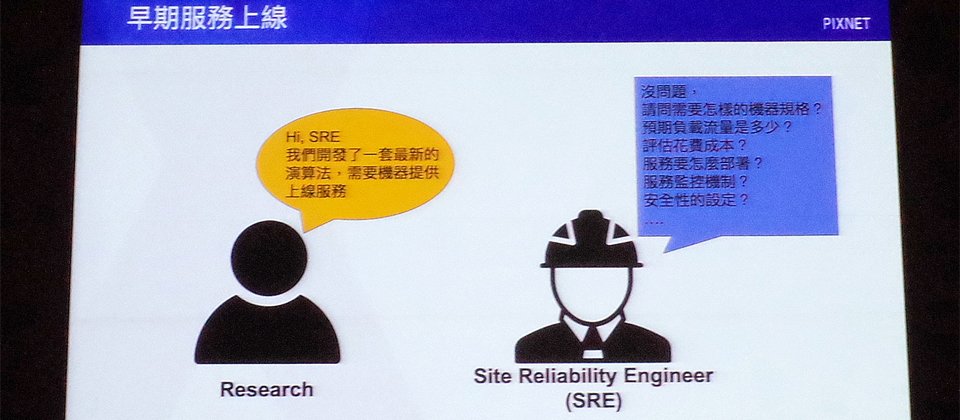

在AI服務上線流程方面,過去他們的流程較為繁瑣。當研究人員開發了一套最新的演算法,需要機器提供上線服務,這時在流程上會需要向SRE(Site Reliability Engineer)工程師申請,但往往過程會花上不少溝通時間。例如,詢問需要的機器規格?預期負載流量、花費成本是多少,還有服務部署、監控與安全性設定的問題等。

賴義偉說明,由於SRE的工作常常處於到處救火的狀態,再加上開發人員也要對他們的網路架構系統有一定瞭解,而團隊也有一些非本科系出身的成員,在這些因素之下,溝通更花時間,因此,若是新的演算法服務上線,開發人員往往都要七天或是更久,才能拿到要的資源。

而在使用的雲端服務方面,由於Pixnet使用的是Google Cloud Platform(GCP)平臺,因此他們是以此平臺來說明,在他們的AI服務應用與人力配置情況下,選擇GCP平臺服務的經驗。

基本上,GCP平臺主要服務包括Compute Engine、App Engine與Kubernetes Engine這三大類型。大約在兩年前,他們開始採用最新的Kubernetes,只是,他們遇到幾個挑戰,例如,因為一些分析服務只有在工作時間使用,造成資源利用率不佳,而且他們對Kubernetes的特性還不是那麼熟悉,更關鍵的是,在演算法開發工程師開發完要部署時,流程不夠簡潔。

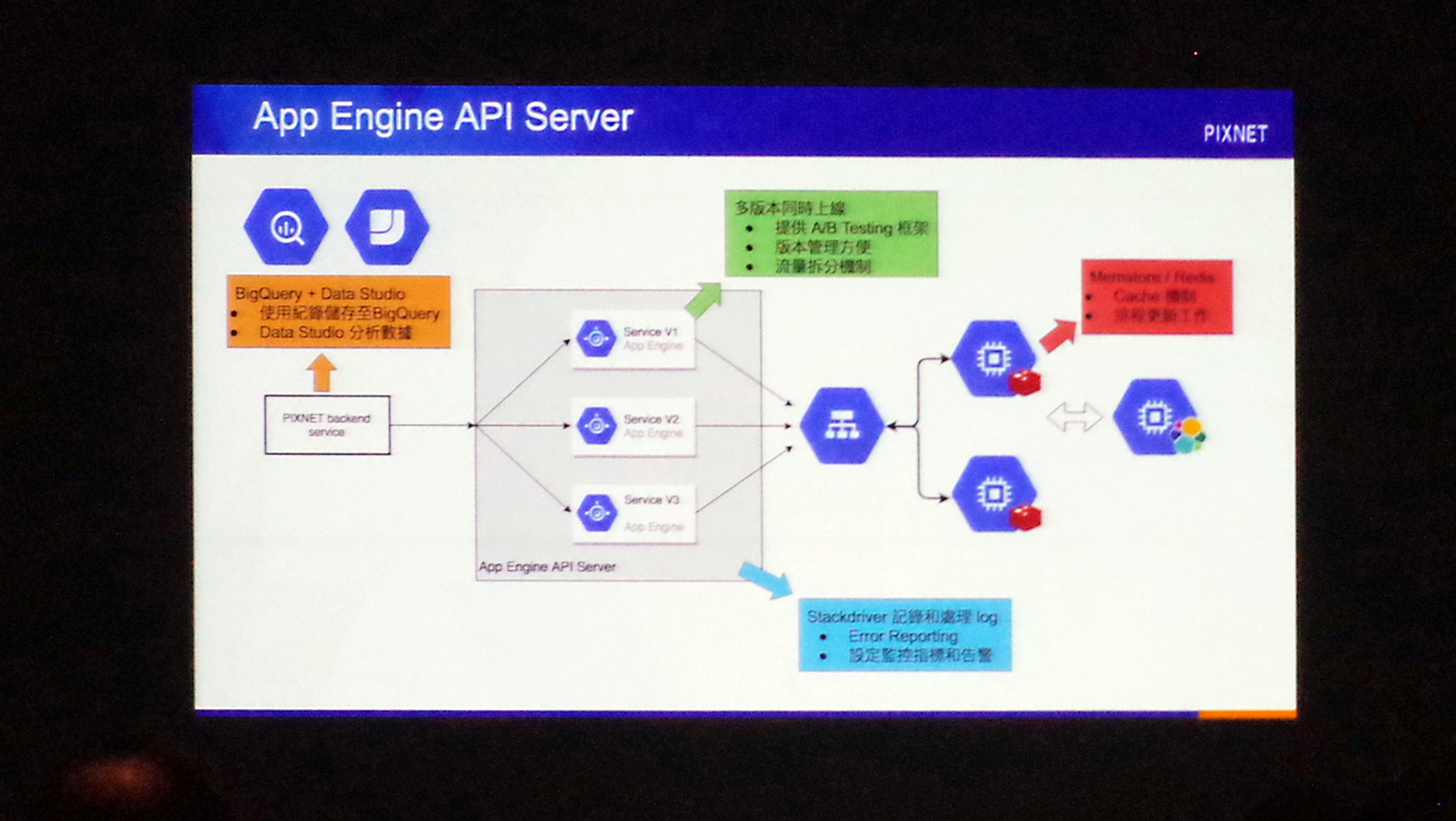

因此,他們再次思考加速開發方法,進而發現App Engine的一些特性,其實很適合讓開發者將AI演算法直接上線。其中最重要的就是,這是全代管的環境,並可以減少SRE人員的介入,最終讓他們新開發的AI演算法,能在一天內就能完成上線。

賴義偉並表示,現在他們已經藉此方式優化搜尋服務,期望能提升站內搜尋點擊率,創造更多自主流量。

儘管各業者使用的雲端平臺,以及開發政策與人員編制都不盡相同,但以Pixnet的經驗而言,在開發AI服務與演算法這一方面,不僅是加速服務部署上線,賴義偉更是指出,開發快速且部署方便,這意謂著可以容易產生大量測試版本,因此他們能夠每日觀察AI演算法各版本的表現,以挖掘問題。如此一來,也等於是讓AI服務要做到更精準的過程可以更簡便。

熱門新聞

2026-02-11

2026-02-11

2026-02-12

2026-02-09

2026-02-10

2026-02-10

2026-02-06