Google臺灣董事簡立峰指出,未來智慧型手機將會由語音助理主導,而以關鍵字搜尋引擎(Search Engine)起家的Google,致力要成為以語音為主的搜尋代理(Search Agent)。

攝影/王若樸

「15年前,Google AI大神Jeff Dean花了45分鐘面試我,問了一題『類神經網路能否用來打造語言模型』。」在Google任職15年的Google臺灣董事簡立峰指出,這個題目,正是這幾年學術界發展自然語言處理(NLP)和語音辨識的關鍵,而現為Google Brain總負責人的Jeff Dean,早在15年前就看出了,近來Jeff Dean更指出「2018年是NLP的黃金歲月。」

早在15年前,Google就已進行多項自然語言相關專案。簡立峰初進Google的第一項專案,就是利用純統計方法,自己打造一款中文機器翻譯(Machine Translation)系統。後來,隨著團隊成員增加,他帶領位於北京、臺灣和美國的Google搜尋中文團隊,來開發更多相關功能和應用,比如斷詞(Word segmentation)、拼字確認(Spelling checking)、輸入法編輯器(IME)、中文搜尋建議和排名,甚至包括Google第一代中文語音辨識。

當時,AI第三波大浪尚未掀起,Google所有AI的開發方法都採用統計模型。「我們內部曾大幅爭論,Google高階主管建議團隊千萬不要使用類神經網路。」簡立峰笑著說,當時爭論的最大原因,是由於類神經網路的不可解釋性,對產業歸責有著極大影響。甚至到今天,雖然目前有新方法可加強AI解釋性,但演算法黑盒子依然是道難題,讓特定AI應用難以通過如GDPR等法規的要求。

2009年,Google撤離中國市場後,中文的自然語言專案便從Google內部消失。但簡立峰另起爐灶,重新組織Google中文研發團隊,並擔任管理職務。到現在,臺灣分部已有3,000名員工(包括1,800位來自HTC團隊成員),9成負責全球技術研發,包括Google手機、Chromebook筆電,以及Google作業系統等,甚至「在臺灣就有200多位Kernel工程師,他們寫的任何一行程式碼,就改變流通全世界的Google服務,」簡立峰坦言。

除了這些領域,他也提到Google著重的NLP領域,其中之一便是機器翻譯(Machine Translation)。2013年時,任職於Google的電腦科學家Tomas Mikolov帶領團隊開發一套文字向量化的模型Word2vec,透過將文字映射到向量空間,來表示字與字之間的關係,這也成為日後打造NLP應用的重要基石。

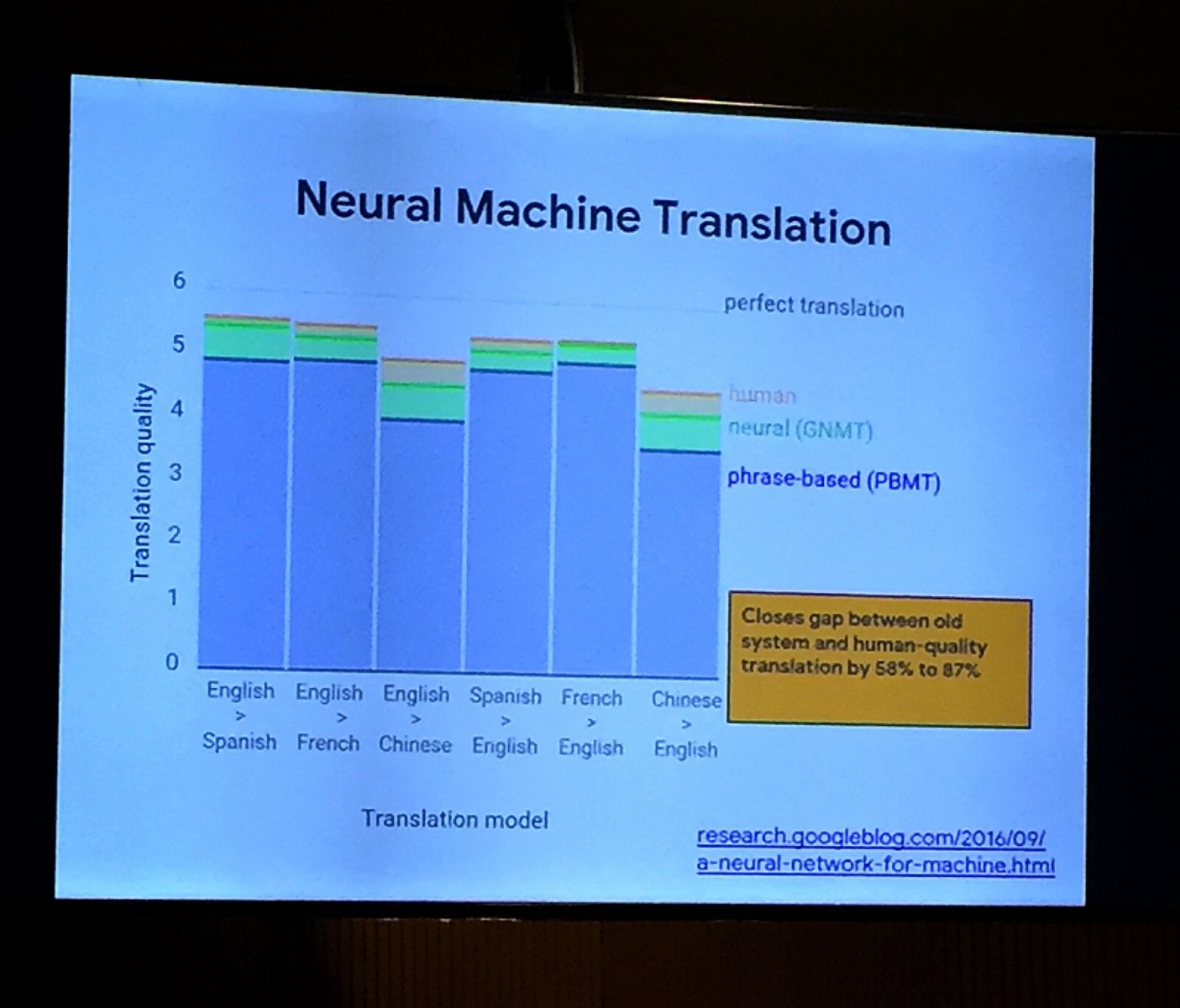

在這個基礎上,2016年,Google首次在訓練機器翻譯的傳統統計方法中,加入類神經網路,大幅提高機器翻譯的表現。Google研究顯示,就中翻英來說,類神經網路表現已與人類相差不遠;就法翻英來說,表現更是不相上下(如下圖)。此外,研究還發現,傳統機器翻譯系統,需要工程師寫上成千上萬行程式碼,但透過「機器學習和TensorFlow,只需要幾百行,」簡立峰說。

去年底,Google在NLP領域創下另一個里程碑,打造並開源一套NLP預訓練新技術BERT,是首個深度雙向、非監督式的語言表示方法,只使用純文字資料資料庫來進行預訓練,模型效能更在11項標竿測試中,拿下新高分。BERT的開源,更加速開發者打造NLP模型的時間,不需要從頭開始訓練模型。

不過,就在上個月,Google Brain團隊改善了BERT模型,進一步釋出更強大的NLP預訓練技術XLNet。XLNet是一套自迴歸訓練方法,和BERT一樣,可雙向學習上下文,但XLNet的自迴歸公式克服了BERT的不足,不只在20項測試中勝過BERT,比如GLUE語言理解測試、SQuAD閱讀理解測試、情感分析和文字分類評比等,其中更有18項達到SOTA等級,創下新紀錄。XLNet的開源,不僅將加速NLP模型的開發周期,也提供表現更佳的NLP模型選擇。

Google AI語言應用的野心,不只如此。看好未來10年至20年,智慧型手機將由語音助理主導,Google以此為目標,要從關鍵字搜尋引擎(Search Engine)進化為以語音為主的智慧型搜尋代理(Search Agent)。

自然語言理解不到位,AI閱讀理解是良機

「許多AI技術也許不及人類,但應用卻無限。」簡立峰指出,類神經網路方法在某種程度上,可算是映射(Mapping)方法,像是「輸入值是A,輸出值是B,模型學久了,就會映射A與B的關係,進而能夠預測,」應用場景比如圖像分類、語言翻譯。

但他話鋒一轉,以自然語言理解(NLU)領域來看,目前類神經網路仍無法藉由抽取輸入值元素,來找出彼此間的邏輯關係,比如從「張三打李四」句子中,映射出張三為動作者、而李四則為接受者。因此,「自然語言理解的任務,不能靠類神經網路來完成。」簡立峰解釋,對類神經網路來說,要執行一個命令及其後續的數個動作,非常困難,以聊天機器人來說,「世界上沒有任何一個Chatbot,能做出Long section-based的回應。」

也就是說,聊天機器人無法應付長時距回應,像是客戶先打電話到銀行客服提出帳戶問題,掛斷後再致電時,聊天機器人無法主動追問處理狀況;甚至「一個句子問好幾個動作後,Chatbot就沒有預測的能力了。」

雖然機器學習在NLU上有其侷限,但簡立峰認為,機器學習應用於文字閱讀理解(Reading comprehension),相當有潛力,尤其是「全球面臨資訊爆炸,」需要有能夠快速閱讀、篩選資訊的工具,特別是醫學資訊領域。在他看來,醫學資訊量快速成長,但醫生時間有限,要是有個能不斷閱讀醫學文獻的機器人,並從中給予醫生治療建議,「就會是個成功的應用場景。」

另一個閱讀理解很有潛力的應用場景,則是法律合約。簡立峰提到,全球知名的律師事務所Baker McKenzie在2年前就開始導入AI,其中之一就是AI合約生成工具,可根據客戶需求和條件,來快速擬定合約草稿,節省傳統人工作業所需的數小時與金錢成本。

Google AI布局三大面向:基礎技術、智慧醫療、自駕車

自簡立峰加入Google 15年來,Google全球員工從3,000人成長至20萬人,公司結構也隨之變化。2015年,Google組織重整,成為Alphabet集團中13家子公司之一。簡立峰提到,整個集團在AI分工上,可分為三個層面,包括了基礎技術研究、智慧醫療研究、自駕車研究。

在基礎技術研究上,由Google Brain和DeepMind負責,其中,Google Brain是由1,000多位科學家組成的AI研發團隊,當中有數十位來自臺灣,「都扮演非常關鍵的角色,比如打造推薦系統的紀懷新。」簡立峰指出,20、30年前,Google就開始研究電子商務的自動推薦系統,而Google Brain首席研究員紀懷新這3年來利用機器學習優化了推薦系統,並應用於YouTube、Google Play商店、廣告和Google搜尋等近70項產品和服務。簡立峰表示,近年數據更點出了推薦系統的重要性,因為它貢獻了Google近10%的年營收,「一套推薦系統演算法,就為Google賺進了130億美元。」

在智慧醫療研究層面,則由Calico和Verily負責。先前,Verily與Google Brain聯手研發一款AI技術,結合了驗光機,可輔助非眼科醫生判斷糖尿病病患眼疾的嚴重程度,包括視網膜病變(DR)和黃斑部水腫(DME)2種。該技術除了通過歐盟監管單位核准,目前也已於印度和泰國展開臨床應用計畫。

至於自駕車研究部分,則由Waymo負責。簡立峰指出,目前Waymo已有600輛自駕車於全美25個城市行駛,每天行駛的總距離高達40,233公里。此外,他還強調,Google今年將成為全美「最大的計程車租賃公司,」將在美國推出8萬2千輛無人計程車,服務客戶。文◎王若樸

熱門新聞

2026-02-11

2026-02-09

2026-02-10

2026-02-11

2026-02-06

2026-02-10

2026-02-10

2026-02-10