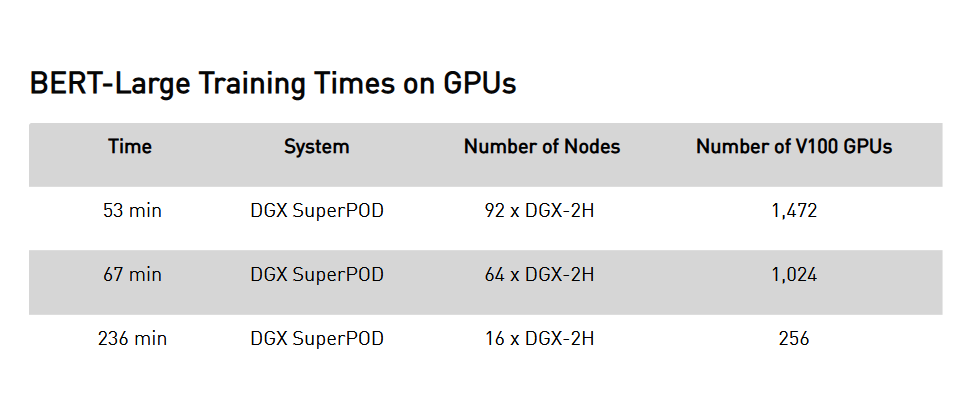

根據Google今年5月發表的論文,他們宣稱訓練BERT-Large的時間為76分鐘。近期Nvidia更宣布他們的超級運算平台DGX SuperPOD可以縮短到53分鐘。不過,在該平台上訓練BERT-Large的時間,是根據所使用的節點與V100 GPU數量而定,要達到53分鐘的速度,必須仰賴92個DGX-2H 節點與1,472個V100 GPU,若只使用64個節點及1,024個CPU,所需時間為67分鐘,若是16個節點與256個CPU,則得耗上236分鐘。(圖片來/Nvidia,https://devblogs.nvidia.com/training-bert-with-gpus/)

Nvidia本周對外展示該公司超級運算平台Nvidia DGX SuperPOD的新成就,指出該平台刷新了全球紀錄,只花了53分鐘來訓練BERT-Large自然語言模型,也以Nvidia DGX SuperPOD來訓練參數多達83億的GPT-2 8B模型。

BERT的全名為Bidirectional Encoder Representations from Transformers,為Google所打造的自然語言處理預先訓練技術,它的特點在於所預先訓練的資料,並非具備標籤的資料,而是任何純文字,例如它能直接使用英文版維基百科進行訓練,因而可提高準確度,但資料量卻相對龐大。而BERT-Large則是目前最大的BERT模型,具備3.4億個參數。

根據Google在今年5月公布的論文,該公司利用新的LAMB大批量優化技術,與專為機器學習打造的Cloud TPU v3 Pod超級運算平台進行訓練,把BERT-Large的訓練時間,從3天縮短到76分鐘。

而Nvidia的DGX SuperPOD則只花了53分鐘。不過,在該平台上訓練BERT-Large的時間,是根據所使用的節點與V100 GPU數量而定,要達到53分鐘的速度,必須仰賴92個DGX-2H 節點與1,472個V100 GPU,若只使用64個節點及1,024個CPU,所需時間為67分鐘,若是16個節點與256個CPU,則得耗上236分鐘。

有鑑於參數愈多,模型的預測就會愈準確,Nvidia也研究了Google用於翻譯的Transformer機器學習架構,發表了Megatron專案,並將原本只有15億個參數的GPT-2模型擴大到83億個參數,建立了更巨大的GPT-2 8B模型。GPT-2 8B模型的規模是GPT-2的5.6倍,更達到BERT-Large的24倍。

Nvidia同樣利用了DGX SuperPOD來訓練GPT-2 8B,而這也是史上曾被訓練的最大Transformer語言模型。

Nvidia表示,基於Transformer的語言模型與預先訓練都需要強大的運算平台,以處理所有的必要運算並確保執行速度及準確性,這些可在未標記資料集上運作的模型,已成為現代化自然語言處理的創新中心,並將延伸成為新一波智慧助理的重要選擇,以支援牽涉到對話AI的各種應用。

熱門新聞

2026-02-11

2026-02-09

2026-02-11

2026-02-10

2026-02-10

2026-02-06

2026-02-10

2026-02-10