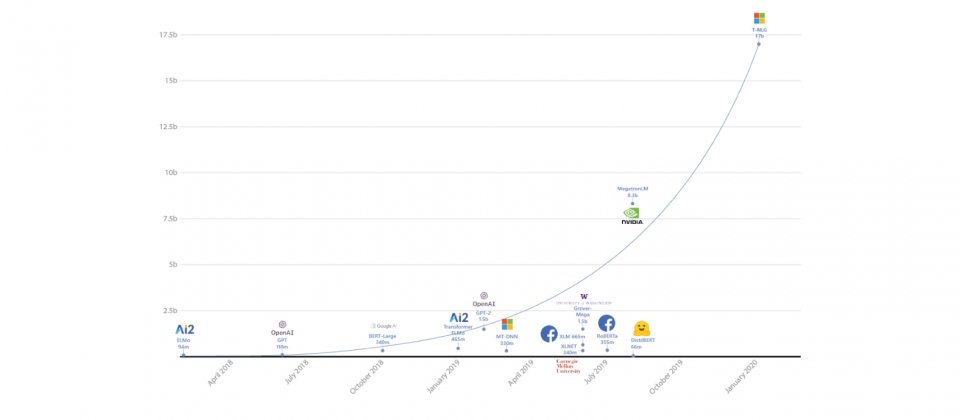

微軟T-NLG模型的參數數量,遠高於第二名模型的參數數量

微軟發表最新語言產生模型T-NLG(Turing Natural Language Generation),該模型具有170億個參數,遠高於BERT與GPT-2等知名模型,在神經語言任務的表現上也都更好,為語言產生模型技術設立了一個新的標竿。目前微軟向學術與研究人員釋出T-NLG範例,展示其自由格式生成、問答以及總結等能力。

無論是Google的BERT模型抑或是OpenAI的GPT-2模型,皆具有幾十億個參數,已經大幅改善自然語言處理能力,而更好的自然語言生成能力,可以應用在各種應用程式上,協助作者撰寫內容、總結文字或是改善數位助理的的使用者體驗。過去的問答或是摘要系統,都是直接從文件中擷取現有內容,但是產生的結果通常不夠自然或是不連貫,而借助語言產生模型,則能夠產生更自然的結果。

微軟提到,模型越大,預訓練資料越多樣化越全面,得到的結果也就越好,而且訓練一個大型集中式的多任務模型,用在處理各種任務,比起為每種任務訓練個別的模型更為有效率。因此微軟建立了基於Transformer,有史以來最大的語言產生模型T-NLG,可生成單詞以完成開放式的文字任務,除了補完不完整的句子之外,還可以回答問題與總結文件等。

而微軟之所以可以產生這麼大的模型,是因為硬體和軟體技術的突破。凡是超過13億個參數的模型,都無法放進單個GPU,因此大型模型必須要可以分解成多個部分,並在多個GPU之間平行處理。微軟使用Nvidia DGX-2配置,以InfiniBand連接加速GPU之間的通訊,並且使用Nvidia Megatron-LM框架,以張量切分(Tensor Slicing)技術分片模型到4個V100 GPU上。

另外,微軟也運用DeepSpeed函式庫以及ZeRO最佳化方法,使每個節點的批次處理大小能夠增加4倍,降低模型平行化維度從16降至4,有效降低3倍訓練時間。DeepSpeed是一個能夠降低模型延遲,和提升預測效率的深度學習函式庫,微軟表示,DeepSpeed讓他們使用更少的GPU訓練大型模型。而ZeRO則是一種記憶體最佳化方法,用於訓練擁有上兆參數的模型。

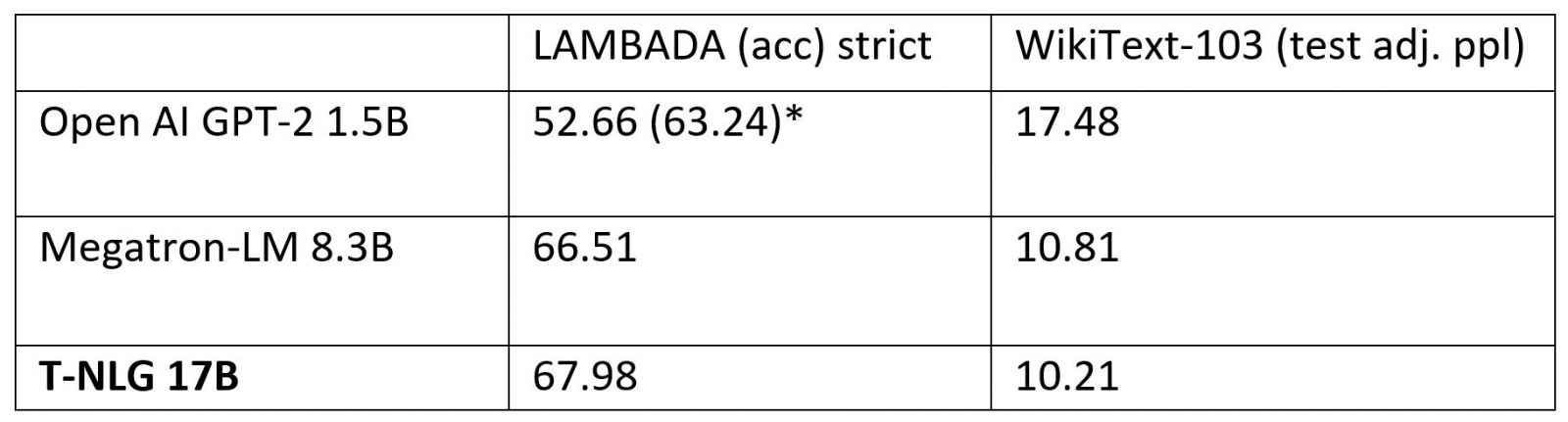

與其他模型相比,在標準語言任務WikiText-103量測指標困惑度的表現,T-NLG比OpenAI的GPT-2和Megatron都還要低,而LAMBADA的下一個單詞預測精確度,也比另外兩個模型表現還要好。T-NLG還能應付零次問答,也就是T-NLG模型不需要上下文,就能夠直接給出問題的答案,而這完全仰賴預訓練過程的知識來生成答案。

T-NLG能夠像人類一樣產生文件摘要,微軟提到,自然語言處理產生摘要的方法有兩種,一種是擷取文件中少量的句子,作為產生摘要的基礎,另一種則是像人類一樣,以抽象的方式產生摘要。而模型以抽象方式產生摘要的困難,在於缺乏監督式訓練資料,但T-NLG的優勢是非常了解文字,因此不需要太多監督式訓練,就能勝任文字總結的工作。

T-NLG模型將被用在微軟的各種服務上,包括總結文件和電子郵件,以節省用戶的時間,也會被用於微軟Office中,為用戶提供寫作協助,或是為文件產生常見問答,進一步T-NLG還將用在聊天機器人與數位助理上,用於協助提升銷售與客戶關係管理效率。

熱門新聞

2026-02-09

2026-02-06

2026-02-09

2026-02-09

2026-02-10

2026-02-09

2026-02-10