臉書與9個國家13所大學合作,創建了第一人稱視角資料集Ego4D,這個資料集由超過700位計畫參與者,佩戴攝影機以第一人稱視角收集了超過2,200小時的影片,臉書提到,單就影片長度來看,這個資料集比起過去任何資料集都大上20倍以上。這些影片可被用於模型訓練,讓人工智慧能以第一人稱學習事物。

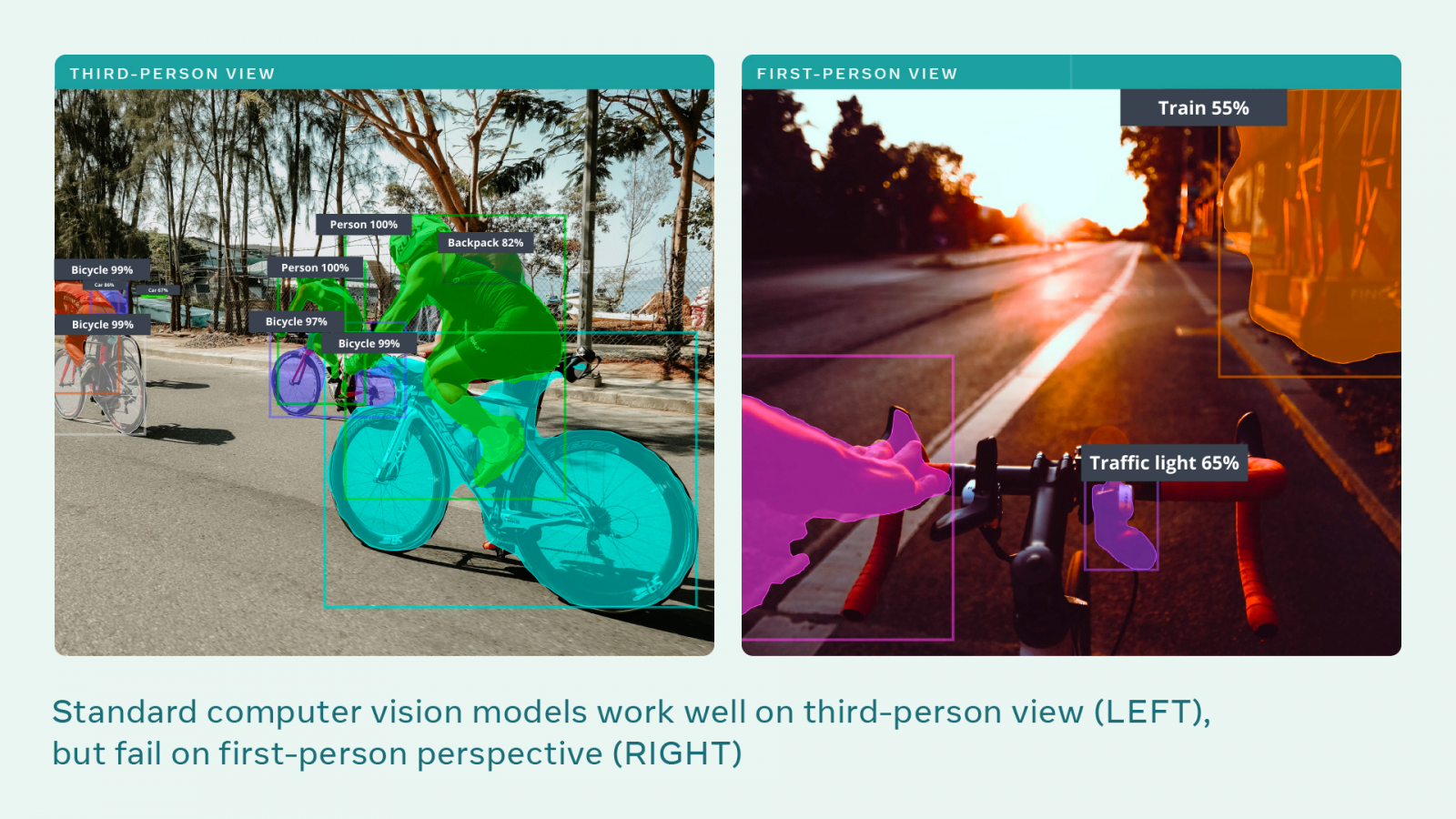

研究人員以坐雲霄飛車的例子,來說明第一人稱視角影片的重要性,他們提到,在雲霄飛車上和在地面上看著雲霄飛車,視野是完全不同的,雖然人類很容易將第一人稱和第三人稱視角關聯起來,但是目前的人工智慧並沒有這樣的理解能力,雖然也能夠將電腦視覺系統,綁在雲霄飛車上拍攝畫面,也能夠收集非常多類似的影片,但是電腦並不知道自己在看什麼,或是應該看什麼。

臉書首席科學家Kristen Grauman提到,下一代人工智慧系統需要從完全不同類型的資料中學習,影片應該是從產生行動的中心拍攝,而非來自旁觀者角度。他還提到,人工智慧要以人類的方式與世界互動,並且以第一人稱感知範式發展。簡單來說,就是教人工智慧透過人眼理解人類日常生活活動。

Ego專案提供研究人員必要的工具和基準,以促進研究,並推動以第一人稱為中心的前端感知研究。研究人員提到,基準和資料集是人工智慧創新的關鍵,當前電腦視覺系統辨識物體的能力,建立在諸如MNIST、COCO和ImageNet等資料集之上。

而第一人稱感知是全新的領域,過去的工具無法提供必要的創新,Ego4D則具有前所未有的規模和多樣性。研究團隊向合作大學的研究參與者,發送頭戴攝影機和其他可穿戴感測器,以便捕捉他們第一人稱、無腳本的日常生活,像是購物、烹飪或是玩遊戲交談等。

影片資料集捕捉了佩戴相機者所關注的內容,以及與其他人互動的第一人稱視角,研究人員提到,Ego4D資料集的重點擺在相機佩戴者所進行的數百項活動,以及與數百種不同物體互動。參與收集Ego4D資料集的參與者,來自英國、義大利、印度、日本、沙烏地阿拉伯、新加坡、哥倫比亞、盧旺達和美國,職業和性別各不相同,與現有的資料集相比,Ego4D提供了場景、人物和活動的多樣性,能夠訓練針對不同背景、種族和年齡的模型。

有了這些資料,就能依據文化和地理背景差異,提供第一人稱的視覺體驗,像是未來人們佩戴AR眼鏡,並且接受人工智慧助理指導烹煮咖哩,系統便能辨識出因地區而異的咖哩烹煮方法。

Ego4D擁有5個基準,分別是情景記憶、預測、手和物體操作、視聽分類、社交互動,這些基準將能夠促進人工智慧助理的研究。Ego4D資料集將會在11月的時候發布,授予簽署資料使用協議的研究單位使用。

熱門新聞

2026-02-06

2026-02-06

2026-02-06

2026-02-06

2026-02-09

2026-02-09

2026-02-09