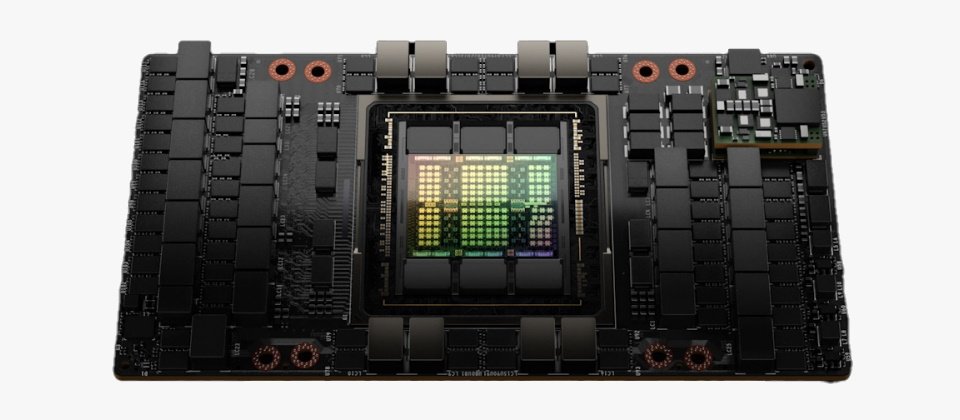

Nvidia發表將接替Ampere的新一代Hopper架構,以及首款基於該架構的H100 GPU。(圖片來源/Nvidia)

Nvidia於本周舉行的GTC會議上發表了新一代的Nvidia Hopper架構,以及首款基於該架構的Nvidia H100 GPU。

Nvidia Hopper將接替兩年前發表的Nvidia Ampere架構,但採用第二代的安全多實例GPU(Multi-Instance GPU,MIG)技術,允許單一GPU可被分成7個更小且隔離的實例來處理不同型態的任務,Hopper架構得以在雲端環境中於每個GPU實例上提供安全的多租戶配置,而延伸最多7倍的MIG能力。

此外,該架構也是為了加速新一代AI任務而設計,具備強大的運算能力及快速的記憶體,以處理日益增加的網路與資料集;架構中的Transformer Engine亦將加快AI效能,把訓練龐大模型的時間從數天縮短至數小時。

採用Hopper架構的H100採用台積電4奈米製程,配備超過800億個電晶體,是首款支援PCIe Gen5及首款使用HBM3的GPU產品,提供每秒3TB的記憶體頻寬,號稱只要20個H100 GPU就能支撐全球的網路流量,允許客戶得以根據即時資料進行推論,提供先進的推薦系統與大型語言模型。

Nvidia宣稱H100改善了AI推論及訓練能力,可藉由超大規模的AI模型來執行即時與沈浸應用,讓聊天機器人使用全球最強大的可客製化語言模型Megatron 530B時,且其吞吐量最高可達前一代的30倍,同時滿足即時對話AI所要求的亞秒級延遲。

現階段包括阿里雲、百度智能雲、AWS、Baidu AI Cloud、Microsoft Azure、Oracle Cloud與騰訊雲,都已計畫要採用基於Hopper架構的Nvidia H100 GPU實例。

熱門新聞

2026-02-13

2026-02-13

2026-02-13

2026-02-13

2026-02-13

2026-02-13