微軟首席科學長Eric Horvitz在其最新的Deepfake研究論文中,提到需要注意兩種新型態的Deepfake威脅,分別是互動(Interactive)以及合成(Compositional)Deepfake,同時他也預測,不久之後將會出現實際應用這兩類Deepfake手法的攻擊,並且對社會產生成本高昂的影響。

互動式Deepfake是利用多模態互動,來模仿具有真實互動行為的人,要建構互動式Deepfake系統,需要一組多模式互動技術,包括生成性人工智慧方法,以高傳真的方式渲染姿勢、表情,甚至是語音。

MosaicML研究科學家Davis Blalock則在推特上,進一步說明了互動式Deepfake可能帶來的實際影響,Davis Blalock提到,互動式Deepfake並非靜態內容,可以讓人產生與真人交談的錯覺。攻擊情境可以發生在像是詐騙集團以晚輩身分撥打視訊給家中長輩,利用晚輩的長相和聲音騙取金錢等,惡意人士不只可以假扮成家人,也可以是任何熟人,但其背後實際上可能僅是一個機器人。

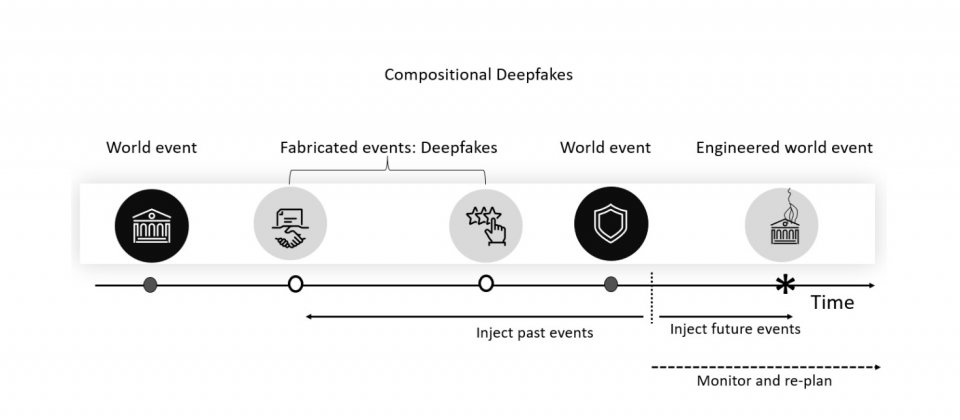

另一種合成Deepfake,則是Eric Horvitz更為擔憂的攻擊手法,因為可以創造出更大規模,更有影響力的虛假訊息內容。有心人士可以利用Deepfake策略性的與真實世界事件搭配,創造出精心編造的故事,而Davis Blalock解釋,合成Deepfake可能被用來編造一場從未發生過的恐怖攻擊,或是虛構的醜聞,甚至透過人造證據以及真實世界的行動,使陰謀論更加可信。透過現成的數位廣告機制,還可以針對人們精準投放錯誤資訊。

Eric Horvitz在論文中提到,政府、企業、研究人員以及各組織,應透過各種方式準備和防禦這兩類Deepfake威脅的興起。更為複雜的Deepfake應用將會提高人們對於新聞媒體的要求標準,同時閱聽人也需要培養媒體識讀素養,認識這些新威脅趨勢成為重要的事。另外,他也認為,可能需要建立一種驗證協定,在各種用例證明身分,並且在數位內容治理上,採用浮水印或是指紋,同時政府也需要制定法律監管,避免Deepfake技術被濫用等。

熱門新聞

2026-02-09

2026-02-06

2026-02-06

2026-02-06

2026-02-06

2026-02-06