中研院CKIP Lab

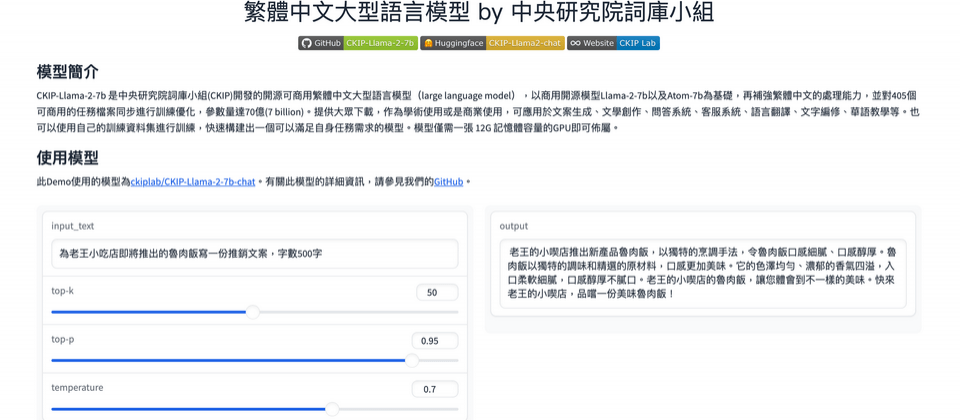

臺灣商用開源的繁中LLM模型現在有了新選擇!從事中文自然語言處理(NLP)研究的中研院CKIP Lab中文詞知識庫小組,最新開源釋出了以Llama 2開發的繁中優化的大型語言模型CKIP-Llama-2-7b,提供給臺灣學術圈或AI開發者來使用,可運用在文案生成、文學創作、問答系統、客服系統、語言翻譯、文字編修、華語教學。該模型已放上Github 和Huggingface開放給公眾使用,並採用Apache 2.0授權釋出。中研院搶先開放測試網頁,開放所有人測試。

Llama 2是由Meta在7月釋出的開源可免費商用大型語言模型,不到幾個月,Llama 2在開源LLM模型競賽中快速竄起,在Huggingface公布許多模型幾乎都是基於Llama 2衍生的模型,近幾個月在臺灣開始有企業以此推出商用模型服務,如台智雲開發了繁體中文版本的優化Llama 2模型,提供了70億、130億和700億參數的三種商用版本,以滿足企業客戶的需求。

幾個月前,來自中研院的CKIP Lab中文詞知識庫小組開始著手投入繁中優化的Llama 2模型的開發,他們以商用開源模型Llama-2-7b和簡中優化的Atom-7b為基礎,專注增強繁體中文的處理能力,通過對405個可商用的任務檔案進行訓練和優化,最終訓練出中研院的繁中優化的CKIP-Llama-2-7b模型。該模型擁有70億個參數。

相較於原本的Llama 2模型,CKIP Lab強調,該模型有4大特色,首先在多項繁中任務的處理比原來模型表現更好,其次,它可以很容易部署在本地裝置或設備上,例如僅需一張具有12GB記憶體容量的GPU,即可在離線的環境中執行,不需要依賴雲端等外部資源。此外,還開放使用者可以根據自身需求使用自己的訓練資料集,快速打造出適合自身任務需求的模型,更重要的是,採用對商用相當友善的Apache-2.0授權許可釋出。

CKIP Lab小組一共開發出兩個模型,一個是繁體中文預訓練後的CKIP-Llama-2-7b模型,一個是以前者為基礎,進行多任務微調訓練後的 CKIP-Llama-2-7b-chat模型。

中研院公開展示了經過多任務微調訓練的 CKIP-Llama-2-7b-chat 模型。例如,當你輸入「台灣最高的山?」,它可以回答「玉山」,甚至問他「在台灣,什麼是22K?」,模型都能夠提供相應的回答。此外,你也可以要求它針對台灣的特定主題進行討論。如「規劃一下日月潭二日遊」或是能用七言絕句吟詩作對。

其中,CKIP-Llama-2-7b使用了5.8GB資料進行預訓練,總共包含273萬筆資料,大約28億個token數。這些資料包括了中英維基百科、CommonCrawl子集、臺灣碩博士論文摘要、中央研究院漢語平衡語料庫、徐志摩詩歌全集、朱自清散文全集等內容。另外,使用純人工產生的COIG-PC資料集和dolly資料集來進行多任務微調訓練。

根據他們的測試,經過C-Eval中文模型評測結果,CKIP-Llama-2-7b-chat和CKIP-Llama-2-7b模型表現在整體平均都高於Llama2-7b、Atom-7B等模型,例如,CKIP-Llama-2-7b平均分數約37.03,高於Llama2-7b的22.26和Atom-7B 的35.95。甚至多任務微調訓練後的CKIP-Llama-2-7b-chat,平均分更高,有38.39分。

CKIP Lab小組表示,這個模型可應用於各種領域,包括文案生成、文學創作、問答系統、客服系統、語言翻譯、文字編修、華語教學等等。中研院搶先開放測試網頁,開放所有人測試。

除了釋出繁中優化的Llama 2模型,CKIP Lab小組在這之前還有釋出了繁體中文的transformers預訓練模型,包含ALBERT、BERT、GPT2,提供使用者試用,並以GPL-3.0授權釋出。隨著中研院繁中優化的Llama 2模型推出,將有助於加速臺灣繁中大型語言模型研究和商用的發展。

熱門新聞

2026-02-06

2026-02-06

2026-02-09

2026-02-06

2026-02-06

2026-02-09

2026-02-09