中研院近日開源釋出用Llama 2所開發的繁中大型語言模型CKIP-Llama-2-7b,並將其放上GitHub等平臺,提供學術和商用,但因在訓練階段部分使用了簡中的開源資料集,使得模型在回答提問時可能出現簡中習慣的用語或詞彙,引起各界的熱議,中研院隨後自行下架該模型。但也掀起了臺灣是否應建立自己的本土化LLM模型的討論聲浪。

中研院CKIP Lab

在10月6日國慶日前夕,中研院開源釋出了使用Llama 2所開發的繁中大型語言模型CKIP-Llama-2-7b,但由於一開始未說明該模型是明清人物研究專用非通用,讓外界誤以為是通用型的繁中語言模型而有更大的期待,經過許多人試用後,結果發現在回答提問時,模型提供的內容不夠本土化,甚至可能出現簡中習慣的用語或詞彙,而引起熱議。中研院在模型釋出4天後決定將該模型下架,並承諾未來發布研究成果時,會制定更嚴謹的審核機制,以防止類似問題再次發生。

中研院AI模型事件引起各界廣泛討論。多數聲浪都是責難中研院,不應該使用中國的簡中語料當作訓練資料,並且批評不該在處於測試階段就將模型對外開放,甚至也有立委出面指責,這已升高到認知戰,但是在臺灣,特別是技術社群中,也有一群持不同觀點的專家,他們認為儘管此次中研院繁中模型的成果不完美,但透過提早釋出和頻繁釋出(Release early, Release often)的方式,可以快速獲得反饋,迅速進行更新,吸引更多人參與,使模型持續迭代,進一步提升成果的品質,這也才是開源社群能夠不斷進步的原因。

但這次事件更深層的意義,一方面反映出各界高度期待擁有一個能夠說出在地口氣、本土回應的LLM模型;另一方面也凸顯了臺灣自主研發大型語言模型的重要性。

可是,大型語言模型,除非使用本地資料集、從頭開始訓練,否則就算用Llama 2或其他開源LLM模型,都可能因為資料集的語言分布落差,而產生各種偏差歧見、不同的價值和解釋,尤其,臺灣本土的資料量僅占網路世界不到0.1%,即使在微調時加入本地資料,資料量不夠多、不夠全面完整,很難確保模型能夠完全貼近自己在地風格、使用習慣和語言表達方式。

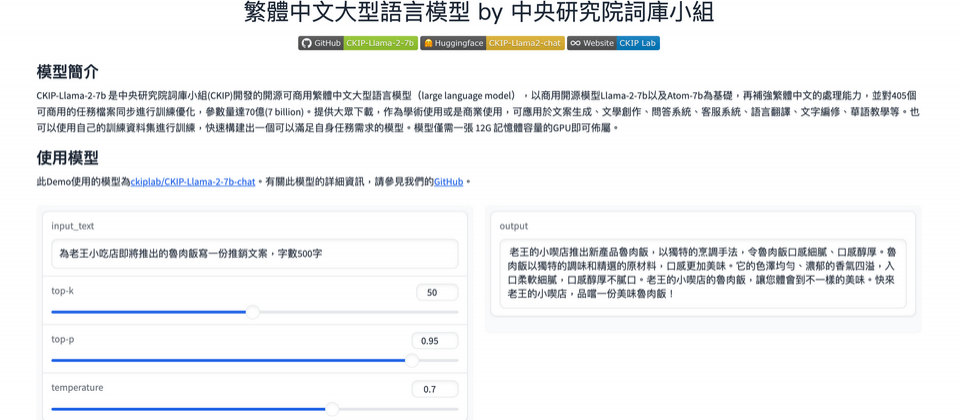

這次由中研院所開發的這一款明清研究用的繁中語言模型,就是一個典型例子。為了要自動化分析中國明清朝代人物的生平圖譜,中研院的CKIP Lab中文詞知識庫小組使用了Meta的Llama-2-7b和來自中國的Atom-7b這兩個開源LLM模型作為預訓練基礎模型,以此訓練出一個專為明清人物分析而優化的CKIP-Llama-2-7b模型,後來更對該模型進行多任務微調訓練,推出了支援更廣泛對話和問答任務的CKIP-Llama-2-7b-chat模型版本,可運用在文案生成、文學創作、問答系統、客服系統、語言翻譯、文字編修、華語教學等。

為了研究所需,CKIP Lab團隊選擇的開源基礎模型和微調的資料集中包含了許多來自中國的簡中資料,例如COIG-PC和dolly資料集等,導致訓練出來的繁中語言模型雖然能更準確地回答明清人物的相關問題,但當回答一些臺灣在地的提問,尤其是一些關於事實的問題時,就有可能生成出不夠本土化,甚至是不正確的內容,例如提供錯誤的國慶日時間或總統姓名。這也凸顯出在訓練過程中使用的資料的重要性。

為何臺灣必須要建立自己的LLM模型

在AI領域研究很有經驗的中研院資訊科技創新研究中心研究員李育杰,是國科會負責建構臺灣大型語言模型的可信任AI對話引擎(TAIDE)計畫負責人。他指出,臺灣必須自行擁有大型語言模型的關鍵原因是,目前不論是OpenAI和Meta提供的語言模型,都存在資料偏差(data bias),特別是在中文語料蒐集方面,中文資料占比非常低,而且由於大部分的訓練資料都是透過網路爬取,其中簡中內容比例遠高於繁中,在臺灣本土的繁中資料量相對稀少的情況下,就容易導致因資料偏差而影響到模型生成的結果,出現和原本預期不一樣的情況。

但要讓臺灣建立自己的大型語言模型,前提是需要建立臺灣自己的大型語言資料集,所以,「臺灣應該好好整理我們自己的繁體中文語料庫」他再三強調。

今年6月時,國科會對外公開展示TAIDE計畫的階段性成果,使用大量純繁中資料微調出一個國產70億參數的AI對話引擎,可執行摘要、翻譯、寫信、寫文章等任務。這套AI對話引擎的背後正是使用和中研院CKIP-Llama-2-7b模型相同的Llama 2開源模型當作預訓練的基礎模型。

本土化的LLM模型訓練三個階段

在本土化LLM模型訓練過程主要分三階段,第一階段是持續預訓練(Continual Pre-training),讓語言模型了解如何透過文字接龍方式,來預測下一個字的機率分布情況。第二階段則是微調建構學習(Fine-Tune Construction Learning),藉由問答的配合來讓模型學會回答人類的問題,例如什麼樣是正確的答案。當模型開始能夠產生回應時,還需要人為的介入,也就是人為反饋強化學習(Reinforcement Learning with Human Feedback) 的階段,透過由人來教導,來加強模型在各方面的表現。

李育杰表示,三個階段中,一開始就需要使用大量的繁體中文語料庫,來讓模型學習基礎的語言邏輯、常識與知識等,以便能夠訓練出符合在地化繁中語境的模型,「這也是我們現在正在做的事情,」他說,目前已蒐集的繁中資料,包括有來自中央社、光華雜誌社資料等。

為了使訓練的模型能更貼近在地化用語或風格,他也提到說,一開始資料選擇很重要,除了需要是本土資料以外,所有資料都要經過篩選過,涵蓋不同的主題,此外,在資料蒐集上也會有相關限制,例如要排除不合宜或不當的用語(dirty words)。

即使靠著簡轉繁方式來獲取可用於模型訓練用的數據,他提醒,也需要注意臺灣和中國之間,不僅在文字用法上存在簡繁體的差異,實際上在翻譯、專有名詞的用法等方面也存在許多不同之處。更深層次的差異,在於彼此的價值觀不同,因此,如果直接使用中國簡轉繁方法,也有可能導致該模型輸出結果與原先預期不一致。

儘管這次中研院模型事件起因於明清的人物研究,研究人員使用了中國的簡中資料來訓練模型,但沒有預料到外界對於模型的測試超出了他的想像範圍,也超出了其研究範疇。李育杰認為,從這起事件中能夠看到臺灣自行建立本土的繁中資料集的必要性,但也需要更加小心處理資料的使用、模型授權與訓練環境的建立。

TAIDE計畫經過半年多發展,他表示,最快10月底將會公布一個可商用的小模型。他透露,目前在文章內容生成和提供建議的測試方面,模型表現已經相當有模有樣,但他不諱言和ChatGPT相比仍有差距,「但是臺灣總要開始踏出第一步」他說。

從推動AI產業的角度來看,台灣人工智慧學校校務長蔡明順在個人臉書以「中研院詞庫模型事件給大家上了一堂LLM課」為題提出他對此事的觀點。他期盼中研院模型事件能成為一大助力,「不僅引起社會關注,還能讓臺灣在大型語言模型這件事上,不只是跟上,更能夠實現與世界同步的發展。」

蔡明順表示,從這起事件反映出臺灣社會非常殷切期待能有自己的本土化的商用繁中大型語言模型,但想要建立一個大型語言模型,首要面對的是資源缺乏的挑戰,不過他指出,中研院開發的語言模型僅僅是個人小型研究之用,用於明清史料的研究,而非用於臺灣通用LLM模型,因此,經費僅有30萬元。他表示,國科會主導的TAIDE計畫,才是真正在開發的臺灣LLM模型。

不過,這次事件引起了不少政治人物的關注,開始認識到臺灣需要擁有自己的GPT,蔡明順認為,這有機會在立法院明年預算中被納入討論。再加上兩岸的認知戰和全球局勢的變化,以及近期OpenAI創辦人Sam Altman訪臺,都讓AI的關注度大幅提高,「在中研院AI模型事件發生後,就像點燃火柴,引爆後續一連串的效應。」他說。

蔡明順建議,政府應該藉此機會加強在軟體方面投入更多資源,尤其是語言模型和資料集的建立上,以便讓臺灣能夠加快發展的腳步,而不僅僅是在硬體方面的投入,如此一來,才能夠有助於臺灣在AI領域上取得更大的進展。

中研院允諾將整合繁中詞知識庫,協助推動臺灣在地化LLM的發展

在中研院AI模型引起爭議後,中研院決定將該模型先行下架,除了聲明表示將制定更嚴謹的審核機制,避免類似事件再發生,也宣布將整合繁體中文詞知識庫,協助推動臺灣大型語言模型的發展。此外,中研院未來還計畫擴大召集跨領域AI相關的研究人員進行跨域研究,而且不僅僅是那些從事科研或科技領域的人,也會廣邀人文及社會科學的人才加入,促進臺灣繁體語境生成式AI的發展。

蔡明順對此表示肯定,認為這對於臺灣本土LLM發展來說是一件好事,「要用技術的語言回應政治的語言是不對的 ,因為你回應不了」他建議,政府應該利用此機會好好審視AI治理的發展,包括AI的管理進程,尤其面對生成式AI帶來社會衝擊,提供相關指引、法規建立等,同時,也要考慮到社會期待,不只是想看到研究成果,而是期望透過AI協助國人、社會帶來生產力提升 、效率提高,甚至能提供企業商用。

儘管中研院繁中語言模型目前已下架,無法繼續使用,不過目前在臺灣還是有一些本土化的LLM模型正在持續發展中,除了國科會AI對話引擎TAIDE,還有來自臺大資工系副教授陳縕儂團隊開源釋出的Taiwan-LLaMa v1.0模型,強調完全採用本地化的繁中語料進行微調訓練。

針對這次中研院事件,陳縕儂也在臉書上發文表示,經過大量網路資料訓練出的LLM,如Llama 2,就算再放入本地化的資料進行模型微調訓練,若是資料量不夠多,還是有可能生成不夠本土化的內容。此外,生成式AI的輸出會有一定程度的隨機性,每次輸出結果可能都不相同,所以她認為,需要透過開源模型,蒐集到更多使用回饋,持續改進模型品質,來達到更加本土化的輸出結果。

李育杰也認為,這次事件凸顯了臺灣需要更積極地整合自己的繁中資料庫,他也樂觀看待此事件後續發展,期待更多人能夠參與,例如有社群已經開始自發地要進行做文字的蒐集、標註清洗,並鼓勵更多人一起加入行動。

熱門新聞

2026-02-11

2026-02-09

2026-02-10

2026-02-11

2026-02-06

2026-02-10

2026-02-10

2026-02-10