國際市場研究機構Gartner發表2024年10大科技趨勢,不只點出生成式AI影響,比如生成式AI民主化、智慧應用將更多,也表示模組化的平臺工程將成開發趨勢。

Gartner

重點新聞(1020~1026)

生成式AI Gartner 平臺工程

Gartner揭露2024年10大科技趨勢預測

國際市場調研機構Gartner最近發表2024年10大科技趨勢預測,聚焦生成式AI及其影響,首先是生成式AI民主化,也就是更普及的生成式AI應用。Gartner點出,更多開源預訓練模型和雲端運算將讓更多人能使用生成式AI,他們預測,到了2026年,超過8成企業將在正式環境中使用生成式AI API和模型,或部署支援生成式AI的應用程式。對比2023年初,這一比例還不到5%。

再來,生成式AI也會增強程式開發工作,來幫助軟體工程師設計、編寫和測試應用程式。甚至,明年會出現更多借AI自主學習和回應的智慧型應用程式,來自動化工作。但這也意味著,AI信任、風險和安全管理(AI TRiSM)越趨迫切,這是Gartner提出的另一個趨勢預測,市面上將出現更多ModelOps、資料保護、特定AI安全性、模型監控和第三方模型與應用程式的風險控制工具。Gartner也預測,到了2026年,採用AI TRiSM工具的企業將消除高達80%的錯誤和非法訊息,進而提高決策準確性。

不只生成式AI,Gartner認為,平臺工程也是明年一大趨勢,透過一系列工具和流程,來為企業開發團隊提供自助式開發平臺。與之類似的預測是產業雲平臺,也就是將傳統雲服務的IaaS、PaaS和SaaS解耦,成為模組化、能解決業務問題的雲平臺。其他預測還包括持續威脅暴露管理、IT永續技術發展、AI優化職員價值,以及客戶機器人,也就是能透過人機協作或機器單獨預測人類需求,進而購買商品的趨勢。(詳全文)

IBM AI晶片 推論

號稱效能超越4奈米GPU!IBM發表AI推論晶片

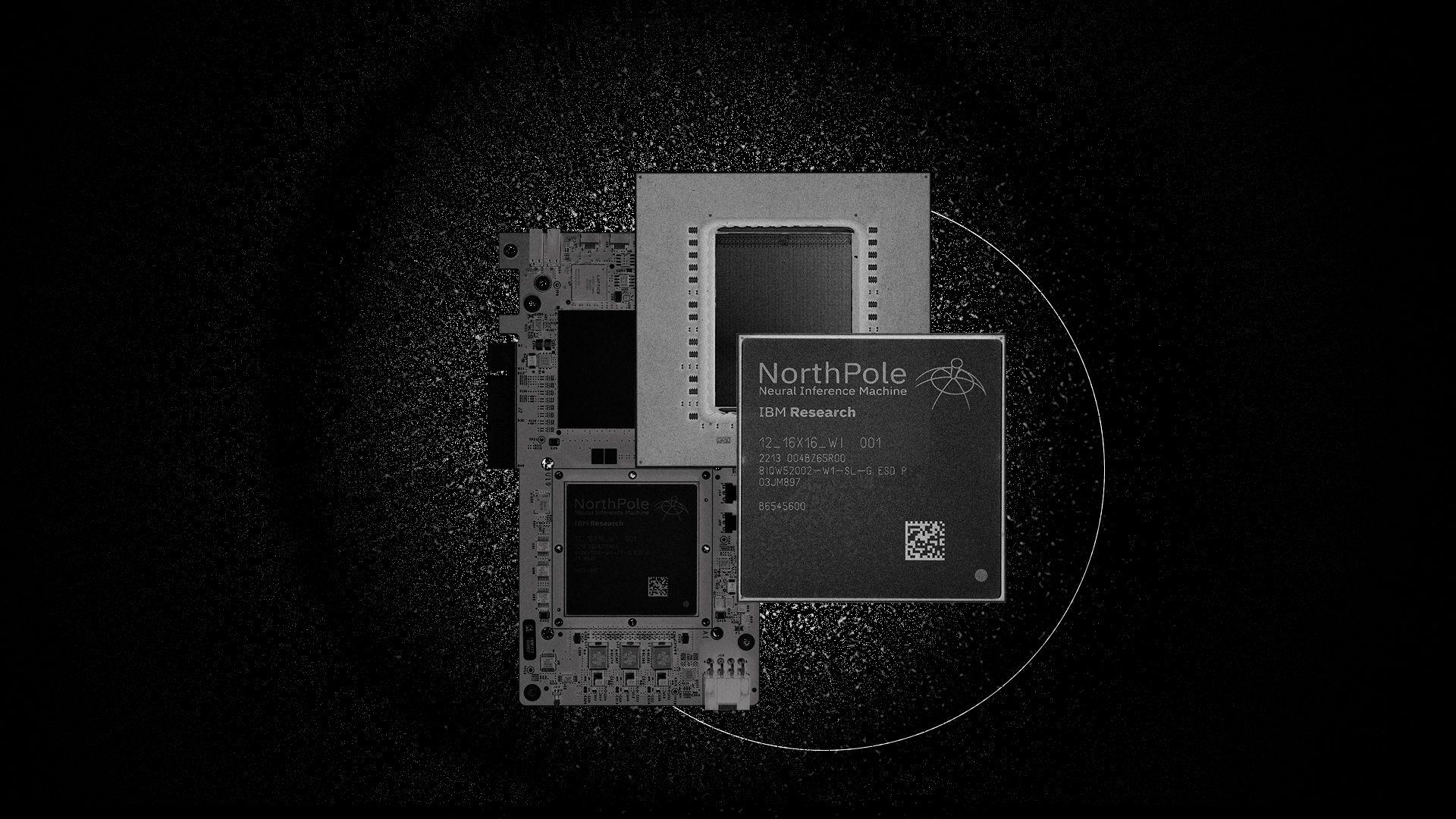

IBM研究院在10月20日發表AI晶片NorthPole,效能號稱超越最先進的4奈米GPU,適用於需要即時處理大量資料的邊緣應用。NorthPole歷時8年研發,特點是所有記憶體都在晶片上,不需額外連結記憶體,因此不會遇到傳統晶片因處理單元與儲存資訊的記憶體分開、資料傳輸速度趕不上處理速度的馮紐曼瓶頸,也於是AI推論能力優於市場其它晶片。

它採12奈米製程,在800平方毫米上安置了220億個電晶體,擁有256個核心,於8-bit精度下每核心每個周期可執行2,048次操作。IBM研究院也在ResNet-50模型上測試NorthPole,相較於12奈米製程的GPU,NorthPole每秒辨識幀數的能源效率是GPU的25倍。不過,NorthPole的優勢也是它的限制,只能存取晶片上的記憶體,若要存取其它地方的資訊,執行速度就會減慢。也因此,要支援更大的神經網路,就得將神經網路拆解成多個子網路,再以多個NorthPole晶片串連這些子網路。目前,NorthPole只能用於推論。(詳全文)

風險 開發 安全

全球24位AI大將聯手呼籲:企業和政府應將1/3的AI預算用於風險管理

包括圖靈獎得主Yoshua Bengio、Geoffrey Hinton在內的24位AI大師日前聯手發表一篇治理框架論文,要來解決AI日益增長的風險問題。該文提出幾項建議,比如企業和政府應將至少三分之一的AI研究預算,來確保AI開發符合風險管理和倫理要求,且政府應盡快、全面地了解AI發展,尤其監管機構得實施模型註冊要求、舉報人保護、事件報告和模型開發與超級電腦的使用監控。

他們也呼籲,在部署模型前,監管機構應有權存取AI系統,來評估其風險,例如自主複製、駭進電腦系統或散播病毒等。文章也建議,政府應使AI開發商和擁有者具備法律責任,以便及早預防模型可能造成的危害。(詳全文)

透明度 LLM 史丹佛大學

史丹佛大學發表基礎模型透明度指標

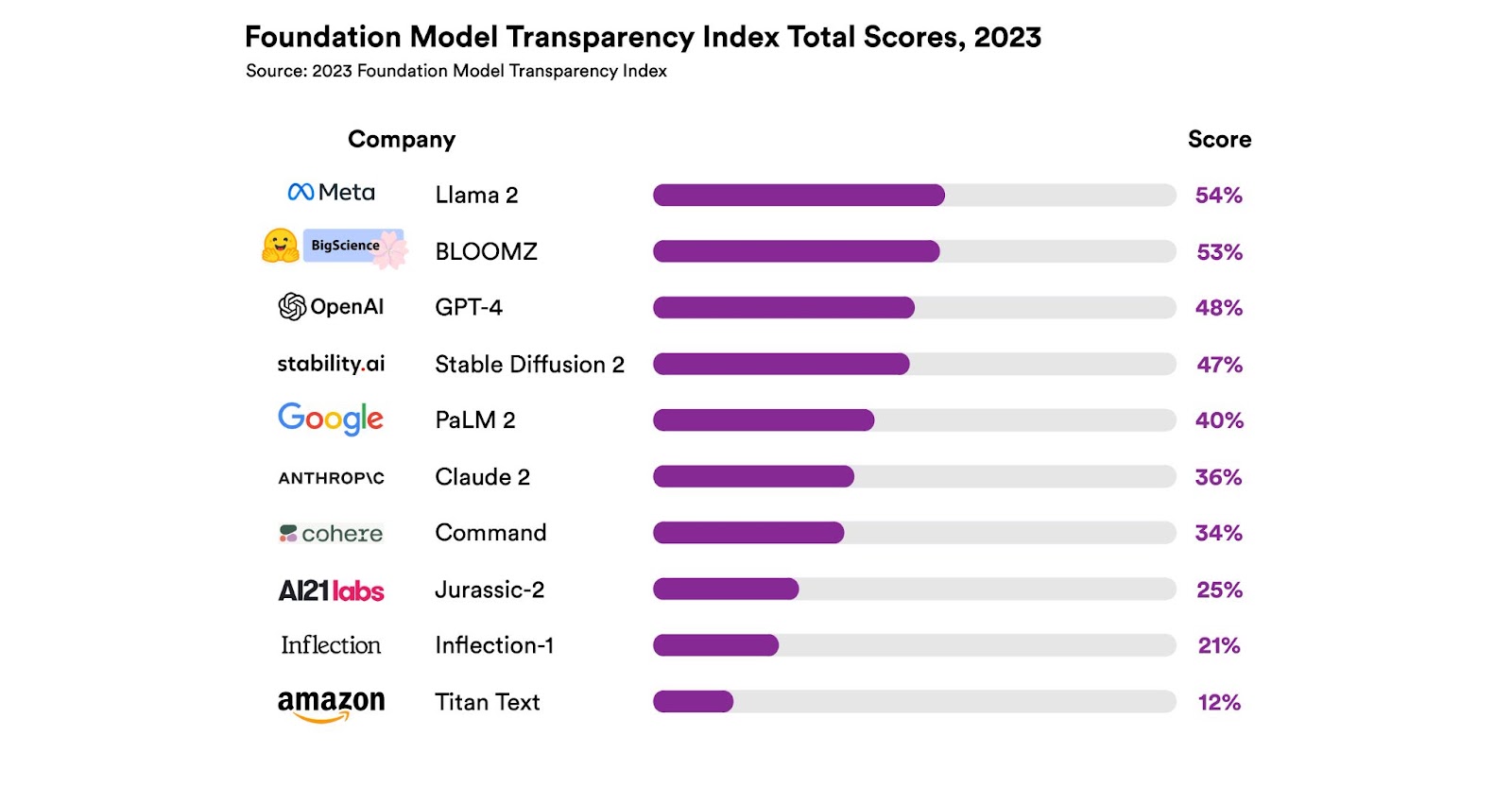

美國史丹佛大學以人為本AI學院(Stanford HAI)近日公布十大基礎模型的透明度指標,其中最高的是Lama 2、為54%,但仍不夠高,團隊認為它們全都缺乏透明度。

進一步來說,調查的10款基礎模型有Llama 2、BloomZ、GPT-4、Stable Diffusion、Claude、PaLM 2、Command、Jurassic-2、Inflection和Titan。而Stanford HAI制定100項基礎模型的透明度指標,其中三分之一與模型如何建置有關,例如訓練資料的相關資訊、建置模型的人力以及使用的運算資源等,另外三分之一與模型本身有關,像是可信度、風險或如何緩解風險等,最後則與下游如何使用模型有關,包括揭露模型分配的公司政策、使用者資料保護以及公司是否替受影響的個人提供補救機會等。

在這些指標中,表現最好的是模型基本資訊,也就是供應商是否揭露基礎模型的模式、規模、架構,以及中心化的模型文件,平均透明度為63%。表現最差的則是影響,亦即基礎模型是否揭露對下游應用的影響,如使用上的統計、監控或提供補救機制,其平均透明度只有11%。(詳全文)

台灣大 客服 Chatbot

台灣大優化智能客服小麥,還要發展語音版Chatbot

台灣大用生成式AI優化智能客服Chatbot小麥,要來分擔真人客服工作量。他們與IT聯手,先將企業知識點資料庫,轉換為向量空間,讓語言模型理解使用者提問、在向量空間內計算信度,再將信度最高的答案作為模型回應,而非任意生成回答。如果企業知識點不足,就會利用語言模型文字接龍的特性,在後臺擴充知識。

台灣大將這個做法稱為AI 2.0優化,他們發現,經過AI 2.0改善的小麥,比起先前的技術,更能回答用戶艱澀難懂的提問,回答正確率還提高3倍多,顧客滿意度也提高了。再來,台灣大進一步打造語音客服Chatbot,採ASR語音辨識技術,能辨識用戶提問中夾雜的國臺語、英文,且能辨識企業服務的特殊用語,還能調整說話音調和語速。有了這些經驗,台灣大也將這些應用打包為AI 2.0方案,作為AIaaS一站式服務,含底層多雲、混合雲架構,也提供不同LLM供企業選擇,並提供ASR語音辨識、TTS語音生成等工具。(詳全文)

生成式AI Nvidia 機器人技術

生成式AI也能優化機器人訓練,Nvidia揭露新系統

Nvidia日前發表一款AI系統Eureka,以GPT-4為基礎,能訓練實體機器人執行近30種複雜任務,如轉筆、開抽屜等。Eureka是Nvidia研究院的演算法研究成果,可搭配Nvidia自家的物理模擬應用程式Isaac Gym,來進行強化學習。

有別於傳統強化學習的獎勵模式,Eureka透過GPT-4和生成式AI撰寫程式碼,來獎賞機器人手臂或手指,來進行強化式學習。過程中,開發者不需要輸入任務提示,也不需撰寫預定義的獎賞範本,還能結合人類回饋來修正獎賞,讓機器手臂更精準執行動作。團隊也公布Eureka測試結果和程式碼,並表示這種生成式AI優化的機器人技術,可實現更靈巧的機器人控制,還能為動畫創作生成更逼真的實體動作。(詳全文)

酷課雲 教育 臺北市

臺北市推出AI教學輔助系統

臺北市教育局最近上線AI智慧教學輔助系統「酷AI」,提供5項AI功能,包括3項幫助學生學習的AI學習小幫手、AI口說練習、AI學習加油站,以及2項輔助老師教學的AI輔助出題、AI輔助作文批閱等功能。

進一步來說,臺北酷課雲是一款整合各項雲端教育學習資源和教學工具的教育雲平臺,這次上線的酷AI就是酷課雲一部分。就AI學習小幫手來說,它能與學生對話,引導學生學習提問的方法,來提高學生探索和自主思辨能力。而AI口說練習功能,則是讓學生上傳英語口說音檔,由AI分析口說表現並提出建議,;AI學習加油站則是藉AI分析學生各項線上學習行為,如教材瀏覽點擊數、作業完成時間和題目作答正確率等,來即時了解學生學習情形,並提供學習輔助建議、主動推播合適的教材內容。

另一方面,就輔助教學來說,AI輔助出題是要幫助老師發想多元評量題目,AI輔助作文批閱功能,則是要幫助老師快速檢視學生作文練習成果,縮短批閱時間。北市教育局表示,酷AI系統已於10月26日正式上線,全市師生都可使用。(詳全文)

生成式AI 文生圖 Nightshade

出現能對文生圖AI模型下毒的新工具

OpenAI、Google等生成式AI業者擷取網路上圖片訓練AI模型引發創作者不滿。一群芝加哥大學研究員發展出Nightshade工具,可擾亂AI業者的底層模型,而且很難發現。該工具是一種專從提示發動的下毒攻擊手法,比如稍稍變更圖片,像變造狗圖片(如擬人化的狗),當這些「含毒」圖文成為訓練資料集,就可能擾亂AI模型。

研究員也攻擊Stable Diffusion V2、SDXL及DeepFloyd等知名模型,來驗證效果。測試顯示,只要很少的有毒樣本就能擾亂AI模型,例如不到100個變造過的「狗」圖片,即可污染SDXL模型對「狗」的概念,使其在接受「狗」的提示時,產出貓的圖片。(詳全文)

圖片來源/IBM、史丹佛大學、Nvidia

AI近期新聞

1. 吳恩達聯手LangChain開設生成式AI課程

2. TikTok發表可理解語、音訊和音樂的生成式AI模型SALMONN

資料來源:iThome整理,2023年10月

熱門新聞

2026-02-06

2026-02-06

2026-02-06

2026-02-06

2026-02-09

2026-02-09

2026-02-09