開放工程聯盟(MLCommons)公開了MLPerf Training v3.1與MLPerf HPC v3.0,兩個重要的基準測試套件的結果,MLPerf Training v3.1獲得產業廣泛參與,官方提到,相較起5年前第一批提交的結果,訓練效能提升達49倍,而MLPerf HPC v3.0的結果也同樣展示科學運算的長足進展,像是DeepCAM天氣建模基準的結果,也比首次推出時提升達14倍。

隨著大型語言模型在各類智慧應用越來越普及,人們對於生成式人工智慧的依賴程度日益增加。為了訓練更強大、更準確地大型語言模型,企業則需要更龐大的運算能力,並高效率地利用超級電腦的硬體和軟體,藉以加速模型訓練流程,使模型更快地迭代和改進,以強化大型語言模型和生成式人工智慧的創新和實用性。

MLPerf Training v3.1套件是用於衡量訓練機器模型、軟體和硬體的全系統評比工具,範圍涵蓋廣泛應用領域。這套開源且經過同儕審查的評比工具,替產業提供了一個公平競爭的平臺,不僅推動技術創新,也可促進效能和能源效率的進步。

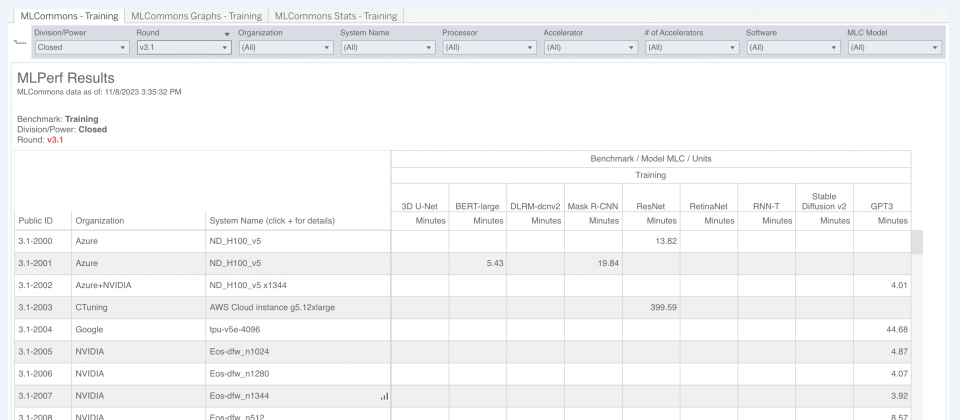

在最新的MLPerf Training v3.1中,有來自19個組織所提交的200多個結果,組織包含華碩、微軟、戴爾、富士通、Google、Nvidia和廣達雲端科技等企業,而這次也有新加入提交MLPerf Training測試結果的組織,像是CTuning基金會與紅帽等。

新的MLPerf Training v3.1套件考慮到圖像生成的高速成長,加入了Stable Diffusion生成式人工智慧基準模型,可用於評估人工智慧系統在接收文字提示並生成圖像的能力。官方提到,MLPerf Training v3.1結果與2018年初次提交的結果相比提升達49倍,效能明顯提升正反映了機器學系統正以非常快的速度創新。

而在MLCommons在MLPerf Training v3.0才新增的GPT-3,在5個月內,大型語言模型基準測試的效能就提升達2.8倍。MLCommons在本輪總共收到11份GPT-3的測試提交,官方認為,提交數量增加與生成式人工智慧大受歡迎有關係。

MLPerf HPC v3.0基準套件則是針對超級電腦,用以衡量科學應用機器學習模型的訓練效能。與MLPerf Training v3.1類似,只不過MLPerf HPC v3.0專門評比科學研究常用的高效能運算系統,並針對支援多用戶的大型系統,納入吞吐量指標。

MLCommons還在HPC v3.0基準套件中,新增了蛋白質折疊基準OpenFold。MLPerf HPC v3.0包含30多項測試結果,官方提到,HPC v3.0基準參與度較去年增加30%,其中包括8個組織提交的大型超級電腦,像是戴爾、富士通與理化學研究所等,還有首次參加的克萊姆森大學,還有HPE與柏克萊實驗室,以及Nvidia和德州高階運算中心。

MLPerf HPC基準測試結果展示了人工智慧在科學領域的重大進展,官方指出,像是DeepCAM天氣模型基準,就比首次推出時快14倍,而這代表著機器學習快速創新,已能夠成為科學家更好的工具,用於解決研究領域的問題,並增加人們對世界的理解。

熱門新聞

2026-02-11

2026-02-11

2026-02-12

2026-02-09

2026-02-10

2026-02-10

2026-02-06