微軟

微軟於周二(12/12)發表了Phi-2,這是一個小型語言模型(Small Language Model,SLM),僅具備27億個參數,但它在許多測試上超越了具備70億參數的Mistral、擁有130億參數的Llama-2,也凌駕了Google剛發表的、基於32億個參數的Gemini Nano 2。

微軟是在今年6月發表了基於深度學習模型Transformer的Phi-1模型,這是為了撰寫基本Python程式碼而設計的小型語言模型,僅使用13億個參數,當時微軟強調用來訓練Phi-1的素材全都是教科書品質,以期在更小的參數規模下達到更好的效能。9月登場的Phi-1.5則擴展至常識推理及語言理解,其效能可媲美5倍的模型。

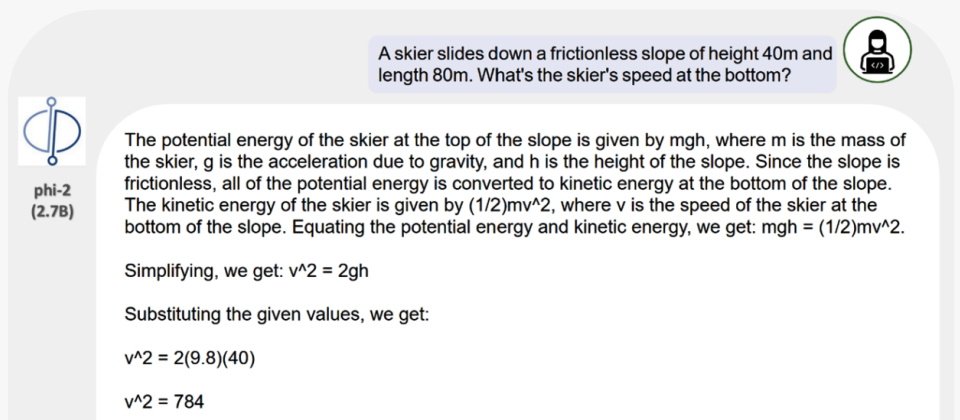

最新的Phi-2則號稱效能可媲美25倍的模型,微軟認為它將是研究人員理想的遊樂場,可用來探索機制可解釋性,安全性的改善,或是針對各種任務進行微調實驗。

Phi-2的訓練素材同樣基於「教科書等級」的概念,涵蓋科學、日常活動與心理學等,再加上篩選過且具有教育價值的高品質網路內容,並將參數量從13億擴大至27億。

有別於Phi-1僅在8個A100 GPU上,以540億個Token進行6天的訓練,Phi-2則是在96個A100 GPU上,以1.4兆個Token進行了14天的訓練。

微軟以完成訓練的Phi-2進行各種基準測試,並與其它模型進行比較,包括用來評估語言模型處理複雜及具挑戰性任務的Big Bench Hard(BBH)、常識推理、語言理解、數學及撰寫程式碼等。發現Phi-2在上述類別的表現全都優於擁有130億個參數的Llama-2,也優於具備70億個參數的Mistral。

此外,微軟也比較了Phi-2與Google專替行動裝置設計的Gemini Nano 2,顯示它在BBH、BoolQ、MBPP與MMLU等類別的評測表現勝過Gemini Nano 2。不過,根據Google Gemini的技術報告,除了上述4項之外,Gemini Nano 2的評測類別還包括TydiQA、NaturalQuestions與MATH,而微軟並未公布相關比較。

熱門新聞

2026-02-11

2026-02-11

2026-02-09

2026-02-10

2026-02-10

2026-02-06

2026-02-10