蘋果

今年6月,蘋果WWDC搶盡了所有人的目光,不只是因為蘋果終於發表了生成式AI戰略,更因為蘋果從應用面,展示了生成式AI如何流暢地整合到不同應用場景中,操作體驗的流暢性和直覺設計,讓人大開眼界。

蘋果執行長Tim Cook在WWDC開場演講中強調,蘋果打造任何產品都必須符合五大原則,首先是必須強大,能夠完成用戶重要的工作。其次是直觀易用,深度整合到產品體驗,第四是最重要的一點,它必須了解使用者,最後一項是,產品從一開始就必須以隱私為基礎。他強調,結合這些因素所打造的人工智慧,就是「個人智慧」(Personal intelligence),這也是蘋果的下一步重大發展。」蘋果用蘋果智慧(Apple Intelligence)來命名這一套個人智慧的系統。

不同於其他生成式AI,蘋果軟體工程資深副總裁Craig Federighi指出,這套蘋果智慧系統將強大的生成模型放到蘋果產品的核心,可以依據個人的脈絡資訊,來提供有幫助又有相關的智慧。「每一步都保護你的隱私,高度整合到蘋果的平臺中,遍布在溝通、工作和表達自我的應用中。」

Craig更強調:「蘋果智慧最大特色是可以了解使用者的個人脈絡。」所以才能讓iPhone、iPad 和 Mac這些裝置可以理解和生成出文字與圖像,也可以代表個人來採取行動,簡化跨不同App之間的互動。

換句話說,蘋果智慧這套個人智慧系統,不只是高度個人化,而且是蘋果希望做到,只有自己看得到,用得上,其他人,連提供平臺的蘋果自己都不能看,除非獲得使用者主動的授權才能存取,可以說,蘋果智慧就是一種個人可以高度掌控的私有化AI。

為了實踐這個隱私優先的設計考量,蘋果在生成式AI運作架構上,採取了雲地混合的AI基礎架構設計,在裝置端提供了30億參數的LLM模型,當地端GAI的能力不足時,才交由雲端的LLM模型接手。蘋果打造了一套「私有雲端運算」(Private Cloud Compute,簡稱PCC)服務來執行這些雲端的LLM模型,確保雲端GAI服務能夠達到蘋果想要的隱私保護要求,這是蘋果實踐私有AI戰略的另一個關鍵,我會用另一篇文章來說明。

雖然雲端PCC有很好的隱私安全設計,但是蘋果希望最好能在本地端裝置上,就能滿足使用者日常工作上、家庭中使用的各種GAI應用需求,必須盡可能發揮30億參數的能力。靠裝置端LLM模型能夠滿足越多使用需求,就能避免將個人資料上傳到雲端,也越能確保使用者的隱私。蘋果克服這項挑戰最大的關鍵就是LoRA架構。

LoRA架構是蘋果裝置端LLM的關鍵架構

蘋果用他們在2023年開源釋出的AXLearn框架來訓練裝置端的LLM模型,也只用蘋果網路爬蟲機器人蒐集到的公開可用資料和其他有授權的資料來進行模型的預訓練,也採用了人工標記資料和合成資料來提高訓練素材的品質。在後訓練中,也採取了人類回饋強化學習RLHF等作法來優化模型。

蘋果還採取了大量模型優化作法,例如所用的LoRA轉接模型(Adapter)採用了2位元和4位元搭配出平均3.5位元的權重壓縮策略,來縮小模型大小。蘋果更在2021年秋天,啟用了一套互動式的ML模型效能分析工具,讓ML工程師可以自己分析模型的行為指標(如準確性、精確度)和硬體指標(模型大小、延遲、功耗)的成效,2年來,蘋果內部超過8百人使用,用來分析超過3,600套各式各樣的模型。

蘋果打造裝置端AI體驗的關鍵利器

盡可能將資料留在裝置端AI上處理,這是蘋果確保使用者隱私的關鍵,因為個人裝置上的算力和電力資源很有限,又要兼顧使用者體驗的考量,要在行動裝置順利執行AI,得同時兼顧模型能力(參數大小)、使用者體驗(延遲性)、和電力消耗,來決定什麼樣的模型優化作法,可以兼顧使用者體驗目標和AI的效果。

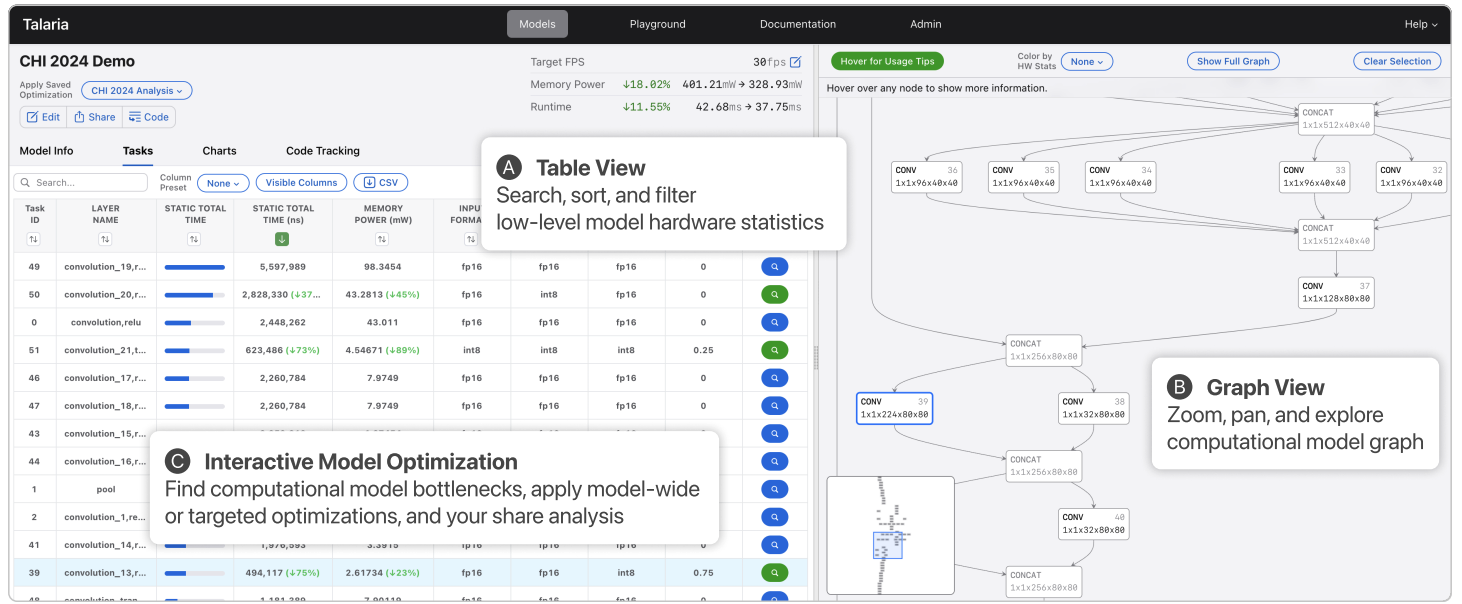

目前很少有這類可以同時考慮模型效能和電力損耗的工具,為了更快也更容易找出裝置端AI的最佳配方,蘋果自己開發了一款互動式ML效能視覺化分析工具Talaria,從2022年正式提供得內部的AI團隊使用。

在這款工具上,有三大功能,第一是表格檢視功能,可以用來搜尋和比較各種AI模型低階硬體數據,例如像是記憶體用量,記憶體耗電,另一個則是模型運算架構檢視(Graph View),可以用來檢視這個模型的推論運算流程和資料流動的架構,另外還提供了互動式的模型優化調整,模型開發人員可以套用不同的模型配置或是特定優化作法例如不同的模型壓縮方式,來比較不同做法之間的差異,找出模型推論運算的瓶頸。

因為蘋果得考量不同類型的裝置,從筆電、手機到智慧手錶,得針對不同的裝置硬體規格和使用者體驗考量(例如關鍵問題是App呼叫AI模型的回應速度有多快),有了這一套自助是、互動式的ML效能視覺化分析工具,讓蘋果開發團隊更容易協作和討論,各種模型優化作法,例如ML團隊更容易跟產品團隊共同討論。

蘋果從2022年開始啟用的自製互動式ML效能視覺化分析工具Talaria,三大功能包括了效能表格檢視、模型運算架構檢視和互動式的模型優化配置設定。圖片來源:蘋果。

透過許多模型優化機制,讓這個30億參數的LLM模型,在iPhone 15 Pro回應第一個提示詞元(Token)的延遲時間,只需要0.6毫秒,也就是不到千分之一秒,就能生成第一個字的反應速度。目前每秒可以生成30個詞元,蘋果希望能持續提高生成的速度。

除了各種優化作法,為了讓裝置端LLM,可以針對使用者各種日常活動來微調,盡可能只靠裝置就能完成任務,蘋果採取了一個非常關鍵,甚至可能是裝置端架構最重要的設計,蘋果採用LoRA(Low-Rank Adaptation)架構來部署LLM模型。這是微軟在2021年發布的大型語言模型優化架構,可以大幅減少微調大型語言模型的參數量。

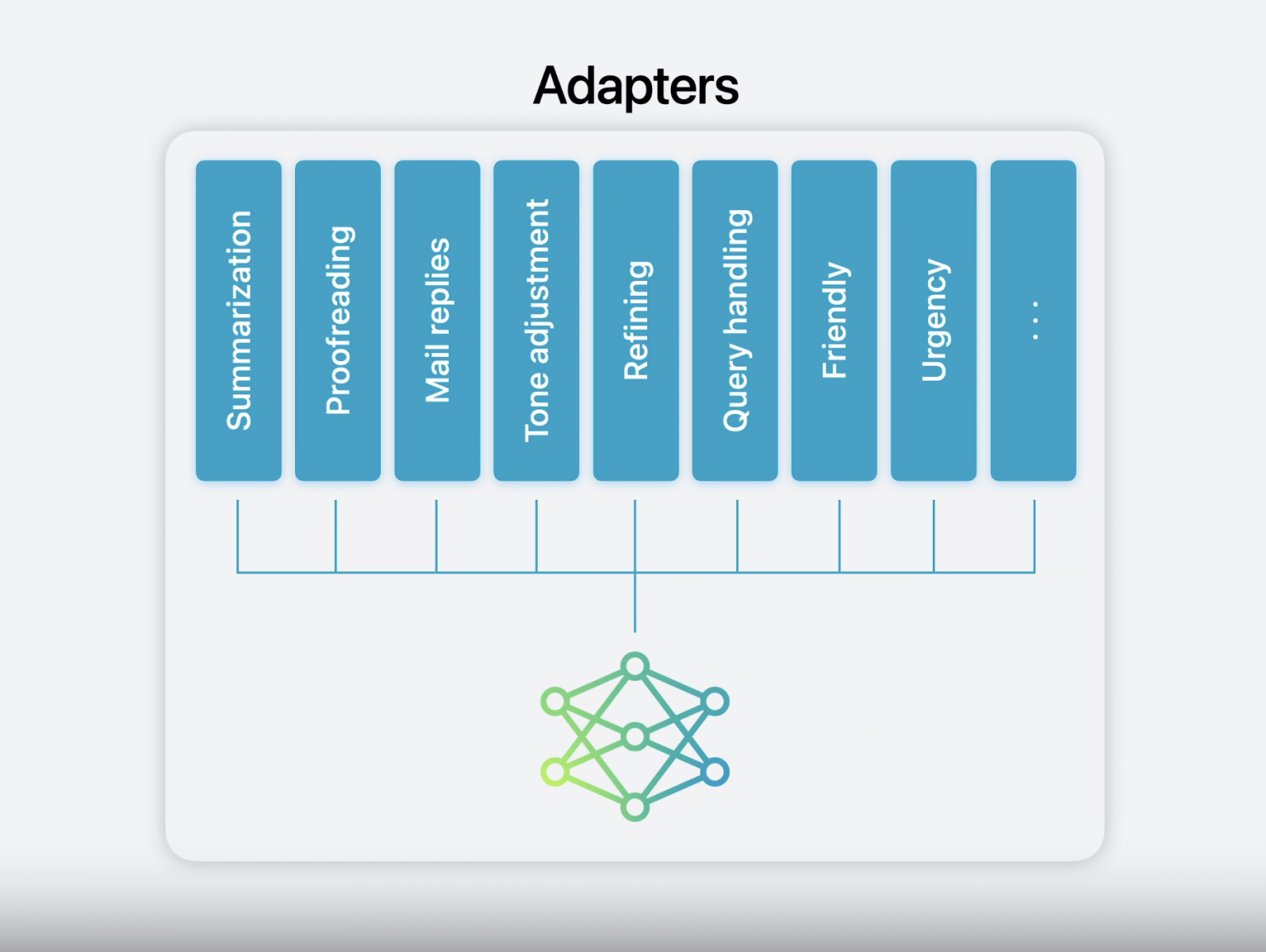

這邊不會詳細解釋LoRA的運作原理,簡單來說,LoRA作法是,在對一個大型語言模型進行微調時,可以搭配一個參數量相對小很多的神經網絡模型,稱為轉接模型(Adapters)來計算,訓練資料只需要來微調這個轉接模型,就能達到媲美直接微調大型語言模型的推論效果。

一般來說30億參數的LLM模型,採用各種模型壓縮技術,可能也需要1、2GB的記憶體,但是,以蘋果所用的30億參數裝置端模型,他們採用了16位元,Rank值16設定的轉接模型大小,只有數十MB大小。

利用LoRA架構,蘋果智慧可以使用同一套裝置端LLM模型,來搭配各種不同用途的轉接模型,蘋果目前已經訓練出了語言生成模型的多種轉接模型,像是摘要模型,校對模型、郵件回覆模型、查詢處理模型、友善回應模型、緊急回應模型等,在圖片生成也有許多不同用途的專用模型。圖片來源/蘋果

轉接模型只有數MB,用記憶體快取就能快速切換不同模型

因為裝置端像是手機、平板的記憶體有限,蘋果指出,這個大小的轉接模型,就可以動態使用記憶體來快取,切換不同的轉接模型。等於只需要載入一份LLM,可以針對不同任務需求,快速切換不用用途的轉接模型,就可以讓GAI具備不同用途的專門能力,就可以更有效的管理記憶體,也能確保在裝置上的回應速度夠快。

以蘋果目前在裝置端上使用的模型大小約30億參數,需要約1~2GB的記憶體,只要再搭配數十到近百MB記憶體作為轉接模型的快取,就可以快速支援裝置端上各種GAI應用場景的推論需求。不只記憶體用量大幅減少,使用AI晶片來運算的算力需求也可以大幅減少,更適合在算力有限的穿戴式裝置上實現本地端AI推論。

採取LoRA有兩大好處,一是在模型預訓練階段,因為主要針對轉接模型進行微調,可以大幅減少需要訓練的參數量,很容易可以訓練出因應不同用途的轉接模型,例如用翻譯用轉接模型、內容摘要用轉接模型等。只需要使用不同用途的訓練資料,就能微調出適合不同任務的專用轉接模型,而不用每次都花時間和算力來微調大型語言模型。

另一個好處是,一個大型語言模型,可以搭配使用不同的轉接模型,換了一個轉接模型,就能擁有這個轉接模型所微調後的效果,例如換上「內容摘要用轉接模型」,就能提高LLM摘要內容的能力和品質,甚至,可以串接多個轉接模型來疊加效果。例如可以疊加翻譯轉接模型和內容摘要轉接模型,就是將一份內容,摘要成不同語言的版本。

若用專業相機的鏡頭來比喻LLM模型,不同鏡頭可以提供不同的功能,但是轉接模型就像是鏡頭的濾鏡,一個鏡頭可以搭配不同功能的濾鏡,不用每次都切換笨重的鏡頭,也能單靠快速更換濾鏡,就能拍出不同風格效果的照片,一個鏡頭還能搭配多個濾鏡,來呈現複合的效果。

利用LoRA架構,蘋果智慧可以使用同一套裝置端LLM模型,來搭配各種不同用途的轉接模型,蘋果目前已經訓練出了語言生成模型的各種轉接模型,像是摘要模型,校對模型、郵件回覆模型、查詢處理模型、友善回應模型、緊急回應模型等,在圖片生成也有許多不同用途的專用模型。

可以用不同專門模型,指揮第三方App來執行特定任務

蘋果將蘋果智慧的功能,高度整合到系統元件中,不同功能用途的元件可以使用對應功能的專用轉接模型,來提高執行特定任務的能力。

蘋果新增的個人脈絡能力,像是語意索引、螢幕文字理解,將使用者當下的畫面,或與一項行動所需的相關個人化資訊,也可以用來分辨,裝置端LLM模型可以搭配使用哪些轉接模型來強化,符合個人化脈絡操作需要的能力,更可以搭配蘋果的App意圖框架,根據不同的App意圖,切換適合這項意圖的轉接模型。

早在2年前的WWDC 2022,蘋果就發表了可讓Siri控制的App意圖,能讓使用者用語音指揮Siri來控制某些App的內部行為,更可以透過蘋果OS中的捷徑功能,組合不同App的行動,打造出一隻自動化RPA程式一樣,後來發展成了現在App意圖框架,到了今年WWDC,App意圖是整個系統可以用的基礎功能,任何第三方App,都可使用App意圖框架,將App內部的核心功能,定義成可以供Siri、Spotlight搜尋或是捷徑可以操作的App意圖。過去幾年已有不少第三方App,自定出了數百項App意圖,都成了Siri可以指揮的行動,讓蘋果智慧呼叫這些第三方App,來完成不同用途的功能。

不只如此,過去幾年,蘋果不斷強化裝置端的隱私機制,盡可能讓用戶擁有更大的資料自主權,從2021年上路的ATT(App Tracking Transparency,ATT)政策,可拒絕廣告識別碼,來避免跨App追蹤,可隱藏真實Email的Hide My Email功能,可隱藏用戶IP的Private relay,更容易開關的精細權限控管、揭露度更高的App隱私報告。今年更新增了App層級的隱私控制,可以將一隻App所用的資料上鎖,沒有解鎖,就無法看到這隻App所用的任何資料。這就讓使用者對裝置端上的App,有更高的資料主控權,也能讓各種裝置端AI代理,更安全、在授權下,完成各項App意圖所驅動的行動。

蘋果採用LoRA架構和種種模型優化技術,讓裝置端的LLM,可以快速切換搭配不同的專用轉接模型,來提供不同任務需要,更專門的GAI能力,還能用來判讀,使用者下達的指令背後的意圖,可以使用哪些第三方App能支援的行動來滿足使用者的需求,這就像是一個以使用者名義來採取各種行動的AI代理,而且蘋果智慧的AI代理,還可以只靠裝置端LLM,就能完成大部分日常活動需要的任務。

蘋果在WWDC主題演講中,一點都沒有提過「AI代理」這個字,這個今年各大科技巨頭強打的GAI新主流,但是,採取LoRA架構來實現超強裝置端LLM的蘋果智慧,早已展開了各項AI代理基礎工程的布局。

熱門新聞

2026-02-09

2026-02-06

2026-02-09

2026-02-09

2026-02-10

2026-02-10

2026-02-10